|

Опрос

|

реклама

Быстрый переход

Хранение данных на ДНК в дата-центрах уже в текущем году — французы готовы сделать фантастику реальностью

07.03.2026 [22:12],

Геннадий Детинич

Французская компания Biomemory объявила о планах развернуть технологию хранения данных на основе ДНК в дата-центрах уже во второй половине 2026 года. Это стало возможным после приобретения активов профильной американской компании Catalog Technologies — пионера в области записи данных на ДНК, а также вычислений с её помощью.

Источник изображения: ИИ-генерация Grok 4/3DNews Тем самым Biomemory позиционирует себя как первого интегратора, который выведет технологии DNA Data Storage на уровень коммерческих решений для ЦОД — в формате решений для стандартной серверной стойки, совместимых с традиционной инфраструктурой. Технология предлагает устойчивую, безопасную и энергоэффективную альтернативу жёстким дискам, магнитной ленте и SSD, особенно для «холодных» данных. В основе подхода Biomemory лежит запатентованный метод массового производства биобезопасной ДНК и ферментных расходных материалов, обеспечивающий стоимость эксплуатации ДНК-хранилищ данных не выше или ненамного выше традиционных. Данные записываются на синтетические ДНК-цепочки и хранятся в специальных контейнерах (DNA Cards), гарантируя надёжное хранение от 50 до 150 лет в стандартных условиях или на протяжении тысячелетий при охлаждении в герметичном состоянии. При этом уровень необратимых ошибок заявлен не выше допустимого в индустрии. Приобретённые у компании Catalog активы, включая прототип «пишущего устройства» ДНК под названием Shannon (по сути, это массив печатающих головок), патенты, технологии чтения/записи и вычислений на ДНК, органично дополняют и усиливают собственные разработки Biomemory, обещая ускорить создание масштабируемых решений с высокой плотностью и низким энергопотреблением. Накопители на основе ДНК будут представлены как дополнительный уровень хранения данных, используя при этом стандартный интерфейс S3 (как объектное хранилище). Тем самым доступ к архивам останется привычным для пользователей. Добавим, что ещё в 2022 году с компанией Catalog начала активно сотрудничать Seagate. Скорее всего, сотрудничество продолжится уже с новым владельцем разработок. Напомним, компания Catalog громко заявила о себе в 2022 году, записав на ДНК фрагмент из «Гамлета» Уильяма Шекспира объёмом 17 тыс. слов и осуществив полномасштабный поиск по фрагменту без индексирования. В теории в одном грамме ДНК можно записать 200 петабайт данных, но первые накопители будут намного скромнее по ёмкости. «Цирк, да и только» — Сэм Альтман посмеялся над идеей Илона Маска размещать ЦОД в космосе

22.02.2026 [12:58],

Владимир Мироненко

Генеральный директор OpenAI Сэм Альтман (Sam Altman) раскритиковал идею главы SpaceX Илона Маска (Elon Musk) размещать ЦОД в космосе, объединившего ради этой цели xAI и SpaceX в одну компанию. Он считает дата-центры в космосе фантастикой, по крайней мере на данный момент, пишет Business Insider.

Источник изображения: SpaceX «Честно говоря, я считаю идею размещения ЦОД в космосе в нынешних условиях нелепой», — сказал Альтман во время общения в прямом эфире с журналистами местных СМИ в Нью-Дели (Индия) в пятницу, вызвав смех у зрителей. Он выразил мнение, что орбитальные ЦОД «когда-нибудь могут иметь смысл», но такие факторы, как стоимость запуска и сложность ремонта компьютерного чипа в космосе, на данный момент являются непреодолимыми препятствиями. «Мы ещё не достигли этого, — убеждён Альтман. — Придёт время. Космос отлично подходит для реализации многих задач. Орбитальные ЦОД — это не то, что будет иметь значение в этом десятилетии». Впрочем, это не первый случай, когда Маск и Альтман расходятся во мнениях. Напомним, что в этом месяце на общем собрании сотрудников xAI Маск сообщил, что приобретение xAI компанией SpaceX позволит ей быстрее развернуть орбитальные ЦОД. В феврале SpaceX назвала целью запуск «группировки из миллиона спутников, которые будут функционировать как орбитальные ЦОД». Компания уже начала нанимать инженеров для её реализации. Между тем другие технологические компании тоже планируют разместить ЦОД в космосе. Например, на это направлен проект Google Suncatcher, представленный в ноябре 2025 года. Генеральный директор Google Сундар Пичаи (Sundar Pichai) заявил в воскресенье в эфире Fox News, что компания может начать размещать в космосе ЦОД, использующие для работы солнечную энергию, уже в 2027 году. На фоне бурного развития ИИ-технологий идёт масштабное строительство ЦОД, обеспечивающих функционирование больших языковых моделей и чат-ботов на базе ИИ. По данным Business Insider, опубликованным в прошлом году, к концу 2024 года в США было одобрено строительство более 1200 дата-центров, что почти в четыре раза больше, чем в 2010 году. Однако эти ЦОД истощают водные ресурсы, создают дополнительную нагрузку на электросети, увеличивают загрязнение окружающей среды, что ведёт к снижению общего качества жизни. В связи с этим проекты по строительству ЦОД всё чаще сталкиваются с жёстким сопротивлением со стороны местных сообществ. Ноль сопротивления и в 10 раз компактнее: Microsoft готовит сверхпроводниковую революцию для дата-центров

11.02.2026 [19:41],

Сергей Сурабекянц

Microsoft задумалась над созданием более эффективных ЦОД при помощи электропроводящих материалов с нулевым сопротивлением. По мнению компании, появление на рынке относительно доступных так называемых высокотемпературных сверхпроводников может кардинально изменить подход к строительству вычислительной инфраструктуры.  Технологические компании подвергаются усиливающейся критике из-за огромных и постоянно растущих объёмов электроэнергии, которые потребляет искусственный интеллект, задержек с подключением к электросетям и влияния ЦОД на местных жителей. Высокотемпературные сверхпроводники (ВТСП) потенциально могут уменьшить площадь, необходимую для центра обработки данных и линий электропередачи, питающих его. Сегодняшние ЦОД, как и большая часть энергетической инфраструктуры, используют медные провода, которые довольно эффективно проводят электричество. Однако ВТСП позволят радикально снизит потери энергии и использовать более лёгкие и компактные кабели. ВТСП уже используются в аппаратах МРТ, а в последнее время — на коротких участках линий электропередачи в густонаселённых мегаполисах, включая Париж и Чикаго. Использование ВТСП пока ограничено, так как такие кабели значительно дороже и сложнее в производстве, чем медные. Для достижения нулевого сопротивления ВТСП необходимо охлаждать до очень низких температур, а основа этих сверхпроводящих кабелей изготавливается из редкоземельных материалов, таких как оксид бария. Производство осложняется тем, что добыча редкоземельных элементов в значительной степени сосредоточена в Китае. «Microsoft изучает, как эта технология может повысить надёжность электросетей и уменьшить воздействие центров обработки данных на близлежащие населённые пункты», — сообщил генеральный менеджер Microsoft по глобальному маркетингу инфраструктуры Алистер Спирс (Alistair Speirs). В частности, в прошлом году при финансовой поддержке Microsoft компания VEIR продемонстрировала, что использование ВТСП в ЦОД позволит снизить размер и вес кабелей примерно в 10 раз по сравнению с традиционными медными аналогами. Microsoft также готова сотрудничать с энергетическими компаниями для поддержки строительства линий электропередачи большой протяжённости с использованием ВТСП. Расширение линий электропередачи является одним из самых больших препятствий на пути модернизации энергосети, подключения ЦОД и наращивания энергоснабжения. Благодаря использованию ВТСП площадь, необходимая для прокладки линий электропередачи, значительно сокращается. В то время как воздушные линии электропередачи могут занимать полосу шириной порядка 70, для ВТСП будет достаточно всего двух метров.

Источник изображения: unsplash.com Профессор MIT Деннис Уайт (Dennis Whyte) уверен в перспективности использования ВТСП. В настоящее время он является одним из руководителей проекта по созданию термоядерной установки SPARC, которая стала результатом сотрудничества MIT и компании Commonwealth Fusion Systems, получившей финансирование от программы Билла Гейтса (Bill Gates) Breakthrough Energy Ventures. Microsoft также заключила сделку с другой компанией, разрабатывающей термоядерную электростанцию в штате Вашингтон. Исследования в области термоядерного синтеза требуют серьёзных объёмов ВТСП, что даёт надежду на расширение производства и снижение цены этих материалов. Электромобили не взлетели: заводы батарей в США массово переходят на аккумуляторы для дата-центров

11.02.2026 [15:29],

Алексей Разин

При президенте Байдене в США зародились надежды на стремительную электрификацию парка автомобилей, под эти нужды начали строиться предприятия по выпуску тяговых батарей, но теперь они перепрофилируются под нужды рынка ЦОД, которому требуются стационарные системы хранения электроэнергии.

Источник изображения: BYD По данным исследовательской компании CRU, на которые ссылается Financial Times, американские производители тяговых батарей отказались от введения в строй мощностей, которых хватило бы для оснащения 2 млн электромобилей. Сворачивание программы субсидирования продаж электромобилей и общее отрезвление рынка привели к тому, что спрос на электромобили в США упал. Из десяти крупных предприятий по выпуску батарей в США семь готовы частично переориентироваться на рынок систем стационарного хранения электроэнергии. Подобная продукция нужна не только для развития центров обработки данных. Переход на возобновляемые источники энергии подразумевает, что она будет генерироваться неравномерно, и для стабильной передачи электроэнергии в сеть необходимо буферное хранилище, в роли которого и будут выступать стационарные системы батарей. Такой конверсии уже подверглось предприятие Ford Motor в штате Кентукки, руководство General Motors недавно также призналось в наличии подобных планов. Если учесть, что и Stellantis при поддержке Samsung SDI собирается переориентировать предприятие в Индиане на выпуск батарей для стационарных хранилищ электроэнергии, то можно признать всех трёх крупнейших автопроизводителей США участниками подобной инициативы. Tesla, которая такие системы выпускает уже давно, в прошлом квартале нарастила выручку от их реализации на 27 % в годовом сравнении до $12,8 млрд, тогда как выручка от реализации электромобилей этой марки упала на 9 % до $64 млрд. Сейчас электромобили формируют только 8 % первичного рынка США, аналитики BloombergNEF ожидают, что в мировом масштабе к 2030 году их доля увеличится лишь до 27 % против прежних 48 %, упоминавшихся в раннем прогнозе. Вложив $980 млн в совместное предприятие по производству батарей в Онтарио, концерн Stellantis продаёт 49 % своих акций партнёру в лице LG Energy Solution всего за $100, поскольку автогиганту пришлось недавно списать 22 млрд евро на фоне неудачных попыток нарастить объёмы выпуска электромобилей. При Дональде Трампе (Donald Trump) в прошлом году были отменены субсидии на продажу электромобилей гражданам США, но сохранились субсидии на выпуск аккумуляторов и систем стационарного хранения электроэнергии. Кроме того, импортные пошлины на китайские аккумуляторы в США достигают 60 %, поэтому производство такой продукции на территории страны остаётся достаточно выгодным. Впрочем, производители батарей в США не торопятся жертвовать прибылью, поэтому они продаются на местном рынке по ценам, сопоставимым с импортируемой из Китая продукцией. Китайские производители при этом обладают более серьёзным опытом в выпуске LFP-батарей, которые оптимальны для использования в стационарных хранилищах. На территории США работают в основном южнокорейские производители, которые традиционно специализируются на батареях другого химического состава, не очень подходящего под конкретные задачи. Аналитики ожидают, что до 2030 года основной прирост производственных мощностей на рынке батарей всё равно будет обусловлен потребностями сегмента электромобилей, а не систем стационарного хранения электроэнергии. Вряд ли спрос на эти решения по своему объёму приблизится к величине спроса на тяговые аккумуляторы для электромобилей, как отмечают эксперты Wood Mackenzie. Через пять лет в космосе будет больше ЦОД, чем на Земле, как уверен Илон Маск

07.02.2026 [07:17],

Алексей Разин

Глава xAI и SpaceX Илон Маск (Elon Musk) в последнее время так ухватился за идею создания ЦОД в космосе, что ради достижения соответствующей цели объединил обе компании в гигантский стартап с капитализацией около $1,25 трлн. Миллиардер дал понять, что в следующие пять лет, по его мнению, вычислительные мощности в космосе превзойдут земные.

Источник изображения: SpaceX К началу следующего десятилетия, как можно понять из интервью Илона Маска, на которое ссылается издание Fortune, затраты на эксплуатацию центров обработки данных (ЦОД) для искусственного интеллекта (ИИ) окажутся ниже в космосе, чем на Земле, поэтому освоение орбиты в этом смысле обеспечит участникам рынка весомые преимущества. Глава SpaceX считает, что если ориентировать будущие ЦОД на использование солнечной энергии, то участники рынка в будущем столкнутся с дефицитом земли и бюрократической волокитой, поэтому перенос вычислительных мощностей в околоземное пространство является разумной альтернативой. Тем более, что в космосе солнечные панели демонстрируют в пять раз более высокую эффективность, чем на Земле. По словам Маска, в ближайшие два с половиной или три года размещать в космосе ЦОД станет выгоднее, чем на Земле. Тем более, что космос предоставляет гораздо больше возможностей по масштабированию вычислительных мощностей, по его мнению. Наземная энергетическая инфраструктура сейчас не успевает за ростом вычислительных мощностей для ИИ, становясь сдерживающим фактором для отрасли. Газовые и ветровые турбины для электроустановок выпускаются в ограниченных количествах. Солнечные панели для применения в космосе дешевле наземных, поскольку для их производства требуется меньше материалов, обеспечивающих устойчивость к погодным явлениям. Кроме того, космические ЦОД нуждаются в менее интенсивном охлаждении. «Если говорить о пятилетней перспективе, я думаю, что в космосе будет ежегодно создаваться больше (мощностей для) ИИ, чем все вместе взятые ЦОД на Земле. То есть, через пять лет, как я ожидаю, мы будем каждый год запускать в космос и вводить в строй больше ИИ, чем до этого было создано на Земле», — заявил Илон Маск. Чтобы достичь поставленных целей, нужно будет осуществлять по 10 000 запусков космических аппаратов ежегодно. Другими словами, каждый час в космос должна будет отправляться ракета с необходимым оборудованием на борту, и даже чаще. SpaceX уже является рекордсменом по подобной активности, но за прошлый год она совершила только 165 пусков. Чтобы выйти на 10 000 пусков в год, SpaceX понадобятся от 20 до 30 ракет Starship, но компания способна изготовить и ввести эксплуатацию больше, что позволит увеличить количество ежегодных пусков до 20 000 или даже 30 000 штук. Для сравнения, как пояснил Маск, мировая авиационная отрасль демонстрирует гораздо более высокую активность. Ежедневно совершаются более 100 000 перелётов. По словам Маска, SpaceX может стать «гипер-гиперскейлером», вводя в строй ежегодно больше вычислительных мощностей, чем было создано на Земле за всю историю в совокупности. Подготовка к соответствующей деятельности уже идёт полным ходом. В ноябре SpaceX вывела на орбиту тестовый спутник с ИИ-сервером стартапа Starcloud. В прошлом месяце компания Маска запросила у американской комиссии FCC разрешение на вывод в космос до 1 млн спутников для космических ЦОД с питанием от солнечных панелей. Нельзя утверждать, что только Маск грезит идеей организации ЦОД в космосе. Стартап OpenAI задумывался о приобретении аэрокосмической компании Stoke Space ради достижения аналогичной цели, профильные разработки ведёт и корпорация Google. Маск подчеркнул, что на рынке публичного капитала в 100 раз больше средств, чем в сегменте частного. И если финансовые ресурсы ограничивают развитие его компаний, миллиардер готов устранять подобные препятствия. Как ожидается, SpaceX готовится выйти на IPO в середине текущего года, чтобы привлечь дополнительные инвестиции в амбициозные проекты Маска. В Москве не осталось электроэнергии для новых дата-центров — и быстро ситуацию не исправить

05.02.2026 [14:03],

Владимир Мироненко

В Москве практически не осталось свободных мощностей для энергоснабжения центров обработки данных (ЦОД) — они либо уже эксплуатируются, либо зарезервированы на несколько лет вперёд под нужды крупных игроков. В связи с этим энергосетевые компании начали отказывать в заключении договоров на подключение к электросетям новых ЦОД в столице, сообщили «Ведомости» со ссылкой на источники в отрасли.

Источник изображения: İsmail Enes Ayhan/unsplash.com По словам экспертов, ЦОД подключаются к электросетям на общих основаниях, как любые другие промышленные потребители. Согласно постановлению правительства № 861, регулирующему подключение к сети, если у поставщика электроэнергии нет мощностей в необходимом объёме, он может предложить заказчику меньшие мощности, но для ЦОД такой вариант не приемлем, сообщил один из собеседников «Ведомостей». Как сообщает независимый эксперт по энергетике, доктор экономических наук Дмитрий Стапран, возможность дальнейшего размещения новых ЦОД в Москве и ближайшем Подмосковье крайне ограничена. Сроки вводов новой генерации определены на 2027–2030 гг. Строительство новых высоковольтных линий от существующей генерации намечено на 2030–2032 гг. Московские ЦОД заполнены примерно на 95 %, а свободная мощность в регионе не превышает 1400 стойко-мест, сообщил советник губернатора Владимирской области Ахметжан Махмутов. В связи с этим география строительства смещается в другие регионы, частности, новые проекты реализуются в Екатеринбурге, Новосибирске, Казани, Самаре, Нижнем Новгороде, Ростове-на-Дону. Хотя в удалённых от центра регионах нет проблем с подключением, там ниже спрос из-за удалённости от клиентов и точек обмена трафиком, сообщил Махмутов. Сейчас самая низкая цена на оптовом рынке зафиксирована в Сибири, но для большинства клиентов это предложение не представляет интереса из-за проблем с логистикой. Зачастую в регионах размещают небольшие корпоративные ЦОД локальные компании, говорит директор направления дата-центров компании Selectel Илья Михайлов. У бизнеса нет острой необходимости перемещать свои ресурсы, несмотря на профицит мощностей в регионах, отметил он. Крупным компаниям экономически невыгодно строить ЦОД в регионах, потому что основные пользователи сосредоточены в Москве и Подмосковье, сообщил директор по стратегии и аналитике Cloud.ru Андрей Прошлецов. Бизнес стремится размещать IT-инфраструктуру в локациях, наиболее приближённых к клиентам, чтобы минимизировать задержки и другие риски. К тому же для некоторых регионов нецелесообразно строить большие ЦОД, потому что без дополнительных значимых инвестиций в сеть между дата-центрами сигнал будет проходить через Москву, что только увеличит уровень задержек, добавил он. Действующее законодательство предусматривает стимулирование инвестиций в ЦОД — в частности, заключением соглашений о защите и поощрении капиталовложений (СЗПК). В рамках СЗПК, согласно 69-ФЗ «О защите и поощрении капиталовложений в Российской Федерации», возмещаются 50 % фактических расходов на строительство обеспечивающих инфраструктурных объектов, а также на погашение процентов и купонных доходов. Согласно прогнозу кабинета министров, к 2030 году энергопотребление ЦОД в России увеличится минимум в 2,5 раза до 2,5 ГВт. Цена прогресса: Oracle не нашла денег на новые ЦОД и может уволить до 30 тысяч человек

31.01.2026 [18:22],

Павел Котов

Oracle не исключает возможности сократить от 20 тыс. до 30 тыс. сотрудников и продать часть своих подразделений, потому что американские банки отказались финансировать для компании программу по расширению центров обработки данных для систем искусственного интеллекта. Об этом сообщило CIO со ссылкой на информацию от инвестиционного банка TD Cowen.

Источник изображений: BoliviaInteligente / unsplash.com Масштабное сокращение штата высвободит для Oracle от $8 млрд до $10 млрд денежного потока. Компания также рассматривает возможность продажи своего подразделения Cerner, которое разрабатывает ПО для здравоохранения — в 2022 году она поглотила его за $28,3 млрд. На такие меры технологический гигант может пойти из-за того, что несколько американских банков отказались выдать кредиты на проекты ЦОД. Проблемы возникли в связи с масштабом инфраструктурных обязательств Oracle, по которым предусматриваются капитальные затраты на сумму $156 млрд. Ещё один отрицательный фактор — спад в банковской сфере, из-за которого стоимость заимствований Oracle с минувшего сентября выросла вдвое. Такие кредиты выдаются компаниям без инвестиционного рейтинга. Oracle уже активно обращается к долговым рынкам: всего за два месяца она привлекла $38 млрд на объекты в Техасе и Висконсине, а также $20 млрд на проекты в Нью-Мексико. Это лишь малая часть того, что нужно компании, но банки всё чаще неохотно предоставляют средства. Альтернативным решением могут стать азиатские банки, готовые занять нишу, из которой уходят американские кредиторы. Азиатские финансовые институты готовы давать в долг под выгодные проценты в стремлении получить доступ к развитию инфраструктуры ИИ. Для Oracle эта альтернатива открывает новый путь к международной экспансии, но всё же не решает проблем с мощностями в США. Возникают сомнения, сможет ли компания вообще нарастить выручку, если не обеспечит ожидаемых клиентами мощностей ЦОД.  Чтобы сократить потребности в капитале, Oracle начала менять стратегию. От новых клиентов она теперь требует предоплаты в размере 40 %, то есть фактически просит их помочь в финансировании строительства инфраструктуры. Ещё один вариант — размещать на объектах оборудование самих клиентов (Bring Your Own Chip — BYOC). Наиболее вероятным аналитикам представляется сочетание последнего варианта с сокращением штата: оборудование клиентов решит проблему капитальных затрат, а увольнения улучшат денежный поток. Но это сопряжено и с рисками: BYOC потребует пересмотреть существующие контракты, а масштабные сокращения могут повлиять на способность компании реализовать планы по развитию инфраструктуры. Вероятное сокращение штата станет крупнейшим для Oracle за последние годы. В конце минувшего года компания сократила около 10 000 рабочих мест в рамках плана реструктуризации на $1,6 млрд; она также неоднократно сокращала штат Cerner — крупная волна прокатилась в 2023 году из-за проблем с одним из контрактов. Сейчас свои краткосрочные потребности Oracle перенаправила на ресурсы Microsoft и Amazon, хотя всего несколько месяцев назад она арендовала около 5,2 ГВт мощностей для рабочих нагрузок OpenAI. Компания резко замедлила темпы закупок ЦОД и сократила присутствие в списках компаний, имеющих долгосрочные планы развития инфраструктуры в США. Частные операторы, которые при обычных условиях заключали бы с Oracle крупные сделки, теперь воздерживаются от этого шага, «пока рынок не осмыслит текущие потребности Oracle в финансировании». В оценке дальнейших перспектив компании мнения аналитиков резко расходятся. Одни считают, что закупать услуги у Oracle стало рискованно. Вторые говорят, что продажа непрофильных активов поможет компании консолидировать основные сервисы. С точки зрения бизнеса Oracle остаётся сильным игроком. За последний отчётный период она на 66 % нарастила выручку от облачной инфраструктуры и на 177 % — от инфраструктуры, связанной с графическими процессорами и ИИ-ускорителями. Но даже оптимисты призывают клиентов компании диверсифицировать поставщиков услуг. SpaceX запросила разрешение на запуск миллиона спутников для сети орбитальных ЦОД

31.01.2026 [12:11],

Владимир Мироненко

Компания SpaceX направила в пятницу на этой неделе в Федеральную комиссию по связи (FCC) просьбу разрешить запуск до одного миллиона спутников для создания сети центров обработки данных на орбитах от 500 до 2000 км вокруг Земли. В настоящее время на орбите находится немногим более 9600 спутников группировки SpaceX Starlink.

Источник изображения: SpaceX/unsplash.com Согласно заявке, проект представляет собой «созвездие спутников с беспрецедентной вычислительной мощностью для обеспечения работы передовых моделей искусственного интеллекта (ИИ) и приложений, которые на них полагаются». Эти спутники будут использовать энергию Солнца, вращаясь на высоте от 500 до 2000 км с наклоном орбиты 30 градусов и солнечно-синхронным наклоном. Орбитальные ЦОД также будут использовать «оптические каналы связи», или лазеры, для соединения со спутниковой интернет-системой Starlink, используя её для маршрутизации трафика к пользователям на Земле и орбите. В заявлении подчёркивается, что «орбитальные ЦОД — это наиболее эффективный способ удовлетворить растущий спрос на вычислительные мощности для ИИ» на фоне растущих энергозатрат наземных дата-центров. Компания рассчитывает, что запуски космических ЦОД можно ускорить с помощью более мощного космического корабля Starship, использование которого также имеет решающее значение для модернизации группировки Starlink с помощью спутников следующего поколения. В заявке не указаны подробности об орбитальных ЦОД SpaceX. SpaceX лишь заявила, что «планирует проектировать и эксплуатировать различные версии спутникового оборудования для оптимизации работы на разных орбитальных поверхностях». SpaceX подала заявку в FCC, готовясь также к первичному публичному размещению акций, предположительно для финансирования проекта по созданию орбитальных ЦОД. Генеральный директор SpaceX Илон Маск (Elon Musk) ранее заявлял, что его технология Starlink уже заложила основу для построения сети орбитальных ЦОД. Однако запрос на миллион спутников представляется беспрецедентным и, вероятно, столкнётся с пристальным вниманием со стороны FCC, а также с потенциальными критиками, отметил ресурс PCMag. Ранее в этом месяце FCC одобрила запрос SpaceX на эксплуатацию ещё 7500 спутников для группировки Starlink второго поколения, в том числе на более низких орбитах, но не дала разрешение на эксплуатацию всех 22 488 спутников. Китай собрался обогнать SpaceX и развернуть на орбите мощные ИИ ЦОД в течение пяти лет

29.01.2026 [18:51],

Владимир Мироненко

В течение ближайших пяти лет Китай планирует развернуть на околоземной орбите сеть дата-центров для задач ИИ, сообщил государственный телеканал CCTV. Китайская корпорация аэрокосмической науки и техники (CASC) запланировала за обозначенные сроки «построить космическую цифровую интеллектуальную инфраструктуру гигаваттного класса».

Источник изображения: CASC Согласно планам китайского космического агентства, новые космические ЦОД будут «интегрировать возможности облачных вычислений, периферийных устройств и терминальных устройств» и обеспечат «глубокую интеграцию вычислительной мощности, ёмкости хранения и пропускной способности передачи», что позволит обрабатывать в космосе данные, переданные с Земли. Ранее о таких же планах по развёртыванию ЦОД в космосе объявил глава американской аэрокосмической компании SpaceX Илон Маск (Elon Musk). В своём выступлении на Всемирном экономическом форуме в Давосе (Швейцария) на прошлой неделе он сообщил, что SpaceX планирует запустить спутники с ИИ ЦОД, работающими на солнечной энергии, в течение следующих двух-трёх лет. «Создание ЦОД на солнечной энергии в космосе — это очевидное решение... самое доступное по стоимости место для размещения ИИ — это космос, и это станет реальностью в течение двух лет, самое позднее — трёх», — сказал Маск, добавив, что солнечная генерация на орбите обеспечивает в пять раз больше энергии, чем панели на Земле. В связи с проблемами в обеспечении электроэнергией строящихся ЦОД компания Илона Маска рассчитывает использовать средства, привлечённые благодаря запланированному на этот год масштабному IPO на сумму $25 млрд, на разработку орбитальных ИИ ЦОД. Согласно документам CASC, Китай также планирует перенести энергоёмкую нагрузку обработки данных ИИ на орбиту, используя солнечные электростанции «гигаваттного класса» для создания к 2030 году промышленного «космического облака». Использование космической солнечной энергии для ИИ-вычислений является одной из ключевых задач грядущего 15-го пятилетнего плана экономического развития Китая. Согласно документам, CASC также планирует «достичь возможности осуществления полётов в рамках суборбитального космического туризма и постепенно развивать орбитальный космический туризм» в течение следующих пяти лет, сообщает CCTV. Главным препятствием для Пекина в осуществлении масштабных планов до сих пор является неспособность завершить разработку многоразовой ракеты, что имеет решающее значение для снижения стоимости пусков и удешевления вывода спутников в космос. В прошлом году Китай осуществил рекордные 93 космических запуска, что стало возможным благодаря развитию коммерческих космических стартапов. Илон Маск созрел для вывода SpaceX на биржу благодаря идее создания ЦОД в космосе

22.01.2026 [13:07],

Алексей Разин

Казалось бы, не все высказывания эксцентричного миллиардера Илона Маска (Elon Musk) следует воспринимать всерьёз, но за некоторые идеи он ухватывается настолько сильно, что не жалеет никаких средств на их воплощение. Заявив о необходимости строить центры обработки данных в космосе, он понял, что деньги на их создание придётся привлекать через публичное размещение акций SpaceX.

Источник изображения: SpaceX Одноимённая частная аэрокосмическая компания до сих пор остаётся частной, но серьёзные привлекаемые суммы инвестиций позволяли ей претендовать на звание самого дорогого стартапа в мире, пока конкурировать с ней за этот статус не начала OpenAI. Исторически руководство SpaceX придерживалось позиции, согласно которой выходить на IPO будет необходимо лишь после того, как ракеты-носители этой марки начнут регулярно совершать полёты на Марс. Идею о возможности строительства ЦОД в космосе высказывал не только Илон Маск, но он буквально загорелся ею, как поясняет The Wall Street Journal, а потому стремится стать первопроходцем в этой сфере. Деньги на реализацию этой идеи можно было бы взять на фондовом рынке путём размещения акций SpaceX, поэтому соответствующее событие наверняка произойдёт раньше, чем планировалось. Кроме того, средства пригодились бы и для качественного рывка в развитии ИИ-стартапа xAI, для которого Маск и будет строить ЦОД в космосе. Соперничающий с Маском Сэм Альтман (Sam Altman), возглавляющий OpenAI, в прошлом году изучал возможность покупки аэрокосмической компании для доставки элементов ЦОД на орбиту Земли. Маск решил поторопиться с IPO компании SpaceX ещё и по той причине, что в этом году на публичный фондовый рынок готовятся выйти конкурирующие с xAI стартапы OpenAI и Anthropic. Чтобы иметь шансы привлечь больше средств инвесторов, нужно опередить соперников с IPO, как считает Маск. Уже скоро он выберет банки для сопровождения этой процедуры, а провести IPO компании SpaceX он намерен в районе июля. Опыт руководства публичной компанией Tesla нельзя назвать исключительно приятным для Маска, поскольку он то и дело сталкивается с претензиями регуляторов и судебными исками, поэтому готовность вывести SpaceX на IPO говорит об отсутствии у миллиардера разумных альтернатив быстро собрать желаемые суммы. Как поясняют осведомлённые источники, SpaceX тайно разрабатывала технологии создания вычислительных центров в космосе уже несколько лет подряд, и в прошлом году она добилась некоторого прогресса в этой области. К середине прошлого года Маск всё более настойчиво начал говорить о соответствующих инициативах, строительство ЦОД в космосе буквально стало для него приоритетной идеей. Илон Маск владеет более чем 40 % акций SpaceX, после выхода компании на биржу он смог бы продавать или закладывать их для реализации прочих проектов, а ещё SpaceX могла бы купить пакет акций xAI для поддержки данного стартапа, который пока сталкивается с серьёзной конкуренцией со стороны OpenAI и других игроков рынка. По сути, SpaceX и xAI уже сотрудничают. Прошлым летом SpaceX вложила в xAI около $2 млрд, а сервис технической поддержки клиентов дочерней компании Starlink работает на основе технологий xAI. Как добавляет WSJ, руководство SpaceX поставило сотрудников компании в известность о намерениях выйти на IPO в 2026 году ещё в начале прошлого месяца. Стремление развернуть ЦОД в космосе прямо указывалось в качестве главной причины выхода на фондовый рынок. Успех программы ракеты-носителя Starship позволил бы SpaceX решить многие технические проблемы, связанные со строительством ЦОД в космосе, но пока компания не перешла к регулярному коммерческому использованию этой ракеты. Испытания обновлённой версии Starship должны состояться в скором времени. Дата-центры будущего смогут отапливать дома — благодаря пассивному охлаждению на тепловых трубках

17.01.2026 [14:07],

Геннадий Детинич

Не секрет, что современные центры обработки данных потребляют огромные объёмы энергии, значительная часть которой расходуется на охлаждение серверов и высокопроизводительных компонентов. По мере роста спроса на вычислительные мощности, особенно для задач искусственного интеллекта и обработки больших данных, традиционные системы охлаждения всё чаще оказываются неэффективными и дорогостоящими в эксплуатации. Выход может быть в ином принципе охлаждения.

Источник изображения: Danish Technological Institute В рамках европейского исследовательского проекта AM2PC исследователи разработали перспективную систему пассивного охлаждения, изготовленную с помощью 3D-печати из алюминия, которая работает без вентиляторов и насосов. Основной принцип её работы основан на двухфазном тепловом цикле: хладагент испаряется на горячей поверхности чипа, поднимается вверх, конденсируется и затем возвращается вниз под действием гравитации. Подобный подход давно реализован в системах охлаждения с тепловыми трубками, однако в случае AM2PC он приобретает иной масштаб. Объёмная печать из алюминиевого порошка (вероятно, спекаемого лазером) позволяет одновременно сформировать рабочую камеру для хладагента и выход на внешний изолированный контур циркуляции жидкости, отводящей тепло. Как считают разработчики, такой способ изготовления компонентов для систем охлаждения сохраняет гибкость проектирования и одновременно гарантирует отсутствие протечек. На начальном этапе отвода тепла система работает пассивно, не требуя электроэнергии для вентиляторов и насосов. Кроме того, более высокие температуры в камерах пассивного охлаждения (60–80 °C) открывают возможности для повторного использования тепла — например, в системах городского отопления или промышленных процессах, если такие объекты расположены вблизи ЦОД, а также в тепличных хозяйствах. Впрочем, непосредственно этими направлениями применения исследователи не занимались. Использование 3D-печати для создания комплекса охлаждающих компонентов также снижает материальные затраты и упрощает утилизацию, поскольку все элементы могут быть выполнены из одного перерабатываемого материала. По предварительным оценкам жизненного цикла компонентов, изготовленных таким образом, выбросы CO₂ на единицу оборудования могут снизиться на 25–30 %. Разработка AM2PC демонстрирует потенциал сочетания передовых методов аддитивного производства и термодинамических принципов для решения одной из ключевых проблем энергетики ЦОД. В условиях растущей вычислительной нагрузки и усиливающегося внимания к устойчивому развитию такие технологии могут стать частью стандартных практик проектирования будущих инфраструктур. Интеграция пассивного охлаждения способна не только сократить эксплуатационные расходы, но и повысить долговечность оборудования за счёт более стабильного температурного режима работы. В то же время следует отметить, что отсутствие унификации и фабричного производства компонентов по определению не может привести к существенной экономии (если она вообще возможна). Кроме того, изготовление под заказ означает отсутствие стандартизированных проектов и планирования, что в конечном итоге может усложнить обслуживание фактически кустарно собранных систем охлаждения. Microsoft пообещала не перекладывать счета за питание ИИ на американцев — у компании есть план

13.01.2026 [20:47],

Сергей Сурабекянц

Технологическим гигантам приходится реагировать на волну общественных протестов против центров обработки данных (ЦОД). Сегодня компания Microsoft объявила о плане «Инфраструктура ИИ, ориентированная на сообщество». Он предусматривает пять основных пунктов: предотвращение роста стоимости электроэнергии из-за энергопотребления ЦОД, снижение потребления воды, обучение сотрудников, создание рабочих мест, а также уплату налогов в местах деятельности компании.

Источник изображения: unsplash.com Рост тарифов на электроэнергию по всей территории США стал одним из самых острых вопросов, и эта тенденция в значительной мере обусловлена увеличением спроса на электроэнергию со стороны ЦОД. Согласно декабрьскому отчёту правозащитной группы Climate Power, счета за электроэнергию для домохозяйств в масштабах страны выросли в 2025 году на 13 %. По прогнозам Министерства энергетики, спрос на электроэнергию для ЦОД к 2028 году резко возрастёт и составит до 12 % от общего объёма потребления электроэнергии в США. «Сейчас настал момент, когда нам нужно прислушаться [к сообществу] и напрямую ответить на эти вопросы», — заявил сегодня в прямом эфире президент Microsoft Брэд Смит (Brad Smith). Microsoft пообещала «попросить коммунальные предприятия и государственные комиссии установить тарифы достаточно высокими, чтобы покрыть расходы на электроэнергию для наших центров обработки данных», включая расходы, связанные со строительством новой инфраструктуры для удовлетворения растущего спроса. Смит также заверил общественность, что компания в своей деятельности не будет использовать субсидии на электроэнергию. Разработчики ЦОД и технологические компании подверглись критике со стороны местных жителей за заключение сделок с коммунальными предприятиями за закрытыми дверями и требования подписать соглашения о неразглашении, ограничивающие доступ общественности к информации. В связи с этим группа сенаторов направили Microsoft, Google, Amazon, Meta✴✴ и крупным разработчикам ЦОД письмо с требованием раскрыть информацию об их энергопотреблении и усилиях по лоббированию на местном уровне. Microsoft пообещала обеспечить максимальную прозрачность в отношении мест строительства планируемых ЦОД и их энергопотребления. Microsoft — не единственная крупная технологическая компания, которой приходится реагировать на требования местных жителей. Meta✴✴ в декабре 2025 года пообещала восстановить источники воды в местах, где расположены ЦОД компании. А Amazon в конце прошлого года провела исследование, которое показало, что ЦОД компании приносят коммунальным предприятиям больше дохода, чем обходится коммунальным предприятиям обслуживание этих объектов. По данным анализа Heatmap Pro, по меньшей мере 25 проектов по всей территории США были отменены после негативной реакции местных жителей. «Правда в том, что развитие инфраструктуры продвигается только тогда, когда сообщества приходят к выводу, что выгоды перевешивают затраты», — был вынужден признать Смит. Президент США Дональд Трамп (Donald Trump), который в прошлом году обещал ускорить развитие ЦОД в рамках своего «Плана действий в области ИИ», теперь также присоединился к волне недовольства по поводу стремительно растущих счетов за электроэнергию. Он заявил, что его команда работает с Microsoft и другими технологическими компаниями, чтобы американцы не платили за потребление электроэнергии центрами обработки данных. Американцы взбунтовались против ЦОД: протесты уже похоронили 25 дата-центров

13.01.2026 [13:23],

Алексей Разин

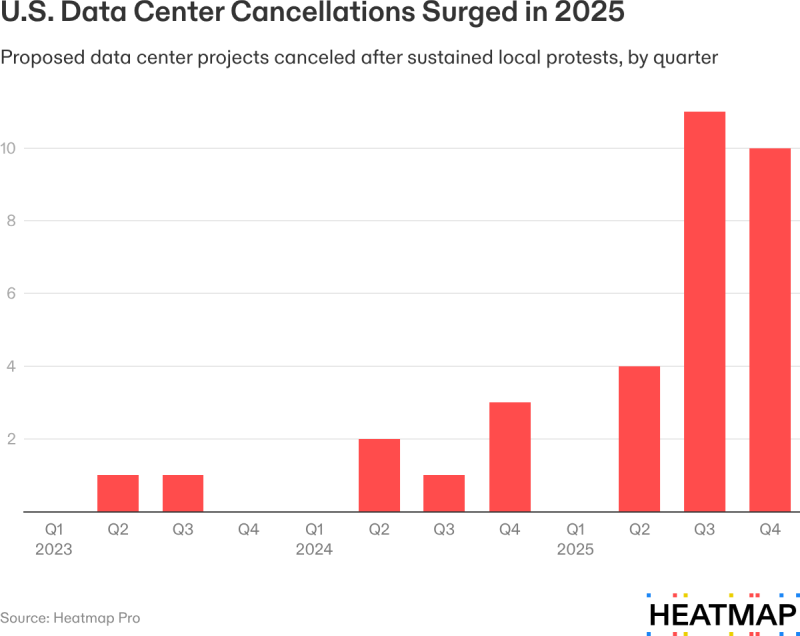

По оценкам Goldman Sachs, в этом году инвесторы будут готовы направить более $500 млрд на строительство новых ЦОД в США, однако их владельцы сталкиваются с новой проблемой — ростом протестов со стороны местных жителей против возведения таких объектов. Только в прошлом году по этой причине были отменены проекты по строительству 25 центров обработки данных.

Источник изображения: Unsplash, Wim van 't Einde В общей сложности эти ЦОД могли бы потреблять до 4,7 ГВт электроэнергии, как отмечает Heatmap со ссылкой на собственное исследование. Примечательно, что ещё несколько лет назад случаи отмены строительства крупных инфраструктурных объектов из-за протестов местного населения были значительно более редкими. Американские граждане не только выступают против строительства новых электростанций из-за их потенциального воздействия на окружающую среду, но и сомневаются в необходимости столь активного развития профильной инфраструктуры. Как гласит источник, из 770 проектов по строительству ЦОД в США с протестами со стороны населения сталкиваются не менее 99. В стадии строительства в настоящее время находятся около 200 центров обработки данных. По имеющейся статистике, около 40 % проектов ЦОД, встретивших противодействие местных жителей, в итоге не воплощаются в жизнь. Темпы развития вычислительной инфраструктуры в США требуют ввода новых генерирующих мощностей. В прошлом году объёмы потребления электроэнергии со стороны ЦОД выросли на 22 %, по данным S&P Global. Согласно прогнозам, в ближайшие десять лет энергопотребление американских ЦОД удвоится или даже утроится. При этом количество протестов против строительства подобных объектов за последние 12 месяцев выросло в четыре раза. Некоторые эксперты считают, что до конечной реализации дойдёт не более 10 % запланированных к вводу в строй ЦОД.

Источник изображения: Heatmap Прошлое полугодие характеризовалось особенно заметным ростом протестов. Из 25 отменённых в США проектов по строительству ЦОД на второе полугодие пришёлся 21. Местных жителей чаще всего беспокоит рост потребления воды из локальных коммунальных сетей, возникающий при строительстве по соседству крупных энергетических объектов. Эта причина в 40 % случаев становится решающей при отмене проектов по возведению ЦОД в США. Рост энергопотребления в регионе и цен на электроэнергию следуют за проблемами с водоснабжением в перечне причин для протеста, а замыкает его обеспокоенность повышением уровня шума в окрестностях. Всё чаще застройщикам ЦОД приходится задумываться и о вводе в эксплуатацию выделенных электростанций для их энергоснабжения. Интересно, что в Техасе, где потребности строящихся ЦОД в электроэнергии оцениваются в 150 ГВт, пока не был отменён ни один проект по причине протестов населения, хотя это можно объяснить и сложностью соответствующих процедур. Основная часть отменённых проектов по строительству ЦОД сосредоточена вдоль восточного побережья США и на Среднем Западе. В некоторых регионах страны местные власти даже готовят инициативы о полном запрете строительства новых центров обработки данных на соответствующих территориях. Илон Маск купил третье здание для проекта Colossus своего ИИ-стартапа xAI

31.12.2025 [08:18],

Алексей Разин

Не отличающийся скромностью амбиций Илон Маск (Elon Musk) демонстрирует их в сегменте ИИ, активно развивая вычислительную инфраструктуру своего стартапа xAI. Специализированный ЦОД Colossus в конечном итоге должен предложить миллиардеру до 2 ГВт вычислительной мощности, и для достижения цели он приобрёл третье здание.

Источник изображения: Nvidia Со страниц социальной сети X миллиардер заявил, что xAI приобрела третье здание, которое получило условное обозначение Macrohardrr (правописание оригинала сохранено). По всей видимости, в таких наименованиях Илон Маск продолжает обыгрывать тему соперничества с Microsoft, составляя обозначения своих проектов из антонимов имени известной американской корпорации. По данным The Information, третье здание для Colossus располагается за пределами Мемфиса (штат Теннесси) на территории соседнего штата Миссисипи. В совокупности, площадка должна разместить не менее 1 млн графических процессоров. Расположенная рядом ТЭС, питающаяся природным газом, будет снабжать ЦОД электроэнергией. На протяжении 2025 года, как напоминает Bloomberg, Илон Маск весьма активно привлекал средства на развитие упоминаемых выше ЦОД. Компания xAI была готова продать собственных акций и привлечь долговых обязательств на общую сумму $20 млрд. Основную часть этих средств предполагалось потратить на закупку ускорителей Nvidia, ведь только для второго здания Colossus потребовалось бы около 550 000 штук, а каждая стоит десятки тысяч долларов США. Неуёмный аппетит ИИ предложили утолить списанными атомными реакторами авианосцев и подлодок ВМС США

26.12.2025 [13:06],

Владимир Фетисов

Техасская компания HGP Intelligence Energy направила запрос в Министерство энергетики США, предложив перепрофилировать два списанных реактора ВМС страны для обеспечения энергией центров обработки данных на базе искусственного интеллекта в Национальной лаборатории Ок-Ридж в Теннеси. Этот проект может быть реализован в рамках инициативы президента США Дональда Трампа (Donald Trump) Genesis Mission.

Источник изображения: Clint Davis/Public Domain HGP Intelligence Energy планирует задействовать два старых реактора для выработки от 450 до 520 мегаватт энергии. В настоящее время ВМС США используют реакторы Westinghouse A4W для энергоснабжения атомных авианосцев класса «Нимиц» и реакторы General Electric S8G для атомных подводных лодок класса «Лос-Анджелес». Авианосец USS Nimitz, принятый на вооружение в 1975 году, уже находится в своём последнем походе перед списанием. Кроме того, из эксплуатации уже выведено около трети от общего количества подводных лодок класса «Лос-Анджелес», которые начали использоваться в 1976 году. По данным Всемирной ядерной организации, за более чем 50 лет эксплуатации ВМС США использовали свыше 100 ядерных реакторов без единой аварии, связанной с радиационным заражением. Это доказывает высокую надёжность реакторов. В случае одобрения предложения HGP Intelligence Energy проект компании станет первым случаем перепрофилирования военного реактора для гражданского использования. Ожидается, что реализация проекта обойдётся в сумму от $1 млн до $4 млн за мегаватт энергии. Хотя конечная сумма может оказаться высокой, она будет значительно ниже объёма затрат, необходимых для строительства совершенно новой атомной электростанции или достаточного количества модульных реакторов. Проект также может подарить вторую жизнь списанным реакторам, которые в противном случае были бы попросту утилизированы на одном из объектов Министерства энергетики США. Компания намерена обратиться в Министерство энергетики для получения кредитных гарантий. Общая стоимость проекта оценивается в сумму от $1,8 млрд до $2,1 млрд. В эту сумму входит подготовка инфраструктуры, необходимой для повторного запуска реакторов и их переоборудования для работы в ЦОД. После начала эксплуатации HGP Intelligence Energy планирует реализовать программу распределения доходов с правительством, а также сформировать фонд для вывода из эксплуатации. Последнее особенно важно, поскольку работа с выведенными из эксплуатации реакторами обходится чрезвычайно дорого. Демонтаж первого атомного авианосца США обошёлся более чем в десять раз дороже, чем утилизация последнего обычного авианосца. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |