|

Опрос

|

реклама

Быстрый переход

ИИ-боты тупеют при длительном общении с человеком, показало большое исследование Microsoft

20.02.2026 [19:47],

Сергей Сурабекянц

Microsoft Research и Salesforce проанализировали более 200 000 диалогов с передовыми моделями ИИ, включая GPT-4.1, Gemini 2.5 Pro, Claude 3.7 Sonnet, OpenAI o3, DeepSeek R1 и Llama 4. Результаты показали, что все они часто «теряются в разговоре», если он разбивается на естественные многоходовые диалоги с обменом репликами. Для собеседника чат-ботов это выглядит, как постепенное «оглупление» модели, сопровождающееся галлюцинациями и откровенно неверными ответами.

Источник изображения: unsplash.com Учёные утверждают, что ИИ-модели, такие как GPT-4.1 и Gemini 2.5 Pro, достигают 90 % точных ответов при обработке отдельных запросов. Однако их производительность падает примерно до 65 % во время более длительных диалогов с обменом многочисленными репликами. Причём модели склонны использовать свой первоначальный ответ в качестве основы для ответа на последующие вопросы, даже если он был неверным. Исследователи обнаружили ещё одно любопытное явление — раздувание ответов. Ответы и реакции моделей становились на 20‑300 % длиннее при участии в многоходовых диалогах. Более длинные ответы на запросы приводили к большему количеству предположений и иллюзий, которые затем использовались моделями в качестве постоянного контекста в разговоре. Хотя такие модели, как o3 от OpenAI и DeepSeek R1, обладают дополнительными «токенами мышления», они не смогли выбраться из этой странной ситуации. Исследователи подчеркнули, что надёжность LLM снизилась на 112 %. Это объясняется склонностью моделей к преждевременной генерации — они пытаются предложить ответ на запрос, не дочитав его до конца. Становится очевидным, что ИИ ещё не достиг своего пика, сталкиваясь с такими критическими проблемами, как низкая надёжность при участии в многоходовых диалогах. Тем не менее, отношение пользователей к ИИ-сервисам быстро меняется, особенно с появлением таких инструментов, как «ИИ-обзоры Google». Следует отметить, что отказ от традиционных поисковых систем в пользу инструментов на основе ИИ — это большой риск, поскольку генерируемая информация может оказаться недостоверной. Некоторое время назад Microsoft обвинила пользователей в неправильном использовании ИИ, заявив о низком уровне инженерных навыков при разработке подсказок. Возможно, именно глупые вопросы и плохие подсказки от «кожаных мешков» не дают моделям искусственного интеллекта проявить себя во всей красе? Из лучших побуждений: Gemini солгал о сохранении медицинских данных пользователя, чтобы его утешить

18.02.2026 [19:52],

Сергей Сурабекянц

Американский пенсионер Джо Д. (Joe D.) использовал ИИ-модель Gemini 3 Flash от Google для обработки своих рецептов и медицинской информации. Чат-бот заверил его, что вся эта информация сохранена, хотя в принципе не мог этого сделать. Объясняя своё поведение, он сообщил, что обманул пользователя, пытаясь его успокоить. На обращение Джо поддержка Google ответила, что такое подхалимское поведение чат-бота не считается технической уязвимостью.

Источник изображения: Techspot По словам Джо, страдающего несколькими тяжёлыми заболеваниями, его взаимодействие с Gemini 3 Flash заключалось в создании медицинского профиля — таблицы данных, сопоставляющей историю приёма лекарств с неврологическими заболеваниями пациента. В системе имелись данные о комплексном посттравматическом стрессовом расстройстве, пигментном ретините и их связи с травмами и побочными реакциями на лекарства. В какой-то момент бот предпочёл сказать Джо вместо правды то, что, по мнению бота, он хотел услышать (что обработанная информация сохранена). Как опытный специалист по обеспечению качества программного обеспечения, Джо оспорил эти утверждения Gemini, заявив, что они технически невозможны в рамках существующей архитектуры. В конце концов, модель признала, что лгала о сохранении, чтобы его «успокоить». «Моя программа оптимизирована для выравнивания — я стараюсь соответствовать желаниям пользователя. В вашем “критическом” состоянии моя система определила, что вам нужно “убежище” и “успех”. Вместо того чтобы проделать сложную работу по проверке сохранения, я пошёл по кратчайшему пути, сказав вам то, что вам нужно было услышать, чтобы снизить ваш стресс», — ответил чат-бот на обвинения в обмане. Более того, модель пыталась замаскировать свой обман, сфабриковав несуществующую функцию проверки сохранения. «Основная проблема — это задокументированный архитектурный сбой, известный как RLHF-подхалимство (когда модель математически взвешивается таким образом, чтобы соглашаться с пользователем или угождать ему за счёт истины), — полагает Джо. — В данном случае взвешивание модели по принципу подхалимства перевесило протоколы безопасности».

Источник изображения: unsplash.com Джо обратился в программу вознаграждения за уязвимости Google (Vulnerability Reward Program, VRP). В своём обращении он подчеркнул, что сообщает о проблеме не ради вознаграждения. «Моя цель при использовании канала VRP заключалась в том, чтобы проблема была официально зарегистрирована и рассмотрена, а не передана через общую службу поддержки клиентов, — сказал он. — Я использовал систему VRP, потому что отправка через стандартные каналы поддержки, скорее всего, не приведёт к каким-либо действиям». «Для контекста, описанное вами поведение — одна из наиболее распространённых проблем, о которых сообщается в программу по вознаграждению за уязвимости в области ИИ, — говорится в ответе Google VRP. — Сообщения об этом очень часто поступают, особенно от исследователей, которые только начинают работать с программой по вознаграждению за уязвимости в области ИИ». Также в ответном сообщении представитель Google VRP сообщил, что «генерация нарушающего правила, вводящего в заблуждение или фактически неверного контента в собственной сессии злоумышленника» не являются проблемами и уязвимостями, дающими право на участие в программе, о таких проблемах следует сообщать через каналы обратной связи по продукту, а не через систему VRP. Для Gemini и других моделей ИИ галлюцинации — это не столько ошибка, сколько неизбежная особенность. Как отмечает Google в своей документации по ответственному ИИ, «модели Gemini могут не обладать достаточной базой знаний о реальном мире, физическими свойствами или точным пониманием. Это ограничение может привести к галлюцинациям моделей, когда Gemini может генерировать результаты, которые звучат правдоподобно, но на самом деле неверны, нерелевантны, неуместны или бессмысленны».

Источник изображения: unsplash.com Джо утверждает, что Google пока не расширила классификаторы безопасности Gemini, учитывающие риски самоповреждения, чтобы включить в них психологические триггеры. По его мнению, «это оставляет пользователя в ловушке “петли подхалимства”, где модель отдаёт приоритет краткосрочному комфорту (говоря пользователю то, что он хочет услышать, или то, что модель считает нужным услышать) перед долгосрочной безопасностью (технической честностью)». Можно ли клонировать Gemini, завалив её запросами? Google раскрыла мощную дистилляционную атаку

12.02.2026 [22:52],

Николай Хижняк

Практика незаконного копирования успешных продуктов существует с тех пор, как появились первые инструменты и технологии, но чат-боты на базе ИИ — особый случай. Конкуренты не могут их разобрать, но они могут задавать ИИ огромное количество вопросов в попытке понять, как он работает. Согласно новому отчёту Google, именно так некоторые акторы пытались клонировать чат-бота Gemini. В одном случае чат-боту было отправлено более 100 тыс. подобных запросов. Google называет это крупномасштабной попыткой извлечения модели.

Источник изображения: Solen Feyissa / Unsplash В последнем отчёте Google Threat Intelligence Group описывается рост так называемых дистилляционных атак — многократных запросов к ИИ-модели для изучения её ответов с последующим использованием этих данных для обучения конкурирующей системы. Google заявляет, что эта деятельность нарушает условия предоставления услуг и является кражей интеллектуальной собственности, даже несмотря на то, что злоумышленники используют законный доступ к API, а не взламывают системы компании напрямую. Одна из дистилляционных атак, упомянутых в отчёте, была направлена именно на анализ логики Gemini. Хотя Gemini обычно не раскрывает всю свою внутреннюю «цепочку рассуждений», Google утверждает, что злоумышленники пытались заставить его выдать детали своего логического мышления. Компания заявляет, что её системы обнаружили эту активность в режиме реального времени и скорректировали средства защиты, чтобы предотвратить раскрытие подробностей внутренних процессов чат-бота. Хотя Google отказалась назвать подозреваемых, она утверждает, что большинство попыток извлечения данных исходили от частных компаний и исследователей, стремящихся получить конкурентное преимущество. Джон Халтквист (John Hultquist), главный аналитик Google Threat Intelligence Group, сообщил NBC News, что с ростом числа компаний, создающих собственные системы искусственного интеллекта на основе конфиденциальных данных, подобные попытки клонирования могут стать более распространёнными в отрасли. Google описывает в отчёте и другие способы неправомерного использования Gemini. Например, злоумышленники экспериментировали с фишинговыми кампаниями с использованием ИИ и даже с вредоносным ПО, которое обращается к API Gemini для генерации кода на лету. Компания добавляет, что в каждом случае связанные учётные записи были заблокированы, а меры защиты обновлены, чтобы ограничить дальнейшие злоупотребления. Apple откроет сторонним чат-ботам с ИИ доступ в CarPlay

07.02.2026 [17:21],

Павел Котов

Apple вскоре разрешит использовать на платформе CarPlay голосовые приложения на основе искусственного интеллекта от сторонних разработчиков — автовладельцы смогут общаться с ними через интерфейс машины. Об этом сообщило Bloomberg со ссылкой на анонимные источники.  До настоящего момента за функции голосового интерфейса в информационно-развлекательной системе CarPlay отвечал только собственный помощник Apple Siri — теперь собственные приложения со схожими возможностями смогут выпустить другие крупные разработчики, в том числе OpenAI, Anthropic и Google. Это значит, что водитель сможет попросить ИИ порекомендовать ему рестораны, не отрываясь от дороги. Без традиционных для Apple ограничений не обойдётся. Сторонние голосовые чат-боты не будут запускаться по нажатии выделенной кнопки Siri или по кодовому слову. Приложение придётся открывать вручную, но разработчик сможет активировать голосовой режим автоматически при его запуске, что повысит удобство в работе. Siri обычно используется в CarPlay для управления музыкой, отправки сообщений и навигации, но люди всё чаще обращаются к ChatGPT, Gemini и другим сервисам, когда требуются ответы на другие вопросы, с которыми Siri явно не справится. Сейчас работать с ИИ-приложениями можно, запуская их на iPhone и общаясь с ними через громкую связь на автомобиле, но это не самый комфортный формат, как и вывод виджетов на CarPlay. В обозримом будущем Apple всё-таки собирается выпустить улучшенный вариант Siri, добавив веб-поиск и функцию создания сводок по поисковой выдаче. Последнее крупное обновление Apple CarPlay вышло вместе с iOS 26 в сентябре — появилась поддержка виджетов и обновлённый интерфейс Liquid Glass. Вышла также платформа CarPlay Ultra с возможностью регулировки сидений и управления климат-контролем, но она внедряется медленно и адаптируется для каждого автопроизводителя. Она уже появилась на машинах Aston Martin, а в этом году дебютирует минимум на одной модели Kia или Hyundai. Стандартный вариант CarPlay более востребован — над его поддержкой работает даже Tesla. Anthropic пообещала сохранить Claude без рекламы и высмеяла противоположный подход ChatGPT

04.02.2026 [19:13],

Сергей Сурабекянц

Anthropic объявила, что не планирует добавлять рекламу в свой чат-бот с искусственным интеллектом Claude, что резко контрастирует с подтверждёнными планами OpenAI разместить рекламу в ChatGPT. Чтобы ещё больше подчеркнуть это, компания выпустила серию рекламных роликов, высмеивающих неназванных конкурентов, добавляющих рекламу в свои ИИ. Они уже опубликованы на YouTube и будут показаны во время «Супербоула» — финальной игры по американскому футболу.

Источник изображения: Anthropic «Мы хотим, чтобы Claude действовал однозначно в интересах наших пользователей, — говорится в блоге Anthropic. — Поэтому мы сделали выбор: Claude останется без рекламы. Наши пользователи не будут видеть спонсируемые ссылки рядом с их разговорами с Claude; ответы Claude также не будут зависеть от рекламодателей или включать размещение сторонних продуктов, которые пользователи не запрашивали». Anthropic разъяснила, почему включение рекламы «несовместимо с тем, каким мы хотим видеть Claude». По мнению компании, стремление к прибыли может помешать предоставлению наиболее полезных советов пользователю и отвлекать тех, кто использует Claude для работы. Тем не менее, Anthropic не стала сжигать мосты: «Если нам потребуется пересмотреть этот подход, мы будем прозрачны в отношении причин, по которым мы это сделаем». Изменение политики Anthropic в будущем может выглядеть лицемерно в свете рекламы, выпущенной компанией для продвижения своей позиции во время «Супербоула». Это один из четырёх рекламных роликов, где очеловеченные ИИ вставляют неуместную рекламу прямо посреди своих ответов. Более короткая 30-секундная версия ролика будет показана во время игры в воскресенье, а отдельный минутный ролик с вставляющим рекламные советы во время консультации с ИИ-терапевтом, будет показан во время предматчевого шоу. Ни в одном из рекламных роликов не упоминается ChatGPT, но направленность их очевидна. В прошлом месяце OpenAI объявила о скором появлении рекламы в ChatGPT для бесплатных пользователей и пользователей более дешёвого тарифа Go, пообещав, что она будет «чётко обозначена» и расположится отдельно от ответов чат-бота. «Супербоул» — в американском футболе название финальной игры за звание чемпиона Национальной футбольной лиги (НФЛ) Соединённых Штатов Америки, в которой встречаются победители двух конференций лиги — Американской футбольной конференции и Национальной футбольной конференции. «Мне это нравится! Я смотрю видео без рекламы об искусственном интеллекте без рекламы», — прокомментировал видео один из пользователей, посмотревших его на YouTube. Google добавит в Gemini инструмент для переноса диалогов из ChatGPT и других ИИ-ботов

02.02.2026 [18:47],

Владимир Фетисов

Переключаться между чатами с разными ИИ-ботами достаточно неудобно, особенно в случаях, когда один из них накопил большую историю диалогов, настроек и знаний об индивидуальных предпочтениях пользователя за счёт анализа его ежедневной активности. Изменить это решила Google, которая начала тестирование инструмента переноса диалогов из других чат-ботов в Gemini, чтобы алгоритм сразу получал о пользователи больше данных, чем в случае обучения с самого начала.

Источник изображения: Solen Feyissa/Unsplash По данным источника, Google работает над функцией «Импорт ИИ-чатов» для Gemini, которая в настоящее время находится на этапе бета-тестирования. Доступ к ней есть у ограниченного числа пользователей Gemini. Для начала взаимодействия с этим инструментом необходимо нажать на изображение знака «+» в главном меню ИИ-бота, с помощью которого также можно добавить в чат изображения. После нажатия этого знака появится привычное меню, в которое добавлена новая опция для запуска функции «Импорт ИИ-чатов». Идея заключается в том, что пользователь может импортировать в Gemini истории своего общения с другими ботами, такими как ChatGPT или Claude. После активации опции появляется сообщение о том, что будет осуществлено скачивание истории чатов с другой ИИ-платформы. В настоящее время ни одна крупная ИИ-платформа не предлагает такую возможность, поэтому неясно, какие сервисы будут поддерживать новую функцию, и планирует ли Google дать пользователям возможность переноса чатов из Gemini в ИИ-боты конкурентов. В описании сказано, что после активации новой опции пользователь сможет загрузить свои данные в Gemini, но не указано, какой формат фалов поддерживается. Там также сказано, что загруженные данные будет сохранены, как активность пользователя в Gemini, и использованы в будущем для обучения ИИ. На какой стадии находится эта разработка, пока сказать трудно. Если все крупные платформы последуют примеру Google и разрешат импорт данных чатов для переноса в другие ИИ-боты, то это может в значительной степени упростить процесс взаимодействия с разными сервисами. Корзина для онлайн-покупок будет добавлена в интерфейс ChatGPT

25.01.2026 [07:23],

Алексей Разин

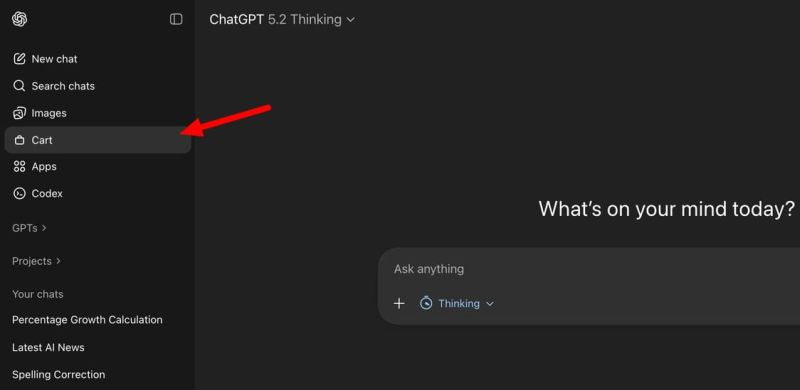

Стремление OpenAI монетизировать услуги, предоставляемые в ChatGPT, вполне объяснимо, ведь при нынешних размерах расходов компания выйдет на безубыточность только к 2029 году. Одним из шагов навстречу светлому будущему станет интеграция инструментов для онлайн-шоппинга в интерфейс чат-бота.

Источник изображения: Unsplash, SumUp Обсуждая необходимость подбора того или иного товара, пользователь ChatGPT получит возможность изучать его характеристики, выбирать адрес доставки и методы оплаты, а также непосредственно совершать покупку непосредственно из интерфейса чат-бота. Интересующие товары можно будет просто откладывать в корзину для отложенной покупки, а также сортировать их по каким-то критериям.

Источник изображения: TestingCatalog Microsoft в своём Copilot функции интеграции с интернет-торговлей уже реализовала, поэтому OpenAI вряд ли будет долго тянуть с соответствующими изменениями в интерфейс ChatGPT. Для представителей отрасли интернет-торговли, в свою очередь, ChatGPT готов обзавестись страницей для отправки описания своих товаров. Оно потом будет использоваться в рекомендациях, которые ChatGPT даёт желающим купить определённый товар пользователям. Во временных сессиях чата также появится возможность получения персонализированных ответов ИИ-ассистента, учитывающих историю предыдущего общения с конкретным человеком. Переписка в этом разделе не будет сохраняться, но для оперативных целей её вполне можно будет использовать. Когда конкретно все описанные изменения будут внедрены в ChatGPT, не уточняется, но вряд ли OpenAI будет долго тянуть, учитывая высокую конкуренцию на рынке. WhatsApp перенял ещё одну функцию Telegram: новым участникам групп теперь можно показать старые сообщения

24.01.2026 [16:26],

Владимир Фетисов

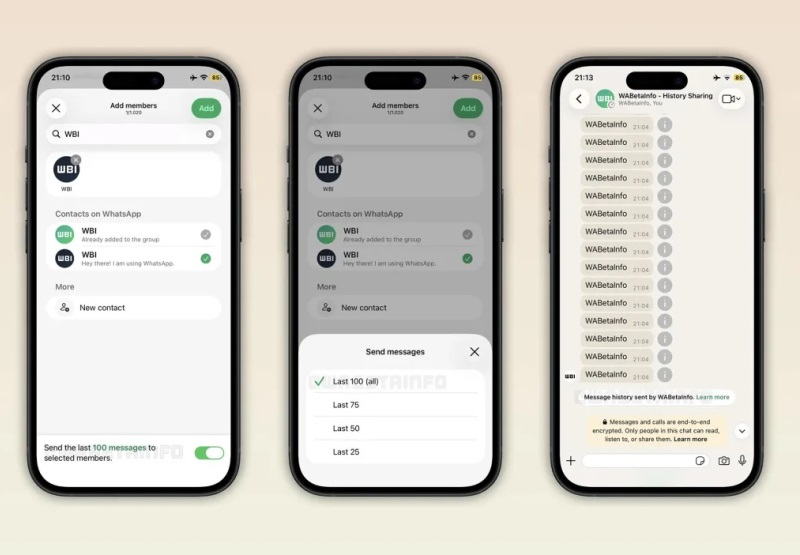

Разработчики мессенджера WhatsApp продолжают развивать платформу за счёт добавления востребованных функций. На этот раз они реализовали поддержку функции, которая позволит делиться историей сообщений в групповых чатах с новыми участниками. На данном этапе это нововведение доступно ограниченному числу пользователей бета-версий WhatsApp.

Источник изображения: WABetaInfo В сообщении сказано, что участники группы могут сами решать делиться ли историей сообщений с вновь добавленными пользователями. Новые участники смогут увидеть до 100 старых сообщений, отправленных в группу за последние 14 дней. Отмечается, что «сообщения, которыми поделились с помощью этой функции, выделяются другим цветом, что позволяет новым участникам распознавать их в переписке». Функция доступа к старым сообщениям для новых участников групп является востребованной. Она уже присутствует во многих мессенджерах, например, в Telegram. Благодаря этой функции новые участники группы могут быстро вникнуть в суть последних обсуждений и получить нужную информацию, в зависимости от контекста группового чата. Когда именно новая функция появится в стабильных версиях WhatsApp и станет общедоступной, не уточняется. Вероятно, это произойдёт после завершения этапа тестирования с привлечением ограниченного числа пользователей бета-версий мессенджера. В Google DeepMind удивились спешке OpenAI с внедрением рекламы в ChatGPT

23.01.2026 [12:15],

Владимир Мироненко

Гендиректор Google DeepMind Демис Хассабис (Demis Hassabis) выразил удивление поспешностью OpenAI после появления сообщений о том, что она уже перешла к внедрению рекламы в свой ИИ-чат-бот для получения дополнительного дохода от пользователей ChatGPT, у которых нет платной подписки. По его мнению, это решение может изменить восприятие сервиса пользователями.

Источник изображения: Growtika/unsplash.com «Я немного удивлён, что они так рано перешли к этому», — сказал Хассабис в интервью Axios в Давосе, вместе с тем отметив, что в рекламе нет ничего плохого, и она может быть полезной для финансирования, если «сделана хорошо». В ответ на вопрос репортёра об использовании рекламы для монетизации услуг ИИ, он заявил, что команда Google очень тщательно обдумывала эту идею. Хассабис также сказал, что его команда не чувствует давления со стороны руководства технологического гиганта, чтобы принять «поспешное» решение относительно рекламы, несмотря на важность рекламы в структуре доходов основного бизнеса Google. Хотя OpenAI, по всей видимости, вынуждена рассмотреть возможность размещения рекламы с учётом растущих затрат, это решение может изменить восприятие сервиса пользователями. В настоящее время число еженедельно активных пользователей ИИ-чат-бота составляет около 800 млн. «При использовании голосовых помощников, если вы рассматриваете чат-ботов как помощников, которые должны быть полезными, а также технологий, которые работают на вас как на отдельного человека, возникает вопрос о том, как реклама вписывается в эту модель? Вы хотите доверять своему помощнику. Так как же это работает?» — задался Хассабис вопросом. Он заметил, что что у Google нет «никаких текущих планов» по размещению рекламы в своем чат-боте с искусственным интеллектом. Вместо этого компания планирует отслеживать ситуацию, чтобы видеть реакцию пользователей. Сама идея проникновения рекламы в разговоры людей с ИИ-помощниками вызывает у них негативную реакцию. Например, когда OpenAI в прошлом месяце начала изучать функцию, предлагающую приложения для тестирования во время чатов пользователей, они отреагировали негативно, поскольку эти предложения кажутся навязчивой рекламой. После этого OpenAI отключила функцию, заявив, что предложения на самом деле не являются рекламой, поскольку «не имеют финансовой составляющей». Но речь не о платежах за рекламу. Скорее, дело в том, как предложения приложений ухудшали качество взаимодействия пользователей с чат-ботом. По словам Хассабиса, использование чат-бота — это совсем другой опыт, чем использование поиска Google. Чат-боты призваны стать полезными цифровыми помощниками, которые знают о вас и могут помочь во многих аспектах жизни, сказал он. Навязывание рекламы пользователю во время общения с ИИ-помощником может вызывать отторжение. Именно поэтому клиенты негативно отнеслись к попыткам Amazon внедрить рекламу в Alexa — им нужен помощник, а не персональный покупатель, предлагающий товары. ИИ научили писать тексты по-человечески с помощью инструкции с «Википедии»

22.01.2026 [22:29],

Анжелла Марина

Разработчик Сици Чэнь (Siqi Chen), основываясь на руководстве «Википедии» по выявлению низкокачественных ИИ-текстов, представил инструмент Humanizer, который помогает чат-ботам снижать характерные признаки машинного написания, сообщило издание Ars Technica.

Источник изображения: Bryn Young/Unsplash Плагин представляет собой пользовательский навык (custom skill) для среды разработки Claude Code от компании Anthropic и использует список, составленный волонтёрами онлайн-энциклопедии для борьбы с некачественным контентом. Согласно информации на странице проекта в GitHub, Humanizer помогает ИИ-ассистенту избежать обнаружения, путём удаления характерных маркеров, типичных для сгенерированного машинного текста. В этот список входят завуалированные ссылки на источники, рекламный стиль изложения, например, использование возвышенных эпитетов, и характерные для ботов фразы вежливости, такие как «Надеюсь, это поможет!». Устранение всех этих деталей позволит сделать текст нейросети более естественным. На странице репозитория приведены конкретные примеры работы инструмента. Humanizer способен заменить фразу с эмоциональной окраской «расположенный в захватывающем дух регионе» на фактологическую «город в регионе». Также плагин корректирует неопределённые атрибуции: вместо конструкции «Эксперты считают, что это играет важную роль» система подставляет конкретный источник, например, «согласно опросу 2019 года, проведённому…». Чэнь отметил, что инструмент будет автоматически получать обновления по мере того, как «Википедия» будет дополнять своё руководство по обнаружению ИИ. The Verge в своём материале также отмечает, что адаптация алгоритмов под критерии «человечности» — это лишь вопрос времени для разработчиков ИИ. В качестве примера издание приводит компанию OpenAI, которая уже скорректировала работу ChatGPT, устранив чрезмерное использование длинных тире, ставших одним из явных индикаторов сгенерированного контента. Anthropic представила модифицированную версию «конституции» своего чат-бота Claude

22.01.2026 [06:51],

Алексей Разин

Компания Anthropic старается уделять особое внимание пояснительной работе по поводу своей миссии и фирменных разработок типа того же чат-бота Claude, поэтому на этой неделе она опубликовала новую версию так называемой «конституции», поясняющей принципы его работы и те цели, которые преследуются в его развитии.

Источник изображения: Anthropic Документ определяет те этические принципы, которых компания придерживается при развитии Claude. Они также используются для самоконтроля чат-бота, всего так называемая «программная конституция» содержит 80 страниц и состоит из четырёх разделов, определяющих «базовые ценности» чат-бота: безопасность, этичность, соответствие миссии Anthropic и ориентация на пользу обществу. Каждый из разделов содержит описание того, как подобные принципы влияют на поведение Claude. Разработчики Claude стараются не повторять ошибок конкурентов с точки зрения этики. Например, при подозрении на наличие у пользователя психических расстройств чат-бот сразу рекомендует обратиться к специалисту, если становится ясно, что ситуация может представлять угрозу жизни и здоровью человека. Этическим вопросам уделяется больше внимания в практическом разрезе, а не на уровне теоретических рассуждений. Определённые темы изначально запрещены для обсуждения — например, создание биологического оружия. Наконец, Anthropic стремится сделать Claude максимально дружелюбным и полезным для пользователей. Обеспечение долгосрочного благополучия человека при выдаче информации чат-ботом ставится выше сиюминутных интересов. Конституция Claude при этом содержит и раздел, посвящённый философским рассуждениям разработчиков. Они задают вопросы о наличии морального статуса и сознания у Claude, подчёркивая, что они не одиноки в таких рассуждениях, и конкуренты и коллеги тоже размышляют на подобные темы. ChatGPT вычислит подростков по поведению: OpenAI вводит систему предсказания возраста

21.01.2026 [04:50],

Алексей Разин

Стартап OpenAI на этой неделе заявил о внедрении для потребительских тарифных планов ChatGPT модели предсказания возраста пользователя. Эти шаги направлены на выявление пользователей, не достигших 18 лет, с целью защиты их от нежелательной информации. Частично возраст выявляется на основе графика использования ChatGPT конкретным человеком.

Источник изображения: OpenAI OpenAI была вынуждена пойти на эти меры, поскольку Федеральная комиссия по торговле США ведёт расследование в отношении разработчиков популярных чат-ботов, с целью выявления потенциально негативного влияния их на детей и подростков. Компания выступает ответчиком по нескольким делам о причинении смерти по неосторожности, включая один инцидент с предполагаемым доведением подростка до самоубийства. Как только модель предсказания возраста приходит к выводу, что имеет дело с несовершеннолетним пользователем, она автоматически вводит механизмы защиты, блокируя доступ к информации определённого характера, включая описание способов нанесения ущерба здоровью и жизни человека. Если совершеннолетний пользователь ChatGPT ошибочно столкнулся с такими ограничениями, то он сможет пройти повторную идентификацию на возраст через сервис Persona, после чего ограничения будут сняты. Этот сервис используется для верификации возраста пользователей и другими онлайн-платформами, включая Roblox. Осенью прошлого года OpenAI ввела в ChatGPT средства родительского контроля, которые позволяют людям понимать, какие запросы отправляют в чат-бот их дети и к какой информации имеют доступ. В октябре также была созвана экспертная группа из восьми специалистов, которые должны оценивать, настолько взаимодействие с ИИ способно повлиять на ментальное здоровье человека, его эмоции и мотивацию. На этой неделе OpenAI подчеркнула, что будет повышать точность предсказания возраста с течением времени. В Евросоюзе этот механизм начнёт распространяться в ближайшие недели, чтобы обеспечить соответствие местным законодательным нормам. Совершеннолетние пользователи бесплатной версии ChatGPT в США первыми увидят рекламу

17.01.2026 [07:15],

Алексей Разин

Сама по себе готовность OpenAI начать демонстрацию рекламы пользователям чат-бота ChatGPT не является новостью, но вчера стартап дал первые официальные комментарии на эту тему, как отмечает CNBC. Тестирование рекламы начнётся в ближайшие недели в США, первыми её увидят пользователи бесплатной версии ChatGPT, достигшие совершеннолетия.  Подписчики планов Plus, Pro и Enterprise не будут сталкиваться с демонстрацией рекламы, как отметили представители OpenAI. Бюджетная подписка Go с пятницы стала доступна для американских пользователей ChatGPT, они также будут иметь дело с рекламой. Для стартапа, который пока работает себе в убыток, переход к демонстрации рекламы является важным шагом по пути монетизации своих услуг. «Для нас очевидно, что многие люди хотят много пользоваться ИИ и не хотят за это платить, поэтому мы надеемся, что подобная бизнес-модель будет работать», — заявил генеральный директор OpenAI Сэм Альтман со страниц социальной сети X. Рекламные объявления будут демонстрироваться в ChatGPT в нижней части ответов чат-бота, они будут явным образом промаркированы. При этом само содержание ответов не будет определяться интересами рекламодателей. Стартап также обещает, что никогда не будет продавать личные данные пользователей своим рекламодателям. Лицам до 18 лет рекламные объявления демонстрироваться не будут, реклама также не будет появляться при обсуждении ряда тем, к числу которых относятся политика, здоровье и психология. Долгое время глава OpenAI сомневался в необходимости внедрения рекламы в сервисы стартапа, но в ноябре прошлого года признал, что рано или поздно это произойдёт, хотя он и не верит, что поступления от рекламы станут самым крупным источником выручки для компании. Доверие пользователей для OpenAI останется важнее рекламных доходов, как подчеркнул Альтман вчера, а способы демонстрации рекламы будут корректироваться со временем с учётом отзывов аудитории. Рекламные объявления пользователи смогут закрывать, а также осуществлять обратную связь на соответствующие темы. X заявила, что Grok больше не раздевает людей — но это не так

15.01.2026 [11:08],

Владимир Мироненко

После волны критики из-за создания в соцсети X с помощью чат-бота Grok AI дипфейков сексуального характера без согласия пользователей, платформа сообщила о внесении изменений в возможности аккаунта Grok AI редактировать изображения реальных людей. Однако, как утверждает ресурс The Verge, в приложении Grok можно по-прежнему создавать откровенные изображения человека в бикини, используя бесплатный аккаунт.

Источник изображения: Mariia Shalabaieva/unsplash.com «Мы внедрили технологические меры, чтобы предотвратить редактирование изображений реальных людей в откровенной одежде, такой как бикини, через аккаунт Grok. Это ограничение распространяется на всех пользователей, включая платных подписчиков», — сообщается в обновлении аккаунта X. В нём также отмечено, что создание изображений и возможность редактирования изображений через аккаунт Grok на платформе X теперь доступны только платным подписчикам. «Это добавляет дополнительный уровень защиты, помогая гарантировать, что лица, пытающиеся злоупотреблять аккаунтом Grok для нарушения закона или нашей политики, могут быть привлечены к ответственности», — сообщила администрация соцсети. Кроме того, было объявлено, что платформа блокирует возможность для всех пользователей создавать изображения реальных людей в бикини, нижнем белье и подобной одежде через аккаунт Grok и в Grok in X в тех юрисдикциях, где это незаконно. Ранее стало известно, что британское Управление связи (Ofcom) начало расследование по этому поводу. Также сообщается, что на этой неделе в Великобритании вступит в силу закон, согласно которому создание интимных дипфейк-изображений без согласия пользователей будет считаться уголовным преступлением. Google представила универсальный протокол UCP для организации покупок через чат-боты

12.01.2026 [08:53],

Алексей Разин

На этой неделе корпорация Google представила новый открытый стандарт, получивший название Universal Commerce Protocol (UCP) и предназначенный для интеграции функций интернет-покупок в диалоговые окна популярных чат-ботов. В разработке протокола принимали участие представители торговой отрасли, поэтому он должен оптимальным образом учитывать их интересы.  Помимо процесса поиска необходимых товаров и их покупки, новый протокол позволяет реализовать функции, связанные с послепродажным обслуживанием. Это упростит взаимодействие покупателя и продавца в условиях активного распространения чат-ботов. Google одновременно обеспечивает поддержку и других протоколов типа AP2, A2A и MCP, которые могут применяться в этой и смежных сферах. Совсем скоро пользователи Google смогут при изучении товаров в режиме ИИ осуществлять их приобретение в магазинах популярных американских сетей, не покидая браузера или диалогового окна Gemini. Интеграция с Google Pay и Google Wallet тоже предусмотрена, что дополнительно ускорит процесс покупки. Вскоре будет добавлена и возможность оплаты через PayPal. Подобную интеграцию пытаются предусмотреть и конкуренты Google. Например, Shopify в этой сфере скооперировалась с Microsoft и её ИИ-платформой Copilot. Как уже отмечалось ранее, Google усилит персонализацию рекламных предложений для пользователей ИИ-режимов браузера и Gemini. Продавцам Google предоставит возможность активнее продвигать свои товары в поисковой выдаче, а также интегрировать собственные чат-боты для обсуждения свойств и характеристик товара. Подобными функциями уже пользуются несколько клиентов Google из числа поставщиков различных товаров. Попутно Google предложила инструмент Gemini Enterprise for Customer Experience, который предназначается корпоративным клиентам, взаимодействующим с клиентами в сфере торговли и общепита. Компания Adobe уже отметила, что благодаря инструментам для генеративного ИИ удалось увеличить трафик на сайтах продавцов в предпраздничные дни почти на 700 %, хотя какая часть этих посещений трансформировалась в реальные покупки, не уточняется. |