|

Групповое тестирование 46 видеокарт в Battlefield 2042

Можно спорить о качестве Battlefield 2042 как игры, но с технической точки зрения она определенно заслуживает внимания. К тому же это еще один пример того, что трассировка лучей в современных играх может приносить очевидную пользу графике, не вызывая привычных тормозов

Уже не секрет, что создатели Battlefield 2042 явно поторопились с релизом — и в результате игра может предложить не так уж много нового ветеранам серии. К тому же в ней отсутствуют многие элементы, привычные по предыдущим релизам, в том числе однопользовательская кампания. О том, что не так с новой Battlefield и в чем франшиза по-прежнему сильна, вы можете узнать из нашего обзора. Ну а в рамках этого материала нас интересует исключительно техническая составляющая — и все недоработки с точки зрения геймдизайна не помешают нам по достоинству ее оценить. А главное, использовать ее в качестве единого бенчмарка для массы видеокарт, начиная с Radeon 500-й серии и GeForce 10 и заканчивая устройствами последнего поколения.

⇡#Настройки качества графики

Battlefield 2042 работает на известном графическом движке Frostbite, однако в последние годы мы сталкиваемся с ним не так уж часто. Причина в том, что Frostbite применяется исключительно в тех проектах, которые выходят под крылом Electronic Arts. Причем Battlefield 2042 стал дебютной игрой для масштабного обновления платформы, о котором разработчики, к сожалению, не сообщают никаких подробностей, в то время как период с 2013 года Frostbite провел на версии 3.0, получая лишь дополнительные функции вроде поддержки API Direct3D 12, а затем аппаратного рейтрейсинга.

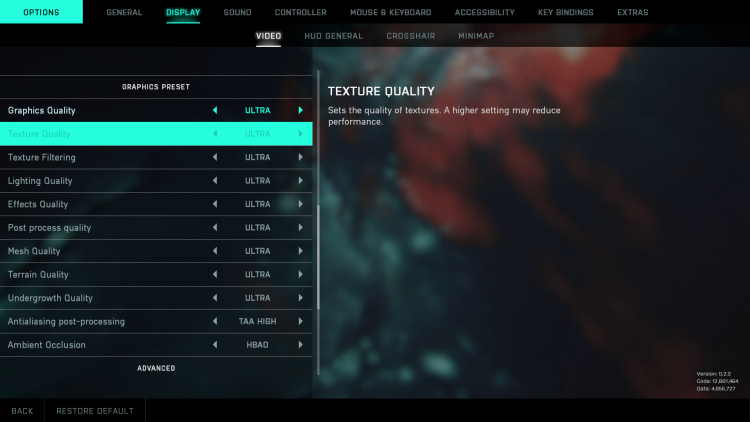

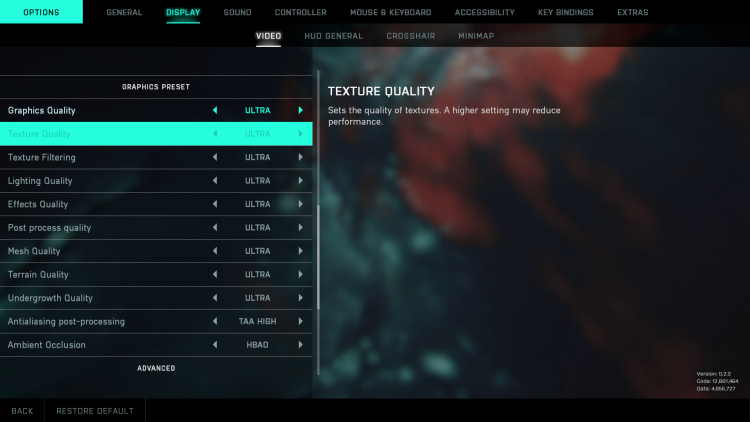

В Battlefield 2042 реализована привычная схема управления настройками графики, когда основная масса параметров подчиняется общему переключателю детализации. Все регулируется четырьмя позициями в диапазоне от Low до Ultra, хотя у пользователя есть дополнительный выбор между двумя алгоритмами Ambient Occlusion: примитивным SSAO родом еще из первого Crysis и более продвинутым HBAO. Для полноэкранного сглаживания используется вездесущий метод TAA — никаких более требовательных, но вместе с тем и более качественных опций Battlefield 2042 не предлагает.

Для тестов производительности видеокарт мы выбрали три режима настроек: самое низкое качество (профиль Low), среднее (Medium) и наивысшее (Ultra). Они обеспечивают большой разброс как в детализации изображения, так и в требованиях к ресурсам GPU.

⇡#Трассировка лучей

Эксклюзивной опцией Battlefield 2042 на персональных компьютерах стала поддержка трассировки лучей. Однако в отличие от предыдущей части франшизы, новая серия использует рейтрейсинг совершенно по-другому. Если в Battlefield V на основе лучей создавались отражения, то в Battlefield 2042 таким образом рассчитываются эффекты Ambient Occlusion, то есть тени в тех участках кадра, где геометрия блокирует распространение фонового освещения. Фактически Ambient Occlusion является грубой аппроксимацией полноценного глобального освещения, которое лишь в избранных проектах реализуется путем трассировки лучей — естественно, из-за ресурсоемкости такого подхода. RTAO не так сильно бьет по быстродействию, как трассированные отражения в Battlefield V, хотя довольно сильно меняет графику.

Правда, наиболее выраженные изменения происходят в сценах на открытом пространстве, где как раз таки доминирует фоновое освещение, а вот внутри зданий эффект от активации RTAO довольно слабый.

⇡#Качество DLSS

Как и в любых играх, которые поддерживают DLSS 2.0 и более современных версий, масштабирование кадров Battlefield 2042 позволяет резко увеличить быстродействие видеокарт NVIDIA, сохраняя в целом высокое качество изображения.

Лучше всего нейросеть обрабатывает несложные паттерны — камень, часто встречающиеся на картах игры металлические конструкции и текстуры военной техники. DLSS со щадящими пропорциями масштабирования даже идет на пользу четкости и полностью устраняет ступеньки на границах полигонов, пропущенные фильтром полноэкранного сглаживания, а на самых простых объектах трудно отличить нативное разрешение 4К от DLSS Ultra Performance, когда за основу берется кадр размером 1280 × 720 пикселей.

Тем не менее масштабирование сопряжено с определенными компромиссами. Во-первых, даже на уровне Quality (исходный кадр растягивается в полтора раза по каждой стороне) DLSS усиливает локальный контраст, но в то же время уравнивает яркость в пределах крупных участков изображения, делая некоторые сцены блеклыми, — все это хорошо знакомо пользователям фоторедакторов: так работают фильтры Unsharp Mask в Photoshop и подобных инструментов. Во-вторых, нейросети по-прежнему с трудом даются хаотичные детали листвы деревьев или, того хуже, речного берега: в режиме Ultra Performance под водой хорошо видны крупные пикселы, которых нет нигде больше в пределах кадра.

⇡#Тестовый стенд, методика тестирования

| Тестовый стенд |

|---|

| CPU |

AMD Ryzen 9 5950X (4,4 ГГц, фиксированная тактовая частота всех ядер) |

| Материнская плата |

ASUS ROG Strix X570-E Gaming (Resizable BAR вкл.) |

| Оперативная память |

G.Skill Trident Z RGB F4-3200C14D-16GTZR, 4 × 8 Гбайт (3600 МТ/с, CL17) |

| ПЗУ |

Intel SSD 760p, 2048 Гбайт |

| Блок питания |

Corsair AX1200i, 1200 Вт |

| Система охлаждения CPU |

Corsair iCUE H115i RGB PRO XT |

| Корпус |

Открытый стенд |

| Операционная система |

Windows 10 Pro x64 |

| ПО для GPU AMD |

| Все видеокарты |

AMD Radeon Software Adrenalin 2020 Edition 21.11.3 |

| ПО для GPU NVIDIA |

| Все видеокарты |

NVIDIA GeForce Game Ready Driver 496.76 |

Измерение производительности выполнено с помощью утилиты OCAT на карте 1942 Classic Conquest — без участия других игроков, поскольку в противном случае было бы невозможно обеспечить постоянные условия тестирования. Показатели средней и минимальной кадровых частот выводятся из массива времени рендеринга индивидуальных кадров, который OCAT записывает в файл результатов.

Средняя частота смены кадров на диаграммах является величиной, обратной среднему времени рендеринга кадра. Для оценки минимальной кадровой частоты вычисляется количество кадров, сформированных в каждую секунду теста. Из этого массива чисел берется значение, соответствующее 1-му процентилю распределения.

⇡#Участники тестирования

- AMD Radeon RX 6900 XT (1825/2250 МГц, 16 Гбит/с, 16 Гбайт);

- AMD Radeon RX 6800 XT (1825/2250 МГц, 16 Гбит/с, 16 Гбайт);

- AMD Radeon RX 6800 (1700/2105 МГц, 16 Гбит/с, 16 Гбайт);

- AMD Radeon RX 6700 XT (2321/2581 МГц, 16 Гбит/с, 12 Гбайт);

- AMD Radeon RX 6600 XT (2064/2607 МГц, 16 Гбит/с, 8 Гбайт);

- AMD Radeon RX 6600 (1626/2491 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 5700 XT (1605/1905 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 5700 (1465/1725 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 5600 XT OC (1420/1750 МГц, 14 Гбит/с, 6 Гбайт);

- AMD Radeon RX 5600 XT (1235/1620 МГц, 12 Гбит/с, 6 Гбайт);

- AMD Radeon RX 5500 XT (1607/1845 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 5500 XT (1607/1845 МГц, 14 Гбит/с, 4 Гбайт);

- AMD Radeon VII (1400/1750 МГц, 2 Гбит/с, 16 Гбайт);

- AMD Radeon RX Vega 64 LC (1406/1677 МГц, 1,89 Гбит/с, 8 Гбайт);

- AMD Radeon RX Vega 64 (1247/1546 МГц, 1,89 Гбит/с, 8 Гбайт);

- AMD Radeon RX Vega 56 (1156/1471 МГц, 16 Гбит/с, 8 Гбайт);

- AMD Radeon RX 590 (1469/1545 МГц, 8 Гбит/с, 8 Гбайт);

- AMD Radeon RX 580 (1257/1340 МГц, 8 Гбит/с, 8 Гбайт);

- AMD Radeon RX 570 (1168/1244 МГц, 7 Гбит/с, 4 Гбайт);

- AMD Radeon RX 560 16 CU (1175/1275 МГц, 7 Гбит/с, 4 Гбайт);

- AMD Radeon RX 560 14 CU (1090/1175 МГц, 7 Гбит/с, 4 Гбайт);

- NVIDIA GeForce RTX 3090 (1395/1695 МГц, 19,5 Гбит/с, 24 Гбайт);

- NVIDIA GeForce RTX 3080 Ti (1365/1665 МГц, 19 Гбит/с, 12 Гбайт);

- NVIDIA GeForce RTX 3080 (1440/1710 МГц, 19 Гбит/с, 10 Гбайт);

- NVIDIA GeForce RTX 3070 Ti (1575/1770 МГц, 19 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 3070 (1500/1730 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 3060 Ti (1410/1665 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 3060 (1320/1837 МГц, 15 Гбит/с, 12 Гбайт);

- NVIDIA GeForce RTX 2080 Ti Founders Edition (1350/1635 МГц, 14 Гбит/с, 11 Гбайт);

- NVIDIA GeForce RTX 2080 SUPER (1650/1815 МГц, 15,5 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2080 Founders Edition (1515/1800 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2070 SUPER (1605/1770 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2070 Founders Edition (1410/1710 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2060 SUPER (1470/1650 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2060 (1365/1680 МГц, 14 Гбит/с, 6 Гбайт);

- NVIDIA GeForce GTX 1660 Ti (1500/1800 МГц, 12 Гбит/с, 6 Гбайт);

- NVIDIA GeForce GTX 1660 SUPER (1530/1830 МГц, 14 Гбит/с, 6 Гбайт);

- NVIDIA GeForce GTX 1660 (1530/1785 МГц, 8 Гбит/с, 6 Гбайт);

- NVIDIA GeForce GTX 1650 SUPER (1530/1770 МГц, 8 Гбит/с, 4 Гбайт);

- NVIDIA GeForce GTX 1650 (1485/1725 МГц, 8 Гбит/с, 4 Гбайт);

- NVIDIA GeForce GTX 1080 Ti (1480/1582 МГц, 11 Гбит/с, 11 Гбайт);

- NVIDIA GeForce GTX 1080 (1607/1733 МГц, 10 Гбит/с, 8 Гбайт);

- NVIDIA GeForce GTX 1070 Ti (1607/1683 МГц, 8 Гбит/с, 8 Гбайт);

- NVIDIA GeForce GTX 1060 (1506/1708 МГц, 9 Гбит/с, 6 Гбайт);

- NVIDIA GeForce GTX 1060 (1506/1708 МГц, 8 Гбит/с, 3 Гбайт);

- NVIDIA GeForce GTX 1050 Ti (1290/1392 МГц, 7 Гбит/с, 4 Гбайт).

Прим. В скобках после названий видеокарт указаны базовая и boost-частота согласно спецификациям каждого устройства. Видеокарты с заводским разгоном приведены в соответствие с референсными параметрами (или приближены к последним) при условии, что это можно сделать без ручной правки кривой тактовых частот. В противном случае используются настройки производителя.

Следующая страница →

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

|

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018