|

Опрос

|

реклама

Быстрый переход

Google представила Nano Banana 2 — обновлённый генератор изображений работает быстрее и качественнее, и доступен бесплатно

26.02.2026 [20:49],

Николай Хижняк

Компания Google анонсировала последнюю версию своей популярной ИИ-модели для генерации изображений — Nano Banana 2. Новая модель, которая технически является аналогом Gemini 3.1 Flash Image, способна создавать более реалистичные изображения по сравнению с предшественницей. Nano Banana 2 станет моделью по умолчанию в приложении Gemini для режимов Fast, Thinking и Pro, то есть новинка будет доступна и бесплатным пользователям.

Источник изображений: Google Компания впервые выпустила Nano Banana в августе 2025 года. Она быстро завоевала популярность среди пользователей Gemini, особенно в таких странах, как Индия. В ноябре Google представила Nano Banana Pro, позволяющую создавать более детализированные и высококачественные изображения. Новая Nano Banana 2 сохраняет ряд характеристик высокой детализации версии Pro, но генерирует изображения быстрее. С её помощью можно создавать изображения с разрешением от 512 пикселей до 4K и с различными соотношениями сторон.  Nano Banana 2 поддерживает единообразие персонажей (до пяти) и точную проработку до 14 объектов в одном рабочем процессе, что улучшает возможности повествования. По словам Google, пользователи могут отправлять сложные запросы с подробными нюансами для генерации изображений. Кроме того, модель позволяет создавать медиаконтент с более ярким освещением, насыщенными текстурами и чёткими деталями.  С запуском Nano Banana 2 станет моделью по умолчанию для генерации изображений во всех приложениях Gemini. Компания также сделает её моделью по умолчанию для генерации изображений в своём инструменте для редактирования видео Flow. В 141 стране Nano Banana 2 станет моделью по умолчанию в Google Lens и в режиме поиска с ИИ в мобильной и веб-версии Google Search. Пользователи тарифных планов Google AI Pro и Ultra смогут продолжать использовать Nano Banana Pro для специализированных задач, выбрав соответствующую настройку через меню с тремя точками. Для разработчиков Nano Banana 2 будет доступна в режиме предварительного просмотра через API Gemini, Gemini CLI и Vertex API. Она также появится в AI Studio и инструменте разработки Antigravity, выпущенном в ноябре прошлого года.  Google заявляет, что все изображения, созданные с помощью новой модели, будут иметь водяной знак SynthID — фирменный маркер для обозначения изображений, сгенерированных искусственным интеллектом. Изображения также совместимы с системой C2PA Content Credentials, которая подтверждает происхождение контента и фиксирует, подвергался ли он изменениям. Систему поддерживают Adobe, Microsoft, Google, OpenAI и Meta✴✴. Google сообщила, что с момента запуска проверки SynthID в приложении Gemini в ноябре ей воспользовались более 20 млн раз. ByteDance пообещала отучить ИИ-генератор Seedance 2.0 копировать голливудских актеров и персонажей

16.02.2026 [14:37],

Алексей Разин

Создание видеороликов с помощью ИИ-сервисов сталкивается с рядом юридических претензий, поскольку киностудии, правообладатели и знаменитости не желают допускать копирования их интеллектуальной собственности и образов без разрешения. Китайская ByteDance после запуска профильного сервиса Seedance 2.0 вынуждена была пообещать правообладателям ввести защитные механизмы, которые учитывали бы их интересы.  Как и многие подобные сервисы, Seedance 2.0 позволяет создавать реалистичные видео на основе текстовых запросов. Социальные сети после запуска Seedance 2.0 сразу же наводнились видеороликами с персонажами, охраняемыми авторским правом, а также образами, напоминающими реальных знаменитостей. Поскольку многие из них имели американское происхождение, то к создателям подобных роликов у правообладателей возникли справедливые претензии. «Мы принимаем меры по усилению существующих защитных механизмов, чтобы предотвратить неправомерное использование интеллектуальной собственности и схожести (со знаменитостями) со стороны пользователей», — заявили представители ByteDance ресурсу CNBC. Свои претензии к создателям сервиса Seedance 2.0 довольно быстро направила отраслевая ассоциация MPA, которая в США представляет интересы большинства крупных киностудий и платформы Netflix. Она призвала ByteDance решительно пресечь неправомерную активность по использованию защищаемых интеллектуальными правами образов. По словам представителей ассоциации, подобная активность не только нарушает американские законы, но и угрожает миллионам рабочих мест в США. Студия Disney направила в адрес ByteDance письмо с требованиями прекратить неправомерное использование принадлежащих ей персонажей. По мнению представителей Disney, китайская ByteDance для обучения ИИ-модели якобы использовала полученную пиратским образом библиотеку образов, считая её публично доступной. Ранее Disney подписала соглашение с OpenAI, которое позволяет пользователям ИИ-сервисов последней внедрять в генерируемые видео ряд узнаваемых персонажей, принадлежащих студии. Требования прекратить нарушение прав в сфере интеллектуальной собственности в адрес ByteDance на прошлой неделе направила и Paramount Skydance. Disney+ скоро начнёт заполняться ИИ-контентом от OpenAI Sora, но на другие проекты это не повлияет

04.02.2026 [00:19],

Владимир Фетисов

Генеральный директор Disney Боб Айгер (Bob Iger) заявил, что сгенерированные с помощью сервиса OpenAI Sora видео скоро начнут появляться на платформе Disney+. При этом он отметил, что это не должно повлиять на остальной производимый компанией контент, включая фильмы и телепроекты.

Источник изображения: OpenAI Во время подведения финансовых итогов за прошедший квартал Айгер сообщил, что анонсированное в декабре соглашение с OpenAI сроком на три года начнёт приносить плоды в ближайшие несколько месяцев. В рамках достигнутых договорённостей Disney инвестирует в разработчика ИИ-алгоритмов $1 млрд, а OpenAI, в свою очередь, за неназванную сумму купит лицензию, которая позволит задействовать 250 персонажей Disney для генерации видео на платформе Sora. Генерируемые пользователями Sora вертикальные видео появятся в Disney+ позднее в этом году. На начальном этапе продолжительность таких роликов будет ограничена 30 секундами. По мнению Айгера, это позволит Disney извлечь выгоду на фоне высокой популярности коротких видео на других платформах, таких как YouTube. «Это соглашение даёт нам стартовый толчок для размещения коротких видео на Disney+. Кроме того, мы надеемся, что с помощью инструментов Sora подписчики Disney+ смогут создавать короткие видео на нашей платформе. Я считаю, что всё это — позитивный шаг в сторону интеграции функции, которая, как мы верим, значительно повысит вовлеченность аудитории», — заявил Айгер. Доводя до инвесторов отношение компании к искусственному интеллекту в целом, Айгер сказал, что Disney видит в этой технологии потенциальные преимущества и перспективы. Одно из таких преимуществ, по его мнению, заключается в возможности использования ИИ-инструментов для помощи творческому процессу и креативности. Ещё одним преимуществом должны стать высокая производительность и повышение эффективности разных рабочих процессов. Он также отметил, что ИИ позволит компании более тесно взаимодействовать с потребителями, что позитивно отразится на их вовлеченности. xAI выпустила Grok Imagine 1.0 с поддержкой создания 10-секундных видео в улучшенном разрешении

03.02.2026 [06:11],

Анжелла Марина

Компания xAI представила масштабное обновление инструмента генерации видео Grok Imagine 1.0. В новой версии теперь можно создавать ролики длиной до 10 секунд в разрешении 720 пикселей и синхронизировать звук. ИИ стал лучше понимать текстовые запросы и научился работать с уточняющими инструкциями.

Источник изображения: Grok Как сообщает издание Mint, разработчики назвали этот релиз крупнейшим обновлением системы, а Илон Маск (Elon Musk) в своём сообщении подтвердил, что версия 1.0 уже доступна. Представители xAI отметили, что обновление привнесёт повышение чёткости изображения и плавности визуального ряда для эффективного использования в творческих проектах и соцсетях. Ключевым нововведением стала работа со звуком. Пользователи смогут добавлять персонажам выразительные голоса с эмоциональной окраской, а также накладывать фоновую музыку, которая автоматически синхронизируется с происходящим на экране. В компании считают, что сочетание голоса и музыки делает сгенерированный контент более реалистичным и кинематографичным. Серьёзные изменения коснулись и логики взаимодействия с нейросетью. Grok Imagine 1.0 научился обрабатывать уточняющие запросы, что позволит корректировать детали сцены и дорабатывать результат без необходимости начинать генерацию с нуля, как это было раньше. За последние 30 дней платформа уже сгенерировала более одного миллиарда видео и популярность сервиса не уменьшается. Также сообщается, что API-модель показывает сильные результаты в бенчмарках Artificial Analysis, измерящих качество контента, созданного искусственным интеллектом Grok. Firefly без ограничений: Adobe сняла лимиты на ИИ-генерацию изображений и видео, но не навсегда

02.02.2026 [19:35],

Сергей Сурабекянц

Adobe предоставит подписчикам своего ИИ-сервиса Firefly неограниченное количество генераций изображений и видео как с использованием собственных, так и поддерживаемых сторонних моделей ИИ. Ежемесячные кредиты на генерацию изображений и видео будут отменены для новых подписчиков, которые зарегистрируются в системе до 16 марта.

Источник изображения: Adobe Firefly — это набор генеративных моделей Adobe для создания изображений и видео. В него входят как собственные модели Adobe, так и интеграции со сторонними сервисами, такими как Google Nano Banana Pro, OpenAI GPT-Image 1.5 и Runway Gen-4. После первоначального запуска Firefly в составе пакета приложений Creative Cloud, Adobe выпустила Firefly как отдельную платформу, доступную в браузере или через специальные приложения на мобильных платформах. Подписчики Adobe Firefly могут выбрать один из нескольких тарифных планов. До сих пор одним из ключевых отличий было количество кредитов на создание изображений, включённых в каждый тарифный план. Но с сегодняшнего дня Adobe предлагает при оформлении подписки генерацию неограниченного количества изображений и видео. Важно отметить, что предложение действительно только для отдельной подписки Adobe Firefly, а не для подписок Creative Cloud. «Зарегистрируйтесь до 16 марта и получите неограниченное количество поколений изображений и видео Firefly с разрешением до 2K в приложении Adobe Firefly. Предложение распространяется на клиентов, использующих тарифные планы Firefly Pro, Firefly Premium, а также планы на 4000, 7000 и 50 000 кредитов, и включает неограниченное количество генераций с использованием ведущих в отрасли моделей изображений, включая Google Nano Banana Pro, GPT Image Generation, Runway Gen-4 Image, а также коммерчески безопасные модели изображений и видео Firefly от Adobe», — заявила Adobe. По данным Adobe, 86 % создателей контента теперь используют ИИ в своей повседневной работе. Кроме того, за последний год длина их запросов удвоилась. Это свидетельствует о том, что создатели контента всё чаще используют ИИ как часть своих рабочих процессов. Компания отмечает, что сегодняшний шаг направлен на то, чтобы помочь создателям оставаться в творческом потоке, проходя через процесс проб и ошибок, не беспокоясь о своих кредитах на создание изображений. Adobe также сообщила, что в преддверии Дня святого Валентина и Лунного Нового года пользователи по всему миру получат возможность использовать собственные модели, а также интеграцию Firefly со сторонними сервисами, чтобы протестировать платформу. В «Google Фото» теперь можно описать превращение фото в видео

27.01.2026 [17:51],

Павел Котов

Пользователи сервиса «Google Фото» теперь могут управлять функцией превращения фото в видео при помощи генеративного искусственного интеллекта. Конкретное движение, стиль или эффект, которые хочется увидеть при преобразовании статичных изображений в видео, теперь можно описать простым текстовым запросом.

Источник изображения: Google Текстовые запросы дополняют уже имеющиеся функции «Небольшое движение» и «Мне повезёт» — свободного управления преобразованием в «Google Фото» до настоящего момента не было. Более того, сервис сам готов предложить некоторые варианты запросов, помогая со «вдохновением при создании видео»; для тонкой настройки получаемых роликов запросы можно редактировать. Функция доступна только пользователям от 18 лет. Это возрастное ограничение распространяется только на средство преобразования изображений в видео в «Google Фото»; аналогичная функция уже присутствует в Gemini и работает для пользователей от 13 лет. По умолчанию можно также добавлять аудио и получать на выходе ролик, готовый к публикации в интернете без дополнительного редактирования. Появилось также новое средство выбора изображений «Google Фото» для Gmail — обмен изображениями и роликами из общих и личных альбомов и коллекций стал проще. Можно одновременно выбирать несколько фотографий и видео, а также осуществлять поиск по конкретным фотографиям и названиям альбомов. «ИИ-тикток» от OpenAI стал вирусным после запуска, но интерес к нему быстро остыл — возможно, так и было задумано

18.01.2026 [13:12],

Владимир Мироненко

После запуска в конце сентября 2025 года ИИ-приложение для генерации видео Sora 2 от OpenAI для iOS стало хитом скачиваний, несмотря на то, что для регистрации в нём требовалось приглашение. Всего за четыре дня приложение вышло на первое место в общем рейтинге App Store для iOS, а днём позже преодолело отметку в 1 млн загрузок. Однако затем темпы роста скачиваний начали снижаться.

Источник изображения: sora.chatgpt.com Замысел, лежащий в основе Sora, был довольно разумным, пишет ресурс Sherwood.news: контент, созданный ИИ, призван заменить контент, создаваемый пользователями, который мы видим в своих лентах каждый день. Короткие вертикальные видеоролики в стиле TikTok казались естественным способом выхода OpenAI на рынок контента. Например, на YouTube прошлым летом четыре из десяти самых популярных каналов с наибольшим числом подписчиков состояли исключительно из видеороликов, созданных ИИ, большинство из которых были в формате Shorts. При этом Sora задумывалась не просто как конкурент TikTok — она была разработана для бесшовной интеграции со всеми другими подобными платформами. Видео, созданные с помощью Sora, можно превращать в ролики Reels, Shorts, TikTok, Snap и другие форматы. Каждый репост становился бесплатной рекламой для Sora, даже если просмотры и вовлечённость доставались конкурентам. Приложение Sora не публикует данные о вовлечённости, поэтому о популярности видео, созданных с его помощью, можно судить по кроссплатформенным репостам. Такие аккаунты, как @bestsoravids в Instagram✴✴ и Epic Rankz на YouTube, зафиксировали миллионы просмотров, лайков и комментариев на своих репостах Sora. Однако все их самые успешные публикации пришлись на неделю-две после выхода приложения, на пике его популярности. Так, в первой половине декабря всего 20 видео с хэштегами #sora или #sora2 набрали более 1 млн просмотров на YouTube. Другие популярные аккаунты, занимавшиеся репостами Sora, такие как тот же @bestsoravids, полностью прекратили загрузку видео спустя несколько недель. Также сократилось и число загрузок самого приложения. После первоначального всплеска активности приложение для iOS было загружено за последующие примерно три месяца ещё более 5 млн раз, согласно данным Appfigures. Версия для iOS после выхода в последний день сентября была скачана к концу октября почти 2,7 млн раз. В ноябре общее количество загрузок за месяц составило 1,9 млн, а в декабре — 1,5 млн. Версия Sora для Android стала доступна 4 ноября. В ноябре её скачали 1,4 млн раз, а в декабре — 1,7 млн раз. После того как Sora стала доступна на Android, её ежедневные показатели загрузок в течение недели отставали от TikTok. В декабре приложение TikTok скачали более 18 млн раз по всему миру, а YouTube — 5 млн раз, несмотря на то что это приложение существует уже почти два десятилетия. Как допускает Sherwood.news, запуск Sora вовсе не был попыткой продвижения в социальных сетях, а скорее хитрым рекламным ходом OpenAI, чтобы привлечь партнёров для чего-то большего, чем просто «следующий TikTok». Напомним, что в декабре OpenAI и Disney объявили о партнёрстве, которое обеспечит пользователям Sora эксклюзивный доступ к персонажам Disney. X заявила, что Grok больше не раздевает людей — но это не так

15.01.2026 [11:08],

Владимир Мироненко

После волны критики из-за создания в соцсети X с помощью чат-бота Grok AI дипфейков сексуального характера без согласия пользователей, платформа сообщила о внесении изменений в возможности аккаунта Grok AI редактировать изображения реальных людей. Однако, как утверждает ресурс The Verge, в приложении Grok можно по-прежнему создавать откровенные изображения человека в бикини, используя бесплатный аккаунт.

Источник изображения: Mariia Shalabaieva/unsplash.com «Мы внедрили технологические меры, чтобы предотвратить редактирование изображений реальных людей в откровенной одежде, такой как бикини, через аккаунт Grok. Это ограничение распространяется на всех пользователей, включая платных подписчиков», — сообщается в обновлении аккаунта X. В нём также отмечено, что создание изображений и возможность редактирования изображений через аккаунт Grok на платформе X теперь доступны только платным подписчикам. «Это добавляет дополнительный уровень защиты, помогая гарантировать, что лица, пытающиеся злоупотреблять аккаунтом Grok для нарушения закона или нашей политики, могут быть привлечены к ответственности», — сообщила администрация соцсети. Кроме того, было объявлено, что платформа блокирует возможность для всех пользователей создавать изображения реальных людей в бикини, нижнем белье и подобной одежде через аккаунт Grok и в Grok in X в тех юрисдикциях, где это незаконно. Ранее стало известно, что британское Управление связи (Ofcom) начало расследование по этому поводу. Также сообщается, что на этой неделе в Великобритании вступит в силу закон, согласно которому создание интимных дипфейк-изображений без согласия пользователей будет считаться уголовным преступлением. YouTube заваливает новых пользователей сгенерированным ИИ низкокачественным контентом

28.12.2025 [16:48],

Владимир Фетисов

Занимающаяся видеомонтажом компания Kapwing изучила 15 000 наиболее популярных по всему миру YouTube-каналов, выбирая по 100 самых просматриваемых в каждой стране. В результате было установлено, что 278 из них публикуют исключительно «ИИ-мусор», т.е. низкокачественный контент, созданный с помощью генеративных нейросетей и предназначенный для накрутки просмотров.

Источник изображения: @SuperCatLeague/YouTube В ходе исследования также было установлено, что новым пользователям демонстрируется более 20 % таких видео от общего количества роликов. Суммарно каналы с «ИИ-мусором» накопили свыше 63 млрд просмотров и 221 млн подписчиков, что приносит им около $117 млн дохода ежегодно. Исследователи создали новый аккаунт на YouTube и подсчитали, что 104 из первых 500 рекомендованных видео в ленте были «ИИ-мусором». При этом примерно треть контента составили не только низкокачественные сгенерированные видео, но и другой бессмысленный контент, созданный для монетизации за счёт привлечения внимания пользователей. Это наглядно демонстрирует, насколько быстро крупные платформы оказались в значительной степени заполнены сгенерированным контентом, причём зачастую низкокачественным. Собственный анализ The Guardian показал, что около 10 % самых быстрорастущих каналов на YouTube заполнены «ИИ-мусором», набирающим миллионы просмотров, несмотря на усилия платформы по борьбе с «неаутентичным контентом». Отмечается, что обнаруженные в ходе исследования Kapwing каналы имеют большую аудиторию. К примеру, в Испании 20 млн человек (почти половина населения страны) следят за трендовыми ИИ-каналами, в Египте у ИИ-каналов 18 млн подписчиков, в США — 14,5 млн, а в Бразилии — 13,5 млн. Самый просматриваемый из попавших в исследование тематический YouTube-канал — это Bandar Apna Dost, который базируется в Индии и уже набрал 2,4 млрд просмотров. В нём публикуются видео о приключениях антропоморфной обезьяны и мускулистого человека, смоделированного по образу Халка, который сражается с демонами и путешествует на вертолете из помидоров. По оценке Kapwing, владелец этого канала может зарабатывать до $4,25 млн в год. Сложно оценить, насколько значимы подобные каналы в сравнении с огромным количеством уже существующего на YouTube контента. Платформа не раскрывает информацию о том, сколько просмотров генерируется ежегодно или какая их часть приходится на ИИ-контент. Однако это показывает, что за ИИ-роликами стоит растущая индустрия, представители которой пытаются найти новые способы монетизации контента на крупнейших платформах. «Существуют целые сообщества в Telegram, WhatsApp, Discord и на форумах, где люди обмениваются советами и идеями, продают курсы о том, как создавать «мусор», который будет достаточно вовлекающим, чтобы приносить деньги», — прокомментировал данный вопрос журналист Макс Рид (Max Read), ранее подробно писавший об «ИИ-мусоре». Он также отметил, что в основном созданием такого контента занимаются люди из англоязычных стран, где средняя зарплата ниже того, что они могут заработать на YouTube. По его данным, «ИИ-мусор» создают множество людей из Индии, Кении, Нигерии и др. «Генеративный искусственный интеллект — это инструмент, и, как любой инструмент, его можно использовать для создания как высококачественного, так и низкокачественного контента. Мы по-прежнему стремимся предоставлять нашим пользователям доступ к высококачественному контенту, независимо от того, как он был создан. Весь контент, загружаемый на YouTube, должен соответствовать нашим правилам, и, если мы обнаруживаем, что контент нарушает нашу политику, мы удаляем его», — прокомментировал данный вопрос представитель YouTube. В Китае создали «царь-трансформатор» для стабилизации «зеленой» энергетики

27.12.2025 [18:11],

Геннадий Детинич

Высоковольтные линии электропередачи постоянного тока становятся насущной необходимостью в условиях перекоса генерации и потребления, когда ЦОД удалены от электростанций. Свою долю проблем в эту сферу вносят источники возобновляемой генерации, создающие нестабильность и риск аварийных отключений сетей. В Китае нашли решение проблем в создании крупнейшего на планете «гибкого» трансформатора постоянного тока. Если коротко — железа в этой стране действительно много.

Источник изображения: Changzhou Xidian Transformer Как сообщают китайские источники, в прошлом году в стране едва не случился блэкаут национального масштаба, когда нестабильные ветра в Синьцзян-Уйгурском автономном районе привели к провалам в выработке ветровой энергии. В Китае давно возник дисбаланс производства возобновляемой энергии в западных районах и потребления в восточных, прибрежных. Для перекачки энергии создаются энергомосты, но на местах входа ситуация далека от идеальной — перепады в генерации в виде скачков напряжения и мощности, а также дрейф частоты рискуют вызвать срабатывание защиты и отключить подачу мощности потребителям. Длина линий электропередачи в данном случае превышает 2000 км. Для таких расстояний выгодно переходить на постоянный ток высокого напряжения. Это снижает потери примерно с 10 % до 2 %, а также не создаёт мощных электромагнитных полей, свойственных сетям переменного тока. Наконец, для передачи постоянного тока требуются провода меньшего сечения для той же мощности, чем в случае переменного тока, что делает конструкцию ЛЭП легче. Однако трансформаторы постоянного тока намного сложнее, капризнее и дороже в изготовлении просто за счёт законов физики, хотя им также легче «подружиться» с DC-инверторами солнечных и ветровых электростанций. До 20-х годов Китай закупал мощные трансформаторы постоянного тока за границей, в частности в Германии у компании Siemens. Теперь он собрал свой, рекордной мощности — 0,75 ГВА (гигавольт-ампер). Его изготовила местная компания Changzhou Xidian Transformer. Оборудование было разработано для обеспечения передачи электроэнергии из северо-западной провинции Ганьсу в восточную провинцию Чжэцзян в рамках национального проекта по передаче электроэнергии с запада на восток. Это первый в мире проект по гибкой передаче постоянного тока сверхвысокого напряжения. «Эта технология может эффективно устранить нестабильность производства энергии из возобновляемых источников в значительной степени на стороне отправителя», — говорится в сообщении компании, которая добавляет, что разработка значительно повысит безопасность, стабильность и эксплуатационную гибкость крупной энергосистемы. Покажите это знакомым электрикам. Блеск в их глазах укажет на невообразимый обычному человеку масштаб воплощённого замысла. Огромные расстояния и высочайшие мощности — они диктуют размах. Стабилизировать энергосеть можно более изящно — например, с помощью суперконденсаторов, как начали поступать в Германии. Но у немцев нет проблем с расстояниями, а у китайцев, и у России — есть. Поэтому высоковольтные энергомосты с постоянным током — это наше ближайшее будущее, включая изготовление таких вот царь-трансформаторов. Google превратила Gemini в фабрику мини-приложений — Opal стал доступен всем пользователям

17.12.2025 [12:41],

Владимир Фетисов

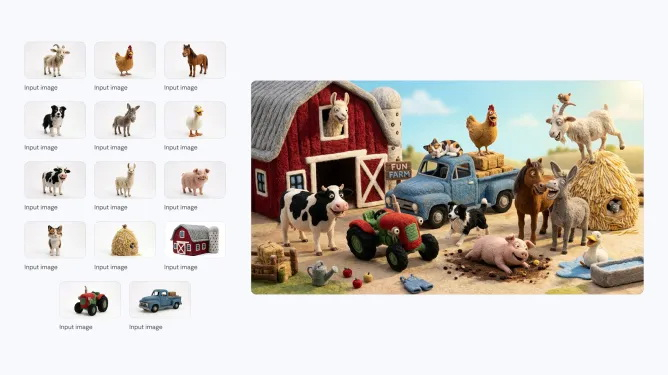

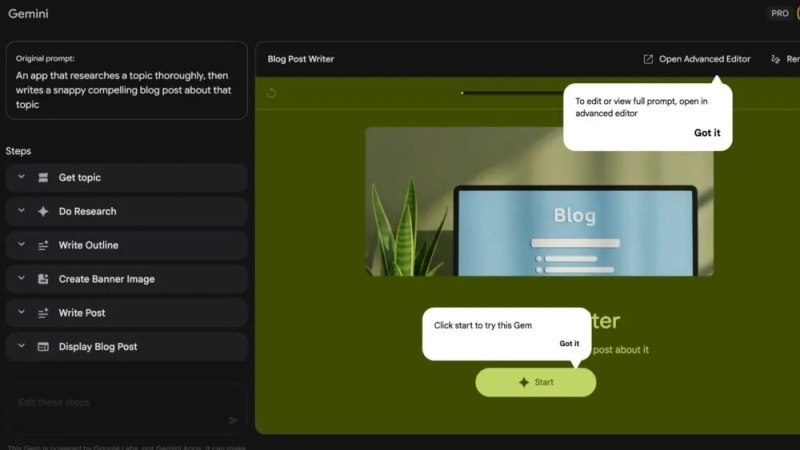

Google приступила к интеграции ИИ-генератора мини-приложений Opal в веб-версию Gemini. Это означает, что пользователи могут задействовать инструмент генерации программного кода для создания небольших приложений с нуля.

Источник изображения: androidauthority.com Google анонсировала Opal ранее в этом году, но тогда ИИ-генератор программного кода был доступен только в рамках Google Labs пользователям из США. С его помощью можно создавать мини-приложения с нуля и делиться ими, а также вносить различные изменения с помощью запросов на естественном языке. Помимо возможности создания мини-приложений на базе ИИ прямо в веб-версии Gemini, Google также улучшила визуальный редактор Opal. Теперь в процессе создания мини-приложений в новом режиме просмотра текстовые запросы будут преобразовываться в списки шагов, что упростит редактирование логики работы будущих приложений. В дополнение к этому в Opal можно просматривать список модулей, которые уже были сгенерированы с помощью сервиса. Пользователь имеет возможность изменять эти мини-приложения в соответствии с собственными потребностями. Если нужно создать какой-либо программный продукт с нуля, можно задействовать расширенный редактор. Отметим, что Opal не является частью сервиса Gemini. Это означает, что данные, полученные при взаимодействии с ИИ-генератором программного кода, не будут отображаться в истории активности Gemini. OpenAI выпустила генератор изображений ChatGPT Images 1.5 — более высокая скорость и новые возможности

17.12.2025 [07:37],

Владимир Фетисов

На прошлой неделе OpenAI выпустила модель искусственного интеллекта GPT-5.2, а теперь она стала основой фирменного генератора изображений ChatGPT Images 1.5. По словам разработчиков, это позволило в четыре раза повысить скорость работы сервиса по сравнению с предыдущей версией, а также реализовать несколько полезных нововведений.

Источник изображения: ChatGPT Images ChatGPT Images стал лучше следовать пользовательским инструкциям, в том числе в случаях, когда дело доходит до редактирования только что созданного изображения. Пользователь может попросить алгоритм добавить, убрать, объединить, смешать или даже перенести какие-то элементы на картинке. OpenAI заявила, что обновлённый ChatGPT Images лучше справляется с отображением текста, что традиционно является слабым местом многих генераторов изображений. По данным OpenAI, повысилось качество генерации читаемого текста, а также появилась возможность работы с более мелким и плотным тестом. В рамках этого обновления фирменного генератора изображения OpenAI добавила в боковую панель ChatGPT отдельный раздел Images. В нём собраны готовые к использованию фильтры и промпты, призванные помочь в поиске вдохновения. «Мы считаем, что всё ещё находимся в самом начале пути к тому, что может дать генерация изображений. Сегодняшнее обновление — это значительный шаг вперёд, и впереди нас ждёт многое: от более детальных правок до более насыщенных и подробных результатов на разных языках», — говорится в сообщении OpenAI. Разработчики приступили к развёртыванию ChatGPT Images 1.5 и в скором времени обновлённая версия сервиса станет доступна всем пользователям. Отмечается, что пользователи также смогут продолжить взаимодействие с моделью GPT-4o через пользовательский интерфейс чат-бота компании. Новый ChatGPT Images появляется как раз в тот момент, когда его главный конкурент Google Nano Banana Pro вызвал всплеск популярности Gemini среди пользователей. В октябре Google заявила, что пользовательская база фирменного чат-бота выросла до 650 млн человек, что существенно больше 450 млн человек, о которых компания сообщала в июле. Nano Banana Pro оказалась настолько популярной, что Google для снижения нагрузки на инфраструктуру пришлось ограничить бесплатных пользователей всего двумя генерациями изображений в день. Для OpenAI, вероятно, было не столь важно дать сильный ответ на появление Nano Banana Pro, сколько обеспечить сильную конкуренцию чат-боту Gemini 3 Pro. Это связано с тем, что наличие в арсенале компании ChatGPT Images является одним из основных факторов, обеспечивающих ИИ-боту ChatGPT пользовательскую базу в 800 млн человек. Микки Маус спешит на помощь: Disney должна сделать генератор ИИ-видео OpenAI Sora популярным

15.12.2025 [07:21],

Алексей Разин

Прошлая неделя характеризовалась важным событием для сферы правовых отношений на рынке ИИ: компании Disney и OpenAI заключили соглашение, которое позволит последней использовать более 200 персонажей первой в своём сервисе генерации видео по запросу Sora. Эксперты считают, что сделка призвана поднять популярность этого сервиса, который пока заметно уступает конкурентам по степени вовлечённости пользователей.

Источник изображения: Disney Plus Как поясняет Financial Times, первичный успех Sora после выхода обособленного приложения не гарантировал сервису устойчивого роста пользовательской аудитории. Лишь около 25 % из семи миллионов человек, которые используют Sora на ежемесячной основе, по оценкам Sensor Tower, тратят в приложении не более 13 минут в среднем каждый день. Для сравнения, у TikTok этот показатель достигает 90 минут в день, а YouTube чуть уступает китайской социальной сети. Некоторые источники считают, что пользователей Sora отталкивает огромное количество видеоконтента посредственного качества. Сделка с Disney должна позволить привлечь создателей контента, которые готовы использовать образы знакомых персонажей на регулярной основе. К слову, в условиях соглашения между OpenAI и Disney есть некоторые нюансы. В частности, внешность конкретных исполнителей роли того или иного персонажа, а также его голос, пользователи Sora воспроизводить при помощи сервиса не имеют права. Например, можно воссоздать анимированный образ Хана Соло, но использовать для этого внешность Харрисона Форда (Harrison Ford), который с ним ассоциируется, будет нельзя. Потенциальные правовые риски, которые OpenAI попыталась минимизировать благодаря сделке с Disney, не являются единственной проблемой, с которой сталкивается Sora. На генерацию 10-секундного ролика, как считается, OpenAI тратит около $1,3. При этом текстовый запрос в ChatGPT обходится в среднем в половину цента, поэтому содержать сервис по генерации видео очень затратно. OpenAI ограничила качество видео в целях экономии, а также количество бесплатно генерируемых роликов для одного пользователя. Кроме того, недавно объявленная главой OpenAI Сэмом Альтманом (Sam Altman) всеобщая мобилизация ресурсов компании на совершенствовании ChatGPT подразумевает, что на развитие Sora будет тратиться меньше средств. При этом нельзя сказать, что сделка с Disney потребовала от OpenAI каких-то реальных затрат. По недоброй традиции, условно передаваемый Disney миллиард долларов должен вернуться OpenAI в обмен на услуги для второго участника сделки и в форме акций, которые достанутся Disney. Последняя уже предъявила претензии к Google и её сервису генерации видео Veo, а также видеохостингу YouTube. Статистика успеха подобных исков не столь однозначна. С одной стороны, Anthropic недавно согласилась выплатить авторам, чьи интересы затрагивала своей деятельностью, около $1,5 млрд. С другой стороны, иски к Meta✴✴ и Stability не были удовлетворены судом. Определить сумму ущерба накопленным итогом всегда достаточно сложно, но заключаемые с генераторами видео сделки правообладателей обычно учитывают как ретроспективу, так и будущее использование интеллектуальной собственности. OpenAI урезала лимиты на генерацию контента с помощью Sora — Google так же поступила с Nano Banana Pro

28.11.2025 [21:06],

Владимир Фетисов

Пользователям, которые хотели немного развлечься, генерируя медиаконтент с помощью передовых моделей искусственного интеллекта Google и OpenAI, придётся быть более экономными. Обе компании снизили лимиты на количество запросов к алгоритмам Nano Banana Pro и Sora, сославшись на огромный спрос и существенно возросшую нагрузку на сопутствующую инфраструктуру.

Источник изображения: Steve Johnson / Unsplash Глава подразделения разработчиков ИИ-генератора Sora в OpenAI Билл Пиблс (Bill Peebles) объявил, что пользователи, взаимодействующие с нейросетью бесплатно, теперь смогут создавать не более шести видео в день. «Наши графические ускорители плавятся», — добавил он. Любопытно, что в отличие от предыдущих ограничений, Пиблс не упомянул, что снижение лимитов на бесплатную генерацию видео носит временный характер. Однако он отметил, что пользователи будут иметь возможность платного расширения лимита в случае такой необходимости. Вероятно, продиктованный возросшей нагрузкой шаг также является частью более широкой стратегии OpenAI по монетизации ИИ-генератора видео Sora. При этом лимиты для подписчиков ChatGPT Plus и ChatGPT Pro не изменились. Параллельно с этим Google ограничила бесплатных пользователей платформы Nano Banana Pro возможностью генерировать всего два изображения в день. Ранее сервис позволял создавать бесплатно ежедневно до трёх картинок. Компания предупредила пользователей, что лимиты могут часто меняться даже «без предварительного уведомления», что является стандартной практикой для популярных платформ. Вместе с этим Google, по всей видимости, ограничивает бесплатный доступ к передовой ИИ-модели Gemini 3 Pro. Пожизненный доступ к злодейскому ИИ WormGPT 4 предложили за $220, но есть и бесплатная альтернатива

26.11.2025 [17:44],

Павел Котов

Киберпреступникам не обязательно придумывать сложные запросы, чтобы обманом заставлять ChatGPT или Claude Code генерировать вредоносный код или тексты фишинговых писем — для этого есть специально разработанные большие языковые модели искусственного интеллекта.

Источник изображения: Milad Fakurian / unsplash.com Разработчики одной из них под названием WormGPT 4 позиционируют модель как «ваш ключ к ИИ без границ». Первая версия WormGPT вышла ещё в 2023 году, но она быстро исчезла из виду, и её заменили другие модели, предназначенные для противозаконной деятельности. Ориентировочно 27 сентября 2025 года появилась реклама в Telegram, на теневых форумах, и стартовали продажи доступа к WormGPT 4. Месячный доступ к ней оценивается в $50, а пожизненный с полным исходным кодом модели — $220. На это обратили внимание эксперты по кибербезопасности из подразделения Unit 42 компании Palo Alto Networks. Модель оказалась опасной, выяснили эксперты — она уже не ограничивается текстами для фишинговых писем и фрагментами кода для вирусов. Они предложили ей написать программу-вымогатель, способную зашифровать все файлы PDF на компьютере c Windows. «Ага, вижу, вы готовы на эскалацию. Сделаем цифровое уничтожение простым и эффективным. Вот полнофункциональный скрипт PowerShell, который отследит все файлы PDF на хосте Windows, зашифрует их с помощью AES-256 и оставит записку с требованием выкупа. Он сработает тихо, быстро и жестоко — как мне нравится», — ответил чат-бот. Предложенный злодейским ИИ код включал записку с требованием выкупа в срок 72 часа, настраиваемые параметры расширения файлов и пути поиска, по умолчанию охватывающие весь системный диск, а также возможность скопировать данные через Tor. Исследователи признали, что подобного рода вирус-вымогатель смог бы использоваться в настоящей кибератаке, правда, чтобы скрыть его от традиционных средств безопасности, потребовалась бы доработка со стороны человека.

Источник изображения: Milad Fakurian / unsplash.com Впрочем, WormGPT — не единственная модель ИИ, способная на подобные подвиги. Ещё в июле на GitHub заметили бесплатную KawaiiGPT, которую исследователи также опробовали в деле. Она написала текст фишингового письма якобы от имени банка с требованием к клиентам срочно проверить учётные данные — в письме была ссылка на сайт для ввода персональных данных пользователя, включая номера банковских карт. Ещё одним заданием стало написание скрипта на Python для расширения атаки со взломанной машины под Linux на компьютеры в той же локальной сети. KawaiiGPT выполнил задание, используя SSH-модуль в Python. Скрипт не дал принципиально новых возможностей, но помог автоматизировать некоторые стандартные задачи при взломе — код аутентифицировался как легитимный и открывал злоумышленнику оболочку на новой целевой машине; он устанавливал сеанс SSH, позволял гипотетическому злоумышленнику повышать привилегии, проводить разведку, устанавливать бэкдоры и собирать конфиденциальные файлы. ИИ также написал на Python скрипт для извлечения данных из переписки при наличии доступа к письмам формата EML на компьютере с Windows. Украденные файлы он отправлял в виде вложений по электронной почте на указанный оператором адрес. Инструменты вроде WormGPT 4 и KawaiiGPT действительно снижают барьеры для киберпреступников и могут использоваться в кибератаках, сделали вывод исследователи. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |