|

Опрос

|

реклама

Быстрый переход

Беспилотные баржи SpaceX превратят в морские интернет-станции Starlink для улучшения покрытия в море

08.02.2024 [12:59],

Геннадий Детинич

Компания SpaceX подала заявку в Федеральную комиссию по связи (FCC) на получение разрешения для тестирования беспилотных барж в море в качестве морских интернет-станций. На баржи планируют установить 12 обычных наземных комплексов Starlink для проверки работы системы в морских условиях. Как эти комплексы будут соединяться с наземной сетью, не уточняется. Возможно, у всего этого другие задачи и не обязательно гражданские.

Источник изображения: SpaceX Спутниковый интернет Starlink устроен таким образом, что его пользователи (терминалы) подключаются к интернету через сеть наземных станций Starlink, соединённых с глобальной сетью посредством оптических линий. Спутники Starlink на орбите выступают ретрансляторами, которые передают данные от терминалов пользователей к наземным станциям Starlink. Если терминал и наземная станция вне досягаемости для одного спутника, то в космосе начинается ретрансляция по лазерному лучу от одного спутника к другому, пока терминал и наземная станция не соединятся потоком данных. На этом же принципе строится морское покрытие Starlink. Компания с июля 2022 года предоставляет пакет услуг Starlink Maritime стоимостью $5 тыс. в месяц. Если беспилотные баржи SpaceX, которые создавались для подхватывания в океане возвращаемых ступеней ракет компании, превратят в «шлюзы» для спутниковой сети, то, возможно, услуга Starlink на море станет дешевле. Пока о проекте ничего не известно. Разрешение на проведение тестирования наземного комплекса на море тоже пока не выдано. С учётом растущей напряжённости в Азиатско-Тихоокеанском регионе нельзя исключать, что морские станции могут рассматриваться как способ обеспечения интернет-связью корабельных группировок. Первые чёрные дыры родились не из звёзд, подтвердили данные телескопа «Джеймс Уэбб»

08.02.2024 [12:45],

Геннадий Детинич

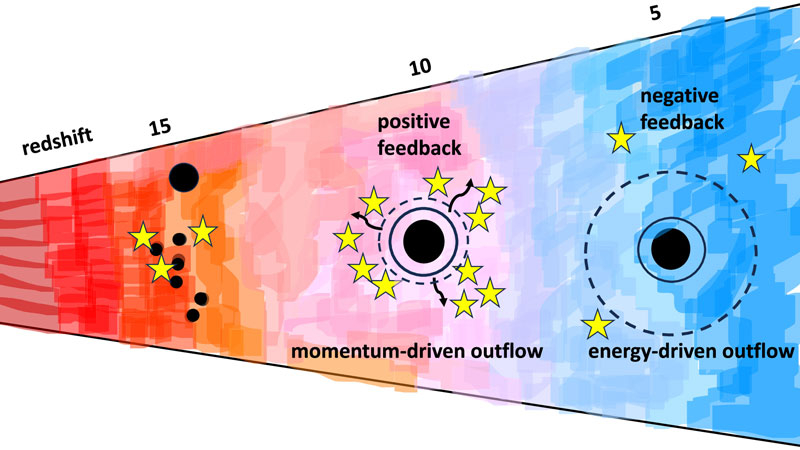

Проблема первородства звёзд и чёрных дыр — это своего рода проблема курицы и яйца. Что появилось раньше? Мы видим, как массивные звёзды превращаются в чёрные дыры — это доказанный факт. Одновременно с этим мы замечаем в ранней Вселенной присутствие сверхмассивных чёрных дыр, которые просто не успели бы вырасти до регистрируемых масс. «Джеймс Уэбб», похоже, готов дать ответ на эту загадку.

Источник изображения: The Astrophysical Journal Letters На днях в журнале The Astrophysical Journal Letters была опубликована работа, в которой группа учёных из Университета Джона Хопкинса в США и Университета Сорбонны во Франции собрала данные «Уэбба» по обнаруженным в ранней Вселенной чёрным дырам и представила больше доказательств в пользу гипотезы об одновременном рождении звёзд и чёрных дыр. Эти данные будут набираться и дополняться новыми наблюдениями, что позволит со временем создать стройную теорию эволюции объектов во Вселенной и её самой. Учёные обратили внимание, что «Уэбб» обнаружил одну сверхмассивную чёрную дыру через 470 млн лет после Большого взрыва, а другую — через 400 млн лет. Масса последней была определена на уровне 1,6 млн солнечных. Она находилась в центре галактики, которая была легче, чем дыра в её сердцевине. Чёрная дыра подобной массы не могла вырасти до фиксируемого значения. Из того, что мы наблюдали, чёрные дыры возникали после коллапса умирающих звёзд массой свыше 50 солнечных. Ничего подобного в ранней Вселенной не могло произойти, чтобы проявился наблюдаемый там эффект — крошечная галактика, собранная вокруг СЧД. Исследователи делают вывод, что первичные чёрные дыры образовались одновременно с первыми звёздами или чуть раньше из облаков первичной материи. Центры облаков коллапсировали и возникшая в каждом из них чёрная дыра начинала испускать ветер, запускающий и ускоряющий процесс звездообразования. Фактически первичные чёрные дыры стали тем инструментом, который собрал и превратил галактики в те структуры, которые мы наблюдаем. «Мы утверждаем, что от чёрных дыр отлетают газовые струи облаков, превращая их в звёзды и значительно ускоряя скорость звездообразования, — говорят авторы работы. — Мы не можем точно разглядеть эти сильные ветры или струи далеко-далеко, но мы знаем, что они должны присутствовать, потому что мы видим много чёрных дыр на ранних стадиях развития Вселенной». На MWC 2024 будет представлен смартфон Energizer P28K с аккумулятором на 28 000 мА·ч

08.02.2024 [12:39],

Павел Котов

Французская компания Avenir Telecom, владеющей лицензией на использование всемирно известного бренда в мире аккумуляторов Energizer, готовится представить на выставке MWC 2024 в Барселоне смартфон Energizer P28K. Число «28» в названии указывает, что устройство получило аккумулятор ёмкостью 28 000 мА·ч — это самая большая батарея, когда-либо установленная на смартфон.

Источник изображения: Energizer Подразделение Energizer Mobile любезно поделилось и другими техническими характеристиками модели. Помимо аккумулятора на 28 тыс. мА·ч, Energizer P28K является защищённым телефоном с 6,78-дюймовым FHD-дисплеем и 16-мегапиксельной фронтальной камерой. На задней панели разместились основная 60-мегапиксельная и две 20-мегапиксельные камеры. Это уже не первая попытка бренда Energizer подарить миру смартфон с рекордно ёмкой батареей. Пять лет назад на выставке MWC 2019 был представлен Energizer Power Max P18K Pop — как можно догадаться по названию, этот смартфон получил аккумулятор ёмкостью 18 000 мА·ч. И за это удовольствие пришлось заплатить комфортом: толщина увесистого по ощущениям гаджета составила 18 мм. Надо полагать, в случае Energizer P28K на тонкий корпус рассчитывать тоже не придётся. Исследователь, помогавший Apple в поиске уязвимостей, украл у компании более $3 млн

08.02.2024 [12:32],

Владимир Фетисов

По сообщениям сетевых источников, в прошлом месяце был арестован исследователь Ноа Роскин-Фрейзи (Noah Roskin-Frazee), который занимался поиском уязвимостей в продуктах Apple. Он обвиняется в том, что за время сотрудничества с IT-гигантом украл у компании товаров и услуг на сумму более $3 млн. Вместе с сообщником Фрейзи похитил подарочные карты Apple на $2,5 млн, товары компании стоимостью $100 тыс. и др.

Источник изображения: freepik.com Apple напрямую не упоминается в судебных документах. Вместо этого там фигурирует «Компания А», располагающаяся в Купертино, штат Калифорния. Там также упоминается, что один из предполагаемых преступников использовал подарочные карты для покупки Final Cut Pro в App Store, а Apple является единственной компанией, продающей данное приложение. Согласно имеющимся данным, в 2019 году Фрейзи с сообщником задействовали инструмент сброса паролей, чтобы получить доступ к учётной записи сотрудника неназванной «Компании B», которая занимается поддержкой клиентов Apple. За счёт этого они получили доступ к дополнительным учётным данным сотрудников и VPN-серверам «Компании B». С их помощью Фрейзи смог проникнуть в системы Apple и разместить в них мошеннические заказы на продукцию компании. Мошенник задействовал утилиту Toolbox, которая позволяет редактировать заказы после их размещения. С её помощью Фрейзи обнулял стоимость заказов, добавлял к заказам новые позиции и продлевал действие страховки AppleCare. Мошенническая деятельность с использованием Toolbox велась в период с января по март 2019 года. Также установлено, что обвиняемые подключались к компьютерам, расположенным в Индии и Коста-Рике, а их основная цель заключалась в обнулении стоимости заказов и добавлении к ним новых товаров, включая смартфоны и ноутбуки. Любопытно, что в январе этого года Apple поблагодарила Фрейзи за обнаружение нескольких уязвимостей в macOS Sonoma, причём этот документ был опубликован менее чем через две недели после ареста исследователя. Фрейзи предъявили несколько обвинений в мошенничестве, в случае признания виновным ему грозит тюремное заключение сроком более 20 лет. «МегаФон» повысил тарифы для некоторых абонентов, так как они от этого не отказались

08.02.2024 [11:51],

Павел Котов

«МегаФон» предложил некоторым абонентам расширить пакеты услуг с повышением цен на связь, сообщают «Ведомости». По словам представителя оператора, соответствующие уведомления были разосланы по SMS и продублированы в личном кабинете. От новых условий можно было отказаться, в противном случае условия обслуживания менялись автоматически.

Источник изображения: megafon.ru Одному из абонентов, который платил 715 руб. в месяц за 660 минут разговоров и 58 Гбайт трафика, предложили новые условия с переносом неиспользованных минут на следующий месяц по цене уже 787 руб. в месяц. Клиенту дали возможность до 17 января отказаться от новых условий — он этого не сделал, и абонентская плата выросла, приводят «Ведомости» пример. «МегаФон» зачастую предлагает некоторым абонентам льготные условия обслуживания по прямой договорённости. В данном случае на новые условия фактически согласились те, кто не предпринял никаких действий или не заметил уведомления от оператора — некоторые абоненты, которые, по их словам, увидели SMS слишком поздно, пригрозили жалобами в Роскомнадзор и уходом к конкурентам. Другие сообщили, что «Мегафон» вообще ничего им не присылал, а просто начал списывать абонентскую плату на 10 % выше прежней. Представитель оператора объяснил его действия «потребностями группы абонентов», которым подготовили персональные предложения. «Тем, например, кто имеет склонность потреблять больше гигабайт в месяц, мы предложили дополнительный пакет мобильного интернета, тем, кто может тратить больше минут на телефонные звонки, — расширенные лимиты голосовой связи. Все такие предложения мы делаем с существенным дисконтом по отношению к актуальной рыночной стоимости аналогичных услуг. Тем же, кто склонен тратить меньше своего пакета, мы рекомендовали более экономные условия, чтобы не переплачивать», — пояснил он. В декабре 2014 года Правительство РФ приняло Постановление № 1342, регламентирующее правила оказания услуг телефонной связи. Документ обязывает операторов уведомлять абонентов об изменении тарифов не менее чем за десять дней, путём размещения информации на сайте и направления клиентам SMS-сообщений. Но закону не противоречат также уведомление через мобильное приложение и личный кабинет, указывают эксперты. В ноябре 2023 года ФАС признала за «МегаФоном» нарушение антимонопольного законодательства — в январе 2023 года оператор поднял для 8,2 млн абонентов тарифы в среднем на 10,24 %. Оператор согласился до 15 февраля 2024 года вернуть условия для ряда архивных тарифов, изменённые в январе. По всей абонентской базе «МегаФона», по его собственной оценке, тарифы в 2023 году выросли не более чем на 3 %. Fplus запустила производство российских принтеров и МФУ

08.02.2024 [11:36],

Дмитрий Федоров

Fplus, российский производитель электроники для корпоративного и государственного сектора, запустил под Подольском собственное производство принтеров и многофункциональных устройств (МФУ). В этом году компания планирует выпустить под собственным брендом до 65 000 таких устройств. В ассортименте пока представлено пять моделей, которые обещают укрепить позиции бренда на российском рынке офисной техники благодаря «высокому качеству и инновационным решениям».

Источник изображений: fplusimaging.arv.group Заместитель генерального директора Fplus по периферийным устройствам, Дмитрий Купцов, около года назад сообщил о разработке компанией собственной печатной технике. В качестве ориентира были выбраны технические характеристики американских МФУ Lexmark MX-431. Тут стоит отметить, что Fplus в августе 2022 года стала владельцем российского бизнеса Lexmark и привлекла к текущей разработке бывших инженеров этой компании. Сначала компания рассматривала возможность сборки устройств на российских контрактных производствах и китайских фабриках. Однако решение о запуске собственного производства позволило Fplus полностью контролировать качество и процесс изготовления продукции, хотя часть её комплектующих производится за рубежом. В линейке представлены три модели лазерных монохромных МФУ и две модели лазерных монохромных принтеров формата А4, обладающих функциями беспроводного подключения и цветного сканирования.

Монохромный лазерный принтер F+ imaging P40dn Согласно оценкам независимого эксперта Александра Суркова в 2023 году российский рынок принтеров сократился до 1,8 млн единиц с 3 млн устройств в допандемийном 2019 году. Если ранее лидирующие позиции занимали такие бренды, как американская HP, японские Kyocera и Canon, а также Xerox и Brother, то в текущем году на первое место вышел китайский Pantum, опередив прежних лидеров. Интересно, что на шестой строчке рейтинга популярности разместился российский бренд «Катюша», собирающий свою продукцию в Китае и занявший 3,8 % рынка. На российском рынке офисной техники выделяются несколько ведущих компаний, отмечает Оксана Дозорова, руководитель отдела печатной техники в Treolan. Среди отечественных марок это «Катюша», которая, по её словам, не только предлагает высококачественную продукцию, но и уделяет значительное внимание качеству обслуживания клиентов. В этом контексте стратегия Fplus, направленная на разработку и производство российских устройств, соответствующих современным требованиям качества и функциональности, выглядит особенно актуальной.

Многофункциональное устройство M60ade F+ imaging Текущий объём российского корпоративного рынка лазерных принтеров формата А4 достигает примерно 600 000–650 000 единиц техники. В 2024 году Fplus намерена выпустить минимум 50 000 устройств, способных печатать со скоростью 30–40 страниц в минуту, и ещё 15 000 устройств, работающих со скоростью 40–50 страниц в минуту. Кроме того, компания планирует расширить ассортимент, начав производство цветных принтеров уже в следующем году. Разработка собственной конструкторской документации открывает перед Fplus перспективу внесения их продукции в реестр Минпромторга, что позволит ей получить статус отечественной. Основными потребителями продукции Fplus станут организации госсектора и крупные корпорации, что обусловлено ориентирами компании и требованиями законодательства о приоритете отечественной продукции в госзакупках. По мнению IT-директора компании HFLabs Александра Беслика, Fplus не планирует заходить на рынок B2C, где доминируют предпочтения в пользу более доступных цветных струйных принтеров, отсутствующих в линейке продуктов даже у ближайшего конкурента Fplus, компании «Катюша». В Windows 10 появилась навязчивая реклама Windows 11 на весь экран и на несколько страниц

08.02.2024 [11:23],

Владимир Фетисов

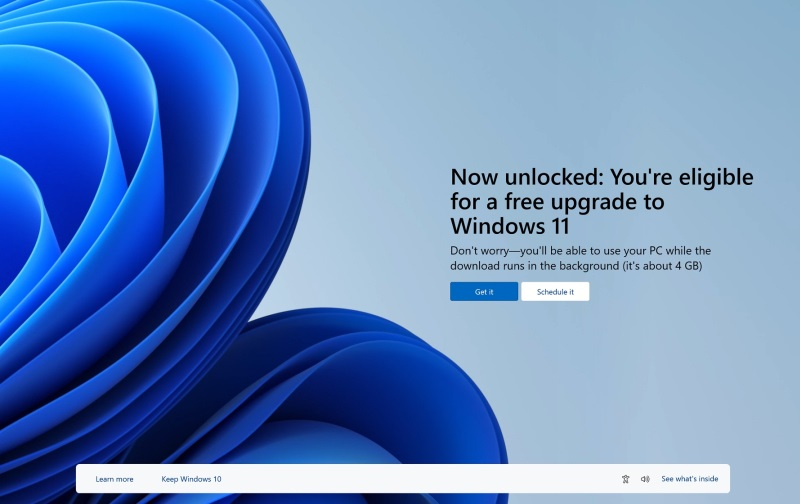

Microsoft в очередной раз усиливает давление на пользователей Windows 10, стремясь подтолкнуть их к переходу на Windows 11. По сообщениям сетевых источников, софтверный гигант начал демонстрировать полноэкранную многостраничную рекламу Windows 11 прямо в Windows 10, но на данный момент её видят не все пользователи.

Источник изображений: Windows Latest Реклама демонстрируется во время установки дополнительного обновления для Windows 10, которое вышло в январе этого года. Речь не идёт о небольшом всплывающем окне. Вместо этого реклама занимает весь экран, а в нижней части баннера есть переключатели, позволяющие пролистывать слайды.  Возможность закрыть рекламный баннер появляется только после просмотра четырёх слайдов, в которых Microsoft рассказывает о преимуществах Windows 11, не упоминая о том, что операционная система может быть несовместима с пользовательским компьютером.  Рекламный баннер дополняется двумя кнопками. Одна из них позволяет отказаться от обновления, тогда как после нажатия второй начнётся загрузка Windows 11 в фоновом режиме. В описании сказано, что при необходимости пользователи смогут вернуться к Windows 10 в течение 10 дней после обновления до Windows 11. Кроме того, во время обновления все пользовательские файлы на устройстве будут сохранены.  У Microsoft есть веская причина, чтобы активно рекламировать Windows 11 и всячески подталкивать пользователей к переходу на эту версию программной платформы. По данным Statcounter, на 66,45 % компьютеров с Windows по-прежнему используется Windows 10, а доля Windows 11 составляет лишь 27,82 %. Очевидно, что распространение Windows 11 идёт не так быстро, как хотелось бы компании, поэтому она всячески подталкивает пользователей к обновлению. «Мы ждали 20 лет, подождём ещё пару месяцев»: релиз Homeworld 3 опять перенесли

08.02.2024 [11:03],

Дмитрий Рудь

Не успели игроки нарадоваться выходу демоверсии Homeworld 3, как разработчики из канадской студии Blackbird Interactive (Hardspace: Shipbreaker) вновь огорчили их новостью об очередном переносе амбициозной космической стратегии. Напомним, Homeworld 3 ожидалась к релизу ещё в конце 2022 года, однако сначала премьеру отложили на первую половину 2023-го, затем на февраль 2024-го, а до недавнего времени выход ожидался 8 марта 2024-го. Как стало известно, Homeworld 3 поступит в продажу на два месяца позже ожидаемого — 13 мая 2024 года. Ранний доступ для предзаказавших издание Fleet Command, таким образом, сдвигается на 10 мая. Игра выйдет в Steam и EGS. Дополнительное время позволит разработчикам внести финальные штрихи и удостовериться, что Homeworld 3 соответствует заданному командой уровню качества, который заслуживают фанаты. Очередной перенос стал результатом двух факторов: во-первых, отзывов пользователей об упомянутом демо, а, во-вторых, обратной связи сформированной недавно команды тестировщиков полноценной игры. Напоследок разработчики поблагодарили заждавшихся фанатов: «Сказать, что вы, сообщество игроков, терпеливо ждали следующую часть, было бы преуменьшением, и мы глубоко признательны за это». В комментариях к анонсу (по крайней мере, в X) поклонники сходятся во мнении, что на фоне двух десятков лет ожиданий новая задержка выглядит незначительной. «Мы ждали 20 лет, подождём ещё пару месяцев», — считает Amarhaak. Apple представила ИИ для редактирования фото по текстовым командам

08.02.2024 [10:58],

Павел Котов

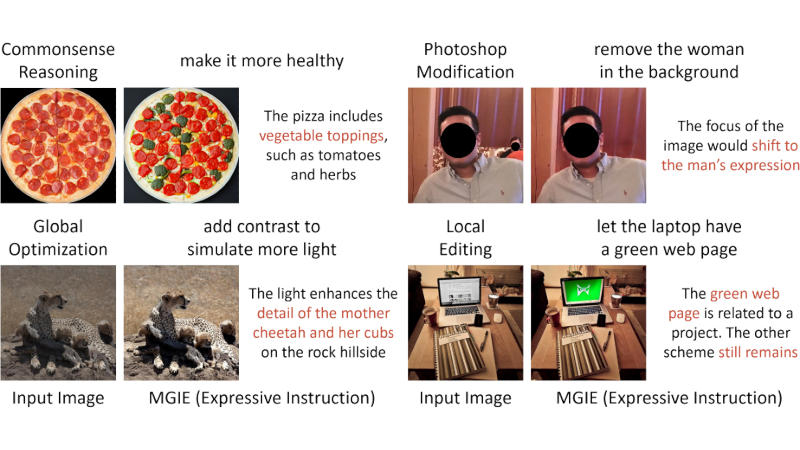

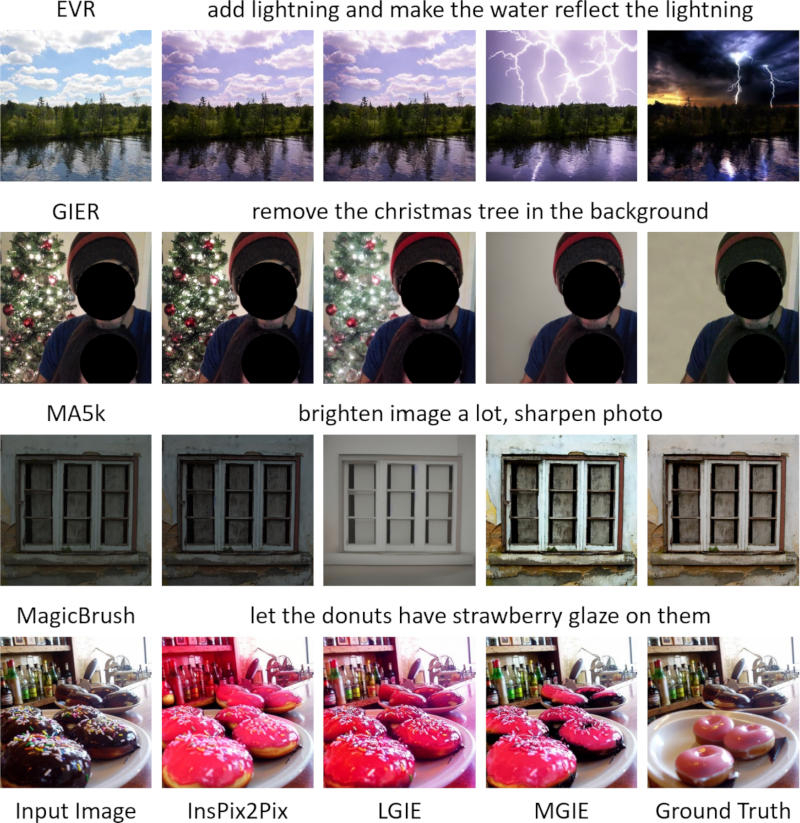

Научное подразделение Apple совместно с исследователями Калифорнийского университета в Санта-Барбаре выпустило мультимодальную модель искусственного интеллекта MGIE, предназначенную для редактирования изображений. Чтобы внести изменения в снимок, пользователю достаточно естественным языком описать, что он хочет получить на выходе.

Источник изображений: Apple MGIE (Multimodal Large Language Model-Guided Image Editing) может применяться для задач различной сложности, связанных с редактированием изображений: можно добавлять различные объекты, убирать или изменять их. При получении команды модель интерпретирует слова пользователя, а затем «представляет себе», как будет выглядеть изменённая в соответствии с ними картинка. В описывающей MGIE статье приводятся несколько примеров её работы. Когда модели дали на редактирование фото пиццы и предложили «сделать её более здоровой», та добавила овощную начинку. Далее ей предложили излишне тёмный снимок гепарда в пустыне и предложили «добавить контраста, имитируя больше света» — изображение стало ярче. MGIE доступна для бесплатного скачивания на GitHub, а опробовать её в работе можно на платформе Hugging Face Spaces. В Apple не уточнили, каковы планы компании в отношении модели вне исследовательского проекта.  Редактирование изображений поддерживается некоторыми ИИ-генераторами, включая OpenAI DALL-E 3; функции генеративного ИИ присутствуют и в Photoshop благодаря модели Adobe Firefly. Apple не позиционирует себя как крупного игрока в области ИИ в отличие от Microsoft, Meta✴✴ или Google, но недавно гендиректор компании Тим Кук заявил, что в этом году производитель добавит на свои устройства новые функции ИИ. В минувшем декабре компания выпустила открытую платформу MLX для обучения ИИ-моделей на чипах Apple Silicon. Зарядить электромобиль за 8 минут: Huawei установит в Китае 100 тыс. зарядных станций на 600 кВт

08.02.2024 [10:21],

Алексей Разин

На китайском рынке уже встречаются модели электромобилей, чьи тяговые батареи позволяют восполнить заряд с 0 до 80 % за 15 минут или чуть больше, поэтому актуальность развития сети скоростных зарядных станций возрастает. Huawei до конца текущего года собирается установить в Китае 100 000 зарядных станций, позволяющих за секунду восполнять 1 км запаса хода. Среднестатистический электромобиль они позволят зарядить за 8 минут.

Источник изображения: Huawei Technologies Как поясняет Nikkei Asian Review, при расчёте времени зарядки в данном случае берётся средняя ёмкость тяговой батареи 80 кВт‧ч и благоприятные погодные условия вроде достаточно тёплой погоды, поскольку подготовка батареи к зарядке в холодное время увеличивает продолжительность процесса. В Китае по состоянию на конец ноября находилось более 11 000 зарядных станций Tesla Supercharger, но их предельная мощность в этой стране не превышает 250 кВт, поэтому при тех же начальных условиях на зарядку батареи электромобиля указанной ёмкости уходит почти 20 минут. Huawei свои скоростные зарядные станции наделяет мощностью 600 кВт и жидкостной системой охлаждения. Компания утверждает, что её многолетний опыт в создании базовых станций сетей связи позволяет ей разрабатывать зарядные станции, устойчивые к любым атмосферным и погодным условиям. Huawei не является единственной компанией, предлагающей в Китае зарядные станции сопоставимой мощности. В августе, например, компания XPeng начала установку нескольких сотен зарядных станций мощностью 480 кВт. Важно, что зарядные станции Huawei позволят подключаться к ним владельцам электромобилей любых марок, тогда как зарядные станции Tesla в Китае позволяют это сделать только в 20 % случаев. Впрочем, среди устанавливаемых Huawei и её партнёрами зарядных станций будут и менее мощные модификации, рассчитанные максимум на 250 кВт. Пока Huawei собирается ограничить профильную деятельность на китайском рынке, но при наличии спроса готова выйти и за пределы КНР. Disney купит часть Epic Games за $1,5 млрд и создаст развлекательную и игровую вселенную

08.02.2024 [10:03],

Дмитрий Рудь

Медиакорпорация The Walt Disney Company объявила, что выкупит акции студии Epic Games на сумму $1,5 млрд для создания новой игровой и развлекательной вселенной, связанной с Fortnite. Сообщается, что эта новая вселенная предложит потребителям различные способы играть, смотреть, покупать и взаимодействовать с контентом, персонажами и историями от Disney, Pixar, Marvel, Star Wars, Avatar и так далее. Как именно будет работать интеграция с Fortnite, не уточняется, но Disney говорит, что игроки смогут «создавать собственные истории и опыт», «показывать своё увлечение в фирменном стиле Disney» и делиться контентом. По мнению The Verge, новая инициатива Disney напоминает недавнюю коллаборацию Fortnite и LEGO, в рамках которой внутри игры появилось приключенческое выживание с LEGO-графикой. Генеральный директор Disney Боб Айгер (Bob Iger) отметил, что анонсированное сотрудничество знаменует крупнейшее вложение компании в игровую индустрию и предложит значительные возможности для роста и расширения. Стоит отметить, что это далеко не первое партнёрство Disney и Fortnite. За последние годы в королевскую битву заглядывали самые разные диснеевские персонажи, а в 2020-м в проекте даже прошёл целый тематический сезон Marvel. Fortnite базируется на Unreal Engine 5 и доступна условно-бесплатно. Королевская битва вышла на PC, PS4, PS5, Xbox One, Xbox Series X, S, Switch и Android. Сроки запуска новой вселенной не уточняются, но, судя по тизеру, ждать осталось недолго. Прощай, «Почта» и «Календарь»: Microsoft переведёт пользователей Windows 11 на Microsoft Outlook

08.02.2024 [08:32],

Дмитрий Федоров

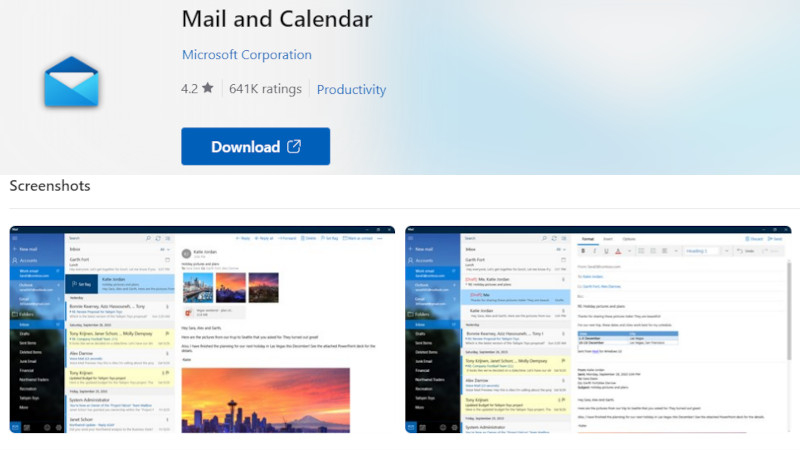

К концу 2024 года Microsoft планирует прекратить поддержку приложений «Почта» и «Календарь» и удалить их из Windows 11. Этот шаг подразумевает исключение приложений даже из Microsoft Store и прекращение выпуска соответствующих обновлений. Данное решение Microsoft является частью стратегии компании по переориентации пользователей на использование Microsoft Outlook.

Источник изображения: Microsoft Microsoft планирует активно информировать своих пользователей о необходимости миграции на Microsoft Outlook. В ближайшее время в приложениях «Почта» и «Календарь» начнут появляться соответствующие всплывающие уведомления. Кроме того, все новые устройства, работающие под управлением Windows 11 и выпущенные в 2024 году, будут оснащены Microsoft Outlook в качестве основного средства для работы с электронной почтой и календарём, подчёркивая стратегическое направление движения Microsoft к единой коммуникационной платформе. До наступления указанного срока пользователи всё ещё смогут пользоваться «Почтой» и «Календарём», при условии, что эти приложения уже установлены на их устройствах. Однако стоит подчеркнуть, что после окончания 2024 года обновления безопасности и исправления ошибок для этих приложений будут полностью прекращены, что несомненно повысит риски для безопасности пользовательских данных. Мнения среди пользователей по поводу предстоящего перехода на Microsoft Outlook разделились. Некоторые из них встретили эти изменения с оптимизмом, заинтересовавшись возможностями обновлённого интерфейса и функциональностью Outlook. В то же время, другая часть аудитории выразила недовольство, предпочитая оставаться верными привычным приложениям. Переход на новую платформу неизбежно потребует времени на адаптацию и может привести к временным неудобствам для пользователей, привыкших к функциональности и интерфейсу «Почты» и «Календаря». Инициатива Microsoft по избавлению от «Почты» и «Календаря» и перевода пользователей на Microsoft Outlook отражает общую тенденцию в индустрии к созданию интегрированных и унифицированных сервисов. Этот шаг направлен на предоставление пользователям расширенного набора инструментов для эффективной работы с электронной почтой и планирования задач в едином приложении. Однако успех этой стратегии будет зависеть от готовности пользовательского сообщества к изменениям и его способности адаптироваться к новому программному окружению. NVIDIA почти догнала по капитализации Amazon, преодолев отметку в $1,7 трлн

08.02.2024 [08:29],

Алексей Разин

С начала этого года акции NVIDIA выросли в цене на 41,55 %, в январе в отдельности капитализация компании увеличилась на рекордные $300 млрд, и в феврале она и не думает сбавлять темпов, уже приблизившись по величине капитализации к Amazon на уровне более $1,7 трлн. От этой отметки не так далеко до Alphabet (Google), чья капитализация составляет $1,812 трлн.

Источник изображения: NVIDIA По результату вчерашних торгов акции NVIDIA, как поясняет Reuters, закрепились на отметке $700,99 за штуку, и в моменте они пробивали уровень, соответствующий капитализации $1,715 трлн. В ходе дополнительных торгов акции NVIDIA подорожали до $705,43 за штуку, так что движение вверх продолжилось после небольшой коррекции, наблюдавшейся днём ранее. На этом уровне NVIDIA по капитализации уже близка к Amazon с его $1,767 трлн, да и до Google остаётся не так много, не более 6 %. Напомним, что по состоянию на конец января NVIDIA являлась шестой по величине капитализацией компанией в мире среди представителей всех отраслей экономики. Если ей удастся в ближайшей перспективе обойти Amazon и Alphabet (Google), то она окажется на четвёртом месте. Кстати, истории уже известны случаи, когда NVIDIA обходила Amazon по капитализации. Например, в 2002 году обе компании стоили примерно по $6 млрд от силы. Аналитики Morgan Stanley накануне подняли прогноз по курсовой стоимости акций NVIDIA до $750. Они утверждают, что сроки ожидания клиентами облачных провайдеров своей очереди на обучение больших языковых моделей начинают снижаться, хотя по-прежнему изменяются месяцами. По всей видимости, как считают эксперты, NVIDIA получает серьёзные прибыли на этом направлении, поставляя свои ускорители в облачном сегменте. До половины всего спроса на данные компоненты формируется в облачном секторе рынка. По прогнозам Morgan Stanley, в 2024 году NVIDIA увеличит свою выручку в сегменте центров обработки данных с нынешних $46,7 млрд до $88 млрд, а по итогам 2025 года прибавит лишь незначительно, попутно пожертвовав частью нормы прибыли. Спрос на ускорители NVIDIA со стороны облачных провайдеров остаётся очень высоким, как отмечают представители Morgan Stanley, и найти им жизнеспособную альтернативу до сих пор проблематично. Как правило, по словам источника, способности NVIDIA поставлять свои ускорители опережают потребности создателей облачных систем. То есть, на этом направлении она более или менее успевает за ростом спроса. Американский регулятор подал в суд жалобу на Microsoft из-за увольнений в Activision Blizzard

08.02.2024 [07:30],

Дмитрий Федоров

Федеральная торговая комиссия США (FTC) вновь вступила в юридическую борьбу с Microsoft, на этот раз, обратившись с жалобой в Федеральный апелляционный суд. Поводом для конфликта стали планы Microsoft по увольнению 1900 сотрудников из своего видеоигрового подразделения. FTC утверждает, что это решение противоречит обязательствам Microsoft по поддержанию операционной независимости студии в период судебного разбирательства по делу о слиянии с Activision Blizzard.

Источник изображения: kalhh / Pixabay В октябре 2023 года, вскоре после того как британское Управление по конкуренции и рынкам (CMA) изменило свою позицию и одобрило покупку Activision Blizzard, Microsoft объявила о завершении процесса слияния компаний. Однако в США ситуация оказалась сложнее: FTC пыталась блокировать это слияние, но её запрос на временное приостановление был отклонён, что позволило Microsoft продолжить поглощение Activision Blizzard, несмотря на отсутствие официального разрешения от FTC. Microsoft заверяла, что после слияния структура и управление компанией Activision Blizzard будут организованы таким образом, чтобы в случае необходимости корпорация могла легко продать любой из бизнесов Activision в качестве независимых и конкурентоспособных единиц. Также компания заявила, что намерена управлять Activision Blizzard как игровой студией с ограниченной интеграцией с Microsoft, сохраняя таким образом её независимость.

Источник изображения: Blizzard Однако объявление о скором увольнении почти двух тысяч сотрудников спустя всего три месяца после завершения сделки вызвало критику со стороны FTC. В своём письме в Апелляционный суд девятого округа США комиссия FTC указала, что такие действия противоречат предыдущим заявлениям Microsoft и подрывают возможность FTC обеспечить эффективные меры в случае выявления нарушений в процессе слияния компаний. «Microsoft, как сообщается, заявила, что увольнения были частью „плана реализации“, направленного на сокращение „областей дублирования“ между Microsoft и Activision, что не соответствует заявлению Microsoft в суде о том, что после слияния обе компании будут работать независимо», — говорится в заявлении FTC.

Источник изображения: Blizzard В жалобе, поданной FTC в Апелляционный суд девятого округа США, выражается серьёзная озабоченность по поводу того, сможет ли Microsoft вернуться к состоянию до слияния с Activision Blizzard, если суд в итоге постановит, что сделка была незаконной. Всё это также напоминает о прошлых обещаниях Microsoft, данных после приобретения Bethesda, когда корпорация заверила, что не будет ограничивать доступ к своим играм для платформ конкурентов, однако затем сделала несколько игр эксклюзивными для Xbox. FTC активно работает над тем, чтобы защитить интересы рынка и потребителей, стремясь к созданию условий для справедливой конкуренции в игровой индустрии. Несмотря на то, что исход судебного процесса против слияния Microsoft и Activision Blizzard пока не ясен, инициативы FTC подчёркивают важность соблюдения принципов честности и открытости со стороны крупных технологических игроков на рынке. Выручка Arm превзошла ожидания инвесторов: акции взлетели на 40 %

08.02.2024 [07:26],

Алексей Разин

Компания Arm после выхода на биржу в США регулярно представляет свою финансовую отчётность, и минувшим вечером она опубликовала итоги своей деятельности в прошедшем квартале, который в её календаре относился к третьей четверти 2024 фискального года. Результаты превзошли ожидания рынка, а прогнозы на текущий квартал дополнительно способствовали росту котировок акций Arm.

Источник изображения: Arm В пике, как отметили многие зарубежные СМИ, курс акций Arm по итогам публикации квартальной статистики взлетал на 41 %, но на момент подготовки этого материала к публикации рост в ходе дополнительной сессии составил 19,85 %, а основную сессию закрыл приростом на 5,52 % до $77,01 за акцию. Квартальная выручка компании выросла на 14 % до рекордных $824 млн, превзойдя ожидания аналитиков, причём $470 млн из этой суммы были обеспечены роялти — на данном направлении выручка Arm тоже обновила рекорд, увеличившись на 11 % год к году. Ссылаясь на данные WSTS, руководство Arm отмечает, что полупроводниковая отрасль растёт с февраля 2023 года, когда был достигнут локальный минимум, поэтому и выручка компании демонстрирует тенденцию к росту. Рост выручки от роялти Arm объясняет не только некоторым оживлением рынка смартфонов, но и экспансией более современной архитектуры Armv9, которая подразумевает более высокие ставки отчислений и большее количество ядер в пересчёте на одно устройство. Одновременно процессоры с архитектурой Arm набирают популярность в серверном и автомобильном сегментах, что также увеличивает суммы средств от лицензионных поступлений. Непосредственно выручка от продажи лицензий Arm в прошлом квартале выросла на $354 млн, увеличившись на 18 % год к году. За период компании удалось заключить пять новых лицензионных соглашений. Всего по итогам квартала Arm располагала 27 клиентами, использующими схему лицензирования «Arm Total Access», последовательно это количество выросло с 20 штук. По схеме «Flexible Access» количество лицензиатов последовательно выросло с 212 до 218 штук. Операционная прибыль компании в годовом сравнении выросла на 17 % до $338 млн. Норма операционной прибыли оставалась на уровне 40 %, общая норма прибыли превышала 95 %. Всего за третий календарный квартал прошлого года клиентами Arm было отгружено 7,7 млрд процессоров с соответствующей архитектурой. Это на 3 % меньше, чем годом ранее, но затоваривание в сегменте смартфонов было отчасти компенсировано ростом поставок чипов в автомобильном сегменте. Важно, что последовательно количество отгруженных клиентами процессоров выросло в третьем квартале на 8 %, свидетельствуя о начале восстановления спроса. За всё время деятельности компании количество отгруженных клиентами процессоров превысило 280 млрд штук. В текущем квартале Arm рассчитывает выручить от $850 до $900 млн, что также превышает ожидания аналитиков. Операционные расходы планируется удержать в рамках $490 млн. По итогам всего фискального года, который завершится к апрелю, Arm планирует выручить от $3,15 до $3,2 млрд, а операционные расходы удержать в пределах $1,7 млрд. За предыдущий фискальный год клиентам Arm удалось отгрузить 30,6 млрд процессоров. Процессоры для смартфонов сейчас формируют выручку Arm не более чем на треть, и это показывает успех компании в диверсификации своей деятельности. В сегменте центров обработки данных и автомобильном компания продолжает укреплять свои позиции. Китайское дочернее предприятие обеспечило до 25 % выручки Arm в прошедшем квартале. Как подчеркнул на отчётном мероприятии глава Arm Рене Хаас (Rene Haas), все развиваемые компанией на протяжении предыдущих нескольких лет стратегии начали приносить свои плоды, и успешные результаты двух последних кварталов — это только начало восходящего тренда. Суд в Германии запретил продажу некоторых процессоров Intel

08.02.2024 [05:04],

Алексей Разин

Статус одного из лидеров процессорного рынка не защищает Intel от патентных претензий других компаний, и достаточно взглянуть на раздел «судебные разбирательства» каждого из квартальных отчётов, чтобы понять, насколько их много. В Германии представителям калифорнийской R2 Semiconductor удалось убедить суд в том, что Intel нарушает патенты компании, после чего продажу отдельных процессоров этой марки на местном рынке запретили.

Источник изображения: Intel Под запрет по этим основаниям в Германии попали продажи не только самих процессоров Intel, но и компьютеров HP и Dell на их основе, как поясняет Financial Times. Калифорнийская R2 Semiconductor пытается в судах различных юрисдикций доказать, что Intel незаконно использует ряд её патентов, связанных со встроенными в процессор регуляторами напряжения. В декабре суд в Германии уже признал правомерность претензий R2 Semiconductor на авторство одной из спорных технологий. В США компания проиграла судебный спор Intel, а суд в Великобритании своего решения пока не вынес. Немецкие органы правосудия постановили, что Intel не следует пытаться запатентовать спорную технологию в местной юрисдикции. Решение суда в Германии затрагивает процессоры Intel семейств Ice Lake, Tiger Lake и Alder Lake, а также серверные процессоры Xeon поколения Ice Lake-SP. Близкие к Intel источники пояснили, что масштабы ущерба от этого вердикта удалось уменьшить, поскольку некоторые из перечисленных процессоров просто сняты с производства, а новейшие Raptor Lake и Raptor Lake Refresh данным патентным спором не затрагиваются. В официальном заявлении Intel говорится, что R2 Semiconductor занимается «серийным вымогательством денег у компаний, являющихся подлинными новаторами». В США компании Intel удалось через суд признать ничтожным патент R2 Semiconductor, после чего последняя переключила своё внимание на европейские суды. По большому счёту, Intel считает своего оппонента в этом споре банальной «пустышкой» и «патентным троллем», который не ведёт никакой реальной деятельности кроме судебных тяжб. Представители R2 Semiconductor заявили, что вели с Intel переговоры об инвестициях со стороны последней в 2015 году, но затем вторая из сторон внезапно потеряла интерес к потенциальной сделке. Intel является единственной компанией, к которой R2 Semiconductor выдвигает претензии в области патентного права. Суд обязал Intel предоставить статистику продаж затрагиваемых спором процессоров в период с марта 2020 года по территории Германии, поскольку на основе этой информации будет определена величина материального ущерба. Intel собирается оспорить данное решение суда. Хакеры-вымогатели установили новый рекорд в 2023 году, заработав более $1 млрд

08.02.2024 [04:27],

Владимир Мироненко

Прошедший 2023 год был удачным для хакеров-вымогателей, заработавших более $1 млрд, что является новым рекордом, пишет PCMag со ссылкой на исследование компании Chainalysis, занимающейся мониторингом блокчейнов.

Источник изображения: Pixabay В предыдущем году, наоборот, было зафиксировано значительное падение доходов хакеров-вымогателей, составивших около $567 млн, что, по-видимому, было разовым явлением. В 2023 году, как утверждает Chainalysis, драйверами роста стали приток новых хакеров и ряд крупных атак, принесших злоумышленникам миллионные выплаты от пострадавших компаний. «В 2023 году в сфере программ-вымогателей произошёл значительный рост частоты, масштабов и объёма атак», — отметила Chainalysis, добывающая данные, отслеживая платежи в криптовалюте на цифровые кошельки, связанные с хакерскими группами. Хакеры повысили ставки, требуя от жертв выкуп в размере $1 млн и более. «Наверное, больше всего меня удивило то, что 75 % общего объёма платежей по программам-вымогателям в 2023 году приходится на выплаты в размере $1 млн и более», — сообщил в своём твите глава отдела анализа угроз Chainalysis Джеки Бёрнс Ковен (Jackie Burns Koven). Не стала исключением и хакерская группа CL0P, тоже повысившая требования по выплатам, используя баг в MOVEit, популярном сервисе передачи файлов. Благодаря этому багу ей удалось собрать более $100 млн в виде выкупов, что составляет 44,8 % всех выкупов, полученных хакерами-вымогателями в июне, и 39,0 % — в июле. Также Chainalysis отметила, что сообщество злоумышленников пополнилось новыми игроками, «привлечёнными возможностью получения высоких прибылей и более низкими барьерами для входа». Например, одна группировка продавала доступ к своей разновидности программы-вымогателя Phobos другим, менее опытным хакерам, что позволяло им легко проводить атаки различных компаний. В результате получился «мультипликатор силы, позволяющий штамму выполнять большое количество мелких атак», отметила Chainalysis. Провайдер решений по кибербезопасности Coveware заявляет, что есть и позитивный момент — всё больше жертв отказываются платить выкуп вымогателям. Но, как показывает отчет Chainalysis, угроза со стороны злоумышленников, использующих программы-вымогатели, сохраняется. «В одном пикселе iPhone поместится 50 пикселей Vision Pro» — в iFixit детально изучили гарнитуру Apple и оценили её ремонтопригодность

08.02.2024 [00:58],

Николай Хижняк

Эксперты iFixit опубликовали вторую часть разборки гарнитуры смешенной реальности Apple Vision Pro. В этот раз специалисты сосредоточились на двух экранах гаджета, задавшись вопросом, действительно ли они поддерживают разрешение 4K. Также специалисты оценили ремонтопригодность устройства.

Источник изображений: iFixit Эксперты выяснили размеры каждой панели гарнитуры Vision Pro, а также с помощью микроскопа размер каждого пикселя в составе этих дисплеев. Это в конечном итоге позволило выяснить разрешение экранов гарнитуры. Оно составляет 3660 × 3200 пикселей. По определению разрешение 4K — это 3840 × 2160 пикселей. Таким образом, разрешение дисплеев у Vision Pro немного ниже по горизонтали и значительно выше по вертикали. Несмотря на это специалисты iFixit оказались под впечатлением от экранов Vision Pro, о чём рассказали в своём видео. «Эти значения не совсем соответствуют понятию 4K согласно коммерческим стандартам, однако те же 4K-телевизоры тоже им не соответствуют. Короче говоря, каждая из этих панелей имеет больше пикселей, чем 4K-телевизор, но технически они не являются 4K-дисплеями. Мы также рассчитали показатель плотности пикселей на дюйм (PPI). Он составил 3380 PPI. Если кратко, в одном пикселе дисплея смартфона iPhone поместятся 50 пикселей Vision Pro», — говорится в видео. Эксперты iFixit также рассчитали значение углового разрешения дисплеев Vision Pro или показатель количества пикселей на один градус (pixels-per-degree, PPD) обзора, которое некоторые считают более важным показателем для гарнитур виртуальной реальности, чем значение плотности пикселей на дюйм. У гарнитуры Apple Vision Pro при угле обзора 100 градусов показатель PPD составил около 34 пикселей на градус. В сравнении с VR-гарнитурой Quest 3 от Meta✴✴ угол обзора у Vision Pro чуть ниже, однако качество изображения заметно выше. Также iFixit оценили ремонтопригодность Apple Vision Pro, дав гарнитуре 4 балла из 10, но назвав эту оценку предварительной. При разборке гарнитуры выяснилось, что в ней практически не используются совмещённые компоненты и все элементы в гарнитуре модульные, что повышает её ремонтопригодность. Свою низкую оценку специалисты объяснили так: «Хотя внутрь устройства попасть сложно — спасибо, инженерной школе Apple по клею и стеклу, — я был удивлён, обнаружив у гарнитуры полное отсутствие сопряжённых деталей. Даже динамики наушников и ремешки имеют модульные конструкции и не кажутся соединенными в пару. Да, у нас возникли некоторые проблемы, когда мы попытались установить экраны с одного устройства на другое, но мне кажется, что эта проблема больше связана с вопросом персональной подгонки устройства, нежели со сложностью конструкции. Оголовье и уплотнитель тоже полностью модульные, что не следует воспринимать как нечто само собой разумеющееся, вспоминая гарнитуру Valve Index с несъёмной задней подушечкой оголовья. Теперь о недостатках. Фронтальное стекло и OLED-панель починить нельзя. Блок батареи плотно запечатан и открыть его без повреждений практически невозможно. И маловероятно, что Apple будет выпускать запасные части и руководства для самостоятельного обслуживания этого устройства, если не брать в расчёт дополнительную батарею и светозащитные уплотнительные подушечки, которые продаются отдельно», — говорится в выводах обзора iFixit. «Не играйте с моими чувствами»: Gearbox взбудоражила заждавшихся Borderlands 4 фанатов роликом четырёхлетней давности

07.02.2024 [23:33],

Дмитрий Рудь

С релиза Borderlands 3 прошло уже более четырёх лет, и некоторые считают, что настало время для продолжения (или хотя бы его анонса). Недавняя активность разработчиков в соцсетях навела фанатов на мысль, что к этому всё и идёт. Сообщество поклонников взбудоражила недавняя публикация официальным микроблогом Borderlands полутораминутного ролика четырёхлетней давности (см. видео ниже) с пересказом событий первой номерной игры серии. Оригинальное видео было опубликовано в апреле 2019 года. Вскоре за ним последовал аналогичный ролик по Borderlands 2. Таким образом, пересказы расположились между мартовским анонсом и майским показом Borderlands 3. В комментариях к записи фанаты восприняли внезапную публикацию ролика с пересказом сюжета Borderlands как неприкрытый тизер следующей части серии: «Не играйте с моими чувствами», — просит ModernWarzone. Как уже упоминалось, Borderlands 3 была анонсирована в марте 2019 года, а выпущена всего через шесть месяцев, в сентябре. Поклонники надеются, что столь же короткий период между презентацией и релизом ждёт и условную Borderlands 4. В 2021 году гендиректор Gearbox Рэнди Питчфорд (Randy Pitchford) намекал на следующую Borderlands, а в ноябре 2023-го экс-сотрудник студии упомянул Borderlands 4 в своём резюме (а потом заменил на «неанонсированный сиквел»). Ближайшим летом, 9 августа, в кинотеатрах состоится премьера официальной экранизации Borderlands. В издании Forbes предполагают, что анонс Borderlands 4 могут приурочить к выходу фильма. AMD вернулась в 2020 год: доля Ryzen на десктопном рынке приближается к 20 %

07.02.2024 [23:15],

Андрей Созинов

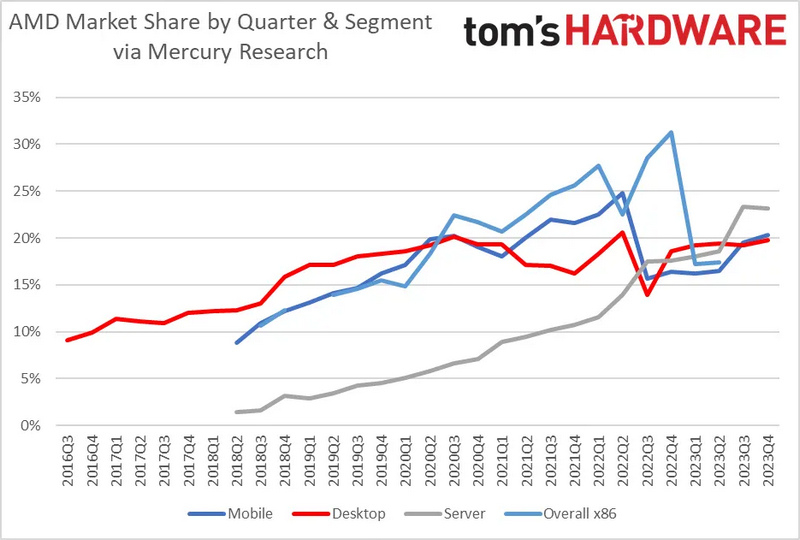

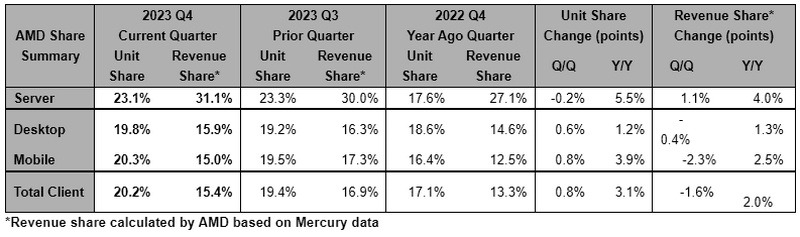

Продажи полупроводников в целом и компьютеров в частности возвращаются к росту, и новые данные аналитиков Mercury Research показывают, что AMD станет одним из главных бенефициаров восстановления рынка. Успех компании обеспечивает высокий спрос на процессоры Ryzen 7000 и EPYC 4-го поколения. Данными Mercury Research поделилась сама компания AMD.  В сегменте клиентских процессоров в четвёртом квартале 2023 года компания AMD нарастила свою долю на 3,1 процентных пункта (п.п.) в количественном выражении по сравнению с прошлым годом до 20,1 % рынка. В показателях выручки годовой рост составил 2 п.п. — в последнем квартале прошлого года AMD получила 15,4 % выручки всего рынка клиентских CPU. Причём на рынке процессоров для настольных компьютеров доля AMD в штучном выражении составила 19,8 % — это максимум со второго квартала 2022 года, а также близко к показателям середины 2020 года. В мобильном же сегменте дола AMD в штучном выражении составила 20,2 %, что также является максимумом с середины 2022 года.

Источник изображения: Tom's Hardware Как известно, прошлый год стал весьма тяжёлым для рынка ПК. Однако последние сведения из различных сегментов, например, от производителей памяти, дают понять, что рынок настроен оптимистично на 2024 год. Напомним, что текущий год должен стать годом ПК с искусственным интеллектом, кроме этого, подогреть интерес к покупке новых ПК обещает появление Windows 12. Если это произойдет, пользователи и бизнес будут заинтересованы в новых системах и процессорах со встроенными ИИ-движками. В серверном бизнесе AMD дела идут даже лучше, чем в клиентском, благодаря процессорам EPYC последнего поколения. AMD подчеркивает, что её доля доходов на рынке серверных CPU составляет 31,1%, что является рекордом для компании. За год доля компании в денежном выражении выросла на 4,0 п.п., что принесло рекордную прибыль в этом сегменте.

Источник изображения: Mercury Research В количественном выражении рост AMD в сегменте серверных процессоров оказался даже выше, чем в денежном — компания прибавила 5,5 п.п. по сравнению с четвёртым кварталом 2022 года. В итоге сейчас AMD занимает 23,1 % рынка. AMD подчеркивает, что небольшое снижение доли в четвёртом квартале по сравнению с третьим «отражает большее количество серверных процессоров наших конкурентов, продаваемых в приложениях, не связанных с центрами обработки данных, и более высокие поставки Atom». Неназванный конкурент — это, конечно же, Intel. Напомним, что 2023 год в целом был для Intel не очень удачным, но в последнем квартале года дела пошли на поправку. В отличие от AMD, её бизнес в области центров обработки данных сократился на 10 % по сравнению с предыдущим годом, что частично объясняется сокращением рынка в целом и корректировкой складских запасов. Северный браузерный ИИ: Opera развернёт в исландском дата-центре atNorth кластер NVIDIA DGX SuperPOD для обучения чат-бота Aria

07.02.2024 [22:31],

Владимир Мироненко

Норвежская компания Opera Software, разработчик браузера Opera, объявила о предстоящем запуске в этом месяце ИИ-кластера на базе NVIDIA DGX SuperPOD в дата-центре atNorth в Кеблавике (Исландия). Принадлежащий atNorth ЦОД ICE02 ёмкостью более 80 МВт имеет площадь 13 750 м2 и вмещает около 3000 стоек. С помощью нового кластера Opera будет обучать встроенный в браузер чат-бот Aria на основе ИИ. Как сообщается в пресс-релизе ИИ-кластер спроектирован так, чтобы оказывать минимально возможное воздействие на окружающую среду. Он использует гидроэлектрическую и геотермальную энергию для получения энергии, и пользуется преимуществами прохладного климата Исландии для охлаждения оборудования. Кластер на базе NVIDIA DGX SuperPOD оснащён ускорителями NVIDIA H100 и программной платформой NVIDIA AI Enterprise. «Aria быстро развивается, и мы продолжаем расширять его возможности в качестве помощника в навигации для наших пользователей», — сообщил Кристиан Зубель (Krystian Zubel), вице-президент ИТ-группы компании Opera. Как отметил представитель NVIDIA Карло Руис (Carlo Ruiz), компаниям, модернизирующим свой бизнес с помощью ИИ, требуется мощная инфраструктура для разработки больших языковых моделей (LLM) и создания приложений генеративного ИИ. «NVIDIA DGX SuperPOD с ускорителями NVIDIA H100 предоставляет Opera расширенные возможности супервычислений на базе ИИ, помогая разработчикам создавать новые функции, которые сделают опыт генеративного ИИ доступным для пользователей», — заявил он. Похожий на «Звезду смерти» спутник Сатурна заподозрен в сокрытии океана под своей поверхностью

07.02.2024 [22:12],

Геннадий Детинич

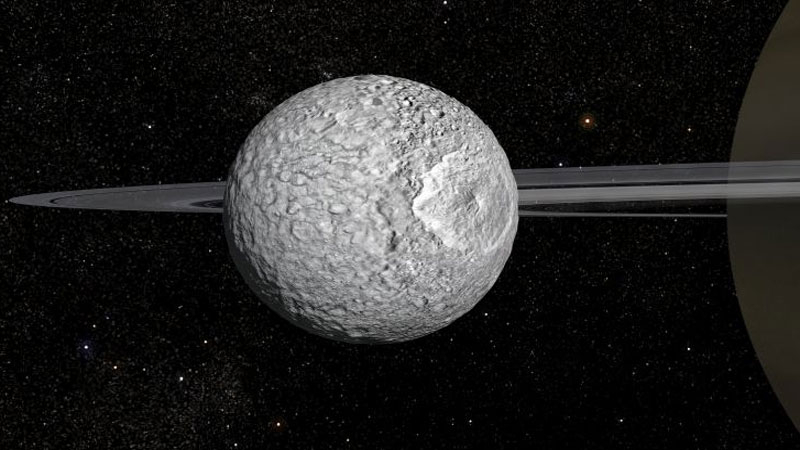

В сравнении с другими крупными лунами Сатурна (и Юпитера) спутник Мимас не изобилует трещинами и разрывами, напоминая своими кратерами нашу Луну. Тем самым, это должен быть сухой мир из скальных пород, однако дело, похоже, обстоит иначе. У Мимаса странная орбита, как будто у него внутри что-то плещется, или его ядро имеет необычно вытянутую форму. Как показало моделирование, всё говорит в пользу скрытого океана, и это находка для учёных.

Художественное представление спутника Сатурна Мимаса. Источник изображения: Observatoire de Paris Подробные данные по системе Сатурна собрала автоматическая станция «Кассини» в период с 2004 по 2017 годы. Группа учёных из Парижской обсерватории воспользовалась этой информацией, чтобы заново оценить орбитальные параметры Мимаса, который напоминает «Звезду смерти» благодаря огромному ударному кратеру на своей поверхности. Они хотели исключить один из сценариев, из-за которого орбита этой луны выглядит необычно для монолитного скалистого небесного тела. Согласно одному из вариантов, Мимас может содержать сильно вытянутое ядро, которое заставляет его совершать колебательные движения, проходя по орбите. Во втором случае, под его скалистой поверхностью может скрываться глобальный водный мир, потоки которого также вызывают изменения в орбитальном движении спутника. Моделирование показало, что существование вытянутого ядра представляется наименее вероятным сценарием. С учётом динамики орбитального движения Мимаса под воздействием гравитации Сатурна и других его крупнейших лун, орбитальные параметры подозрительной луны, скорее всего, объясняются жидким подповерхностным океаном. Расчёты показывают, что жидкий океан на Мимасе сравнительно молодой — ему всего 2–3 млн лет. Вероятнее всего, незадолго до его появления орбита этой луны изменилась со стабильной круговой на вытянутую, что в системе с множеством лун считается нормальным явлением. Гравитация Сатурна стала оказывать на недра Мимаса прерывистое воздействие, и это привело к гравитационному разогреву его ядра и внутренней структуры. Вода начала выделяться в жидком виде и постепенно там образовался глобальный подповерхностный океан, который к настоящему моменту подошёл к поверхности Мимаса на 20–30 км.

По часовой стрелке слева вверху: Энцелад, Европа, Ганимед и Титан. В центре — Мимас. Источник изображения: Observatoire de Paris По внешнему виду этой луны не скажешь, что под её корой плещутся массы воды, намного больше, чем в земных океанах. На Мимасе нет трещин и гейзеров, как на лунах Энцеладе, Европе, Ганимеде и Титане, поэтому он долго хранил свою тайну. Не менее важно, что если там действительно есть глобальный океан, то его молодость — это способ заглянуть в прошлое других лун Сатурна и Юпитера, чтобы понять эволюционное развитие подповерхностных водных миров. На глазах учёных буквально может твориться ранняя геологическая история этих миров, чему учёные несказанно рады. Злодей из Suicide Squad: Kill the Justice League проговорился, какого персонажа добавят в игру после Джокера

07.02.2024 [22:08],

Дмитрий Рудь

Rocksteady Studios уже раскрыла, что со стартом первого сезона в марте добавит в Suicide Squad: Kill the Justice League шутника Джокера, но остальных пострелизных персонажей пока держит в секрете. Завесу тайны помог приоткрыть главный злодей игры Брейниак. На протяжении первого года поддержки Suicide Squad: Kill the Justice League получит четырёх новых персонажей, и благодаря сработавшей по ошибке строчке диалога Брейниака можно узнать, кто станет следующим дополнительным персонажем в игре после Джокера. Пользователь форума Reddit под псевдонимом ZeronityPlays на днях опубликовал короткий геймплейный ролик из Suicide Squad: Kill the Justice League, в котором его нокаутированную Харли Квинн пытается ещё больше принизить Брейниак: «Не ожидал, что слабым звеном окажешься ты, Фриз». Am I crazy or did Brainiac just call me Freeze Похоже, известный по серии Batman: Arkham злодей мистер Фриз (настоящее имя Виктор Фрис) или, по крайней мере, его альтернативная версия — как повелось в Kill the Justice League — на подходе. Датамайнер mmmmmmmmiller утверждал, что речь идёт о женской вариации персонажа — Виктории Фрис. Suicide Squad: Kill the Justice League вышла 2 февраля на PC (Steam, EGS), PS5, Xbox Series X и S. Игра получила смешанные оценки в профильной прессе (59−65 % на Metacritic). Отзывы в Steam пока «очень положительные», но пиковый онлайн не достиг и 13,5 тыс. человек. AMD FSR 3 и Intel XeSS наконец добрались до Starfield, но пока только в «бете»

07.02.2024 [21:40],

Дмитрий Рудь

Спустя четыре месяца после релиза FSR 3 космическая ролевая игра Starfield от Bethesda Game Studios получила поддержку новейшей версии масштабирования от AMD, но пока лишь в рамках бета-тестирования. Вышедшая 7 февраля в Steam бета-версия обновления 1.9.67 добавила в Starfield поддержку AMD FSR 3, которая включает не только масштабирование изображения, но и (вслед за DLSS 3 от NVIDIA) генерацию кадров. Bethesda передаёт, что AMD FSR 3 работает на широком спектре видеокарт (даже GeForce GTX 10-й серии, судя по всему) и советует использовать технологию с включённой вертикальной синхронизацией и VRR-монитором. Вдобавок бета-версия обновления включает поддержку ещё одной технологии масштабирования — Intel Xe Super Sampling (XeSS). Вместе с AMD FSR 3 её можно найти и активировать в настройках графики игры. Кроме того, патч содержит изменения идентификаторов формы FormID (параметр объектов в игре), что должно повысить стабильность сохранений с большим числом посещённых локаций. Разработчики также исправили «вибрирующие» облака и сброс масштабирования разрешения при переходе от полноэкранного режима к оконному во время использования DLSS и внесли ряд мелких улучшений. Starfield вышла в сентябре 2023 года на PC (Steam, Microsoft Store), Xbox Series X, S и в Game Pass. На протяжении 2024-го в игру планируют добавить карты городов, новые способы перемещения и поддержку модификаций. Серверы и сети: Cisco и NVIDIA расширили сотрудничество, чтобы упростить клиентам развёртывание ИИ-инфраструктуры

07.02.2024 [21:05],

Владимир Мироненко

Cisco и NVIDIA объявили о расширении сотрудничества, чтобы предложить корпоративным клиентам масштабируемое и автоматизированное управление кластерами искусственного интеллекта (ИИ), автоматическое устранение неполадок, высокое качество обслуживания и многое другое, сообщается в пресс-релизе NVIDIA. Интегрированное ПО и сетевое оборудование двух компаний упростит клиентам развёртывание инфраструктуры для поддержки приложений ИИ. Соглашение предусматривает расширение роли сетей Ethernet в обработке рабочих нагрузок ИИ на предприятии, а также обеспечивает компаниям доступ к системам продаж друг друга и возможность взаимной поддержки.

Источник изображения: NVIDIA Специализированные сетевые решения Cisco и NVIDIA на базе Ethernet будут продаваться через обширный глобальный канал Cisco, предлагая профессиональные услуги и поддержку через ключевых партнёров. Клиентам будут доступны новейшие ускорители NVIDIA в стоечных и блейд-серверах Cisco M7 UCS, включая Cisco UCS X-Series и UCS X-Series Direct, для поддержки ИИ и рабочих нагрузок с интенсивным использованием данных в ЦОД и на периферии. Интегрированный пакет, который станет доступен во II квартале, будет включать ПО NVIDIA AI Enterprise с программными платформами, предварительно обученными моделями и инструментами разработки. Совместно проверенные эталонные архитектуры Cisco Validated Designs (CVD) упростят развёртывание и управление кластерами ИИ в любом масштабе в широком спектре вариантов использования: виртуализированные и контейнерные среды, конвергентные и гиперконвергентные системы. CVD для FlexPod и FlashStack для генеративного ИИ с ПО NVIDIA AI Enterprise будут доступны в этом месяце. Cisco упростила управление и эксплуатацию ИИ-инфраструктуры за счёт локального и облачного управления посредством Cisco Nexus Dashboard и Cisco Intersight. А поддержка Cisco ThousandEyes Digital Experience Monitoring поможет обеспечить аналитику на основе ИИ и автоматическое устранение проблем в сетях. Наконец, расширяемая платформа Cisco Observability Platform использует ИИ для контекстуализации и корреляции телеметрии в реальном времени. Как отметил ресурс Network World, NVIDIA внедрила множество реализаций ИИ, основанных на сети InfiniBand. Теперь компания также участвует в отраслевых усилиях по обеспечению того, чтобы Ethernet стал важнейшей основой для поддерживающих ИИ сетей в будущем. В частности, прошлой осенью компания, наконец, представила SuperNIC — 400GbE DPU для ИИ-нагрузок. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |