|

Опрос

|

реклама

Быстрый переход

«Пожалуйста, просто остановитесь»: трейлер Suicide Squad: Kill the Justice League с живыми актёрами не склонил фанатов на сторону игры

26.01.2024 [21:14],

Дмитрий Рудь

До релиза кооперативного экшена Suicide Squad: Kill the Justice League от Rocksteady Studios остаётся всего несколько дней, и издатель Warner Bros. Games решил подогреть интерес к игре трейлером с живыми актёрами. Напомним, в Kill the Justice League пресловутому Отряду самоубийц в лице Харли Квинн, Дэдшота, Капитана Бумеранга и Короля Акул предстоит спасти мир от Лиги Справедливости, членов которой контролирует суперзлодей Брейниак. В ролике антигероев играют реальные актёры: роль Дэдшота досталась Уиллу Арнетту (Will Arnett) — Бэтмену из LEGO-фильмов, — а Харли Квинн на себя взял Рон Фанчес (Ron Funches), который в мультсериале «Харли Квинн» озвучивал Короля Акул. На протяжении минуты персонажи шутят на тему комплекции Арнетта, отстрела голубей и отсутствия плана действий, а потом прибывает Лига Справедливости. Чем заканчивается ролик, смотрите сами. Игроки встретили трейлер Suicide Squad: Kill the Justice League с живыми актёрами неоднозначно: под роликом на канале Warner Bros. Games лайков и дизлайков примерно поровну, а под видео от IGN доминируют негативные оценки. В комментариях царят пессимистические настроения. Актёры делу не помогли, а шутки многим показались неудачными. «Пожалуйста, просто остановитесь. Словами не передать, до чего кринжово это было», — призвал Hartfox. Suicide Squad: Kill the Justice League выйдет уже 2 февраля на PC (Steam, EGS), PS5, Xbox Series X и S. Предзаказавшие расширенное издание получат доступ к игре на 72 часа раньше. До релиза обзоров, судя по всему, ждать не стоит. «Юнона» засекла признаки поверхностной активности на Европе, спутнике Юпитера

26.01.2024 [19:35],

Геннадий Детинич

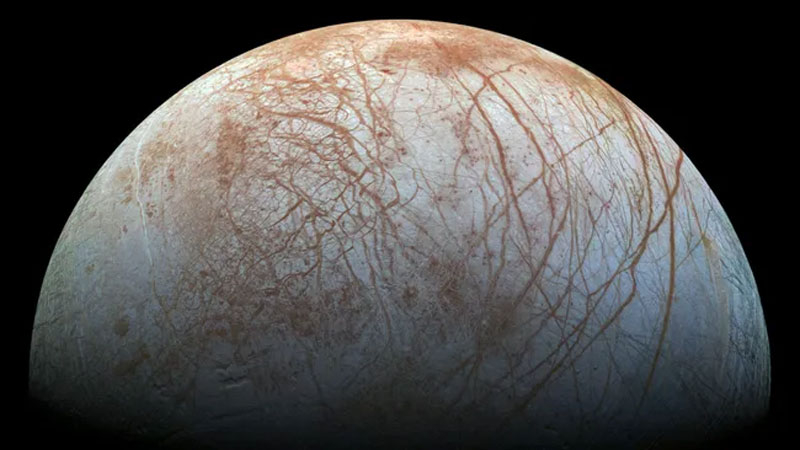

С большой вероятностью ледяные спутники Юпитера и в частности Европа имеют глубочайшие подповерхностные океаны. На каждом из этих небольших небесных тел может быть многократно больше воды, чем на всей Земле. Тем любопытней искать признаки выхода этой воды на поверхность в виде гейзеров и через трещины, чтобы когда-нибудь проникнуть под толщу льда этих лун Юпитера в поисках жизни.

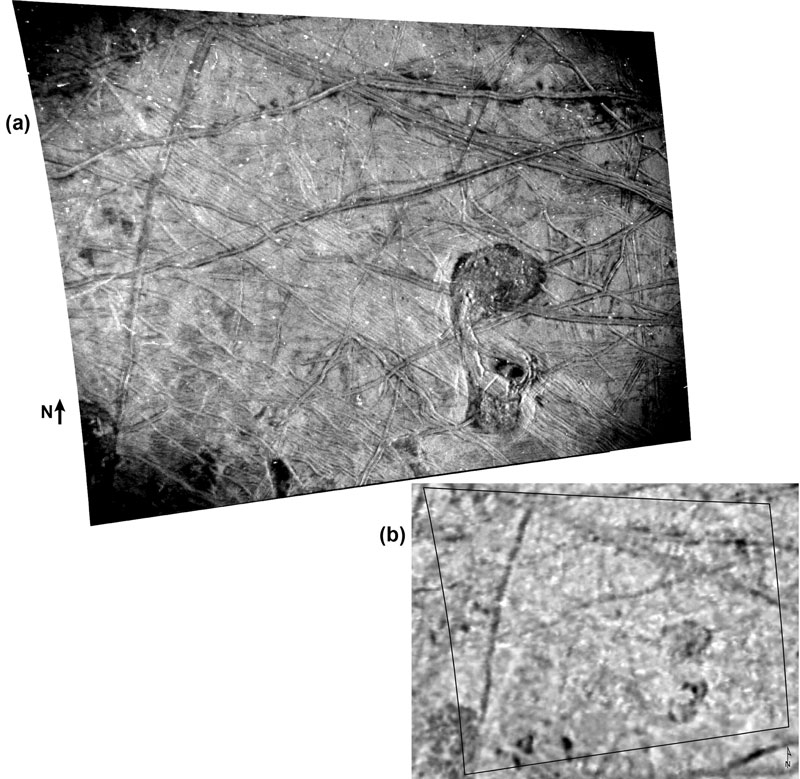

Источник изображения: NASA/JPL-Caltech/SETI Institute Некоторое время назад группа учёных опубликовала в журнале JGR Planets статью, в которой сообщила об обнаружении признаков поверхностной активности на спутнике Юпитера Европе при сравнении снимков одного из участков, сделанных с интервалом где-то в 20 лет или больше. Первый снимок был получен зондом NASA Galileo, который изучал систему Юпитера с 1993 года по 2003, а второй сделан в 2022 году другим зондом NASA — Juno. Учёные заинтересовались сравнением двух изображений области размером 37 × 67 км, которую назвали «утконосом». С некоторой долей уверенности исследователи заявили, что в некоторых аспектах рисунок поверхности на верхнем снимке, сделанном «Юноной», отличается от рисунка, изображённого на нижнем снимке, сделанным «Галилео».

Верхний снимок сделан звёздной навигационной камерой «Юноны», а нижний — камерой «Галилео» (нажмите для увеличения) Данная область поверхности Европы может стать отправной точкой для будущих исследований лун Юпитера космическими аппаратами NASA Europa Clipper и ESA JUICE. Станция JUICE уже на пути в систему Юпитера и прибудет туда в декабре 2031 года, а станция Europa Clipper должна отправиться в космос на ракете Falcon Heavy 6 октября этого года. Египетская сила: для «Русы против ящеров» вышло крупное обновление с кооперативом на пятерых и миссией в Африке

26.01.2024 [19:28],

Дмитрий Рудь

Создатели псевдоисторического экшена «Русы против ящеров» из российской студии the Bratans подготовили для фанатов приятный сюрприз: заявленное на начало февраля крупное обновление для игры доступно уже сейчас. Как и было обещано, главным нововведением патча стал онлайновый кооператив. На анонсе неделю назад разработчики говорили о поддержке четырёх человек, а к релизу их число увеличилось до пяти. Контентное обновление также добавило в игру карту «Африка», на которой богатырям предстоит очистить египетские пирамиды от ящеров. Обещают новые виды рептилий, дополнительный тип врагов и уникального мини-босса. Кроме того, патч включает бесплатного персонажа — мастера двуручной палицы Мстислава Дуболюба, — два новых достижения и исправления множества багов (в частности, касающихся возможностей ящеров и инопланетян). Наконец, вместе с обновлением в продажу для «Русы против ящеров» поступило платное дополнение с Виктором — мощным и безжалостным адептом копья и щита. Доступен в Steam за 25 рублей (скидка 40 % до 2 февраля). Обновление и платное дополнение для «Русы против ящеров» пока доступны только в сервисе цифровой дистрибуции Steam. Когда новый контент доберётся до VK Play, на данном этапе не уточняется. «Русы против ящеров» вышла в сентябре 2023 года и доступна в Steam (скидка 46 % до 9 февраля) и VK Play. Игра вошла в топ-20 самых высокооценённых игр Steam за 2023 год, согласно алгоритмам портала SteamDB. Realme 12 Pro получит процессор Snapdragon 6 Gen 1 и камеру на совершенно новом сенсоре Sony

26.01.2024 [19:21],

Владимир Мироненко

На следующей неделе, 29 января, компания Realme проведёт презентацию смартфонов Realme 12 Pro и Realme 12 Pro+. В преддверии мероприятия производитель раскрыл новые подробности о младшей из грядущих новинок.

Источник изображений: GSMArena.com Realme сообщила, что модель 12 Pro получит камеру на базе сенсора Sony IMX882 с оптической стабилизацией изображения. Этот сенсор ещё не был анонсирован, и похоже Realme 12 Pro станет первым смартфоном, который будет оснащён камерой на его базе. Как полагают инсайдер, это сенсор может быть переименованной версией сенсора LYT-600, который используется, например, в камере Oppo Reno11 5G. Ранее стало известно, что у Realme 12 Pro+ будет камера с сенсором Sony IMX890.  Согласно сообщению Realme в социальной сети X основная камера смартфона будет иметь сенсор на 50 Мп и «совершит революцию» в фотосъемке. Судя по рендерам Realme 12 Pro, у него будет три камеры, но перископического объектива мы тут не увидим. Также сообщается, что у камеры смартфона будет 20-кратный зум, что на деле может означать наличие телеобъектива с двухкратным увеличением и 10-кратный цифровым зумом. На сайте компании указано, что Realme 12 Pro оснащён восьмиядерным 4-нм процессором Snapdragon 6 Gen 1. Компания Realme показала в январе на выставке CES 2024 в Лас-Вегасе Realme 12 Pro+, представив его как первый смартфон среднего уровня, получивший перископическую камеру. Все остальные подробности о новинках станут известны 29 января. Мобильное приложение Microsoft Xbox получит сенсорный контроллер

26.01.2024 [18:35],

Павел Котов

На этой неделе Microsoft начала тестировать сенсорный контроллер в бета-версии приложения Xbox для Android и iOS, которое позволяет удалённо подключаться к приставке и играть на смартфоне или планшете. Прежде для этого необходимо было подключить Bluetooth-геймпад, сообщает The Verge.

Источник изображения: theverge.com Сенсорное управление идентично тому, что используется в службе Xbox Cloud Gaming — элементы управления накладываются на экран, а пользователь обладает возможностью перемещаться по интерфейсу консоли и транслировать игры, не подключая дополнительных устройств. Играть с внешним контроллером, конечно, намного удобнее, но и возможность отказаться от него трудно переоценить. Пару лет назад Microsoft установила, что 20 % пользователей Xbox Cloud Gaming обходятся только сенсорным управлением. После этого компания добавила сенсорные элементы в сотни игр для Xbox — особенно популярными они оказались в Hades, Minecraft Dungeons и Yakuza: Like a Dragon. Сенсорное управление Xbox есть также на двухэкранном телефоне Surface Duo, который становится похож на Nintendo 3DS с играми для «больших» приставок. Но аудитория владельцев Surface Duo очень невелика, и теперь эта возможность откроется для пользователей миллионов устройств под Android и iOS. К слову, Apple открыла iOS для облачных игр по всему миру, и скоро Xbox Cloud Gaming появится на iPhone. Разработчики «Смуты» показали полторы минуты прогулки по Нижнему Новгороду и пообещали «большие новости»

26.01.2024 [18:30],

Дмитрий Рудь

Разработчики исторического ролевого экшена «Смута» из студии Cyberia Nova в преддверии полноценной демонстрации игрового процесса представили новый геймплейный тизер проекта. В полутораминутном ролике, озаглавленном «Нижегородская командировка Юрия», главный герой «Смуты» — дворянин Юрий Милославский — отправляется в прогулку по Нижнему Новгороду. За отведённый хронометраж протагонист успевает пройти по пристани и выйти к стенам местного посада. На пути персонаж встречает лишь общающихся между собой или занимающихся своими делами NPC. Так как никакого экшена в ролике нет, зрители поневоле начали присматриваться к техническому исполнению, и к нему у пользователей в комментариях возникли вопросы. Например, игроки подметили, что в видео «Смута» подтормаживает, факелы имеют неправильно настроенную цветовую гамму, текстуры местами прогружаются на глазах, а камера не отличается плавностью. В сопровождавшем геймплейный тизер сообщении разработчики обмолвились, что из нижегородской командировки Милославский вернётся в понедельник (29 января) с «большими новостями». Вероятно, речь о неком анонсе. Релиз «Смуты» ожидается 26 февраля в VK Play, где игра будет продаваться за 2015 рублей (1612 рублей по предзаказу). На февраль также запланирована вторая часть показа геймплея — дневник разработки, посвящённый боевой системе. PayPal решила вдохнуть новую жизнь в платёжную систему при помощи ИИ

26.01.2024 [18:27],

Сергей Сурабекянц

Новый генеральный директор PayPal Алекс Крисс (Alex Chriss) заявил, что компания в этом году развернёт платформу на базе ИИ, которая позволит продавцам привлекать новых клиентов на основе их предыдущей истории покупок, используя данные торговых транзакций на общую сумму примерно в полтриллиона долларов по всему миру. Компания также запускает функцию оплаты в один клик.

Источник изображения: unsplash.com Это первое крупное программное заявление Крисса, который приступил к работе в PayPal в сентябре 2023 года. Представленные им новые продукты на основе нейросети являются ещё одним примером того, как компании пытаются использовать энтузиазм инвесторов в отношении ИИ, который помог фондовым рынкам США достичь рекордных высот в этом месяце. Индекс S&P 500 поднялся до четвёртого рекордного максимума на закрытии торгов в среду, отчасти именно благодаря ралли акций технологических компаний на фоне всеобщего оптимизма в отношении ИИ. Эксперты надеются, что Крисс, который ранее был старшим руководителем компании-разработчика программного обеспечения Intuit, откроет новую страницу в истории PayPal и «оживит» акции компании, которые упали более чем на 22 % по сравнению с январём 2023 года из-за низкой рентабельности, не впечатлившей инвесторов. Крисс назвал 2024 год «переходным» для PayPal и пообещал существенно увеличить прибыльность компании. Продавцы смогут использовать отдельный инструмент на базе нейросети под названием «умные квитанции», чтобы рекомендовать покупателям персонализированные товары в квитанциях по электронной почте, а также начислять кэшбэк. PayPal представляет функцию оплаты «в один клик» под названием Fastlane, которая на ранних этапах тестирования увеличила скорость оплаты почти на 40 %, а также новые возможности для бизнес-профилей Venmo, сообщила компания. «Результаты инноваций… многообещающие и должны улучшить качество обслуживания потребителей и продавцов, — заявил аналитик BTIG Эндрю Харт (Andrew Harte). — Тем не менее, мы думаем, что инвесторы будут рассматривать какую-либо из них не как новаторскую информацию, а, скорее, как инициативы, над которыми, как они ожидали, компания уже работает». «Данные, которыми мы располагаем, и наша способность реально видеть, что покупают люди, и знать, на что пытаются ориентироваться продавцы, — вот где ИИ является огромной возможностью для нас», — заявил Крисс. Акции PayPal на последних торгах упали на 4,6 %, поскольку, кроме новостей от руководителя, инвесторы ждут реальных изменений от компании. Возможно, ситуация изменится уже 7 февраля, когда PayPal отчитается о результатах деятельности за четвёртый квартал. «Хаббл» обнаружил водяной пар на горячей экзопланете

26.01.2024 [18:26],

Павел Котов

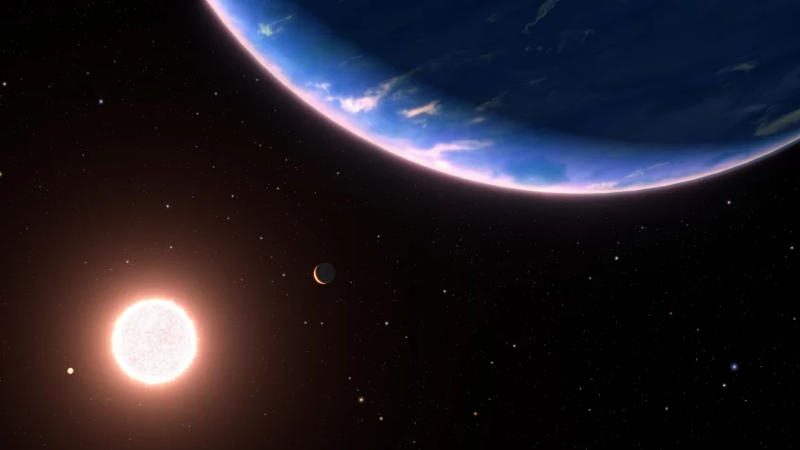

Учёные Института Макса Планка (Германия) при помощи космического телескопа «Хаббл» (Hubble) обнаружили, что атмосфера относительно небольшой планеты GJ 9827d в другой звёздной системе богата водяным паром. Но радоваться преждевременно: её поверхность достаточно горяча, чтобы расплавить свинец, а значит, этот мир непригоден для жизни в том виде, в котором мы её знаем.

Источник изображения: mpia.de Температура на поверхности экзопланеты GJ 9827d сравнима с температурой на Венере — около 400 °C, но это всё равно захватывающее открытие. Дело в том, что это самая маленькая из открытых экзопланет, где была обнаружена вода. А значит, учёные ближе чем когда-либо подобрались к описанию миров, похожих на Землю. GJ 9827d примерно вдвое крупнее Земли, а вращается планета вокруг звезды GJ 9827, которая находится на расстоянии 97 световых лет от нас и наблюдается в созвездии Рыб. Эта планета — лишь один из похожих на Землю миров, вращающихся вокруг этой звезды, а её возраст составляет около 6 млрд лет. «Хаббл» наблюдал GJ 9827d в течение трёх лет, и за это время планета прошла по диску своей звезды 11 раз. Её состав оценили при помощи спектрального анализа, но у учёных пока нет ясности, составляет ли водный пар небольшую долю в богатой водородом атмосфере, или её атмосфера, напротив, преимущественно состоит из воды. За 6 млрд лет поблизости от родительской звезды водород мог выпариться из атмосферы, оставив её с водяным паром — эта гипотеза подтверждается тем, что вблизи GJ 9827d обнаружить водород не удалось. В противном случае это мини-нептун, то есть уменьшенная и горячая версия расположенного в Солнечной системе ледяного гиганта с плотной атмосферой из водорода и гелия. Или планета может напоминать увеличенную и, опять же, горячую версию Европы — спутника Юпитера, который, как предполагается, под толстой ледяной коркой скрывает в два раза больше воды, чем Земля. Если же GJ 9827d обладает плотной атмосферой из водяного пара, то значит, что планета родилась дальше от своей звезды, где температура ниже, но впоследствии мигрировала к своей текущей позиции. В результате GJ 9827d подверглась сильному излучению своей звезды, которое превратило её лёд в жидкую воду и в водяной пар. Водород при таких условиях нагрелся бы и начал утекать из атмосферы из-за относительно невысокой гравитации планеты — возможно, эта утечка происходит до сих пор. Теперь GJ 9827d станет предметом изучения для более мощного космического телескопа «Джеймс Уэбб» (JWST). ЕС пригрозил Apple решительными мерами, если изменения в App Store и iOS окажутся недостаточными

26.01.2024 [18:14],

Сергей Сурабекянц

В соответствии с новым Законом о цифровых рынках (DMA) Apple должна дать разработчикам программного обеспечения возможность распространять приложения для устройств Apple через альтернативные магазины. Эксперты утверждают, что структура комиссий Apple остаётся несправедливой, и изменения в её политике могут не соответствовать DMA. Официальные лица ЕС угрожают Apple «решительными мерами, если предложенные решения окажутся недостаточно хорошими».  С начала марта разработчики, в соответствии с DMA, смогут предлагать своим пользователям альтернативные магазины приложений на iPhone, отказаться от использования платёжной системы Apple, а также избежать комиссии до 30 %. Пользователи устройств Apple в ЕС также смогут выбирать веб-обозреватели по умолчанию и совершать бесконтактные платежи без использования системы Apple Pay. Но даже если разработчики решат не использовать App Store или платёжную систему Apple, они все равно будут вынуждены платить Apple «за основную технологию» 50 евроцентов за каждую новую установку в течении года, если количество установок перевалит за 1 млн. Компании с миллионами бесплатных пользователей, такие как Meta✴✴ и Spotify, скорее всего, пострадают больше, чем мелкие разработчики. Также, в соответствии с обновлённой политикой Apple в ЕС разработчикам по-прежнему придётся отправлять приложения в Apple для проверки на предмет рисков кибербезопасности и очевидного мошенничества. Генеральный директор альтернативного магазина приложений Aptoide Пауло Трезентос (Paulo Trezentos) заявил: «Для нас это стало неожиданностью. До нас доходили слухи о грядущих изменениях, но мы не ожидали, что они будут настолько основательными. Это определённо хороший шаг, но сборы по-прежнему слишком высоки. Мы готовимся направить официальный отзыв в Европейскую комиссию». Руководитель отрасли ЕС Тьерри Бретон (Thierry Breton) прокомментировал ситуацию агентству Reuters: «DMA откроет ворота интернета для конкуренции, чтобы цифровые рынки были справедливыми и открытыми. Изменения уже происходят. С 7 марта мы будем оценивать предложения компаний на основании отзывов третьих лиц. […] Если предложенные решения окажутся недостаточно хорошими, мы без колебаний предпримем решительные действия». Представитель Еврокомиссии сообщил, что регулятор будет внимательно следить за действиями и заявлениями Apple вплоть до наступления крайнего срока соблюдения требований 7 марта. Еврокомиссия не будет давать комментариев по этому поводу, но настоятельно рекомендует ответственным лицам Apple сверять свои предложения с заинтересованными сторонами. Intel удвоит ИИ-производительность процессоров Panther Lake относительно Lunar Lake

26.01.2024 [18:09],

Николай Хижняк

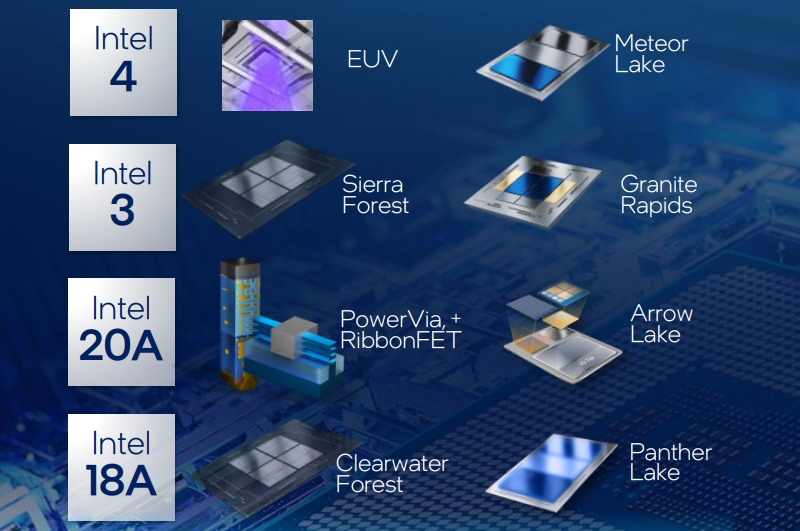

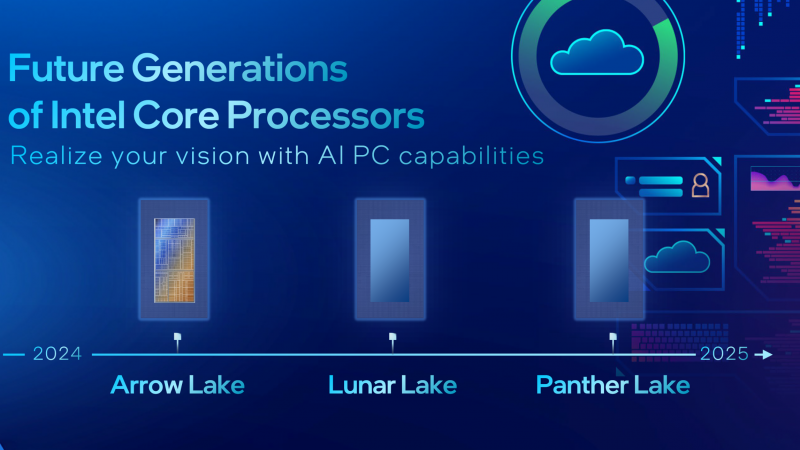

В рамках последнего финансового отчёта глава Intel Пэт Гелсингер (Pat Gelsinger) рассказал, что в этом году компания расширит платформу Core Ultra процессорами Arrow Lake и Lunar Lake. Их ИИ-производительность вырастет до трёх раз по сравнению с нынешними Meteor Lake. В следующем году компания в сегментах настольных ПК и ноутбуков представит серию процессоров Panther Lake, которые будут обладать ещё вдвое большей ИИ-производительностью по сравнению с предшественниками.

Источник изображений: Intel «Платформа Core Ultra обеспечивает нам лидерство в задачах, связанных с ИИ [в потребительском сегменте]. С запуском платформ нового поколения Lunar Lake и Arrow Lake в этом году мы удвоим отрыв от конкурентов. В 2025 году новые процессоры Panther Lake обеспечат дополнительное двукратное увеличение ИИ-производительности», — заявил Гелсингер. В рамках встречи с инвесторами глава Intel также затронул вопрос подготовки фирменного технологического процесса 18A для производства чипов. Он придёт на смену техпроцессу 20A, который будет использоваться в потребительских процессорах Arrow Lake. Гелсингер также напомнил, что серверные процессоры Xeon Granite Rapids и Sierra Forest появятся на рынке во второй половине этого года.  Новый техпроцесс 18A будет использоваться в будущих процессорах Clearwater Forest. По словам Гелсингера, разработка этих чипов уже завершена и скоро начнётся их производство. Указанные процессоры будут предназначены для ЦОД и предложат до 288 вычислительных ядер. В них будут применяться только энергоэффективные ядра нового поколения с кодовым названием Darkmont. «Мы первые в индустрии объединили в одном техпроцессе технологии GAA-транзисторов и подачи питания с обратной стороны кристалла. Вторая технология появится у наших ближайших конкурентов не ранее чем через два года. Чипы Arrow Lake станут ключевым продуктом на нашем технологическом процессе Intel 20A в этом году. Готовность техпроцесса Intel 18A к использованию в производстве ожидается во второй половине 2024 года. Я рад сообщить, что чипы Clearwater Forest, наши первые процессоры на базе Intel 18A для серверов, также готовы для производства. Скоро завершится разработка потребительских чипов Panther Lake», — добавил Гелсингер. Тут же добавим, что Intel связывает большие надежды с техпроцессом 18A не только в личных целях, но также и в качестве передового техпроцесса, который сможет предложить в качестве контрактного производителя сторонним разработчикам чипов. Компания отметила, что в 2023 году добилась успехов в создании экосистемы контрактного производства, заключив более 40 соглашений о сфере услуг по разработке и производству чипов, в том числе с военными США и аэрокосмической отраслью. «В четвёртом квартале мы выпустили набор инструментов для разработки чипов под Intel 18A версии 0.9, и расширили его доступность. Мы значительно расширили программу RAMP-C и только в этом квартале подписали крупный контракт на контрактное производство с правительством США и Министерством обороны», — отметила компания. Компания собирается провести 21 февраля мероприятие IFS Direct Connect 2024, на котором более подробно расскажет о своей дорожной карте будущих продуктов. В рамках финансового отчёта также была затронута тема будущих специализированных ИИ-ускорителей Gaudi 3. Они ожидаются в этом году и обещают четырёхкратный прирост производительности и вдвое более высокую пропускную способность по сравнению с предшественниками. Компания также продолжает разработку специализированных ускорителей Falcon Shores. «Мы продолжим освоение рынка ИИ с новыми ускорителями Gaudi 3, которые планируем выпустить в этом году. Мы ожидаем от них четырёхкратный прирост производительности и вдвое более высокую пропускную способность по сравнению с предшественниками. Сейчас мы тестируем их в лабораториях. Они действительно показывают отличный уровень быстродействия. Разработка Falcon Shores также продолжается», — заявил глава Intel. Авторы боевика Outcast — A New Beginning показали трейлер с красочными локациями, опубликовали системные требования и открыли предзаказы

26.01.2024 [18:00],

Юлия Позднякова

Разработчики из бельгийской студии Appeal представили новый трейлер приключенческого экшена Outcast — A New Beginning, а также раскрыли системные требования и объявили о начале приёма предзаказов.

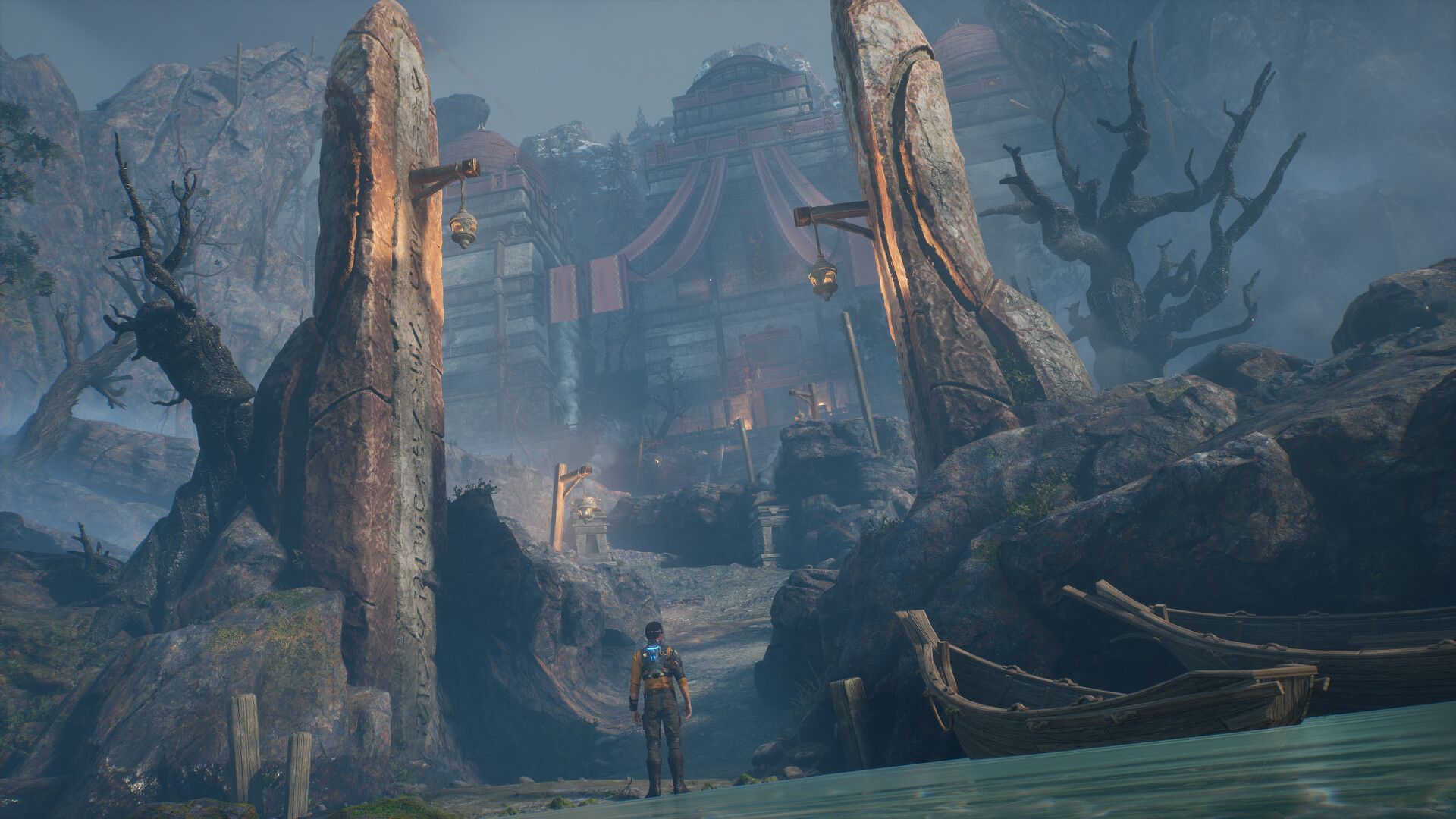

Источник изображений: Steam В ролике демонстрируются красочные локации в поселении жителей планеты Адельфа (Adelpha) и открытом мире, а также NPC, с которыми предстоит общаться герою, и фрагменты второстепенных квестов. В поселениях племени талан (Talan) игроки будут помогать жителям рыбачить, оглушая крупную рыбу во время полётов на ракетном ранце. Также они посетят загадочный храм и поучаствуют в воздушных гонках. Системные требования были опубликованы без указания разрешения и кадровой частоты, на которую могут рассчитывать пользователи. Минимальные системные требования:

Рекомендованные системные требования:

Одновременно открылись предварительные заказы. Компьютерную версию оценили в $60, а за консольные придётся отдать $70. За раннюю покупку предоставляется бонус в виде 17-процентной скидки. В российском сегменте Steam цена с учётом данного предложения составляет 2058,4 руб. Outcast — A New Beginning — сиквел приключенческого экшена Outcast 1999 года от той же команды разработчиков. События второй части развернутся на знакомой планете, где продолжается борьба роботов-захватчиков и местных жителей. Главный герой серии, бывший «морской котик» Каттер Слейд (Cutter Slade), вернётся спустя 20 лет, чтобы освободить индейцев и помочь им восстановить деревни и природу.  Как и в оригинале, игроки смогут исследовать полноценный открытый мир. История нелинейная — квесты позволят выполнять в любом порядке. Боевая система построена на комбинировании модулей для пистолета (всего их более 30), меняющих его особенности и открывающих новые боевые стили. Кроме того, герой будет использовать щит (предназначенный не только для обороны, но и для атаки) и умения талан вроде антигравитации и призыва существ, которые можно получить за выполнение заданий. Outcast — A New Beginning выйдет 15 марта на ПК (Steam), PlayStation 5, Xbox Series X и S. В декабре студия представила коллекционное издание Adelpha Edition c 24-сантиметровой фигуркой существа SAÏ, саундтреком на трёх дисках и 50-страничным альбомом иллюстраций. Подтверждён полный перевод на русский язык. В США придумали архитектуру для отказоустойчивого электроснабжения

26.01.2024 [17:51],

Геннадий Детинич

Отказоустойчивость интернета как сетевой инфраструктуры поражает, если не знать, что она разрабатывалась для сохранения связи в зонах ведения боевых действий. Нечто подобное американские учёные решили создать для сетей электроснабжения с упором на микросети на возобновляемых источниках энергии и системы накопления.

Источник изображения: ИИ-генерация Кандинский 3.0/3DNews Выбор микросетей на возобновляемых источниках энергии был очевиден — они не зависят от внешних поставок энергоресурсов для производства электрической энергии и даже в случае каких-либо аварий смогут работать локально. Поэтому главной задачей было создание архитектуры и протоколов для обхода или изоляции повреждений на линии и балансировки выдаваемой и потребляемой мощности. Также важным моментом стала защита от кибернетических атак, что сегодня вообще не должно вызывать вопросов. Сообщается, что поставленная задача в основном была решена группой исследователей из Сандийских национальных лабораторий (Sandia National Laboratories) — одной из 16 национальных лабораторий под управлением Министерства энергетики США. Они разработали протоколы и алгоритмы для управления микросетями, включая работу программируемых сетевых реле. Платформа по обеспечению отказоустойчивого энергоснабжения сама оценивает повреждения на линиях или оборудовании, а также вырабатываемую и потребляемую мощность. Она также может подключаться к общей сети электроснабжения, но в случае перегрузки будет управлять не возможностями инвертора, а начнёт отключать менее важных потребителей, например, частные домохозяйства, отдавая предпочтение больницам и другим критически важным структурам. Кроме того, протокол предусматривает разрывы нежелательных закольцовок, которые могут появиться при обрывах и восстановлении энергоснабжения. Интересно отметить, что разработать алгоритм реконфигурации сети электроснабжения помогло программное обеспечение для сферы автоматизированного проектирования. Представленные учёными алгоритмы на примере трёх небольших взаимосвязанных микросетей позволили локализовать неполадки, в том числе повреждённые поваленными деревьями линии электропередач и повреждения на электростанции, а затем восстановить электроснабжение основных объектов инфраструктуры. AMD похоронила мобильное приложение Link

26.01.2024 [17:40],

Владимир Фетисов

Компания AMD приняла решение о закрытии мобильного приложения AMD Link, которое позволяет владельцам компьютеров с видеокартами Radeon отслеживать параметры графической подсистемы, а также транслировать игровой процесс с ПК на мобильные устройства. Поддержка приложения будет прекращена уже в этом квартале вместе с выпуском пакета драйверов AMD Software: Adrenaline Edition.

Источник изображения: AMD «Для пользователей, которые играют удалённо с помощью AMD Link, важным объявлением является то, что AMD прекращает поддержку приложения AMD Link в будущем выпуске AMD Software: Adrenaline Edition. Мы запустили AMD Link в то время, когда для пользователей графики Radeon было мало альтернативных решений для удалённого гейминга. Сейчас пользователям доступно много вариантов потоковой передачи контента с ПК на другие устройства. В связи с этим мы прекращаем поддержку AMD Link и направляем свои ресурсы на развитие других возможностей и функций, которые приносят пользу пользователям. Мы продолжим поддерживать разработчиков с помощью наших SDK, таких как AMD Advanced Media Framework, которые позволят им интегрировать функции потокового вещания в свои решения», — говорится в сообщении AMD. Приложение AMD Link прекращает работу через год после того, как NVIDIA прекратила поддержку своего сервиса GameStream, с помощью которого пользователи могли осуществлять локальную потоковую передачу данных без необходимости использовать внешние сервисы. В отличие от NVIDIA, AMD пока не предложила никаких альтернатив. Наиболее очевидной альтернативой является сервис Steam Link, но это приложение ограничено поддержкой игр из Steam. Baidu заменит ИИ-технологии Google в китайских Samsung Galaxy S24

26.01.2024 [17:39],

Владимир Мироненко

Китайское подразделение Samsung и облачное подразделение китайского интернет-гиганта Baidu объявили о партнёрстве, благодаря которому смартфоны семейства Galaxy S24, поставляемые в Китай, будут оснащены ИИ-чат-ботом Ernie от Baidu. Он обеспечит расширенные возможности по работе с текстом, перевод телефонных разговоров в реальном времени и многие другие функции.

Источник изображений: Samsung Обновлённый ассистент Samsung Note Assistant на базе Ernie теперь предлагает перевод и обобщение текста, а также его форматирование в более подходящие форматы. Это позволяет быстро преобразовать контент в короткий и понятный текст одним нажатием кнопки. С помощью Ernie смартфоны серии Galaxy S24 смогут на лету преобразовывать речь в текст, определять, кто говорит, и переводить сказанное на целый ряд языков во время телефонных разговоров, что поможет устранить преграды в общении между носителями разных языков.  Функция «Обвести для поиска» (Circle to Search) позволит пользователям искать объекты в текстах, изображениях, аудио или видео, используя простые жесты. Она будет работать вместе с поиском Baidu Search, обеспечивая быстрые и точные результаты поиска, не покидая приложение. Чэнь Ифань (Chen Yifan), вице-президент Baidu, пообещал, что в будущем бот Ernie будет использоваться более широко. Он отметил, что Ernie действительно хорош в работе с различными типами данных, такими как текст, изображения, звук и видео, и может соответствовать потребностям разных пользователей. Версия Ernie 4.0 от Baidu, выпущенная в прошлом году, как утверждает компания, не уступает по возможностям чат-боту от OpenAI, а аудитория чат-бота уже превышает 100 млн пользователей. Напомним, что в другие регионы мира смартфоны Galaxy S24 поставляются с набором функций Galaxy AI на базе ИИ-моделей Gemini Nano и Gemini Pro от компании Google. Однако в Китае сервисы Google заблокированы, так что Samsung пришлось искать альтернативу. Помимо Google Cloud и Baidu AI Cloud, компания Samsung назвала в качестве партнёров в сфере ИИ местные фирмы, такие как WPS, Meitu и т. д. Google выпустит Chrome для компьютеров с Arm и Windows 11

26.01.2024 [17:21],

Павел Котов

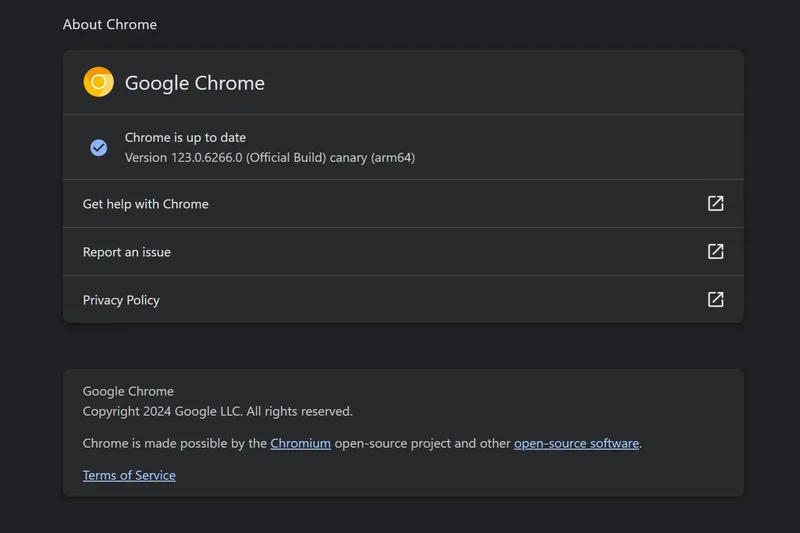

В последних предварительных сборках браузера Google Chrome на тестовом канале Canary обнаружилась версия, предназначенная для компьютеров на чипах Arm под управлением Windows 11.

Источник изображения: Rubaitul Azad / unsplash.com Microsoft уже давно поддерживает Arm-версию своего браузера Edge, основанного на Chromium, но сама Google до настоящего времени не выказывала никаких признаков поддержки этих процессоров в среде Windows. В результате владельцам ПК под Windows на новейших чипах Qualcomm Snapdragon приходилось запускать Chrome через эмулятор с пониженной производительностью.

Источник изображения: twitter.com/itanium_guy Разница между Arm-версией Edge и стандартным вариантом Chrome x86 на компьютере с Arm-процессором под Windows значительна. Первый работает так же быстро, как и на любом компьютере с x86-процессором, а второй заметно замедляется. При этом Google уже давно поддерживает Arm-процессоры на хромбуках, и есть версия ChromeOS, оптимизированная для чипов Qualcomm. Microsoft смогла выпустить Arm-версию Edge, пожертвовав системой DRM Google Widevine. Другие разработчики браузеров на базе Chromium DRM-систему от Google сохранили, поэтому в среде Windows на Arm альтернатив Edge фактически не было. 2024 год может ознаменовать наступление новой эпохи в истории ноутбуков под Windows: Qualcomm обещает превзойти Apple, Intel и AMD; а в 2025 году могут выйти Arm-процессоры от NVIDIA и AMD. Участие Google в этом процессе может иметь большое значение. Авторы сетевого экшена Warhaven объявили о его скором закрытии спустя четыре месяца после релиза

26.01.2024 [16:34],

Игнатий Колыско

Компания Nexon сообщила, что серверы сетевого экшена Warhaven будут отключены уже 5 апреля. В своём обращении разработчики проекта также дали понять, что геймеры больше не смогут приобретать внутриигровые предметы.

Источник изображения: Nexon Первое альфа-тестирование Warhaven прошло ещё в 2021 году, а 21 сентября 2023 года экшен вышел в раннем доступе Steam. Таким образом, решение о сворачивании поддержки озвучено спустя четыре месяца после релиза. Warhaven предлагал (и пока ещё предлагает) принять участие в сражениях, где две команды по 16 человек сражаются на арене, используя при этом оружие ближнего и дальнего боя. В игре представлено несколько режимов и шесть классов персонажей. За время пребывания в раннем доступе фэнтезийный экшен Warhaven набрал свыше 6800 отзывов в Steam (рейтинг 58 %). Геймеры ругают проект за бесконечные проблемы с серверами и балансом, а также «стабильно небольшой онлайн». Последний пункт легко проверить с помощью сервиса SteamDB (прямо сейчас в игре находится 135 человек). TSMC скоро начнёт закладывать основу для производства 1-нм чипов

26.01.2024 [15:57],

Павел Котов

TSMC развивает производство по техпроцессу 3 нм и активно готовится к запуску линий 2 нм, а неофициальные источники утверждают, что компания вскоре начнёт закладывать основы для техпроцесса 1 нм. Контрактный производитель инвестирует в фабрики чипов в западных странах, включая Германию и США, но, невзирая на геополитическую напряжённость в Азиатско-Тихоокеанском регионе, продолжает строительство передовых предприятий на Тайване. Источник изображения: Maxence Pira / unsplash.com TSMC уже приступила к планированию строительства завода, способного выпускать продукцию по нормам 1 нм, в научном парке Цзяи — компания явно уверена, что продолжит развиваться в области полупроводников и сохранит доминирование на рынке производства чипов. Об этом сообщает тайваньское издание United Daily News. Компания направила властям города предложение о застройке участка площадью 100 га — он будет поделён 40/60 между заводами по производству упаковки и чипов по нормам 1 нм. TSMC, как сообщается, опередила всех других претендентов. Инвестиции компании в технологию 1 нм составляют более 1 трлн тайваньских долларов ($32 млрд). В декабре TSMC представила дорожную карту, указывающую на намерение запустить производство чипов по нормам 1 нм к концу десятилетия. В сочетании с трёхмерной гетерогенной интеграцией она сможет выпускать процессоры с более чем 1 трлн транзисторов на чипе. Выяснились характеристики видеокарты MSI GeForce RTX 4080 Super EXPERT с вентиляторами спереди и сзади

26.01.2024 [15:54],

Николай Хижняк

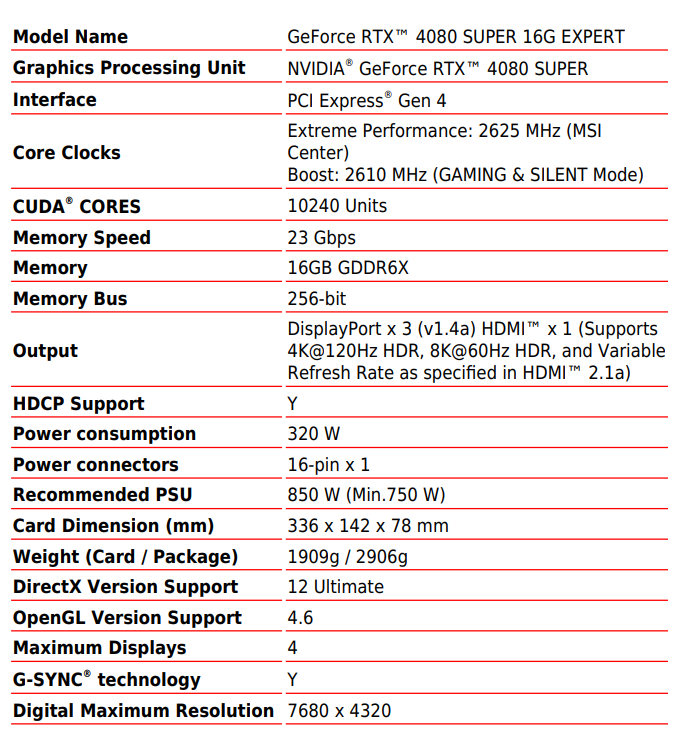

В рамках выставки CES 2024 в начале этого месяца компания MSI представила видеокарту GeForce RTX 4080 Super в новом фирменном исполнении EXPERT. Новинка обладает минималистичным, но эстетичным внешним видом, который отчасти напоминает дизайн эталонных видеокарт NVIDIA Founders Edition актуального поколения. На тот момент производитель не сообщил характеристики карты. Недавно этими деталями поделился инсайдер @wnxod.

Источник изображений: MSI Кожух системы охлаждения MSI GeForce RTX 4080 Super EXPERT, а также её задняя усиливающая пластина полностью отлиты из алюминия и выполнены в цвете шампань. В них не используется пластик, что придаёт видеокарте премиальный внешний вид. В составе системы охлаждения применяется технология испарительной камеры, которая в сочетании с тепловыми трубками эффективно передаёт тепло от GPU к радиатору. Для охлаждения самого радиатора имеется два вентилятора Zero Frozr с системой «тяни-толкай», когда один вентилятор работает на вдув, а другой на выдув. Толщина видеокарты составляет 3,5 слота расширения. Размеры карты составляют 336 × 142 × 78 мм, а вес — без малого 2 кг. Производитель будет рекомендовать для неё использование блока питания мощностью не менее 750 Вт. Энергопотребление новинки заявлено на уровне 320 Вт, что соответствует эталонному значению NVIDIA. Согласно имеющимся данным, карта оснащена двойной системой BIOS с тихим и производительным режимами работы. Для обоих заявляется частота GPU на уровне 2610 МГц, что на 60 МГц выше эталонного значения, заявленного NVIDIA. Однако в фирменном приложении MSI Center можно выставить профиль разгона до 2625 МГц. С учётом внешнего вида и дополнительного разгона MSI GeForce RTX 4080 Super EXPERT будет являться премиальным решением. Иными словами, её цена будет несколько выше рекомендованных $999, установленных NVIDIA для RTX 4080 Super. Сообщается, что некоторые обозреватели получили на тесты ускоритель именно в этом исполнении MSI.  Напомним, что в продажу GeForce RTX 4080 Super поступит 31 января. На день раньше профильные СМИ и техноблогеры опубликуют независимые обзоры указанной новинки. ИИ-стартап Илона Маска намерен привлечь $6 млрд и составить конкуренцию OpenAI

26.01.2024 [15:39],

Павел Котов

Компания xAI Илона Маска (Elon Musk) ведёт переговоры о привлечении инвестиций в размере до $6 млрд. Бизнесмен стремится получить финансирование от потенциальных зарубежных партнёров, в том числе из Гонконга, чтобы составить конкуренцию OpenAI, которую поддерживает Microsoft. Об этом сообщает Financial Times со ссылкой на собственные источники.

Источник изображения: x.ai Представители компании xAI провели переговоры с несколькими потенциальными инвесторами в Гонконге в надежде привлечь до $6 млрд при оценке самого стартапа в $20 млрд — переговоры ещё не окончены, а Маск пока оценивает настроения инвесторов. Партнёрами xAI также могут стать суверенные фонды благосостояния на Ближнем Востоке, инвесторы в Японии и Южной Корее. Привлечение американской компанией, работающей в области искусственного интеллекта, средств в Гонконге может иметь негативные последствия из-за геополитической напряжённости между США и Китаем. Сам Маск, в пятницу заявил, что его компания по искусственному интеллекту xAI не ведет переговоров с инвесторами о привлечении финансирования. «xAI не занимается привлечением капитала, и я ни с кем не разговаривал по этому поводу», — написал Маск в сообщении на X. Однако таким образом бизнесмен реагирует на любые упоминания его планов в прессе. Как пишет Financial Times, сбор средств для стартапа Илона Маска координирует банк Morgan Stanley, который в 2022 году помог миллиардеру в покупке Twitter, теперь переименованного в X. Масштаб привлечения средств отражает колоссальные затраты, необходимые для разработки систем генеративного ИИ — моделей, способных за считанные секунды генерировать текст, изображения и программный код, но для работы им требуются огромные вычислительные ресурсы, огромные объёмы данных для обучения и новейшие чипы. OpenAI привлекла на эти цели от Microsoft около $13 млрд; другие крупные стартапы, включая Anthropic и Cohere, привлекли многомиллиардные инвестиции от Google, Amazon и крупных игроков Кремниевой долины. В декабре xAI уведомила Комиссию по ценным бумагам и биржам США (SEC) о намерении привлечь $1 млрд в акционерный капитал — согласно документам, пока удалось привлечь $135 млн. Недавно Bloomberg сообщила, что xAI получила ещё $500 млн, но Маск опроверг эти сведения. Бизнесмен пока не раскрывал подробностей о механизмах финансирования xAI, хотя в ноябре и обмолвился, что теперешним акционерам X будут принадлежать 25 % компании. В покупке Twitter ему помогли глава Oracle Ларри Эллисон (Larry Ellison), компании Sequoia Capital, Andreessen Horowitz, Fidelity Management и саудовский принц Аль-Валид ибн Талал (Alwaleed bin Talal). В 2023 году домены .RU и .РФ показали рекордный рост

26.01.2024 [15:32],

Владимир Мироненко

В 2023 году домен .RU стал безусловным лидером по темпам роста среди всех российских доменов верхнего уровня, прибавив 506 024 домена (+10,3 %), благодаря чему вернулся на пятое место в мировом рейтинге страновых доменов, пишет Координационный центр доменов .RU/.РФ. На конец декабря в зоне .RU насчитывалось 5 439 137 доменов, большая часть которых (85 %) была зарегистрирована российскими гражданами и организациями. Всего за минувший год в зоне .RU было зарегистрировано 1 709 718 новых доменов. К концу года темпы регистрации выросли почти в два раза. Если с января по сентябрь в среднем регистрировалось 123 тыс. доменов в месяц, то с октября до конца года число регистраций выросло до 201 тыс.

Источник изображения: Координационный центр доменов .RU/.РФ Всего в прошлом году в зоне в .РФ было зарегистрировано 244 266 доменных имён, но в связи с естественным оттоком из-за непродления части доменов кириллический домен .РФ вырос за год на 92 769 доменных имён или 13,7 % до 768 883 доменных имени. По словам директора Координационного центра, основными драйверами роста российских доменных зон были перенос сайтов в российскую юрисдикцию под давлением санкций, а также появление большого числа новых проектов, ориентированных на российскую аудиторию. Доменные зоны .RU и .РФ показали свою устойчивость и обеспечили стабильное функционирование российским сайтам, несмотря на значительный рост фишинговых атак. В 2023 году компетентные организации направили 54 977 обращений к регистраторам, что в 3 раза больше, чем в 2022 году (16 324 обращения), большей частью (90 % всех обращений) по поводу фишинга. В результате рассмотрения обращений было заблокировано 54 135 вредоносных доменов, при этом скорость реагирования была по-прежнему самой высокой в мире. В частности, в мае–декабре 2023 года с момента подачи жалобы до блокировки вредоносного домена проходило всего 21,5 часа. Роскомнадзор заблокировал более 558 тыс. сайтов и веб-страниц в 2023 году

26.01.2024 [15:25],

Владимир Фетисов

За прошедший год Роскомнадзор заблокировал в Рунете 558 200 материалов, распространение которых на территории страны запрещено. Для мониторинга интернет-пространства и выявления противоправного контента дежурные службы задействовали автоматизированные информационные системы, в том числе «Окулус» и «Вепрь». Об этом пишут «Ведомости» со ссылкой на данные Роскомнадзора.

Источник изображения: Роскомнадзор О запуске системы поиска запрещённого контента «Окулус» СМИ писали в феврале 2023 года. Тогда же представитель Главного радиочастотного центра (ФГУП ГРЧЦ) сообщил, что основная задача системы состоит в выявлении нарушений российского законодательства в изображениях и видео. «Система распознаёт изображения и символы, противоправные сцены и действия, анализирует текст в фото- и видеоматериалах. «Окулус» автоматически обнаруживает такие правонарушения, как экстремистская тематика, призывы к массовым незаконным мероприятиям, суициду, пронаркотический контент и др.», — рассказал представитель ведомства. В феврале 2023 года ГРЧЦ проводил испытания системы обнаружения информационных бомб «Вепрь», которая предназначена для выявления потенциальных точек напряжённости в сети, способных перерасти в информационные угрозы. Система может осуществлять анализ таких точек и прогнозировать последствия распространения деструктивных материалов. Гендиректор разработчика решений по интеллектуальному сбору и анализу данных «Социальная лаборатория» Наталья Тылевич сообщила, что в распоряжении Роскомнадзора имеются сразу три системы — «Мир», «Окулус» и «Вепрь». Она отметила, что системы дополняют друг друга, но невозможно заранее определить, какая из них выявит тот или иной контент. «Дело в том, что каждая публикация содержит сразу несколько типов контента: текст, изображения, аудио- и видеокомпозиции. В составе системы «Мир», запущенной в 2021 году, используется система краулинга (сбора и извлечения информации) и дальнейшего анализа текста. «Окулус» заточен на вычисление изображений и видео и их идентификацию. «Вепрь» же дополнил функциональность двух систем прогнозной аналитикой», — рассказала Наталья Тылевич. RuStore подвёл итоги 2023 года — названы самые популярные игры и приложения

26.01.2024 [15:14],

Дмитрий Рудь

Официальный российский цифровой мобильный магазин RuStore подвёл итоги 2023 года. Пресс-служба компании VK поделилась аналитикой по количеству скачиваний приложений и игр на площадке. Как стало известно, самыми популярными мобильными играми в RuStore по итогам 2023 года оказались танковый экшен Tanks Blitz, «Симулятор автобуса 3D» и казуальный градостроительный симулятор «Плюс Сити». Наиболее востребованными среди пользователей RuStore за 2023 год игровыми жанрами были экшены (18,6 % от общего числа скачиваний), симуляторы (14,9 %) и приключения (10,9 %). RuStore также раскрыл подборку самых популярных игр в трёх жанрах:

Итоги 2023 года от RuStore (источник изображений: VK)

Что касается приложений, то среди них в 2023 году по популярности не было равных «Сбербанк Онлайн», Ozon и «2ГИС». Финансы по-прежнему лидируют среди неигровых категорий (около половины скачиваний). Самые скачиваемые приложения из неигровых категорий:

RuStore был запущен в мае 2022 года. Сообщается, что ежемесячная аудитория сервиса в России превышает 26 млн человек, а магазин насчитывает уже более 32 тыс. приложений. Новый сбор Apple может разорить разработчиков бесплатных и условно-бесплатных приложений

26.01.2024 [14:45],

Павел Котов

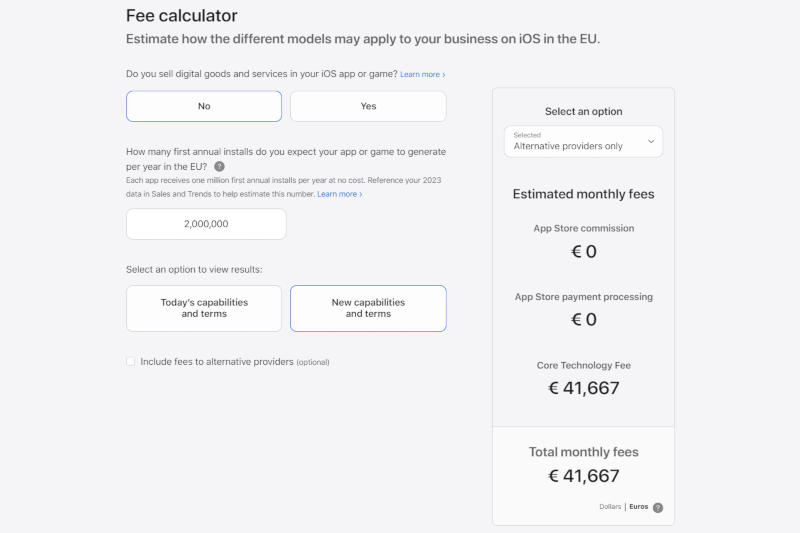

Европейские разработчики приложений, которые решат принять новые условия сотрудничества с Apple, должны будут платить «основной технологический сбор» (Core Technology Fee — CTF) в размере €0,50 за каждую первую установку приложения после достижения миллиона установок в течении года. Эта модель грозит разорением создателям бесплатных и условно-бесплатных приложений.

Источник изображения: apple.com Разработчикам бесплатных или условно-бесплатных приложений, которые оказываются достаточно популярными, чтобы превысить миллион загрузок, придётся платить астрономические суммы — Apple даже разместила на своём сайте онлайн-калькулятор. Так, создатель приложения с аудиторией 2 млн пользователей должен будет ежемесячно выплачивать Apple €41 667 или €500 000 в год, даже если сам не зарабатывает на этом денег. То есть для выхода на окупаемость приложения должны зарабатывать на каждом пользователе не менее €0,50 в год — на такую меру будут вынуждены идти разработчики продуктов, чья аудитория превысит 1 млн скачиваний. У них есть возможность избежать этого, согласившись на обычные условия Apple с комиссией от 15 % до 30 % за каждую транзакцию. Помимо CTF в размере €0,50, новые условия Apple устанавливают комиссию в размере от 10 % до 17 % для приложений из App Store и 3 % за каждую транзакцию через платёжную систему Apple. Компания отказывается от CTF для приложений некоммерческих организаций, аккредитованных образовательных учреждений, а также государственных учреждений, которым было одобрено освобождение от сбора. Для служб масштаба Spotify сбор CTF может оказаться непомерно высоким. Так, разработчик приложения за $0,99 с продажами на $10 млн должен будет перечислять Apple более $500 тыс. в месяц. Изменения вступают в силу с выходом Apple iOS 17.4 — для их применения разработчикам потребуется перейти на новую систему расчётов. Глобальная стратегия Total War: Pharaoh получила первое большое обновление после релиза

26.01.2024 [14:34],

Игнатий Колыско

Разработчики из компании Creative Assembly совместно с издательством SEGA объявили о выпуске обновления High Tide для своей глобальной стратегии Total War: Pharaoh. По такому случаю представлен отдельный трейлер.

Источник изображения: SEGA Апдейт High Tide обновил игру до версии 1.1.0 и добавил в неё множество контента: две новые фракции в лице народов шердан и филистимлян, свыше 30 новых юнитов и уникальную механику военных трофеев. Общее количество фракций в стратегии выросло до 10, свежие формирования же включают в себя пять новых божеств и уникальные пантеоны местных божеств. Патч 1.1.0 также «подтянул» техническую составляющую Total War: Pharaoh, в адрес которой было много нареканий. С полным списком изменений можно ознакомиться на официальном сайте. Total War: Pharaoh поступила в продажу 11 октября 2023 года в Steam (в РФ недоступна), а до Epic Games Store доберётся в начале текущего года. Создатели чересчур реалистичного шутера Unrecord рассказали, почему замалчивают подробности игры и что готовят на 2024 год

26.01.2024 [14:29],

Дмитрий Рудь

Разработчики чересчур реалистичного шутера Unrecord из французской студии DRAMA у себя в соцсетях и на странице в Steam объяснили затянувшееся молчание и рассказали о планах на 2024 год. DRAMA заверила, что отсутствие новостей не означает бездействие: команда «неустанно работает над игрой» (это всё ещё однопользовательский проект), а производство продвигается «гладко». Авторы Unrecord готовят на 2024 год несколько «громких анонсов». Публичные тестирования пока не планируются, а оптимизация для широкого спектра ПК (игра должна выйти и на консолях) остаётся в приоритете. Не спешат разработчики делиться подробностями Unrecord по двум причинам: во-первых, чтобы не испортить пользователям впечатление от игры, во-вторых, чтобы не подкинуть идею для той или иной функции конкурентам. «Мы готовим множество новых инновационных элементов, в связи с чем пока держим их в секрете. То, что мы публично показали из игры — лишь малая часть нашей работы», — уверяют в DRAMA. Новые изображения с моделями оружия из Unrecord (источник изображений: DRAMA)

Команда также предостерегла фанатов насчёт мелькающих в Сети сообщений и роликов о возможности поиграть в Unrecord: никакого раннего доступа или «беты» разработчики не предлагают. Unrecord позиционируется как смесь тактического шутера Ready or Not с сюжетным приключением Firewatch. Игрокам в роли полицейского предстоит раскрыть сложное дело, используя свои тактические и детективные навыки. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |