|

Опрос

|

реклама

Быстрый переход

Долой формулы и макросы: российская нейросеть SheetsGPT облегчит работу с таблицами в Excel

25.08.2023 [19:10],

Владимир Мироненко

В России создана нейросеть SheetsGPT, призванная упростить работу с электронными таблицами для всех, кто использует их в своей работе — бухгалтеров, операторов персональных данных, сотрудников маркетплейсов и других специалистов, пишет РИА Новости со ссылкой на информацию пресс-службы платформы Национальной технологической инициативы (НТИ). Нейросеть «понимает» текстовые запросы, поэтому специалистам больше не потребуется прибегать к формулам и писать макросы в Excel.

Источник изображения: Pixabay «Российская команда разработчиков создала систему SheetsGPT на базе собственной нейросети, которая упростит работу бухгалтера, оператора персональных данных, сотрудника маркетплейсов и всех, кто работает с электронными таблицами — персональные данные, отчёты, заказы и продажи и многое другое. В будущем пользователь также сможет вносить изменения в таблицы. Такое решение избавит клиентов от заучивания формул и написания макросов», — рассказали в пресс-службе. По словам руководителя проекта Антона Аверьянова, пользователю будет достаточно направить нейросети текстовый запрос, который будет обработан серверной частью, после чего человек получит ответ, преобразованный нейросетью в удобный для него вид. Чтобы получить необходимые данные из электронной таблицы, пользователю необходимо загрузить документ на сайт SheetsGPT и написать запрос, на подготовку ответа на который нейросети потребуется 8–15 секунд. Нейросеть также обладает способностью сопоставлять и создавать срез сразу по нескольким таблицам, получать выборки в виде таблицы. В дальнейшем разработчики намерены добавить опцию редактирования данных в таблицах с помощью SheetsGPT. «Мы предлагаем принципиально новый подход к работе с данными. Теперь не нужно знать формулы, писать макросы для того, чтобы с ними работать, — вам нужно только написать текстом то, что вы хотите получить», — рассказал Аверьянов. На данный момент проект находится на стадии прототипа. В ближайшем будущем после проведения тестов разработчики планируют начать продажи продукта конечным потребителям, а также клиентам B2B и B2G-сегментов. AMD выпустит в сентябре технологию масштабирования FSR 3, которая сможет рисовать в играх дополнительные кадры

25.08.2023 [19:07],

Николай Хижняк

Компания AMD в рамках своего мероприятия Gaming Festival 2023 на выставке Gamescom сообщила, что поддержку технологии масштабирования изображения FidelityFX Super Resolution (FSR) версии 3 первыми получат две игры — Forspoken и Immortals of Aveum. В перспективе список поддерживаемых игр будет расширяться. Важной особенностью технологии станет технология генерации дополнительных кадров, что повысит FPS в играх.

Источник изображений: AMD В составе новой версии FSR используется технология генерации дополнительных кадров в играх Fluid Motion Frames (FMF), которую можно сравнить с технологией генератора кадров DLSS3 Frame Generation от компании NVIDIA. Последняя значительно повышает FPS в играх, генерируя дополнительные кадры на основе данных о предыдущих, но вместе с этим увеличивает время задержки. Сокращение времени задержки также будет ключевым направлением для FSR 3, поскольку компания понимает, что геймерам нужны не только высокая частота кадров в играх, но и максимально быстрый отклик на действия игрока. В AMD отметили, что интеграция FSR 3 в игры, где уже присутствует поддержка FSR 2, не будет представлять никаких сложностей. Первыми играми, в которых будут использованы возможности FSR 3, являются Forspoken и Immortals of Aveum. Первая вышла в январе и судя по обзорам и отзывам игроков не оправдала ожиданий. Вторая в свою очередь была выпущена несколько дней назад. Это первая игра, использующая игровой движок Unreal Engine 5.1. На сегодняшней презентации AMD показала возможности FSR 3 в игре Forspoken, запущенной в разрешении 4K, при использовании максимальных настроек качества изображения с трассировкой лучей. Для демонстрации был выбран режим FSR 3 «Производительность». Благодаря этому частота кадров игры увеличилась более чем в три раза. Минимальные требования для FSR 3 подразумевают наличие видеокарты уровня Radeon RX 5000 и новее или же видеокарт NVIDIA GeForce RTX 2000 и новее. Поддержка FSR 3 будет распространяться по лицензии MIT. Технология будет также совместима с консолями. AMD ожидает, что патчи с поддержкой FSR 3 для Forspoken и Immortals of Aveum выйдут во второй половине сентября. Opera и ASUS анонсировали специальную версию игрового браузера Opera GX ROG Edition

25.08.2023 [18:52],

Сергей Сурабекянц

Opera и ASUS Republic of Gamers (ROG) сегодня объявили о совместной разработке специальной версии браузера для геймеров Opera GX ROG Edition. Браузер Opera GX уже в базовой конфигурации предлагает широкие возможности настройки с помощью модов и легко интегрируется с такими платформами, как Discord и Twitch. Opera GX ROG Edition добавляет к этим возможностям интеграцию с ASUS Aura Sync, тематические фоны и эксклюзивный контент в едином фирменном стиле Republic of Gamers.

Источник изображений: ASUS ROG Ноутбуки, настольные компьютеры, мониторы, игровые приставки и другие устройства ROG объединяет общий подход к дизайну, и теперь пользователи могут дополнить внешний вид своих устройств с помощью браузера Opera GX ROG Edition. Браузер предлагает обои ROG, фоновую музыку и звуковые клипы, а также такие функции, как игра ROG Electro Punk. Браузер Opera GX ROG Edition включает все инструменты и функции оригинальной Opera GX, которые сделали этот браузер привлекательным выбором для геймеров. Одной из наиболее важных функций является возможность ограничить потребление ресурсов ПК браузером во время игры. Функция Hot Tabs Killer позволяет пользователям закрывать наиболее ресурсоёмкие вкладки, а GX Cleaner помогает избавиться от старых ненужных файлов. Интеграция Aura Sync позволяет пользователям создавать собственные световые эффекты и анимацию, которые в режиме реального времени реагируют на содержимое браузера. Световые эффекты можно использовать для оповещения пользователей о новых сообщениях, для индикации завершения загрузки файла или для информирования об открытии вкладки.  Браузер также сможет оповещать пользователей о событиях ROG через специальный элемент интерфейса Opera GX Corner. Одним щелчком мыши геймеры смогут узнать о предстоящих событиях, новых продуктах ROG и игровом оборудовании, а также связаться с сотрудниками ROG и другими геймерами. Скачать Opera GX ROG Edition можно по этой ссылке. AMD представила видеокарты Radeon RX 7800 XT и Radeon RX 7700 XT

25.08.2023 [18:16],

Андрей Созинов

AMD представила две долгожданные видеокарты нового поколения: Radeon RX 7800 XT и Radeon RX 7700 XT. Новинки заполнят существенный пробел в семействе AMD RDNA3, в которой прежде были представлены только флагманские модели и игровые карты среднего уровня.

AMD Radeon RX 7800 XT. Источник изображения: AMD В составе новых видеокарт AMD представляет новый графический процессор под названием Navi 32. Данный графический процессор в полной конфигурации имеет 60 вычислительных блоков и 256-битную шину памяти, а также 64 Мбайт скоростной кэш-памяти Infinity Cache. В Radeon RX 7800 XT используется полная версия данного GPU с 60 вычислительными блоками (3840 потоковых процессоров), 60 RT-блоками для аппаратного ускорения трассировки лучей и 120 блоками ускорения ИИ. Таким образом, новинка имеет меньшее потоковых процессоров, чем Radeon RX 6800 XT прошлого поколения (4608 потоковых процессоров). Игровая частота GPU в эталонном исполнении составила 2124 МГц, а максимальная Boost-частота — 2430 МГц.  Видеокарта Radeon RX 7800 XT оснащена 16 Гбайт памяти GDDR6 со скоростью 19,5 Гбит/с на контакт, которая подключена по 256-битной шине. Пропускная способность достигает 624 Гбайт/с. Потребляемая мощность новой видеокарты составляет 263 Вт. Для питания имеется пара 8-контактных разъёмов. Radeon RX 7700 XT в свою очередь приятно удивила своими характеристиками. В ней используется совсем чуть-чуть урезанная версия Navi 32, которая обладает 54 вычислительными блоками (3456 потоковых процессоров), 54 RT-блоками и 108 ИИ-ускорителями. Это намного больше, чем у прежней Radeon RX 6700 XT с 40 вычислительными блоками. А вот с точки зрения памяти новинка похожа на предшественницу. Здесь также используется 12 Гбайт памяти GDDR6 со 192-разрядной шиной, хотя скорость памяти поднята до 18 Гбит/с. Это даёт пропускную способность в 432 Гбайт/с. Примечательно, что Radeon RX 7700 XT обладает более высоким по сравнению с RX 6700 XT энергопотребление — 245 Вт, что на 15 Вт больше. Данная новинка тоже использует пару 8-контактных разъёмов для дополнительного питания. Что касается производительности, то AMD утверждает, что Radeon RX 7800 XT в среднем на 3,5 % опережает GeForce RTX 4070 в играх с разрешением 1440p при максимальных настройках качества графики. А в некоторых играх даже демонстрируют превосходство на величину от 5 % до 23 %, хотя в некоторых играх, использующих трассировку лучей, пальма первенства остаётся у GeForce RTX 4070. В тех же играх и при тех же настройках графики Radeon RX 7700 XT оказывается в среднем на 12 % быстрее по сравнению с GeForce RTX 4060 Ti 16GB, а максимальный отрыв достигает 31 %. AMD подтвердила, что не будет выпускать эталонную версию Radeon RX 7700 XT, хотя показала такую карту на изображениях в презентации. Реализацией карты займутся партнёры AMD. В свою очередь Radeon RX 7800 XT будет выпускаться в референсном дизайне с новой системой охлаждения с парой вентиляторов. Кроме того, AMD подтвердила, что и Radeon RX 7800 XT, и Radeon RX 7700 XT будут поддерживать DisplayPort 2.1.  Продажи видеокарт Radeon RX 7700 XT и Radeon RX 7800 XT начнутся с 6 сентября. Рекомендованные цены новинок в США составят $449 и $499 соответственно. Заметим, что в те же $499 оценивается видеокарта GeForce RTX 4060 Ti с 16 Гбайт памяти, тогда как GeForce RTX 4070 оценена компанией NVIDIA в $599. В Европе видеокарты AMD Radeon RX 7700 XT и Radeon RX 7800 XT будут предлагаться за 489 и 549 евро соответственно. AMD создала видеокарту, которая меняет окраску при нагреве — Radeon RX 7900 XTX Avatar: Frontiers of Pandora

25.08.2023 [18:05],

Николай Хижняк

Компания AMD представила уникальную видеокарту Radeon RX 7900 XTX Avatar: Frontiers of Pandora Limited Edition, созданную в коллаборации с Massive Entertainment и Ubisoft по мотивам игры Avatar: Frontiers of Pandora, запуск которой ожидается 7 декабря. Источник изображений: AMD Карта оснащена эталонной системой охлаждения, однако её примечательной особенностью является раскраска. Ускоритель покрыт термореактивной краской, которая изменяет свой цвет при нагреве и демонстрирует рисунки по мотивам вселенной Avatar. Помимо этого карта обладает настраиваемой RGB-подсветкой. Весьма необычное решение, особенно если учесть, что речь идёт о видеокарте — важном компоненте любого игрового ПК, которому часто приходится работать при высоких температурах. Почему другие производители до сих пор не додумались до такого — вопрос. А ведь фантазия здесь позволит создавать действительно уникальные продукты. AMD сообщила, что выпустит всего 500 таких видеокарт и продавать их в рознице не будет. Вместо этого уникальные карты будут разыграны в различных акциях самой AMD, а также Ubisoft и других партнёров. Чтобы не пропустить розыгрыши, компания рекомендует следить за объявлениями в социальных сетях. Американские власти случайно отправили мошеннику криптовалюту на $55 тысяч

25.08.2023 [17:31],

Павел Котов

Неизвестный мошенник обманул американское Управление по борьбе с наркотиками (DEA) — сотрудники ведомства по оплошности сами отправили ему криптовалюту на $55 тыс. Злоумышленник рассчитывал на невнимательность своих жертв, и те произвели перевод на кошелёк, в адресе которого он заменил несколько символов.

Источник изображения: Riki32 / pixabay.com В мае 2023 года DEA изъяло с двух учётных записей на криптовалютной бирже Binance средства в стейблкоине Tether USD (USDT) на сумму более $500 тыс. Уже тогда за движениями по кошельку ведомства наблюдал мошенник; в какой-то момент он заметил, что с этого кошелька был осуществлён перевод одному из подразделений Минюста — Службе маршалов. Сумма составляла всего $45,36, то есть транзакция была, вероятно, тестовой. Тогда злоумышленник создал собственный криптовалютный кошелёк, адрес которого отчасти напоминал адрес кошелька Службы маршалов — совпадали первые пять и последние четыре символа. Он рассчитывал, что при последующей отправке сотрудники ведомства, не проверяя, скопируют адрес поддельного, а не настоящего кошелька. Расчёт оказался верным, и мошеннику отправили криптовалюту на $55 тыс. Когда в DEA обнаружили ошибку, то обратились в компанию Tether с требованием заблокировать средства. Но было уже поздно: к тому моменту злоумышленник вывел средства и конвертировал их. Ранее стало известно, что за 2022 год из-за хакеров и мошенников было потеряно $11,5 млрд в криптовалюте. Huawei и Ericsson договорились о перекрёстном лицензировании патентов

25.08.2023 [16:54],

Павел Котов

Huawei и Ericsson подписали долгосрочное соглашение о перекрёстном лицензировании интеллектуальной собственности. Документ охватывает патенты, касающиеся широкого спектра стандартов, таких как 3GPP, ITU, IEEE и IETF, для технологий мобильной связи 3G, 4G и 5G.

Источник изображения: huawei.com Соглашение двух телекоммуникационных гигантов охватывает как элементы сетевой инфраструктуры, так и потребительские устройства — обе компании получат международный доступ к запатентованным стандартизированным технологиям друг друга. В Huawei заявили, что компании признали ценность интеллектуальной собственности друг друга, что повышает прочность патентной среды — соглашение демонстрирует обязательство сторон уважать и защищать интеллектуальную собственность. За последние 20 лет китайский электронный гигант внёс значительный вклад в телекоммуникационные решения — это коснулось направлений мобильной связи, Wi-Fi и мультимедиа. По итогам 2022 года Huawei стала лидером в рейтинге заявителей Европейского патентного ведомства по числу поданных патентных заявок — их оказалось 4505. «Наша приверженность обмену технологическими инновациями обеспечит здоровое и устойчивое развитие отрасли, а потребитель будет получит надёжные продукты и услуги», — заявил глава отдела интеллектуальной собственности Huawei Алан Фань (Alan Fan). При помощи ИИ уже создано 15 млрд изображений — у фотографов на это ушло 150 лет

25.08.2023 [16:08],

Павел Котов

Сервис Everypixel решил оценить, сколько изображений было создано искусственным интеллектом с 2022 года. Проанализировав некоторые статистические данные и факты, эксперты сервиса установили, что за это время появились 15 миллиардов таких изображений — столько же снимков человек сделал с момента получения первой фотографии в 1826 году и до 1975 года, то есть примерно за 150 лет. Источник изображений: journal.everypixel.com С момента запуска модели OpenAI DALL-E 2 в апреле 2022 года пользователи создают в среднем 34 млн изображений ежедневно. Самым быстрорастущим генератором изображений является интегрированный в Photoshop инструмент Adobe Firefly — всего за три месяца при его помощи был создан 1 млрд изображений. Самой популярной централизованной платформой с общедоступной статистикой является Midjourney с 15 млн пользователей — для сравнения, на всю Adobe Creative Cloud приходятся около 30 млн пользователей. А больше всего изображений было создано при помощи моделей, сервисов, платформ и приложений на основе нейросети Stable Diffusion с открытым исходным кодом — на неё пришлось 80 % «творчества» ИИ или 12,59 млрд изображений. Авторы проекта не претендуют на то, что их исследование — истина в последней инстанции. Их легко понять: технологии ИИ интенсивно развиваются, ассортимент моделей и приложений расширяется буквально каждый день, что значительно усложняет сбор статистических данных. Поэтому показатель в 15 млрд изображений носит скорее оценочный характер. Зато они предложили сравнить это число с другими: библиотека фотобанка Shutterstock содержит 386 млн изображений; на платформу Instagram✴ загружено 50 млрд снимков; поисковик Google проиндексировал 136 млрд файлов картинок; до 240 млрд их значится на платформе Pinterest; а пользователи Facebook✴ загрузили в соцсеть уже 1,5 трлн изображений. Baldur’s Gate 3 получила крупный патч с тысячей исправлений, а серьёзные улучшения производительности «уже совсем рядом»

25.08.2023 [16:04],

Дмитрий Рудь

Разработчики из Larian Studios сообщили о выпуске первого крупного патча для своей фэнтезийной ролевой игры Baldur’s Gate 3. Обновление получилось настолько большим, что список входящих в него изменений не уместился в лимиты публикаций Steam. Как и было обещано, первое крупное обновление Baldur’s Gate 3 исправляет более тысячи багов (в том числе графических), а также вносит корректировки в баланс, скрипты, интерфейс и прочие элементы. В частности, лаунчер Baldur’s Gate 3 начнёт запоминать сделанный выбор между DirectX 11 и Vulkan, в настройках отныне можно сменить стиль иконок контроллера, а финальные титры теперь разделены на две колонки. Кроме того, NPC больше не будут обнаруживать игрока в тех условиях, при которых это невозможно, открытие концовки романтической линии Шэдоухарт работает как следует, а низкорослые герои наконец смогут нормально поцеловать персонажа с историей.  По словам Larian, второй крупный патч для Baldur’s Gate 3 не просто в работе, а «уже совсем рядом». Это обновление принесёт с собой «значительные улучшения производительности» (третьего акта, надо полагать). Кроме того, в объявлении насчёт патча разработчики обновили некоторые статистические показатели игроков:

Baldur’s Gate 3 вышла из раннего доступа 3 августа на PC (Steam, GOG), до macOS и PS5 доберётся 6 сентября, а до Xbox Series X и S — к концу 2023 года и без локального кооператива в случае Xbox Series S. Проекторы Acer для школ добавят наглядности в учебный процесс

25.08.2023 [15:49],

Андрей Созинов

Не за горами начало учебного года. Ни для кого не секрет, что дети куда лучше усваивают знания, подкреплённые наглядными материалами. Однако картинок в книге может быть недостаточно: там невозможно показать протекание какого-либо биологического процесса или химической реакции, или же продемонстрировать некие исторические события. На помощь придёт проектор, который обеспечит большую картинку в классе, которую будет хорошо видно всем учащимся. Acer предлагает несколько моделей, хорошо подходящих для подобного сценария за счёт высокой яркости и других полезных функций — ниже расскажем о них подробнее.

Источник изображений: Acer Проектор Acer S1286H наилучшим образом подойдёт для небольших кабинетов в школе, так как он обладает коротким фокусным расстоянием. Проще говоря, даже с небольшого расстояния он способен выдать картинку большого размера, до 150 дюймов по диагонали. При этом стандартное разрешение составляет 1024 × 768 пикселей, но поддерживается и более высокое разрешение в 1920 × 1200 точек. Поддерживается коррекция трапецеидальных искажений, а наличие встроенных 16-Вт динамиков обеспечит громкий и качественный звук. Другим важным преимуществом данного проектора является весьма высокая яркость в 3500 люмен (ANSI). Это позволит полноценно использовать Acer S1286H даже не зашторивая окна — картинка всё равно останется чёткой. Поддерживается и режим ECO в котором максимальная яркость составляет 2800 люмен. Динамическая контрастность проектора составляет 20 000:1.  Acer S1286H выполнен по технологии DLP с тремя матрицами (3 DMD). Ресурс лампы проектора в стандартном режиме составляет 5000 часов, в ECO-режиме — 6000 часов, а в режиме ExtremeEco — 10 тыс. часов. Тут же отметим поддержку технологий защиты от пыли, возможного износа и ухудшения изображения. Acer ColorSafe II управляет динамическими значениями RGB для предотвращения потери цвета. Acer ColorBoost3D обеспечивает естественные цвета и яркое изображение. Acer LumiSense регулирует яркость изображения и насыщенность цветов в зависимости от содержимого. Acer BlueLightShield защитите глаза от ненужного напряжения за счёт снижения интенсивности синего света, что особенно важно для детей.  Для удобства использования проектора в организациях, в том числе школах, у Acer S1286H есть система управления Crestron, которая позволяет удалённо управлять, обслуживать и вести мониторинг устройства в любом месте с помощью интернет-соединения. Набор интерфейсов включает HDMI, USB, входной и выходной VGA (D-sub), пару 3,5-мм аудиоразъёмов (вход и выход), а также COM-порт. Следующим интересным кандидатом в проекторы для учебного кабинета является модель Acer H5386BDi. Этот проектор выделяется более мощным источником света с яркостью до 5000 люмен (до 4000 люмен в режиме ECO), что позволяет использовать его без каких-либо компромиссов по качеству изображения даже в сильно освещенном помещении.  Данный проектор способен выводить огромное изображение размером до 300 дюймов по диагонали (это более 7,6 метров) с разрешением до WUXGA (1920 × 1200 пикселей). Минимальное фокусное расстояние составляет 1 метр, а максимальное — 10 метров. Конечно же, имеется и коррекция трапецеидальных искажений в диапазонах +/-40° вертикально и горизонтально, как и у модели выше. Это облегчает настройку проектора под разные помещения и экраны. В проекторе Acer H5386BDi применены технологии Acer, направленные на улучшение качества изображения и повышение комфорта для зрителей, а именно Acer Bluelight Shield, Dynamic Black 20000:1, Acer LumiSense, Acer ColorBoost3D, Acer ColorSafe II и другие. И тут же отметим тихую работу системы: в стандартном режиме уровень шума не превышает 27 дБА, так что проектор фактически не будет слышно.  Удобной особенностью Acer H5386BDi является поддержка беспроводного подключения к источнику сигнала. Для этого в комплекте имеется специальный адаптер, который подключается к порту USB компьютера и позволяет дублировать его экран на проектор. Есть и стандартные интерфейсы HDMI и VGA. А наличие встроенного динамика на 3 Вт обеспечит качественное звучание без дополнительного оборудования. Наконец, Acer предлагает продвинутый проектор Acer X1528i, который отличается ещё более высокой яркостью в 4300 люмен в стандартном режиме работы и 3440 люмен в энергосберегающем режиме ECO. Там образом данный проектор способен обеспечить ещё более насыщенную и яркую картинку даже в очень светлых помещениях. Отмечается и высокая контрастность — 10 000:1 благодаря технологии DynamicBlack. А ещё производитель обращает внимание на долгий срок службы проектора: в стандартном режиме он составляет 5000 часов, в ECO — 10 тыс. часов и в ExtremeEco — 15 тыс. часов.  Родное разрешение данного проектора — Full HD (1920 × 1080 точек), но также поддерживается вывод изображения с разрешением 1920 × 1200 точек. Производитель также отмечает способность Acer X1528i отображать 1,07 млрд цветов, что обеспечивает высокую точность цветопередачи и насыщенность изображения.  Имеются и уже упоминавшиеся фирменные технологии для улучшения качества изображения и повышения комфорта пользователей, а именно Acer Bluelight Shield, LumiSense, ColorBoost3D, ColorSafe II и другие. Тут же отметим поддержку режима Football Mode, который повышает яркость, насыщенность, четкость и гамму в светлых сценах, а также оптимизирует изображение и цветопередачу газона и кожи футболистов для достижения максимально яркой и сочной картинки. Имеется поддержка беспроводного подключения к источнику сигнала, а также традиционные проводные интерфейсы VGA и HDMI. Как и у вышеописанных проекторов, у Acer X1528i присутствует поддержка HDMI 3D, что позволяет воспроизводить 3D-контент высокого разрешения.  Что касается стоимости, то Acer S1286H предлагается за 45 709 рублей, модель Acer H5386BDi обойдётся в 44 058 рублей, а старший Acer X1528i можно приобрести за 82 790 рублей. Как видно, Acer предлагает довольно разнообразный ассортимент проекторов с высокой яркостью и долгим сроком службы, что важно в случае использования их в школьных классах. Уязвимости WinRAR затронули сотни других программ, распространённых по всему миру

25.08.2023 [15:42],

Павел Котов

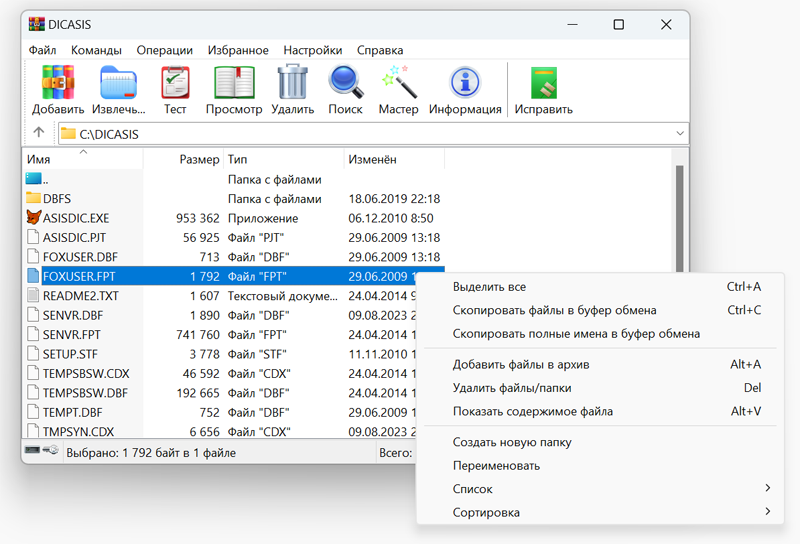

В минувшие выходные стало известно об уязвимости популярного архиватора WinRAR, которая была исправлена в новой версии 6.23. Впоследствии выяснилось, что до этого обновления у программы была другая уязвимость, которую эксплуатировали хакеры, и последствия этих ошибок могут оказаться серьёзными, поскольку уязвимости затрагивают и другое ПО.  Ранее стало известно, что архиватор WinRAR содержит уязвимость, которую злоумышленники могут использовать для выполнения произвольного кода — она отслеживается под номером CVE-2023-40477 и имеет рейтинг 7,8 из 10 (высокий). Проблема заключается в некорректной проверке данных в так называемых томах восстановления для архивов RAR, в результате чего вредоносный код получает доступ к области за пределами выделенного буфера памяти. Вредоносный код выполняется при попытке открыть такой специально подготовленный архив. Спустя некоторое время эксперты Group-IB рассказали об уязвимости CVE-2023-38831 (рейтинг пока не присвоен), которая эксплуатируется с апреля неизвестной хакерской группировкой, которая выбрала в качестве жертв сотрудников брокерских контор. Данная уязвимость позволяет маскировать вредоносные скрипты под безобидные на первый взгляд файлы JPG и TXT, двойной клик по которым в архиве также запускает их на выполнение. Обе уязвимости были исправлены. Компания Rarlab ответственна также за библиотеки unrar.dll и unrar64.dll, которые, вероятно, тоже уязвимы, и они входят в состав множества других программ. Повод для подозрений появился с обновлением не менее культового чем архиватор WinRAR файлового менеджера Total Commander: в замечаниях к сборке 11.01 RC1 указано, что исправлена критическая уязвимость библиотеки unrar.dll, и эту библиотеку при необходимости предлагается загрузить отдельно. Впоследствии разработчик программы Кристиан Гислер (Christian Ghisler) пояснил на форуме проекта: «Никто не знает, уязвим ли также unrar.dll, или это сам WinRAR. Но поскольку я в текущий момент готовлю выход TC 11.01, я в любом случае включу в него новые библиотеки unrar». В немецком институте кибербезопасности AV-Test пояснили, что в их базе числятся более 400 программ, использующих unrar.dll и unrar64.dll, включая антивирусные программы. Вероятно, в ближайшее время эти библиотеки будут заменяться во всех обновлениях этих программ. Нельзя не вспомнить и Windows, чей «Проводник» вскоре должен получить встроенную поддержку архивов RAR. И здесь тоже есть нюанс: открытая библиотека от Rarlab написана на C++, а поддержка формата RAR «Проводником» реализуется на базе кода libarchive — эта библиотека использует собственную реализацию C. А значит, если уязвимость каким-то образом коснулась libarchive, компании Microsoft придётся закрыть её перед выходом общедоступного обновления Windows, где «Проводник» будет поддерживать RAR. Французы показали летающий скутер — он сможет два часа летать на керосине и ещё чуть-чуть на аккумуляторе

25.08.2023 [15:25],

Геннадий Детинич

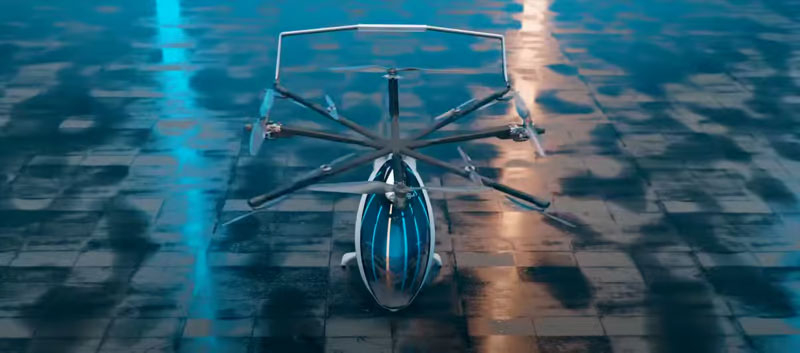

Французская компания Фрэнки Запаты (Franky Zapata) на выставке в Париже представила концепцию одноместного летающего «скутера» — Zapata Airscooter. Для управления этим легчайшим аппаратом не нужна будет лицензия пилота, что может сделать его интересным для широкого круга энтузиастов. Гибридная силовая установка обещает держать его в воздухе до двух часов, позволяя преодолевать на полном баке до 200 км.

Источник изображений: Franky Zapata В настоящий момент отсутствуют подробности о конструкции силовой схемы Zapata Airscooter. Судя по имеющимся изображениям, в воздухе аппарат будут поднимать четыре компактные турбины на керосине, возможно, сопряжённые с электрическими двигателями. Восемь электродвигателей на диагональных стойках с пропеллерами меньшего размера будут отвечать за стабилизацию и быстрые манёвры аппарата. Управлять им будет не сложнее, чем обычным дроном — все сложности возьмёт на себя электроника.  Турбины, подчеркнём, размещены на концах стоек, что необычно (обычно турбина где-то в центре и одна, а крутящий момент передаётся на винты через механическую передачу). В проекте Запаты турбины четыре штуки и топливо подаётся к ним по протяжённым топливопроводам. Даже не смотря на компактные размеры турбин, шум от них будет определённо далеко не комфортным и это станет главным минусом данного аппарата. Впрочем, ещё один минус — это достаточно дорогое обслуживание турбин, которое по регламенту проводится после каждых 25 часов её эксплуатации — до $300 за каждую.  Заявленная для Zapata Airscooter крейсерская скорость составляет 80 км/ч. При этом он будет способен разгоняться до 100 км/ч. Вес аппарата — 115 кг. В воздух он сможет поднимать одного пилота массой до 120 кг. Топливного бака на 5 галлонов (18,9 л) хватит на пилотирование более двух часов. О цене аппарата информации нет.  Создан аккумулятор толщиной с роговицу глаза для умных контактных линз — он питается от солевого раствора

25.08.2023 [15:21],

Дмитрий Федоров

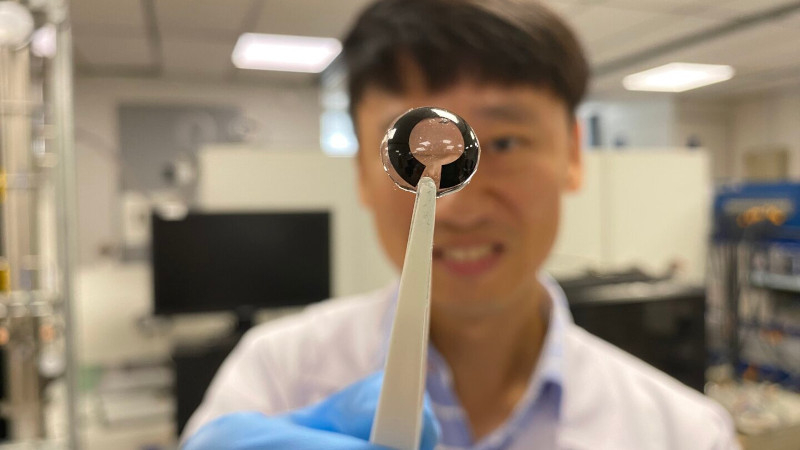

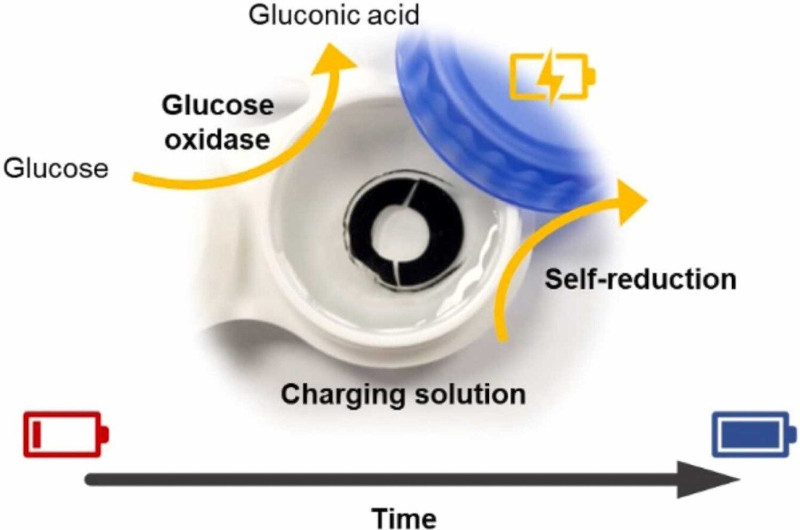

Учёные из Наньянского технологического университета (NTU) Сингапура создали гибкий аккумулятор, толщиной с человеческую роговицу, который заряжается от солевого раствора и в будущем может обеспечивать питание умным контактным линзам.

Источник изображения: Nanyang Technological University По задумке, умные контактные линзы должны быть способны отображать информацию прямо на роговице глаза, предоставляя доступ к дополненной реальности (AR). Пока что же они ограничены в функциональности, но уже используются для коррекции зрения, мониторинга состояния здоровья и даже для диагностики и лечения хронических заболеваний, таких как диабет и глаукома. В перспективе такие линзы смогут записывать и передавать в облачное хранилище всё, что видит и слышит их носитель. Однако для реализации этого потенциала необходимо создать безопасный и подходящий аккумулятор. Существующие перезаряжаемые батареи, основанные на проводах или индукционных катушках, содержат металлы и не подходят для использования в глазу из-за риска для здоровья.

Принцип работы нового аккумулятора, разработанного сингапурскими учёными (источник изображения: Nano Energy) Разработанный в NTU аккумулятор изготовлен из биосовместимых материалов и не содержит проводов или токсичных тяжёлых металлов, присутствующих, например, в литийионных аккумуляторах. Его покрытие на основе глюкозы реагирует с ионами натрия и хлора в солевом растворе, в который обычно линзы помещают для хранения ночью. Содержащаяся в батарее вода служит электрическим проводником, обеспечивая передачу электрического тока, который генерируется в результате описанной химической реакции. Интересный факт заключается в том, что такой аккумулятор может заряжаться даже от человеческих слёз, так как они содержат ионы натрия и калия, хотя в меньших концентрациях. Тестирование аккумулятора с использованием раствора, имитирующего состав человеческих слёз, показало, что при таком способе зарядки его работоспособность продлевается на дополнительный час после каждых двенадцати часов непрерывной работы. Кроме того, аккумулятор можно заряжать традиционным способом от внешнего источника питания. Этот прорыв в области аккумуляторных технологий может стать ключевым моментом в развитии умных контактных линз и других медицинских устройств. Безопасность, гибкость и возможность зарядки от солевого раствора или даже слёз делают этот аккумулятор идеальным кандидатом для интеграции в медицинские устройства будущего. Samsung представила смарт-часы Galaxy Watch6 Classic Astro Edition, вдохновлённые астролябией

25.08.2023 [15:09],

Николай Хижняк

Компания Samsung представила специальную версию умных часов Galaxy Watch6 Classic Astro Edition. Они оснащены «астробезелем» — поворотной рамкой дисплея, на которой изображены звёзды, созвездия и другие небесные тела. Внешний вид часов вдохновлён астролябиями — древними астрономическими инструментами, служившими для измерения горизонтальных углов и определения координат небесных тел.

Источник изображений: Samsung Часы Galaxy Watch6 Classic Astro Edition будут доступны в единственном размере (47 мм) и будут поставляться в чёрном цвете. В комплект поставки устройства также войдёт дополнительный тканевый ремешок и коллекционные предметы издания Astro Edition. Samsung наделила часы эксклюзивными программными функциями и циферблатами. В частности, появилась функция компаса на циферблате, а также возможность отслеживания лунных и солнечных фаз.  Покупателям Galaxy Watch6 Classic Astro Edition также будет предоставлен доступ к эксклюзивному промо-магазину приложений Samsung. Galaxy Watch6 Classic Astro Edition будут предлагаться только в странах Ближнего Востока и Северной Африки (MENA), включая ОАЭ, Кувейт, Катар, Бахрейн, Оман, Саудовскую Аравию, Ирак, Египет, Иорданию, Турцию и Марокко. Новинку оценили примерно в $544. «Galaxy Watch6 Classic Astro Edition от Samsung — это дань уважения первопроходцам Ближнего Востока, признание их исторического вклада в математику, науку и инновации. Samsung уверена в потенциале региона и его значимой роли в качестве глобального центра инноваций», — прокомментировал Омар Сахеб (Omar Saheb), региональный директор по маркетингу MENA компании Samsung. Курчатовский институт испытал модернизированный токамак Т-15МД с новыми системами повышения мощности

25.08.2023 [14:53],

Геннадий Детинич

На пленарном заседании форума «Технопром» вице-президент НИЦ «Курчатовский институт» Александр Благов сообщил о проведении энергетических испытаний модернизированного токамака Т-15МД. Это первая построенная за 20 лет установка такого рода в России. Первая плазма на токамаке получена весной этого года, после чего началось постепенное увеличение мощности установки.

Модернизированная термоядерная установка токамак Т-15МД. Источник изображения: Юлия Бубнова/ТАСС В чистом виде токамак Т-15МД не может считаться термоядерным реактором. По крайней мере, от него не будут требовать производства энергии. Установка проектировалась и создавалась как мощный термоядерный источник нейтронов. При этом Т-15МД обладает уникальным сочетанием компактности и мощности, что позволит отрабатывать на установке технологии, которые потом найдут применение в масштабных термоядерных проектах. В частности, Т-15МД входит в структуру международного термоядерного проекта ИТЭР (International Thermonuclear Experimental Reactor) и поможет запустить одноимённый реактор в работу, проверяя те или иные аспекты поведения установки и испытывая новое оборудование и материалы. Физический пуск токамака Т-15МД состоялся в мае 2021 года при участии премьер-министра РФ Михаила Мишустина. Первая плазма на нём, как сообщалось выше, получена весной этого года. «Сейчас мы его (токамак) дооснастили дополнительными системами нагрева и уже провели первые испытания по энергетическому пуску этой установки. Это очень важное событие с точки зрения развития термоядерный энергетики в нашей стране», — сказал Благов, которого цитирует ТАСС. Работы по дооснащению токамака продолжаются. В конечном итоге он будет выведен на уровень, необходимый для получения результатов высокого международного значения. Работы по проекту ведёт Курчатовский институт. Конкретно реакторные технологии будут разрабатываться на другой установке — на токамаке с реакторными технологиями, который начали строить на базе Троицкого института инновационных термоядерных исследований. Он должен быть готов к 2030 году. MSI предложила временное решение проблемы BSOD из-за «неподдерживаемых процессоров» в Windows 11

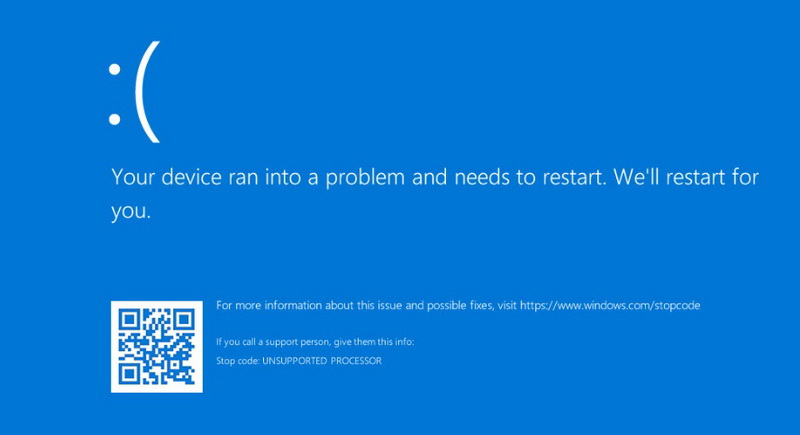

25.08.2023 [14:44],

Николай Хижняк

Вчера сообщалось о том, что очередное обновление Windows 11 стало приводить к появлению синих экранов смерти (BSOD) с сообщением о неподдерживаемом процессоре (UNSUPPORTED_PROCESSOR). BSOD возникает после установки пакета KB5029351, распространение которого началось ранее на этой неделе. Судя по всему, этой ошибке оказались подвержены только материнские платы MSI на чипсетах Intel 600-й и 700-й серий. Компания предложила временное решение.

Источник изображения: MSI В частности, с ошибкой могут столкнуться владельцы тех моделей материнских плат MSI, для которых производитель уже выпустил обновления BIOS с поддержкой будущих процессоров Raptor Lake Refresh. Причину ошибки определить пока не удалось и её связь с новыми процессорами до сих пор остаётся неясной. Microsoft и MSI подтвердили существование проблемы и активно ищут надёжный способ её решения. Последняя предложила пока временное решение для владельцев плат, которые уже столкнулись с вышеуказанной ошибкой, а также пообещала публиковать новую информацию о процессе расследования. «Если вы уже столкнулись с этой проблемой, то обновление KB5029351 может быть автоматически удалено для возможности загрузки Windows. Однако если обновление KB5029351 не откатывается самостоятельно, то мы рекомендуем откатить BIOS материнской платы на предыдущую версию, а затем удалить обновление KB5029351 из Windows. Если вы не знаете, как восстановить старую версию BIOS, по этой ссылке можно посмотреть видео, которое расскажет, как прошить BIOS на материнских платах MSI», — выступила с заявлением компания. Citizen отзовёт смарт-часы CZ Smart Gen-2 — они тормозят, не ловят GPS и имеют много других проблем

25.08.2023 [14:33],

Павел Котов

Компания Citizen временно приостановила продажи своих умных часов CZ Smart второго поколения в связи с «технической проблемой». Устройство под управлением Google Wear OS поступило в продажу в мае и отличалось функцией оценки психомоторного состояния человека, основанной на технологиях IBM Watson и NASA.

Источник изображения: Citizen Авторы обзоров дали устройству негативные оценки за многочисленные сбои в работе: тормозящий интерфейс, непродолжительное время автономной работы, низкая точность в работе датчиков, а также циферблаты, которые не показывают правильного времени. «Мы расследуем проблему, отзываем модели для проверки и временно приостанавливаем продажи моделей с сенсорным экраном, пока не выявим источник проблемы и лучший способ решения для наших клиентов и партнёров», — приводит ресурс The Verge заявление Citizen, сделанное по электронной почте. Под программу отзыва попали смарт-часы моделей MX1003-71X, MX1000-28X, MX1000-01X, MX1000-52X, MX1005-83X, MX1002-57X, MX1018-06X, MX1017-50X, MX1010-59X, MX1011-05X и MX1016-28X. Модель CZ Smart Hybrid программа не затронет. Журналист ресурса The Verge Виктория Сон (Victoria Song) заметила множество недостатков устройства менее чем за две недели их использования. В ходе пробежек на свежем воздухе умные часы Citizen CZ Smart не смогли поймать сигнал GPS, зависли на середине тренировки и не смогли её записать: девушка пробежала 3,2 км, но устройство зафиксировало лишь 160 м, которые она пробежала якобы со скоростью 1,03 км/ч — примерно как черепаха на суше. При этом заряженные в полдень до 100 % умные часы в 22:30 того же дня показали всего 6 %. Вдобавок почти не работала синхронизация данных — Citizen CZ Smart не смогли поддерживать соединение с телефоном, даже когда находились рядом с ним. В обмен на строительство фабрики электромобилей в Индии Tesla намерена добиться снижения таможенных пошлин

25.08.2023 [14:25],

Алексей Разин

В июне этого года во время визита премьер-министра Индии Нарендры Моди (Narendra Modi) глава компании Tesla Илон Маск (Elon Musk) встретился с ним в Нью-Йорке. По словам информированных источников, индийское правительство сейчас работает над новой политикой в сфере производства электромобилей, которая подразумевает не только привлечение зарубежных компаний к локализации выпуска, но и снижение таможенных пошлин для расширения импорта готовых машин.

Источник изображения: Tesla Собственно говоря, представители Reuters утверждают, что на последнем изменении уже давно настаивает компания Tesla, в появлении предприятия которой на территории Индии заинтересованы власти этой южноазиатской страны. Первая попытка добиться преференций от властей Индии для Tesla в 2021 году завершилась неудачей, поскольку чиновники не наши веских причин отказываться от импортной пошлины в 100 % от стоимости ввозимых в страну электромобилей. В качестве встречного предложения они рекомендовали Tesla рассмотреть возможность организации сборки электромобилей на территории Индии. В прошлом году переговоры зашли в тупик, поскольку власти страны рассчитывали на то, что Tesla первой сделает шаг навстречу. Сейчас, по данным Reuters, американская компания рассчитывает на послабления в таможенной политике Индии, которая в случае своего обновления позволит Tesla ввозить в страну по сниженной ставке те электромобили, которые она не будет производить локально. При этом власти настаивают на организации сборки электромобилей Tesla в Индии как необходимом условии смягчения таможенной политики. Сейчас импортёры электромобилей в Индию должны уплачивать 100 % пошлины от стоимости машин свыше $40 000, для более дешёвых моделей эта ставка достигает 70 %. Компания Tesla хотела бы, что для неё пошлина снизилась до 15 %, если ряд моделей она начнёт производить в Индии. Естественно, такие условия распространились бы и на других производителей электромобилей, просто Tesla хочет получить преимущество первой участницы данной программы. Сейчас электромобили составляют не более 2 % первичного авторынка Индии, но страна обладает огромным потенциалом роста, и производители пытаются добиться наиболее выгодных для себя условий работы на местном рынке. Если говорить о планах локализации производства электромобилей Tesla в Индии, то компания собирается наладить выпуск новой модели стоимостью $24 000, которая оказалась бы почти на четверть доступнее самой дешёвой из имеющихся в ассортименте продукции марки машин. Недорогой электромобиль Tesla индийской сборки имел бы и некоторый потенциал экспорта. Аналогичную машину компания собирается выпускать и на строящемся предприятии в Мексике. На полную мощность предприятие в Индии могло бы выйти к 2030 году, как пояснили информированные источники со ссылкой на комментарии представителей Tesla. Чиновники пока настаивают, что никаких налоговых преференций компания в случае организации производства в Индии не получит. Местные автопроизводители Tata Motors и Mahindra & Mahindra не заинтересованы в том, чтобы таможенные пошлины на импорт электромобилей снижались. The Elder Scrolls VI должна стать «лучшим симулятором фэнтезийного мира» — Тодд Говард рассказал, жалеет ли о раннем анонсе игры

25.08.2023 [14:24],

Дмитрий Рудь

Starfield и The Elder Scrolls VI анонсировали на одной и той же пресс-конференции в июне 2018 года, но первая выходит буквально на следующей неделе, а вторую от релиза отделяет ещё по меньшей мере пять лет. Исполнительный продюсер Bethesda Game Studios Тодд Говард (Todd Howard) в недавнем интервью GQ затронул эту тему. Фильмы Marvel, например, подтверждают буквально пачками за несколько лет до того, как они даже материализуются, но не жалеет ли Говард о столь раннем анонсе The Elder Scrolls VI? На этот вопрос разработчик ищет ответ до сих пор: «Спрашивал себя об этом много раз. Не знаю. Наверное, я бы анонсировал её более непринуждённо». В том же интервью Говард подтвердил, что у The Elder Scrolls VI есть рабочее название (и гейм-дизайнеру нравится его произносить), а также наметил основную задачу Bethesda на игру: «Мы хотим, чтобы она стала лучшим симулятором фэнтезийного мира. И существует несколько способов этого достичь, учитывая то, сколько времени прошло». Для сравнения: за те же (почти) 12 лет, что прошли с выхода Skyrim, Bethesda в период с 1994 по 2006 год выпустила все предыдущие номерные The Elder Scrolls (Arena, Daggerfall, Morrowind, Oblivion), не считая дополнений и ответвлений (Battlespire, Redguard). Само собой разработка игр в прошлом и сейчас — две разные вещи. The Elder Scrolls VI до сих пор находится на этапе предварительного производства и должна стать следующей крупной игрой Bethesda Game Studio после Starfield. Фанатам «Древних свитков», таким образом, ещё повезло: потенциальная Fallout 5 стоит в очереди даже после TES VI. Вредонос Smoke Loader получил функцию обнаружения местоположения жертвы через триангуляцию Wi-Fi

25.08.2023 [14:17],

Дмитрий Федоров

Специалисты Secureworks, американской компании, специализирующейся на кибербезопасности, обнаружили новую функцию вредоносного ПО Smoke Loader. Выяснилось, что оно способно определять местоположение заражённого ПК с помощью триангуляции Wi-Fi. Этот метод редко встречается среди хакерских инструментов, но его потенциальное применение может быть направлено на запугивание жертвы.

Источник изображения: geralt / Pixabay Smoke Loader — это вредоносное ПО, известное специалистам по безопасности уже многие годы. Оно было создано, чтобы загружать и устанавливать на ПК дополнительные вредоносные программы, что в свою очередь позволяет злоумышленникам контролировать заражённую систему. Недавно исследователи из Secureworks обнаружили новую функцию этого вредоноса, которую они назвали Whiffy Recon. Она каждую минуту определяет местоположение заражённого ПК, анализируя сигналы ближайших точек доступа Wi-Fi. Для этого Whiffy Recon использует Google Maps Geolocation API. Этот сервис был создан для устройств, не имеющих встроенного GPS, и он определяет местоположение устройства на основе данных о близлежащих Wi-Fi-точках доступа и сотовых вышках. Зачем киберпреступникам знать местоположение жертвы? Специалисты Secureworks предполагают, что данная информация может быть использована для запугивания: например, чтобы угрожать пользователю или давить на него, зная, где он находится. Как отметил Дон Смит (Don Smith), вице-президент Secureworks, такая возможность вредоносного ПО редко используется киберпреступниками. В отдельности эта функция не позволяет быстро получить прибыль. Однако реальность такова, что она может быть использована для реализации любых преступных мотивов. Для минимизации рисков, связанных с вредоносным ПО, рекомендуется следующее:

Dropbox ограничила безлимитное облачное хранилище из-за злоупотреблений

25.08.2023 [14:09],

Павел Котов

Служба облачного хранения данных Dropbox решила из-за злоупотреблений ввести ограничения на свой безлимитный тарифный план: вместо того, чтобы предоставлять пользователям «столько места, сколько необходимо», компания примет меры к клиентам, которые заняли более 15 Тбайт облачного пространства.

Источник изображения: fernando zhiminaicela / pixabay.com Компания изменила политику из-за злоупотреблений: использования облачного пространства для майнинга криптовалюты, его перепродажи третьим лицам, а также использования сервиса в личных целях лицами, которые не имеют отношения к корпоративным клиентам. «В последние месяцы мы обнаружили всплеск такого поведения. Мы обратили внимание, что подобные клиенты часто потребляют в тысячи раз больше места для хранения данных, чем наши настоящие бизнес-клиенты», — заявила администрация службы. Результаты проверки показали, что 1 % клиентов Dropbox занял более 35 Тбайт на одну лицензию, предусматривающую трёх пользователей с оплатой $24 в месяц на каждого. Компания преимущественно пользуется собственной инфраструктурой, но также сохраняет присутствие в облаке Amazon Web Services — тарифы её службы Simple Storage Service предусматривают оплату в $0,023 за 1 Гбайт в месяц при потреблении менее 50 Тбайт, а значит, за 35 Тбайт придётся платить $805 в месяц (ёмкость хранилища рассчитывается по десятичной системе, при которой 1 Тбайт равен 1000 Гбайт). При этом Dropbox всё-таки должна работать в прибыль.

Источник изображения: Glenn Carstens-Peters / unsplash.com Dropbox объяснила нововведение тем, что стремилась предоставить «столько места, сколько необходимо для работы бизнеса или организации, но не давала неограниченного пространства для любого варианта использования». В компании также поняли, что невозможно дать универсальных определений «приемлемых» и «неприемлемых» сценариев использования её ресурсов — отказаться от безлимитного предложения оказалось проще. Теперь данный тарифный план предложит всего 15 Тбайт пространства для трёх пользователей, и с добавлением каждого последующего этот показатель будет увеличиваться на 5 Тбайт. Нынешним клиентам, которые используют менее 35 Тбайт хранилища на одну лицензию, в ближайшие пять лет смогут пользоваться уже занятым пространством на прежних условиях и получат бонусные 5 Тбайт. Тем же, кто превысил отметку в 35 Тбайт, Dropbox предложит 5 Тбайт на ближайший год без дополнительной платы, но им придётся дать пояснения и «обсудить ряд вариантов получения хранилища, необходимого для вашего бизнеса или организации». Внедрение новой политики начнётся 1 ноября — все пользователи будут уведомляться о касающихся их изменениях за 30 дней. Тем же, кто решит отказаться от услуг Dropbox, придётся непросто: сервис ограничил скачивание объёмом 20 Гбайт и до 100 тыс. файлов в день. Если заняты более 35 Тбайт пространства, загрузка займёт очень продолжительное время. Количество DDoS-атак на российскую IT-инфраструктуру удвоилось

25.08.2023 [13:30],

Сергей Карасёв

Россия по итогам II квартала 2023 года оказалась на девятом месте в мире по общему количеству зарегистрированных DDoS-атак. Как сообщает компания «Гарда», ситуация в данной сфере значительно ухудшилась. В период с апреля по июнь включительно на российскую IT-инфраструктуру пришлось 2,3 % от общего числа DDoS-атак в мире. Это в два раза больше по сравнению с I четвертью текущего года. По оценкам, в I квартале 2023 года количество DDoS-атак в России составило приблизительно 385 тыс. Абсолютные значения за II четверть года не приводятся, но говорится, что по сравнению с тем же периодом 2022-го показатель увеличился на 28 %. При этом число атак на правительственные организации подскочило за год на 118 %, на энергетический сектор — на 74 %, на нефтяную отрасль — на 53 %. В исследовании «Гарда» говорится, что по сравнению с I кварталом 2023 года, во II четверти года несколько изменилось распределение активности по дням недели. Число атак в пятницу и воскресенье снизилось по отношению к предыдущему периоду, а заметный рост наблюдается по вторникам и средам. Зафиксирован рост TCP-флуда: доля таких атак достигла — 18 %. Суммарная доля TCP ACK и TCP SYN составила 42 %, UDP-флуд по-прежнему занимает второе место. При этом число таких атак сократилось с 47 % до 24 %, стабилен уровень атак типа DNS Amplification —в районе 9-10 %. Доля NTP Amplification значительно выросла —с 1 % до 10 %. Отмечается, что основная часть DDoS-атак реализуется с использованием ботнетов, в состав которых входят компьютеры не только компаний, но и обычных пользователей по всему миру. В техническом плане сложность таких киберпреступных кампаний постоянно растёт. DDoS-атаки организуются на канальный уровень, сетевую инфраструктуру, TCP/IP-стек и уровень приложения. Наибольшее количество атак во II квартале 2023 года пришлось на США — около 33,5 % от общего числа. На втором месте находится Китай с результатом в 10 %. Количество атак с территории России снизилось: их доля сократилась с 3,09 % до 2,11 %. Лидерами по данному показателю являются Китай (38 %), Индия (24 %) и Южная Корея (10 %). Китайская электроника успешно потеснила привычные бренды на прилавках российских магазинов

25.08.2023 [12:52],

Владимир Фетисов

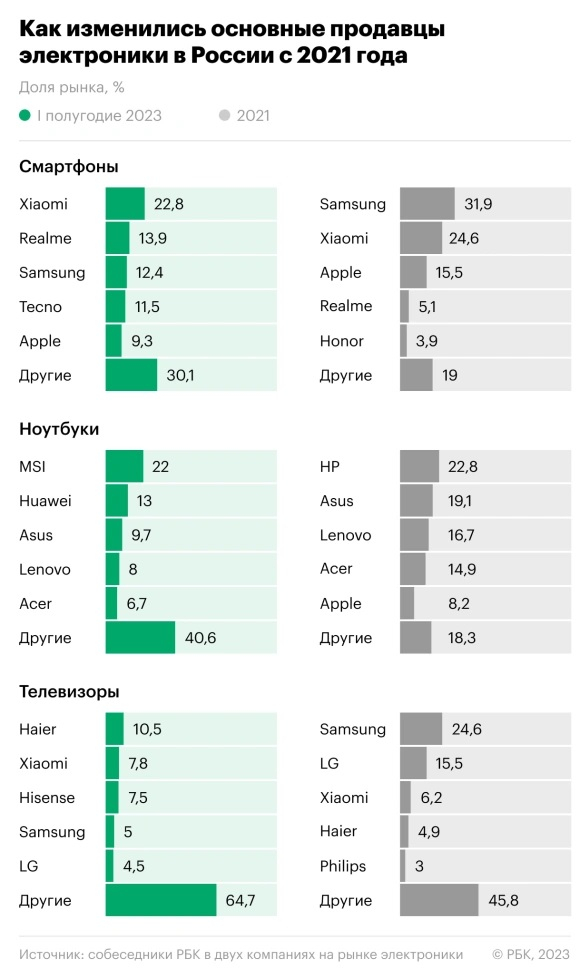

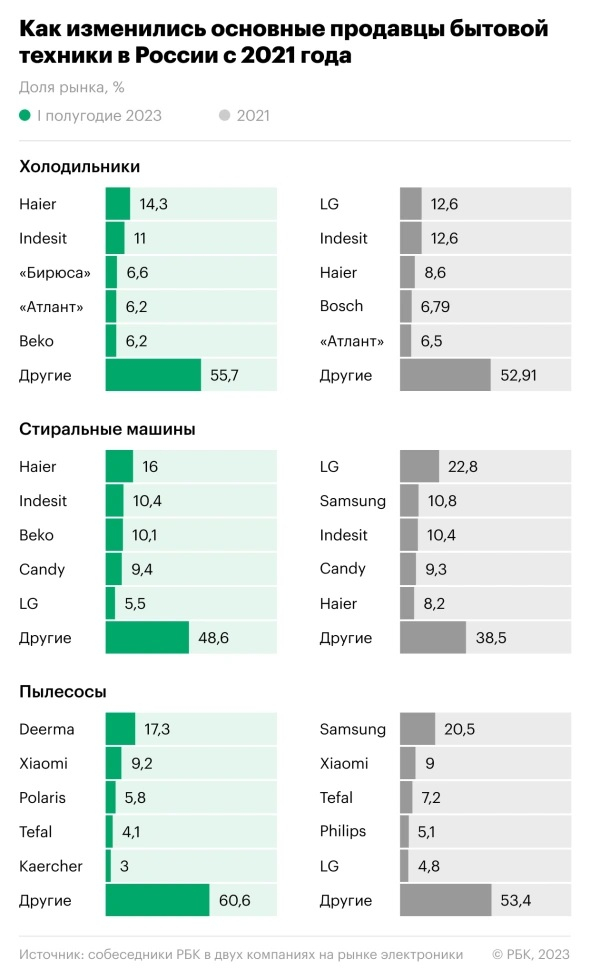

Китайская и турецкая бытовая электроника и техника серьёзно потеснили изделия привычных производителей на прилавках российских магазинов. Так южнокорейская Samsung потеряла лидерство сразу в нескольких категориях: доля компании в сегментах смартфонов, телевизоров и пылесосов существенно снизилась. На основе данных от собственных источников на рынке электроники РБК подготовил инфографику, которая наглядно демонстрирует произошедшие с тех пор изменения.

Источник изображения: Headway/unsplash.com Доля ещё одной южнокорейской компании LG также снизилась в нескольких категориях, а позиции американской Apple ухудшились в сегментах смартфонов и ноутбуков. На этом фоне ощутимо выросли доли китайских брендов Haier, Huawei, Tecno, Deerma и турецкого производителя крупной бытовой техники Beko. В сегменте ноутбуков на лидирующую позицию вышла тайваньская MSI, хотя прежде компания не входила даже в первую пятёрку. С весны 2022 года многие иностранные бренды приостановили или полностью прекратили работу в России на фоне санкций США и ЕС, проблем с логистикой и общественного давления. Samsung, LG, HP, Bosch и Apple прекратили поставки в страну своей техники ещё в марте 2022 года. В дополнение к этому некоторые компании приостановили сборку техники на заводах, находящихся на территории России. В прошлом году заработала схема параллельного импорта, позволяющая ввозить в страну товар без разрешения правообладателя. За счёт этого удалось частично компенсировать отсутствие официальных поставок.

Источник изображения: РБК В Ozon изменения относительно лидеров на российском рынке электроники связывают с возросшими преимуществами компаний из Китая. «Очень активно растут китайские производители, в том числе за счёт хорошего соотношения «цена-качество», а также активной маркетинговой деятельности и сервисной поддержки, в то время как корейские, европейские и американские бренды теряют долю», — рассказал представитель маркетплейса. В «М.Видео-Эльдорадо» также отметили изменения в потребительском поведении. Для многих покупателей бренд уже не является определяющим фактором при выборе. «В условиях структурных изменений потребители демонстрируют достаточно лояльное отношение и готовы выбирать конкурентоспособные новые или ранее менее известные для них торговые марки. При этом важным фактором, кроме стоимости, является доверие к месту покупки, а также наличие гарантийного обслуживания», — сообщил представитель компании.

Источник изображения: РБК По подсчётам «М.Видео-Эльдорадо», в первом полугодии 2023 года 70 % штучных продаж смартфонов на рынке приходилось на китайские бренды. За счёт этого в топ-10 восемь мест занимают китайские бренды, включая первую строку, а Samsung и Apple опустились на третье и четвёртое места соответственно. В сегменте ноутбуков китайские компании занимают 40 % рынка в штучном выражении. В «Яндекс.Маркете» сообщили, что статистика продаж телевизоров отличается от общей тенденции. «А-бренды всё ещё занимают существенную долю (лидеры LG, Xiaomi и Samsung), тем не менее наблюдаем увеличение спроса на телевизоры китайских брендов — это Xiaomi, усиливается доля Haier. Мы также ожидаем сильного роста Hisense и TCL», — отметил представитель маркетплейса. Медитативное приключение Jusant от создателей Life is Strange предложит взобраться на загадочную башню — дата выхода и геймплейный трейлер

25.08.2023 [12:44],

Дмитрий Рудь

Французская студия Don’t Nod (бывшая Dontnod Entertainment), известная по Remember Me, Life is Strange и Vampyr, объявила дату выхода своего альпинистского приключения Jusant. Анонс сопровождался геймплейным трейлером. По сюжету на каменной башне посреди бескрайнего бурного моря жила цивилизация, спускаясь с отливом порыбачить и добыть продукты. Когда море в конце концов высохло, люди покинули башню и разбрелись кто куда. Спустя много лет главный герой Jusant решает проделать путь в обратную сторону — вверх по башне. В путешествии безымянного протагониста сопровождает живущее в его рюкзаке водянистое создание, которого разработчики зовут Балластом. Jusant (в переводе с французского значит отлив) позиционируется как экшен-головоломка с медитативным характером — по башне можно взбираться в своём темпе, исследовать альтернативные маршруты и раскрывать секреты древней цивилизации. Для успешного подъёма на изменчивую и загадочную башню игрокам предстоит освоить своё снаряжение для альпинизма (продумывать, как лучше использовать доступные инструменты) и следить за расходом выносливости. Скриншоты Jusant

Помимо прочего, разработчики Jusant обещают «захватывающие дух биомы, полные флоры и фауны», «спокойный и атмосферный саундтрек», а также поддержку русского языка (судя по описанию в Steam, озвучки в игре не будет). Как стало известно, Jusant поступит в продажу 31 октября текущего года для PC (Steam, Microsoft Store), PlayStation 5, Xbox Series X и S. Со дня релиза проект также будет доступен в подписке Game Pass. Главная страница настроек Windows 11 будет адаптироваться под пользователя

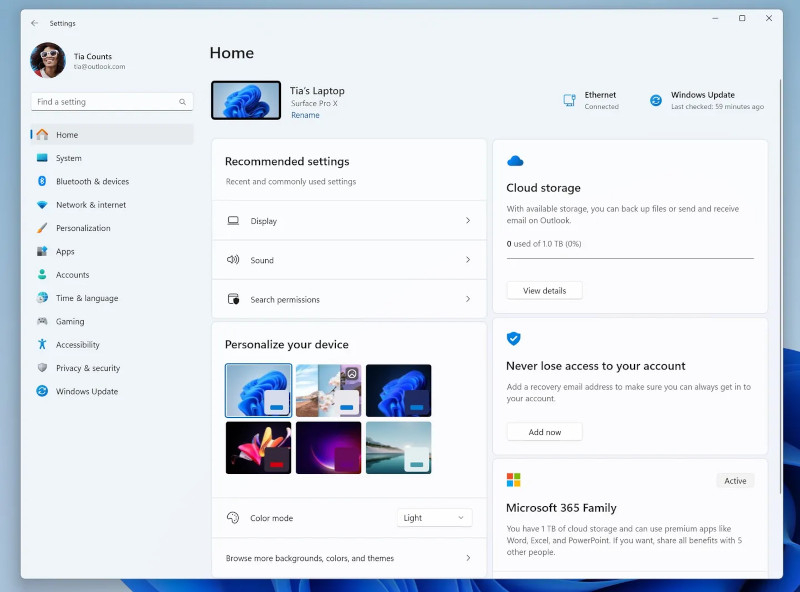

25.08.2023 [12:42],

Дмитрий Федоров

Microsoft активно работает над внедрением новой главной страницы настроек в Windows 11. В последнем обновлении, представленном участникам программы Windows Insiders, компания добавила главную страницу с интерактивными карточками. Они позволяют быстро переходить к различным настройкам, таким как персонализация устройства, управление Bluetooth, восстановление учётной записи и многим другим.

Источник изображения: PabitraKaity / Pixabay Главная страница настроек будет адаптироваться к индивидуальным потребностям каждого пользователя. Основываясь на анализе «специфических паттернов использования», система будет предлагать рекомендуемые настройки, которые могут быть наиболее актуальными для пользователя. Так, если пользователь часто изменяет параметры дисплея или настраивает звук, эти опции будут представлены на видном месте, обеспечивая быстрый и удобный к ним доступ. На странице также будут отображаться информация о доступном объёме облачного хранилища в OneDrive и статус подписки на Microsoft 365 и Xbox. По словам Microsoft, поначалу меню будет содержать до семи карточек, но в будущем планируется увеличить их количество. Компания впервые начала тестирование этой функции в июне.

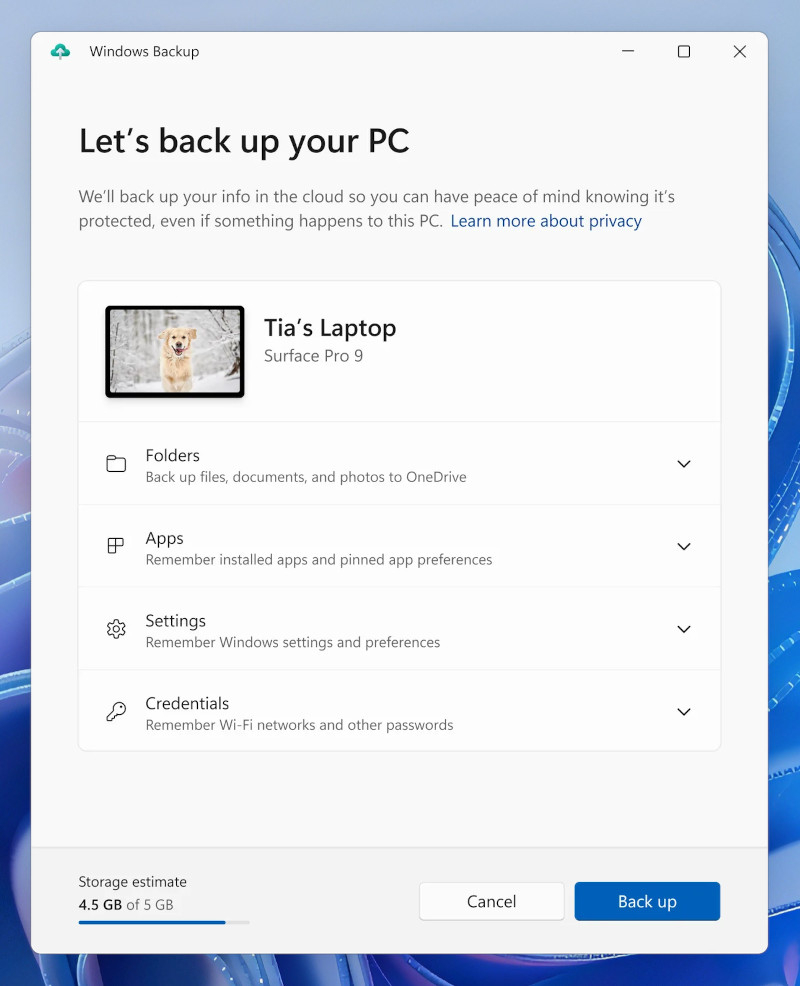

Обновлённая домашняя страница содержит рекомендуемые настройки, учитывающие активность пользователя (источник изображения: Microsoft) Ещё одной интересной функцией, которую Microsoft может скоро выпустить в широкий доступ, является приложение Windows Backup. Впервые представленное в мае, оно позволяет создавать резервные копии ПК перед переходом на новое устройство. Помимо автоматического применения текущих пользовательских настроек к новому ПК, приложение также сохранит все закреплённые приложения на рабочем столе, в меню «Пуск» и на панели задач. Microsoft утверждает, что ранее установленные приложения не будут автоматически устанавливаться на новый ПК. Пользователю будут даны ярлыки, которые перенаправят его в Microsoft Store или на сайт разработчика для их установки.

Так выглядит приложение Windows Backup (источник изображения: Microsoft) Стоит уделить внимание обновлению функции динамической подсветки (Dynamic Lighting). Первоначально она предназначалась для управления RGB-подсветкой в Windows 11 с помощью открытого стандарта HID LampArray. После обновления пользователи Windows 11 смогут не просто адаптировать подсветки, но и синхронизировать цвет акцента Windows с цветами своих периферийных устройств. Это позволит создать гармоничное и единое визуальное пространство рабочего места. Кроме того, пользователи получат возможность устанавливать индивидуальные цветовые схемы для различных устройств, делая окружающее пространство ещё более персонализированным и комфортным. Все перечисленные функции включены в сборку Windows 11 Insider Preview Build 22631.2262, которая доступна участникам Beta Channel. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |