|

Опрос

|

реклама

Быстрый переход

Некоторые разработки для российских чипов «Байкал Электроникс» уйдут с молотка

24.08.2023 [12:42],

Сергей Карасёв

Компания «Т-Платформы» в рамках процедуры банкротства, по сообщению газеты «Коммерсантъ», выставила на торги права на разработки и патенты «Байкал Электроникс» — поставщика отечественных процессоров Baikal. Реализуемые активы оцениваются почти в 500 млн руб. Говорится, что с молотка уйдут 3,46 млн акций АО «Байкал Электроникс», которые принадлежат «Т-Платформам». Речь идет об 1 % разработчика процессоров, а начальная стоимость этого пакета ценных бумаг составляет приблизительно 2 млн руб. Сама «Байкал Электроникс» два года назад перешла под контроль ГК «Вартон». Кроме того, на торги выставлены результаты интеллектуальной деятельности «Байкал Электроникс», используемые, в частности, при разработке и производстве микропроцессоров «Байкал-М», материнских плат, компонентов для ноутбуков, блейд-серверов и другой электроники. В общей сложности за продаваемые активы «Т-Платформы» рассчитывают получить 484 млн руб. Однако участники рынка сомневаются в ценности реализуемых разработок. Дело в том, что «Байкал-М» — это уже устаревший процессор. А специалистов, знакомых с конструкцией этих чипов и способных развивать его, найти трудно. Эксперты говорят, что значительно проще разработать продукт заново, чем пытаться адаптировать решения «Т-Платформ». С другой стороны, интеллектуальная собственность может быть актуальна для инженеров других компаний в качестве «учебного материала». Российский рынок соревновательных онлайн-игр превысил $3 млрд и вышел на седьмое место в мире

24.08.2023 [12:30],

Павел Котов

Издание Forbes со ссылкой на совместное исследование ex corp. и Nielsen сообщает, что размеры российского рынка соревновательных игр достигают $3,1 млрд в год. По размерам игровых трат Россия вышла на седьмое место в мире.

Источник изображений: ELLA DON / unsplash.com Соревновательными играми в России увлекаются 11,5 млн человек — это 7,8 % от населения страны, которое составляет 146,1 млн человек. Среднемесячные расходы геймеров на внутриигровые покупки по итогам 2022 года составили $22,3, а значит, что объём российского рынка составляет $3,1 млрд. По этому показателю Россия занимает седьмое место в мире, уступая США ($16,5 млрд), Китаю ($9,8 млрд), Японии ($7,2 млрд), Южной Корее ($6,4 млрд), Великобритании ($4,4 млрд) и Франции ($3,3 млрд) — объём общемирового рынка составляет $64,4 млрд. Под соревновательными подразумеваются игры, в которых участники состязаются друг с другом в попытке получить наилучший результат — сравнить свои навыки, одержать победу и подняться в рейтинге. В число таких проектов входят, в частности, CS:GO, Dota 2, League of Legends и Valorant. Реальные деньги уходят на внутриигровое оружие, различные артефакты или внешний вид персонажа. Объём только вторичного рынка игровых товаров в Dota 2 и CS:GO по России за 2021 год составил $450 млн. Ещё одной статьёй расходов является загружаемый контент (DLC), который приобретается и скачивается после выхода основной игры. В нём открываются новые возможности, предметы, персонажи, уровни и т.д. Предлагаются также боевые пропуски, включающие дополнительные награды — часть этих средств идёт в призовые фонды киберспортивных турниров.  Опрошенные Forbes эксперты не смогли прийти к единому мнению в отношении исследования ex corp. и Nielsen. Существуют и другие данные, согласно которым, например, весь игровой российский рынок в 2021 году составил от $2,21 млрд до $2,8 млрд, а значит, показатель в $3,1 млрд только на соревновательные игры представляется существенно завышенным. По другим данным, весь рынок игр в России в 2021 году был $1,8 млрд, а в 2022 и 2023 годах он не демонстрировал роста и едва ли мог превышать $600 млн в год или $50 млн в месяц. С другой стороны, россияне на самом деле чрезвычайно активны в игровом пространстве: на платформе Steam русский язык уступает только китайскому и английскому. Российские киберспортсмены одерживают победы на международных состязаниях, а вокруг Dota 2, CS:GO и других популярных игр сформировались стойкие сообщества и экосистемы. При этом россияне менее склонны платить в играх, а с учётом введённых в отношении страны санкций транзакции оказываются ещё и непростой задачей. Rocket Lab впервые запустила ракету Electron с б/у двигателем

24.08.2023 [12:28],

Геннадий Детинич

Компания Rocket Lab шагнула в сферу повторно используемых компонентов ракет-носителей. Сегодня в 11:45 по местному времени (02:45 мск) с площадки в Новой Зеландии в космос был отправлен спутник на ракете Electron, один из девяти двигателей которой впервые был использован повторно. Запуск прошел успешно, спутник выведен на целевую орбиту. Дальше компания расширит свой опыт по использованию бывших в употреблении компонентов ракет.

Источник изображения: Rocket Lab Поскольку ракета Electron довольно небольшая — всего 18 м в высоту — она не может нести достаточный для приземления на двигателях запас «лишнего» топлива. Поэтому отработавшая ракета на парашюте опускается в океан, что не очень хорошо с точки зрения коррозийной безопасности, но реализуется довольно просто. В качестве альтернативы компания пытается научиться подхватывать ракету в воздухе вертолётом за стропы парашюта. Однако пока все попытки сделать это были провальными. Нырнувшую в волны океана ракету буксируют к берегу и разбирают для оценки состояния узлов. Изношенные детали меняются на новые. Пока компания рискнула повторно испытать только один двигатель первой ступени из девяти. Сообщается, что ранее он был использован для запуска спутника в мае этого года. Старт и полёт ракеты с одним использованным ранее двигателем состоялся и прошёл по заданной программе. На орбиту высотой 640 км был выведен спутник дистанционного радарного зондирования земли компании Capella Space из Сан-Франциско. Для Rocket Lab это был 40-й по счёту запуск. Он был запланирован на конец июля, но состоялся только сейчас. Volkswagen перешла на прямые закупки чипов у десяти поставщиков, чтобы избежать нового дефицита

24.08.2023 [12:08],

Алексей Разин

В условиях пандемии места на конвейере для массовых и при этом не особо выгодных производителям автомобильных чипов осталось не так много, поэтому от их дефицита начали страдать многие автопроизводители. Концерн Volkswagen предпочёл с учётом такого опыта заключить прямые соглашения на поставку чипов с десятью производителями, чтобы избежать дефицита в будущем.

Источник изображения: Volkswagen До сих пор, как отмечает Reuters, второй по величине автопроизводитель в мире полагался в сфере поставок полупроводниковых компонентов на своих поставщиков автомобильных компонентов, но с прошлого октября Volkswagen перешёл на прямые контракты с разработчиками и производителями чипов типа NXP Semiconductors, Infineon Technologies и Renesas Electronics. Об этом заявили представители автопроизводителя, отвечающие за снабжение компании подобными компонентами. Как они поясняют, объёмов поставляемых на мировой рынок чипов для нужд автопрома всё равно не хватает, поэтому нужно проявлять дополнительную активность в этом вопросе. В июле прошлого года Volkswagen начала сотрудничать с франко-итальянской компанией STMicroelectronics в рамках разработки полупроводниковых компонентов нового поколения, так что европейский автогигант расширяет партнёрство с производителями чипов не только в сфере поставок. Крупнейший контрактный производитель чипов — тайваньская компания TSMC, пока не заключила с Volkswagen прямого контракта, но встречается с представителями автоконцерна каждые несколько недель для обсуждения ситуации с поставками. Представители Volkswagen также пояснили, что автогигант намеревается сократить номенклатуру используемых полупроводниковых компонентов, чтобы упростить их закупки. Одновременно это позволит оптимизировать ассортимент программного обеспечения, которое нужно сопровождать и обновлять. Google усилит защиту аккаунтов Gmail и потребует верификации для изменения ряда настроек

24.08.2023 [12:04],

Дмитрий Федоров

Google объявила о введении дополнительных мер безопасности для своего почтового сервиса Gmail. Теперь при попытке добавления адреса для переадресации или редактирования фильтров может потребоваться дополнительная верификация. Это поможет предотвратить ситуации, когда злоумышленники, получившие доступ к аккаунту, могут изменять настройки без ведома владельца.

Источник изображения: Google В частности, Google ввела дополнительные проверки для следующих сценариев:

Если пользователь попытается изменить эти настройки, Google сочтёт такое действие рискованным и предложит подтвердить, что его совершает владелец аккаунта. Дополнительная защита доступна всем клиентам Google Workspace и владельцам личных аккаунтов Google. Однако стоит отметить, что данная функция поддерживается только для пользователей, повсеместно использующих сервисы Google и указавших в настройках аккаунта все необходимые идентификационные данные. Введение дополнительных мер безопасности в Gmail — ещё один шаг Google на пути к обеспечению надёжной защиты данных своих пользователей. В эпоху цифровых технологий и постоянно растущих киберугроз, такие инициативы становятся не просто желательными, но и необходимыми для сохранения доверия к онлайновым сервисам и безопасности пользовательской информации. Blackview готовит к выходу флагманский смартфон A200 Pro с чипом Helio G99 и 108-Мп камерой

24.08.2023 [12:00],

Владимир Мироненко

В Сети появились сообщения о подготовке компанией Blackview бизнес-флагмана A200 Pro с AMOLED-экраном с частотой обновления 120 Гц, 6-нм чипом Helio G99 и поддержкой быстрой 66-Вт зарядки. Отметим, что Blackview проведёт акцию к запуску новинки, в рамках которой первые покупатели смогут приобрести смартфон A200 Pro со скидкой, а также получат ценные подарки.  Грядущий смартфон A200 Pro, по данным источников, оснащён 16-мегапиксельной селфи-камерой с сенсором производства Samsung. На задней панели размещена тройная камера, включающая 108-мегапиксельный сенсор Samsung ISOCELL HM6 (оптический формат 1/1,67 дюйма, размер пикселя 0,64 мкм) с поддержкой оптической стабилизации, а также 8-мегапиксельный датчик с широкоугольной оптикой (угол поля зрения — 117°) и 2-мегапиксельный датчик для макросъёмки. Как сообщается, благодаря использованию передовых алгоритмов Blackview ArcSoft 6.0 качество фотосъёмки повышается на 15 %. Blackview A200 Pro базируется на мощном 6-нм восьмиядерном процессоре MediaTek Helio G99 (два ядра Cortex-A76 с частотой до 2,2 ГГц и шесть ядер Cortex-A55 с частотой до 2,0 ГГц) с графическим ускорителем GPU Mali-G57 MC2. Объём оперативной памяти LPDDR4X составляет до 24 Гбайт, включая виртуальное расширение на 12 Гбайт за счёт флеш-памяти, ёмкость флеш-накопителя UFS 2.2 равна 256 Гбайт. Объём памяти можно расширить ещё на 1 Тбайт с помощью карты microSD. Мощный процессор в сочетании с ОЗУ LPDDR4X позволяет справляться с ресурсоёмкими приложениями, тяжёлыми играми, а также обеспечивать стабильную работу в многозадачном режиме. По словам источников, A200 Pro оснащён 6,67-дюймовым изогнутым экраном AMOLED, защищённым от царапин и повреждений прочным стеклом Corning Gorilla Glass 5, обладающим разрешением 2,4K и адаптивной динамической частотой обновления до 120 Гц. Также известно, что дисплей смартфона получил сертификат TÜV SÜD Low Blue Light, подтверждающий пониженный уровень вредного для глаз излучения в синей части спектра. Как сообщается, A200 Pro будет поставляться с обновлённой DokeOS 4.0 на базе Android 13, созданной специально для бизнеса и имеющей больше клиентоориентированных приложений, таких как EasyShare Business App и Workspace Business App, а также дополнительные функции, более интуитивно понятный и удобный интерфейс. Также смартфон получит два слота для SIM-карт 4G и батарею ёмкостью 5050 мА·ч, обеспечивающую до 24 дней автономной работы в режиме ожидания и поддерживающую быструю зарядку мощностью 66 Вт. Сообщается, что Blackview A200 Pro поступит в продажу на AliExpress по цене со скидкой в размере $219,99, которая будет действовать в течение недели с 21 по 27 августа 2023 года. Кроме того, для первых 1000 покупателей смартфон будет стоить ещё дешевле — всего $199, причём для первых 200 заказов предусмотрены наушники Blackview AirBuds 4 в подарок. Alienware представила ещё один монитор с частотой обновления 500 Гц — с AMD FreeSync Premium и на 20 % дешевле прежнего

24.08.2023 [11:57],

Павел Котов

Игровой монитор Alienware AW2524H с частотой обновления экрана до 500 Гц считается самым быстрым в мире, но его стоимость составляет $830. Dell предложила его обновлённую версию с кодовым обозначением AW2524HF, отличием которой является отказ от технологии NVIDIA G-Sync в пользу независимой от платформы AMD FreeSync Premium, а также более приятный ценник в $650.

Источник изображения: Dell Стоимость нового Alienware AW2524HF назвать гуманной тоже не получается, особенно если учесть, что речь идёт о 24-дюймовом мониторе с разрешением Full HD (1920 × 1080 точек). Но для киберспортсменов, которым высокая скорость работы критична, подобная жертва может выглядеть оправданной. Стандартно монитор работает с частотой до 480 Гц, но в режиме разгона частота достигает 500 Гц. В обоих случаях требуется подключение через DisplayPort. Тут же отметим, что поддерживаемая новинкой технология синхронизации изображения AMD FreeSync Premium совместима с видеокартами как от AMD, так и NVIDIA. Есть у новинки и сертификация VESA AdaptiveSync. К достоинствам монитора производитель относит панель Fast IPS с точной цветопередачей. Dell заявляет для новинки время реакции пикселя в 0,5 мс (GtG), яркость 400 кд/м2, контрастность 1000:1 и 99-процентный охват цветового пространства sRGB. Монитор имеет поддержку HDR10 и имеет угля обзора 178 градусов по вертикали и горизонтали. один вход DisplayPort 1.4 и два HDMI 2.1, квартет портов USB 3.2 для гаджетов и зарядки, крючок для наушников и шестиугольное основание. Есть и крепление VESA. От первой версии Alienware AW2524HF также отличает отсутствие RGB-подсветки на заднем логотипе. На сайте Dell новый монитор поступит в продажу 12 сентября. Epic Games начнёт выплачивать разработчикам 100 % доходов в обмен на эксклюзивность их игр

24.08.2023 [11:33],

Дмитрий Рудь

Сделать свою игру эксклюзивом Epic Games Store скоро станет ещё выгоднее. Студия Epic Games представила новую программу для сторонних разработчиков — «Первый релиз в Epic» (Epic First Run). Участники «Первого релиза в Epic» смогут в течение первых шести месяцев размещения игры или приложения в Epic Games Store увеличить свою долю прибыли от продаж с 88 % до 100 %. После полугода разделение вернётся к стандартным 88/12 %. Помимо увеличенной прибыли, участникам «Первого релиза в Epic» обещают отображение в магазине на главной странице и в специальных коллекциях, включая распродажи, события и авторские статьи. «Разработчики зарабатывают больше денег, Epic привлекает новых пользователей. Все в выигрыше», — прокомментировал анонс «Первого релиза в Epic» гендиректор Epic Games Тим Суини (Tim Sweeney). Программа «Первый релиз в Epic» открыта для всех разработчиков и издателей. Участвовать смогут игры/приложения, выходящие не раньше 16 октября 2023 года и прежде не выпускавшиеся в сторонних магазинах или подписках. Кроме того, участники программы «Первый релиз в Epic» смогут одновременно выпускать товар в собственных магазинах, в лаунчерах с прямой продажей или посредством продажи кодов активации Epic. Регистрация откроется в октябре. Цифровой магазин Epic Games Store открылся в декабре 2018 года. С тех пор аудитория сервиса достигла 230 млн пользователей. В марте Суини рассказывал, что стратегия эксклюзивов лучше всего себя показывает в случае с крупными релизами. Учёные с помощью ИИ в четыре раза ускорили преобразование мыслей в речь через нейроинтерфейс

24.08.2023 [11:30],

Геннадий Детинич

В журнале Nature вышли две статьи, в которых учёные рассказали о новых методиках трансляции мыслей пациентов с поражениями мозга в речь и эмоции. Преобразование мозговой активности в текст и голосовое общение происходит с помощью алгоритма машинного обучения. Учёным удалось увеличить скорость преобразования почти в четыре раза с 18 слов в минуту до 78. Это ниже среднего для обычного разговора темпа в 160 слов в минуту, но кратно быстрее, чем было до этого.

Источник изображений: Noah Berger/UCSF Нейродегенеративные заболевания, инсульты или травмы способны лишить человека речи разными способами, но один из них достаточно легко поддаётся исправлению. Современные технологии позволяют создать мостик между здоровыми участками мозга, отвечающими за речь или мысленное произношение, и мышцами, управляющими мимикой и позволяющими говорить. Естественный канал коммуникации между мышцами и мозгом может быть разорван в случае болезни или травмы, и тогда на помощь приходит интерфейс человек-компьютер и обучаемый алгоритм.  В мозг пациента встраивается датчик или несколько датчиков с электродами, входящими в зоны активности мозга человека, ответственные за произношение и речь (хотя учёные пока не до конца понимают, какие это зоны). В одном случае, например, учёные установили на речевую область сенсомоторной коры и на область верхней височной извилины женщины после инсульта 253 электрода. После болезни она не могла говорить и даже печатать.  В течение нескольких недель ИИ обучался на примере произношения пациенткой 1024 слов из специально подобранного словаря. Для упрощения работы алгоритма он разбивал все слова на фонемы, которых было всего 39. Затем словарный запас женщины был расширен до 125 тыс. слов. Машинный алгоритм смог распознавать мысленное произношение женщины с ошибками на уровне 25 %, но со скоростью до 78 слов в минуту. Алгоритм также научили распознавать эмоции пациентки — горе, радость, удивление. Наконец, используя старую видеозапись женщины, учёные создали её компьютерный образ — аватар — и заставили его транслировать текстовые сообщения в голосовые. По сути, они вернули пациентке возможность разговаривать. Сегодня подобные процедуры восстановления сопряжены с длительным обучением ИИ и необходимостью быть постоянно подключённым к компьютеру. Учёные из Калифорнийского университета в Сан-Франциско (UCSF) и Калифорнийского университета в Беркли, которые реализовали представленную методику, теперь работают над беспроводными вариантами транслятора. Когда-нибудь это повысит социальную вовлечённость людей с подобными медицинскими проблемами. «Это не я плачу, это ты плачешь»: анонсы новой Broken Sword и ремастера первой части довели фанатов до слёз

24.08.2023 [10:41],

Дмитрий Рудь

Разработчики из британской студии Revolution Software привезли на выставку gamescom 2023 сразу две приятные новости для фанатов Broken Sword — анонс новой игры серии и ремастера самой первой части. Новая игра называется Broken Sword: Parzival’s Stone и представляет собой уже шестой номерной выпуск в прославленной серии квестов. Знакомым по прошлым частям Джорджу и Нико предстоит предотвратить армагеддон. «Джордж и Нико воссоединяются, но скоро оказываются втянуты в ужасающий заговор в мире тайных охотников за сокровищами, жестоких средневековых историй и квантовой физики», — гласит описание игры. Broken Sword: Parzival’s Stone создаётся для ПК, консолей и мобильных устройств. Обещают «инновационный геймплей» формата point-and-click и «уникальный» визуальный стиль «супер 2D» (сочетание 2D-задников и 3D-геометрии). Что касается ремастера, то Broken Sword: Shadow of the Templars — Reforged предложит перерисованные задники, переработанную анимацию спрайтов, более качественный звук и поддержку разрешения 4K. Оригинальная Broken Sword: Shadow of the Templars вышла в далёком 1996 году, а Reforged планируется к релизу в начале 2024 года на ПК, консолях и мобильных устройствах. Тизер переиздания содержался в трейлере Parzival’s Stone. Parzival’s Stone — первая за почти 10 лет новая игра серии, поэтому фанаты Broken Sword в комментариях к анонсу предсказуемо встретили новость восторгами (а некоторые даже слезами): «Это не я плачу, это ты плачешь». GeForce RTX используют всего 47 % пользователей видеокарт NVIDIA

24.08.2023 [09:43],

Алексей Разин

В минувшем квартале выручка NVIDIA в игровом сегменте выросла последовательно на 11 % до $2,49 млрд и на 22 % в годовом сравнении, что позволило руководству заявить о нормализации ситуации со складскими запасами и уровнем спроса. Дальнейшая экспансия GeForce RTX не подвергается сомнению, поскольку трассировку лучей пока обеспечивают лишь видеокарты, находящиеся во владении у 47 % пользователей продукции NVIDIA.

Источник изображения: NVIDIA Как добавила финансовый директор NVIDIA Колетт Кресс (Colette Kress), не более 20 % находящихся в пользовании видеокарт этой марки обладают уровнем быстродействия GeForce RTX 3060 и более высоким, поэтому «возможности дальнейшей модернизации велики». «Спрос подогревался графическими решениями GeForce RTX 40 для настольных систем и ноутбуков. Конечный пользовательский спрос был стабилен и соответствовал сезонным тенденциям. Мы считаем, что спрос на мировом рынке со стороны конечных потребителей вернулся к росту после прошлогоднего замедления», — охарактеризовала итоги второго квартала в игровом сегменте Колетт Кресс. В сегменте ноутбуков спрос заметно вырос в ожидании начала сезона деловой активности, лидером стали графические процессоры GeForce RTX 4060. Ноутбуки на основе дискретной графики NVIDIA набрали популярность, и теперь в некоторых регионах они количественно превосходят объёмы поставок графических процессоров настольного класса, как призналась финансовый директор компании. Это должно обеспечить поддержку игровой выручке не только в прошлом, но и в текущем квартале, как она считает. Ноутбуки обычно пользуются повышенным спросом в преддверии начала учебного года и осенних предновогодних распродаж, запасы графических процессоров для которых производители должны формировать заблаговременно. Индийская лунная миссия «Чандраян-3» прислала первый снимок с поверхности Луны

24.08.2023 [09:25],

Геннадий Детинич

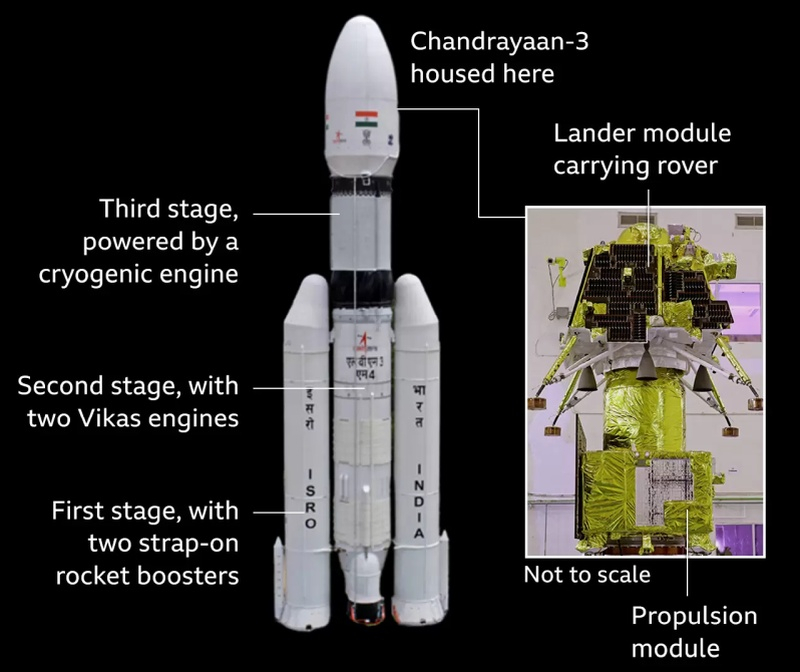

Успешная посадка индийского лунного модуля «Чандраян-3» (Chandrayaan-3) на поверхность естественного спутника Земли открыла дорогу к исследованию по-настоящему неизведанных пространств — южного полюса Селены. Бортовая камера модуля подтвердила мягкое прилунение и прислала первый снимок с места посадки. На изображении кроме лунной поверхности, довольно ровной, если судить по снимку, видна тень от одной из опор посадочного модуля. Где-то там должна быть и сама опора, судя по подписи к фотографии на страничке канала Индийской организации космических исследований (ISRO) в соцсети X (бывшая Twitter), но нам её не показали. Возможно это обрезанное фото.

Через день–два ожидается более насыщенная предметами фотосессия — с посадочного модуля должен сойти луноход для манёвренных исследований местности. На поверхности Луны луноход и станция будут оставаться в работоспособном положении около 14 земных суток или один лунный день. Индийские инженеры не стали усложнять задачи миссии и не обеспечили модулю и луноходу безопасную «зимовку». Зато вся программа уложилась в скромную сумму $74 млн. Это оказалось дешевле, чем снять кино о космосе в Голливуде, если сравнить стоимость миссии с кинофильмами «Гравитация» или «Марсианин».  Ракета-носитель с миссией «Чандраян-3» стартовала с площадки Космического центра им. Сатиша Дхавана (Satish Dhawan Space Centre) 14 июля. На лунную орбиту аппарат вышел 5 августа. Посадочный модуль «Викрам» (Vikram) с луноходом «Прагъян» (Pragyan) отделился от него 17 августа. Мягкая посадка модуля с луноходом состоялась днём 23 августа. Индия стала четвёртой страной, которая смогла сделать это, но также она стала первооткрывателем — в приполярной области ещё никто не спускался. По крайней мере, успешно. С 9 по 14 октября в Сочи пройдёт Российский форум «Микроэлектроника 2023»

24.08.2023 [08:59],

Владимир Мироненко

С 9 по 14 октября в Сочи пройдёт Российский форум «Микроэлектроника 2023», ставший за свою восьмилетнюю историю основной межотраслевой площадкой для общения профессионалов, специализирующихся на разработке, поставке и применении ЭКБ и РЭС.

microelectronica.pro Форум предоставляет возможности для полноценного диалога между разработчиками электронной компонентной базы и производителями готовой продукции, напрямую способствуя активному развитию цифровой экономики и привлекая внимание специалистов различных отраслей. Главные цели Российского форума «Микроэлектроника 2023»:

В программе форума указаны:

На выставочной территории Парка науки и искусства «Сириус», где пройдёт мероприятие, ведущие отечественные производители микроэлектроники и радиоэлектроники представят свои разработки в едином пространстве «Виртуальная среда микроэлектроники». В пленарных заседаниях форума примут участие:

В 2022 году в мероприятии приняли участие более 1700 руководителей и специалистов из 665 научных центров, госкорпораций, производственных предприятий, вузов, коммерческих структур, журналистов отраслевых СМИ и блогеров. В рамках научной конференции были заслушаны более 444 очных докладов, представивших достижения как в традиционных технологиях микроэлектроники, так и в перспективных высокотехнологичных областях, таких как: квантовые технологии, оптоэлектроника, материаловедение микро- и наноэлектроники. Состоялись 17 круглых столов, посвященных актуальным вопросам развития микроэлектроники и тесно связанных с ней отраслей. Свои стенды на выставке форума представили 74 организации. Google начала тестирование нового способа поиска песен на YouTube: их достаточно напеть

24.08.2023 [08:22],

Дмитрий Федоров

Google тестирует новый способ поиска песен на YouTube — просто напевая их голосом. Этот инновационный шаг, уже доступный ограниченному числу пользователей Android, может кардинально изменить то, как мы находим музыкальные композиции в интернете.

Источник изображения: SAM-RIZ44 / Pixabay В мире смартфонов поиск песни по звуку используется уже давно. Сервисы вроде Google Assistant и SoundHound позволяют добавлять треки в плейлист Spotify или воспроизводить клипы на YouTube. Однако новый способ поиска песни кажется более удобным, если вы не помните её название или другие детали. Google объявила о том, что экспериментирует с поиском песен на YouTube по напеву голосом. Кроме этого, пользователи могут использовать функцию определения песни, записав её фрагмент, который играет фоном, например, в кафе или на радио. Для активации функции необходимо переключиться из голосового поиска YouTube на поиск песен. После этого пользователь должен напеть или записать фрагмент песни в течение минимум 3 секунд. Затем система перенаправит его к соответствующему контенту на YouTube — официальному клипу, пользовательскому видео или короткому ролику Shorts. На этапе тестирования новый поиск доступен только ограниченному числу пользователей YouTube на Android. Перед тем, как он окажется в широком доступе, его характеристики могут измениться. Многие надеются, что компания добавит его и в YouTube Music. Кроме этого, Google тестирует ещё одну функцию для YouTube — «Полка канала» (Channel Shelf) в ленте подписок. Она позволит объединять несколько свежих публикаций одного автора на одной «полке». Таким образом, подписчикам не придётся переходить на YouTube-канал, чтобы увидеть недавние публикации. Google утверждает, что это нововведение снизит давление на авторов контента в плане частоты его публикаций. NVIDIA утверждает, что санкции США против КНР достигают своих целей

24.08.2023 [08:16],

Алексей Разин

Буквально в конце июня финансовый директор NVIDIA Колетт Кресс (Colette Kress) давала свою оценку влиянию американских санкций против сектора вычислений китайской компьютерной отрасли, но минувшее квартальное мероприятие вынудило её снова вернуться к этой теме. За два месяца в выдаваемых руководством NVIDIA характеристиках ничего не изменилось, разве что оно признало эффективность самих экспортных ограничений США.

Источник изображения: NVIDIA Колетт Кресс решила предвосхитить все сопутствующие вопросы, сославшись на ситуацию с санкциями в начале своего подготовленного выступления. Во-первых, она отметила, что знакома со слухами о возможности введения новых экспортных ограничений США в отношении Китая. Во-вторых, она добавила, что существующие ограничения достигают поставленных целей. «Учитывая силу спроса на наши продукты по всему миру, мы не ожидаем, что дополнительные экспортные ограничения по нашим GPU для ЦОД, если таковые будут приняты, будут иметь незамедлительное значительное влияние на наши финансовые результаты», — пояснила финансовый директор NVIDIA. «Однако, в долгосрочной перспективе ограничения на продажу наших GPU для ЦОД в Китае, если они будут приняты, приведут к потерям и окончательной утрате американской отраслью возможности лидировать и конкурировать на одном из крупнейших рынков мира», — добавила Колетт Кресс, во многом повторяя свои заявления двухмесячной давности. В прошлом квартале доля выручки в серверном сегменте на территории Китая у компании не отклонилась от исторических значений в диапазоне от 20 до 25 % от мировой. В эту долю включены не только вычислительные решения, но и телекоммуникационные. При этом сильнейший рост выручки в прошлом квартале был зафиксирован именно на рынке США, поскольку здесь сосредоточены многие разработчики систем искусственного интеллекта и провайдеры облачных услуг. Электромобили Tesla стали запирать своих владельцев внутри при проблемах с электропитанием

24.08.2023 [05:53],

Дмитрий Федоров

Владельцы электромобилей Tesla жалуются на то, что машины запирают их внутри после неожиданных проблем с электропитанием. О подобных инцидента стало известно после того, как британский автоблогер рассказал о проблеме, и с тех пор число жалоб только растёт.

Источник изображения: Tesla В конце прошлого года автоблогер Том Экстон (Tom Exton) рассказал своим подписчикам о том, как его новый электромобиль Tesla Model Y внезапно остановился на автостраде, несмотря на то, что заряда батареи должно было хватить более чем на 320 километров. После остановки Экстон не мог выйти из машины. Ему пришлось воспользоваться аварийным механизмом открытия двери, что привело к поломке окна. Все модели Tesla оснащены аварийными ручками для открытия дверей. Однако, найти их без инструкции может быть сложно, особенно в панической ситуации. Кроме Экстона, подобные проблемы возникли и у других владельцев Tesla. В июле 73-летний Рик Меггисон (Rick Meggison) из Аризоны рассказал о том, как оказался запертым в своём Model Y в гараже во время жаркого лета, когда температура внутри автомобиля может достигать 54 градусов Цельсия. Это произошло после того, как в его Model Y неожиданно пропало электричество. «Я не мог открыть двери. Я не мог опустить стекла. Компьютер сдох, и я не мог открыть бардачок. Я не мог ничего открыть», — рассказал Меггисон. К счастью, его сестре удалось открыть дверь с помощью мобильного приложения Tesla. На сегодняшний день известно, что десятки владельцев Tesla подали жалобы федеральным регуляторам США на внезапные блокировки их электромобилей. В ответ на это регуляторы рекомендуют водителям изучить аварийные механизмы своих электромобилей. Tesla пока не комментирует ситуацию, и поэтому многие водители могут узнать об этой проблеме слишком поздно. NVIDIA на волне ИИ-бума удвоила выручку до $13,51 млрд, а прибыль взлетела почти в 10 раз

24.08.2023 [04:17],

Алексей Разин

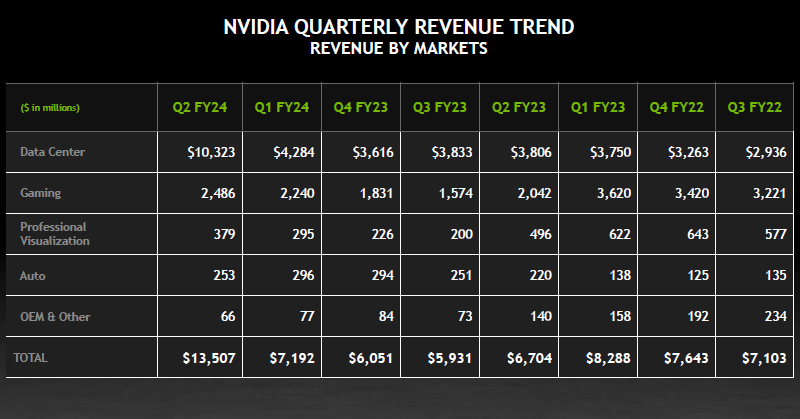

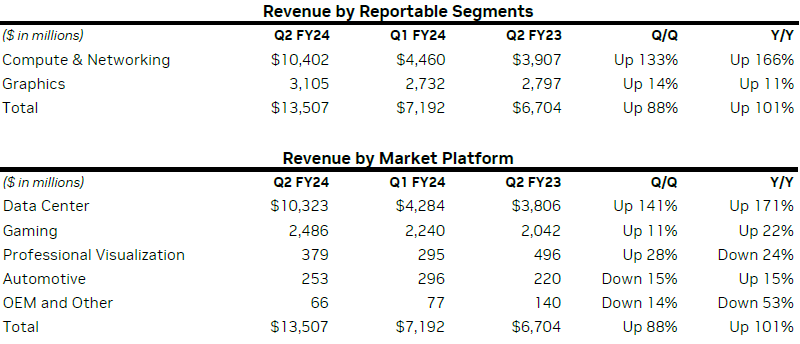

В конце июля в календаре NVIDIA завершился второй квартал 2024 фискального года, компания сегодня сообщила об увеличении выручки по его итогам на 101 % до $13,51 млрд. По сути, во многом это стало возможным именно благодаря достижению серверной выручкой NVIDIA рекордного значения в $10,32 млрд. На этом направлении выручка выросла на 141 % год к году и на 171 % последовательно. После закрытия торгов акции NVIDIA выросли в цене на 6,58 %.

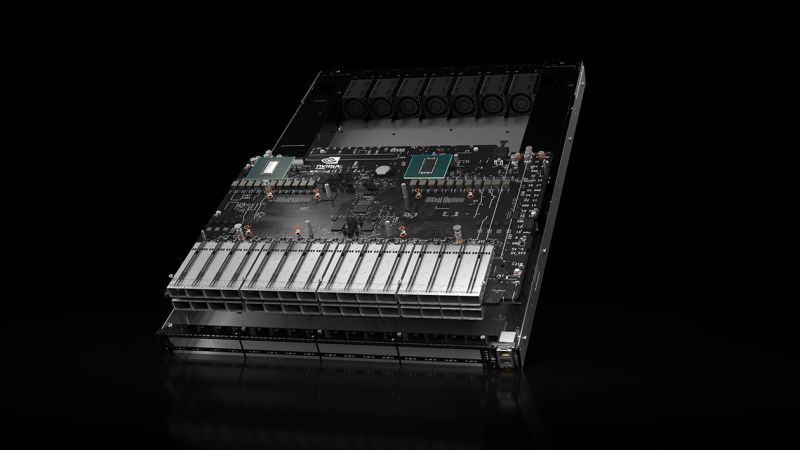

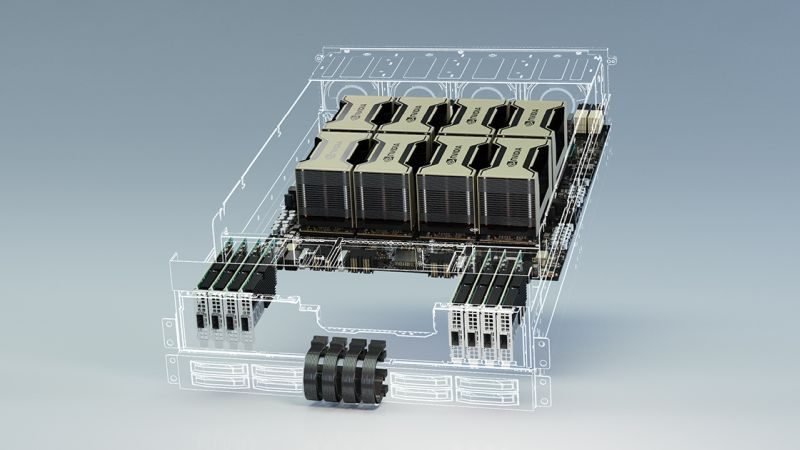

Источник изображений: NVIDIA Напомним, что аналитики в среднем ожидали достижения совокупной выручкой NVIDIA рубежа в $11,22 млрд по итогам минувшего квартала, поэтому выход на уровень в $13,51 млрд оказался для большинства из них сюрпризом и способствовал росту курса акций на 3,17 % ещё до закрытия торговой сессии. Последовательно выручка выросла на 88 %. Подогреть котировки акций NVIDIA смогла и за счёт объявления о намерениях потратить на их выкуп $25 млрд. К концу сентября компания также выплатит дивиденды из расчёта $0,04 на одну акцию. В минувшем квартале она вернула акционерам $3,38 млрд тем или иным способом. Чистая прибыль NVIDIA в годовом сравнении увеличилась почти в девять с половиной раз, до $6,19 млрд. Операционная прибыль взлетела в 13,6 раза до $6,8 млрд. Операционные расходы при этом выросли всего на 10 % до $2,67 млрд. Норму прибыли в годовом сравнении удалось поднять с 43,5 до 70,1 %. По словам представителей NVIDIA, существенное увеличение нормы прибыли отчасти объясняется тем, что год назад она была вынуждена списать $1,34 млрд из-за возникших складских излишков.

Распределение выручки по сегментам было предсказуемым. Вычисления и сетевое оборудование принесли NVIDIA в минувшем квартале $10,4 млрд, а графические решения — $3,1 млрд. Если в первом случае выручка выросла на 166 % в годовом сравнении и на 133 % в последовательном, то во втором всё ограничилось ростом на 11 % год к году и на 14 % последовательно. Рекордная выручка в сегменте центров обработки данных, как следует из комментариев финансового директора Колетт Кресс (Colette Kress), была обеспечена высоким спросом на платформу NVIDIA HGX (Hopper и Ampere одновременно), поскольку эти ускорители вычислений использовались при разработке больших языковых моделей и систем генеративного искусственного интеллекта. Непосредственно выручка от реализации ускорителей вычислений выросла на 195 % по сравнению с аналогичным периодом прошлого года, а последовательно она увеличилась на 157 %, и в последнем случае влияние оказало появление на рынке ускорителей поколения Hopper.  Сопутствующие сетевые решения Mellanox увеличили выручку на 94 % год к году и на 85 % последовательно. Выручка NVIDIA в игровом сегменте увеличилась на 22 % в годовом сравнении и на 11 % последовательно, до $2,5 млрд, тоже превысив ожидания аналитиков ($2,38 млрд). По словам Колетт Кресс, это стало возможным за счёт спроса на графические решения серии GeForce RTX 40 в условиях нормализации складских запасов. В сегменте ноутбуков спрос на компоненты NVIDIA оказался особенно высоким. Выручка NVIDIA в сегменте средств профессиональной визуализации сократилась на 24 % в годовом сравнении, но выросла на 28 % в последовательном, до $379 млн. Если в первом случае негативное влияние оказало затоваривание складов, то положительный эффект обеспечил интерес потребителей к профессиональным решениям с архитектурой Ada Lovelace. Выручка в автомобильном сегменте сократилась последовательно на 15 % до $253 млн, но выросла год к году на те же 15 %. Последовательное снижение вызвано падением спроса на автомобили, особенно на китайском рынке. Рост выручки в годовом сравнении обусловлен планомерным продвижением решений NVIDIA для систем автопилота. В текущем фискальном квартале NVIDIA рассчитывает выручить $16 млрд. При этом норма прибыли будет лежать в диапазоне от 71,5 до 72,5 %. Такой прогноз оказался выше ожиданий аналитиков, которые в среднем упоминали $12,61 млрд в качестве ориентира по величине квартальной выручки. Если прогноз NVIDIA сбудется, то компания по итогам текущего квартала увеличит свою выручку на 170 %. Основатель компании Дженсен Хуанг (Jensen Huang) на квартальном мероприятии заявил, что во всём мире установлено серверного оборудования где-то на $1 трлн, и сейчас этот парк находится в состоянии перехода на ускорители вычислений и системы генеративного искусственного интеллекта. «Началась новая эра вычислений», — резюмировал он. Готовящиеся властями США новые ограничения на поставку ускорителей вычислений в Китай, по оценкам представителей NVIDIA, не окажут незамедлительного влияния на бизнес компании, поскольку спрос на других географических направлениях в значительной мере сможет их компенсировать. В долгосрочной же перспективе подобные ограничения «лишат всю американскую промышленность возможности лидировать и конкурировать на одном из крупнейших рынков мира», как заявила Колетт Кресс. Новая статья: Навстречу прекрасному: 10 сайтов для культурных людей

24.08.2023 [00:22],

3DNews Team

Данные берутся из публикации Навстречу прекрасному: 10 сайтов для культурных людей BioWare уволит 50 сотрудников на благо Dragon Age: Dreadwolf и следующей Mass Effect

23.08.2023 [23:38],

Дмитрий Рудь

Генеральный менеджер BioWare Гэри Маккей (Gary McKay) в специальном обращении сообщил, что принадлежащую Electronic Arts канадскую студию, известную по ролевым сериям Dragon Age и Mass Effect, ждёт волна сокращений. По словам Маккея, для удовлетворения нужд будущих игр BioWare должна стать более гибкой и сфокусированной, что позволит сотрудникам раскрыть их творческий потенциал и сформировать чёткое видение проекта до старта активной разработки. В рамках инициативы BioWare вынуждена пойти на реорганизацию своей команды, которая приведёт к сокращению порядка 50 должностей. Маккей такому развитию событий предсказуемо не рад. «Писать это очень больно и унизительно. Мы делаем всё возможное, чтобы процесс прошёл с сочувствием, уважением и чёткой коммуникацией», — заверил Маккей, добавив, что уволенным будет предложена позиция в составе самой Electronic Arts. Эти изменения направлены на достижение «долгосрочного видения» для BioWare, которое позволит студии делать то, что у неё получается лучше всего — «создавать отличные сюжетные одиночные игры с обширными мирами и проработанными персонажами». «Это видение балансирует текущие нужды студии — в частности, стремление сделать Dragon Age: Dreadwolf выдающейся игрой — с её будущими, включающими успех следующей Mass Effect», — подчеркнул Маккей. Dragon Age: Dreadwolf выйдет не раньше апреля 2024 года, а у новой Mass Effect даже примерных сроков выхода пока нет — игра всё ещё находится на стадии предварительного производства. GSC Game World спрятала новость о переносе S.T.A.L.K.E.R. 2: Heart of Chornobyl на 2024 год в материалах для прессы

23.08.2023 [22:34],

Дмитрий Рудь

Администрация сообщества «Вестник "Того Самого Сталкера"» обратила внимание, что в официальном наборе для прессы с сайта S.T.A.L.K.E.R. 2: Heart of Chornobyl игра заявлена к релизу не в 2023 году. О том, что горячо ожидаемый постапокалиптический шутер с открытым миром от GSC Game World на самом деле выйдет не в 2023 году, а в феврале 2024-го, «Вестник» со ссылкой на свои источники рассказывал ещё в июне. Судя по информационному бюллетеню из набора для прессы, релиз S.T.A.L.K.E.R. 2: Heart of Chornobyl действительно переносится. В документе указано, что игра поступит в продажу на протяжении первого квартала (с января по март) 2024 года. Официально о переносе S.T.A.L.K.E.R. 2: Heart of Chornobyl разработчики не объявляли, но, вероятно, уже совсем скоро это сделают. Уже 24 августа в рамках выставки gamescom 2023 пройдёт трансляция Xbox с участием игры. S.T.A.L.K.E.R. 2: Heart of Chornobyl создаётся для PC (Steam, GOG, EGS, Microsoft Store), Xbox Series X и S, а также сервиса Game Pass (PC и Xbox). Посетителям gamescom 2023 для ознакомления доступна демоверсия проекта. Поглощение врагов, грандиозные боссы и странный мир: анонсирована мрачная метроидвания Grime II

23.08.2023 [21:47],

Дмитрий Рудь

Сюрреалистичная метроидвания Grime с элементами Dark Souls получит продолжение. Об этом без лишних церемоний разработчики из студии Clover Bite объявили у себя в микроблоге. Анонс сопровождался ссылкой на страницу игры в Steam. Пользователям Grime II (именно так называется сиквел) достанется роль не героя с чёрной дырой вместо головы, а таинственного Бесформенного (Formless), который умеет поглощать врагов и призывать их формы. Поглощённых противников можно будет использовать, чтобы проводить специальные атаки, бросать или оглушать неприятелей, запускать снаряды и даже превращаться в призванных клонов. Используя элементы окружения и призванные формы, игроки будут преодолевать сопротивление смертельно опасных врагов и грандиозных боссов, а также исследовать загадочный и опасный мир. Разработчики обещают возможность выработать свой собственный стиль игры, выбирая между набором способностей, видов оружия и форм. Врагов можно будет не только поглощать, но и парировать. Скриншоты Grime II

Помимо прочего, в Grime II заявлены странный мир с невероятными локациями, интересные персонажи для общения и различные секреты для обнаружения. Поддержка русского языка не подтверждена. Сроки выхода Grime II создатели не раскрыли, но заверили в скором релизе на Nintendo Switch оригинальной Grime. Студия также подтвердила работу над третьим крупным обновлением для игры (выйдет в одно время со Switch-версией). Be quiet! показала мощнейшие системы охлаждения Dark Rock Pro 5 и Dark Rock Elite

23.08.2023 [21:39],

Николай Хижняк

Компания be quiet! привезла на выставку Gamescom несколько новых продуктов. В их числе — новейшие высокопроизводительные флагманские воздушные системы охлаждения Dark Rock Pro 5 и Dark Rock Elite.

Источник изображений: Be quiet! Компания пока не делится подробными характеристиками новинок, но отмечает, что кулер Dark Rock Pro 5 является прямым наследником очень популярной модели Dark Rock Pro 4, предлагающей не только высокий уровень эффективности, но также обладающей исключительно низким уровнем шума при работе. В свою очередь новая модель кулера Dark Rock Elite предназначена для тех пользователей, кто хочет обеспечить максимальную производительность и воздушный поток. В составе данного кулера применяется ARGB-подсветка. В be quiet! заявляют, что превзойти показатели эффективности кулера Dark Rock Pro 4 было сложно, но инженеры компании решили этот вопрос и новинка Dark Rock Pro 5 оказалась ещё эффективнее предшественника. В составе этой системы охлаждения применяются вентиляторы Silent Wings. Кулер оснащён переключателем выбора режимов работы вентиляторов для максимальной тихой или максимальной эффективной работы. Cистема охлаждения Dark Rock Elite, в свою очередь, готова предложить, по заявлению компании, максимально возможную для воздушного процессорного кулера эффективность и воздушный поток. Этот кулер тоже оснащается вентиляторами Silent Wings и переключателем режимов работы. Однако ключевой особенностью новинки является новая система крепления фронтального вентилятора, которая обеспечивает совместимость с большинством представленных на рынке модулей памяти и материнских плат. В продаже кулеры Dark Rock Pro 5 и Dark Rock Elite ожидаются в конце октября. О стоимости новинок производитель не сообщил. X переходит на новый API, прекращая поддержку устаревших уровней доступа и конечных точек

23.08.2023 [21:35],

Сергей Сурабекянц

На этой неделе социальная сеть X заявила о прекращении поддержки некоторых конечных точек API из-за перехода на новый API версии 2. Компания также заявила, что прекращает поддержку устаревших уровней доступа Essential и Elevated. Соцсеть X в марте повысила цены за доступ к своему API, а теперь компания объявила о новых изменениях, что может снова увеличить расходы для разработчиков, особенно для корпоративных клиентов.

Источник изображения: twitter.com «В рамках наших постоянных усилий по модернизации и преобразованию нашей платформы API мы объявляем устаревшими некоторые из наших конечных точек версии 1.1 и просим вас перейти на эквиваленты версии 2. Эти прекращения поддержки позволят нам продолжить поддержку новейших функций X с помощью нашего API v2», — заявили в компании. Для справки: API (application programming interface) — интерфейс программирования приложения — описание способов взаимодействия одной компьютерной программы с другими. Конечные точки API указывают, как получить доступ к ресурсу. Один и тот же ресурс обычно предлагает множество связанных конечных точек, каждая из которых имеет разные пути и методы, но возвращает различную информацию об одном и том же ресурсе. В течение следующих 30 дней X планирует удалить устаревшие уровни доступа к API версии 2, включая Essential и Elevated. Чтобы сохранить доступ, пользователям необходимо войти в свою учётную запись разработчика и поменять уровень доступа на Free, Basic, Pro или Enterprise. Ранее разработчики сообщали, что некоторые вызовы с конечными точками API версии 1.1 не учитывались в ежемесячной квоте для корпоративных клиентов. Но с последним обновлением X эта ошибка будет исправлена. Кроме того, станет недоступна функция поиска пользователей. X последние несколько месяцев проводит ребрендинг сразу по всем направлениям и, в том числе, планирует изменить способ отображения новостных ссылок и платформу, скрывая заголовки и краткий текст из публикации. Ранее в этом году компания заблокировала сторонние приложения и радикально изменила структуру своего API. Корпоративные планы социальной сети стоят $42 000, $125 000 и $210 000 в месяц с лимитом в 50 млн, 100 млн и 200 млн постов соответственно. Новые изменения направлены на то, чтобы побудить ценных клиентов платить больше за более высокие уровни доступа. Ретрофутуристический экшен-платформер Replaced от белорусских разработчиков не выйдет и в 2023 году

23.08.2023 [21:06],

Дмитрий Рудь

Амбициозный ретрофутуристический экшен-платформер Replaced от белорусской Sad Cat Studios поразил зрителей на анонсе в 2021 году, но к релизу не спешит: на днях проект настиг ещё один перенос. Напомним, прошлой весной Replaced перенесли на 2023 год, однако сначала в майском, а затем и августовском финансовом отчёте компании Thunderful (числится одним из издателей проекта) игра оказалась заявлена на 2024-й. На днях у себя в микроблоге Sad Cat Studios подтвердила, что Replaced задержится до 2024 года. Команда хочет, чтобы игра стала «чем-то особенным и запоминающимся», а выпустить посредственный продукт позволить себе не может. «Это наша первая игра, поэтому мы хотим отточить каждый её аспект как можно лучше. Это требует много усилий — больше, чем мы могли бы себе представить», — заявили в Sad Cat Studios. В то же время авторы подчёркивают, что осознают масштабы игры и опасности чрезмерных обещаний. Большинство систем для Replaced уже готовы, и основной проблемой является создание ассетов. Именно нехватка материалов в настоящее время больше всего сдерживает разработку: «Наша планка качества невероятно высока. Для примера: у главного героя Replaced более 500 тщательно нарисованных вручную анимаций (к счастью, они уже готовы)». Replaced создаётся для PC (Steam, EGS, Microsoft Store), Xbox One, Xbox Series X и S, а также Game Pass. События развернутся в альтернативной Америке 1980-х годов, где игрокам достанется роль ИИ, запертого в человеческом теле. «Начало захватывающей новой эпохи»: критики назвали Armored Core VI: Fires of Rubicon лучшей игрой в серии, но не всё так однозначно

23.08.2023 [20:28],

Дмитрий Рудь

Как и предполагалось, 23 августа сайты агрегаторов рецензий Metacritic и OpenCritic наводнили оценки экшена про боевых роботов Armored Core VI: Fires of Rubicon от Bandai Namco и разработчиков из FromSoftware (серия Dark Souls, Elden Ring). На сайте Metacritic у Armored Core VI: Fires of Rubicon собралось 80 рецензий: на версию для PS5 пришлось 47 материалов (88 %), на PC — 26 (87 %), а на Xbox Series X и S — семь (78 %). На OpenCritic картина схожая: 39 рецензий и 86 %. Для сравнения: средний рейтинг ни одной из предыдущих Armored Core на Metacritic не преодолел отметку даже в 80 %, так что Fires of Rubicon по умолчанию становится самой высокооценённой игрой серии.

Помимо сюжетной кампании, Armored Core VI предлагает дуэли на арене, PvP, режим «Новая игра +» и несколько концовок Рецензенты хвалят динамичную боевую систему с широким набором возможностей для индивидуализации своего робота и отзывчивым управлением, запоминающихся боссов, великолепную работу художников и стабильную производительность. В минусы проекту записали не всегда адекватный баланс сложности, не самый выдающийся сюжет (хотя некоторым авторам он пришёлся по вкусу), структуру миссий, местами неудобную камеру и блёклое окружение. Критики сходятся во мнении, что из Armored Core VI: Fires of Rubicon получился отличный экшен и однозначно лучшая игра во франшизе. «Начало захватывающей новой эпохи для серии», — резюмировали в Easy Allies. Armored Core VI: Fires of Rubicon выйдет 25 августа на PC (Steam), PS4, PS5, Xbox One, Xbox Series X и S. На прошлой неделе разработчики объявили окончательные системные требования для игры с трассировкой лучей и без неё. |