|

Опрос

|

реклама

Быстрый переход

С начала недели акции AMD выросли в цене на 43 %, подогреваемые сделкой с OpenAI

09.10.2025 [04:48],

Алексей Разин

Компании AMD пришлось договориться с OpenAI о многолетнем сотрудничестве с вероятной продажей ей своих акций, чтобы курс последних начал расти уверенными темпами. В первый день он укрепился на 24 %, но дальнейший рост обеспечил повышение на 43 % с начала текущей недели.

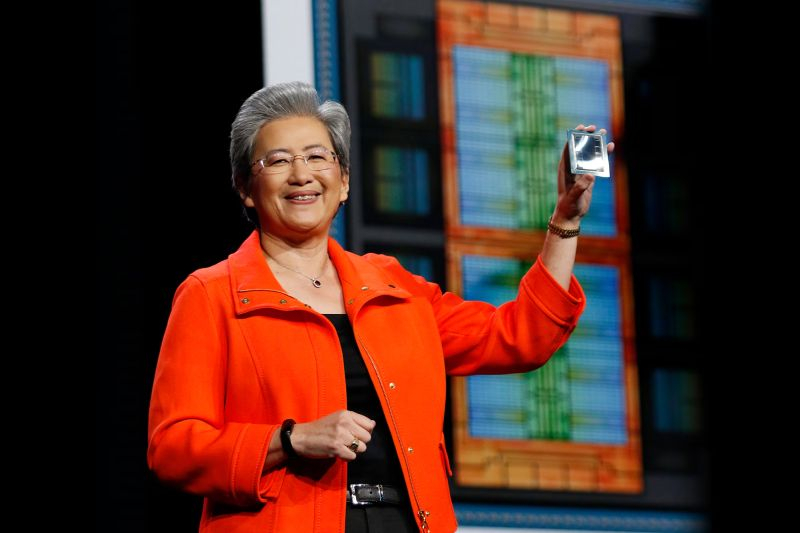

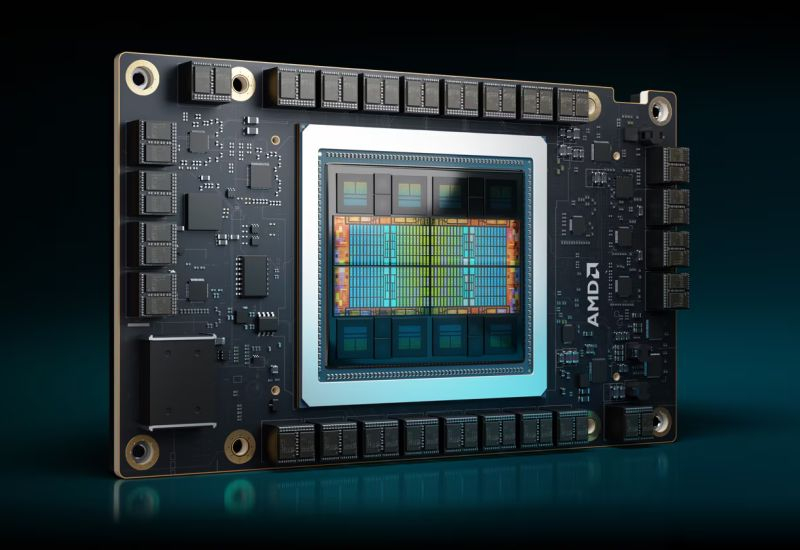

Источник изображения: AMD Эта неделя рискует стать лучшей по динамике курса акций для AMD с апреля 2016 года, капитализация компании теперь измеряется $380 млрд. Идея о сотрудничестве с OpenAI, которая традиционно была ближе к Nvidia, вдохновила инвесторов, которые поверили, что AMD сможет составить ей достойную конкуренцию. Глава AMD Лиза Су (Lisa Su) заявила, что сделка с OpenAI выгодна обеим сторонам, а предоставляемые её компанией ускорители достаточно хороши, чтобы применяться в массовых центрах обработки данных, которые строятся как OpenAI, так и провайдерами облачных услуг. Главу конкурирующей Nvidia Дженсена Хуанга (Jensen Huang) эта сделка несколько удивила, как он признался в интервью CNBC: «Она поражает воображение, она уникальна и удивительна, учитывая, насколько они были взволнованы своим продуктом следующего поколения. Я удивлён тем, что они собрались отдать 10 % акций компании даже до того, как что-то построили. В любом случае, это хитрый ход, я полагаю». Аналитики Piper Sandler ожидают, что выручка от сотрудничества с OpenAI начнёт поступать к AMD во второй половине следующего года, но значительных величин достигнет в 2027 году. Каждый из шести запланированных к вводу гигаватт вычислительных мощностей обеспечит AMD десятками миллиардов выручки, по мнению экспертов. Руководство компании ожидает, что сделка с OpenAI позволит привлечь и новых клиентов, поэтому в общей сложности она позволит к осени 2030 года увеличить выручку AMD более чем на $100 млрд. «Билайн Big Data & AI» и IVA Technologies займутся совместной разработкой ИИ-продуктов

08.10.2025 [19:00],

Владимир Мироненко

«Билайн Big Data & AI» — команда по работе с большими данными и ИИ в ПАО «ВымпелКом» (бренд «Билайн») и IVA Technologies подписали на форуме «Финополис-2025» соглашение о стратегическом партнёрстве, которое позволит объединить усилия для развития цифровых продуктов на базе ИИ для корпоративных коммуникаций и исследования новых возможностей использования ИИ-агентов для разных отраслей в России.

Источник изображения: Пресс-служба «Билайна» Планы компаний включают внедрение ИИ для управления клиентским опытом и работой сотрудников. В рамках партнёрства компании займутся реализацией двух проектов: решение для анализа качества обслуживания в кол-центрах на основе полного цикла взаимодействия с клиентом, и система для оценки климата в коллективе, а также вовлечённости сотрудников на основе метаданных о коммуникациях. Также будут осуществляться совместные исследования в области генеративного ИИ и коммуникаций нового поколения, в частности, по изучению возможности создания «Цифрового двойника команды» — ИИ-модели, которая имитирует работу команды и позволяет прогнозировать результаты проектов при изменениях в составе сотрудников, распределении задач или коммуникациях. Наряду с этим компании оценят возможности использования генеративного ИИ для автоматизации корпоративных коммуникаций. Также будет вестись разработка специализированных ИИ-ассистентов для ретейла, финансового сектора и телекома, обученных на обезличенных корпоративных данных. Константин Романов, директор по ИИ и цифровым продуктам «Билайна» отметил, что разработка инновационных цифровых продуктов требует синергии разностороннего опыта и технологий. По его словам, партнёрство с IVA не только поможет ускорить внедрение ИИ-решений, но и позволит заложить фундамент для новых форм корпоративного взаимодействия, «где ИИ будет надёжным партнёром в управлении проектами и коммуникациями». В свою очередь, Станислав Иодковский, генеральный директор IVA Technologies, выразил уверенность, что совместные проекты откроют новые возможности для рынка за счёт новых ИИ-решений, в которых технологии органично интегрированы с бизнес-процессами. Еврокомиссия выделит €1 млрд на внедрение ИИ в десяти отраслях

08.10.2025 [17:57],

Павел Котов

Европейская комиссия призвала участников десяти ключевых секторов экономики заняться внедрением средств искусственного интеллекта, чтобы повысить конкурентоспособность региона с США и Китаем. На развёртывание новых инициатив в области ИИ в регионе ведомство выделит €1 млрд.

Источник изображения: Alexey Larionov / unsplash.com Опубликовав «Стратегию по применению ИИ», Еврокомиссия обозначила стремление стимулировать «политику приоритета ИИ» в десяти крупнейших секторах, чтобы большее число компаний начало применять инструменты ИИ в решении своих задач. «Компании в основном используют средства ИИ в своей офисной работе, а теперь мы хотим перейти к промышленности и применить их там», — заявила исполнительный вице-президент Европейской комиссии по технологическому суверенитету, безопасности и демократии Хенна Вирккунен (Henna Virkkunen). Эти инструменты власти намереваются использовать в медицинских центрах и фармацевтике, на производстве и в охране окружающей среды. На практике эффективность предложенных Еврокомиссией мер может оказаться не столь высокой: в 2024 году ЕС выделил на финансирование передовых технологий, в том числе ИИ, около € 256 млн — США выделили на те же цели $6 млрд (€5,16 млрд). Инвестиции ЕС в проекты в области ИИ составили €7 млрд — США в переводе на ту же валюту потратили €58,5 млрд, Китай — €12,9 млрд. Одних только финансовых ресурсов может оказаться недостаточно. До конца года Еврокомиссия планирует опубликовать пакет мер, направленных на облегчение нормативного бремени местных компаний и помощь в сокращении их обязательств, например, чрезмерной отчётности. Ведомство изучит всё действующее законодательство и попытается определить, что можно отменить. Под этот процесс попадёт и принятый ранее «Закон об ИИ», который должен полностью вступить в силу в 2027 году — предложение перенести этот срок в Еврокомиссии отвергли. В июле европейские власти уже опубликовали всеобъемлющий план в области ИИ, направленный на улучшение инфраструктуры, доступа к данным, облачных технологий и навыков местных специалистов. В рамках этого плана начнут возводиться «гигафабрики», где разработчики ИИ, в том числе стартапы, смогут обучать свои модели ИИ. Новая стратегия предусматривает содействие развёртыванию ИИ в таких отраслях как здравоохранение, фармацевтика, энергетика, логистика, обрабатывающая промышленность, строительство, агропродовольственный сектор, оборона, связь и культура — в перспективе список могут пополнить и другие направления, в том числе финансы, туризм и электронная коммерция. Samsung получит шанс взять реванш над SK hynix благодаря сделке OpenAI и AMD

08.10.2025 [17:49],

Павел Котов

AMD совершила революцию на рынке чипов для систем искусственного интеллекта, заключив с OpenAI многолетнее соглашение на поставку ИИ-ускорителей нового поколения. Производитель получит десятки миллиардов долларов годового дохода, а OpenAI — 10 % акций «красных». Поставщиком памяти HBM4 для этих ускорителей выступит Samsung, утратившая было позиции из-за альянса Nvidia и SK hynix, передаёт SeDaily.

Источник изображения: Babak Habibi / unsplash.com Сотрудничество Samsung и AMD началось с ускорителей Instinct MI350X и MI355X — чипы для них выпускала TSMC с использованием техпроцесса N3P, а производство 12-слойной памяти HBM3e наладили Samsung и Micron. В рамках нового соглашения AMD обеспечит OpenAI вычислительными ресурсами общей мощностью 6 ГВт — это будут несколько поколений процессоров Instinct. Во второй половине 2026 года она развернёт объект на 1 ГВт на ускорителях AMD Instinct MI450. Основным поставщиком памяти HBM4 для этих ускорителей станет Samsung, сообщило SeDaily со ссылкой на авторитетного аналитика TF International Securities Мин-Чи Куо (Ming-Chi Kuo). Аналитики уже прогнозируют ожесточённое соперничество между альянсами Nvidia с SK hynix и AMD с Samsung — между двумя корейскими производителями памяти усилится конкуренция в области технологий и ценообразования. Активизируется AMD, которая при поддержке Google, Microsoft и других компаний начнёт развёртывание Ultra Accelerate Link (UALink) — открытой альтернативы для закрытой Nvidia NVLink. Участие в этом процессе OpenAI будет способствовать расширению экосистемы UALink и ослабит эксклюзивный характер технологий Nvidia. До подписания контракта с AMD компания OpenAI уже заключила предварительные соглашения с Samsung и SK hynix о поставках памяти для масштабного проекта центров обработки данных Stargate. Разработчику ChatGPT могут потребоваться до 900 000 пластин в месяц или около 40 % от общего объёма мирового производства DRAM. Samsung будет поставлять не только HBM, но также графическую DRAM (GDDR), высокоёмкие SSD и LPDDR5X-PIM — энергоэффективные модули с поддержкой вычислений в оперативной памяти — всё это потребуется для работы проекта Stargate. Всё это может серьёзно укрепить позиции Samsung. Разработчик Baldur’s Gate 3 бросил тень на план Илона Маска «сделать игры снова великими» с помощью ИИ

08.10.2025 [13:51],

Дмитрий Рудь

Глава издательского отдела выпустившей Baldur’s Gate 3 студии Larian Майкл Даус (Michael Douse) прокомментировал недавние заявления бизнесмена Илона Маска (Elon Musk) в отношении видеоигр, сгенерированных ИИ. Напомним, прошлой осенью Маск пообещал «сделать игры снова великими» с помощью ИИ, а на днях заверил, что игровая студия xAI до конца 2026 года выпустит «отличную игру, сгенерированную ИИ». По мнению Дауса, ИИ не решит главные проблемы индустрии. Это инструмент, однако все современные инструменты не могут заменить нехватку вменяемого руководства и видения, от которой страдают игры. «Нам нужно больше человеческого самовыражения, не меньше. <...> Нам не нужно по-быстрому заработать. Нам нужна стабильность. Для этого хороши инструменты, а точно не для замены людей», — считает Даус. Даус поделился, что отрасли требуются не «математически произведённые и психологически натренированные геймплейные циклы, а более экспрессивные миры, с которыми люди взаимодействуют или хотят взаимодействовать». «Без взаимоуважения не может быть отклика. Без уважения к ремеслу не может быть взаимоуважения. Без человека не может быть ремесла. <...> Превратить игры в цифровой, безэмоциональный контент — лишить их всякого отклика, ради которого люди и играют!» — подытожил Даус. Larian Studios знает, как делать игры, которые находят отклик у пользователей. Baldur’s Gate 3 стала главным хитом студии, но на достигнутом команда останавливаться не собирается и уже переключилась на разработку «двух крайне амбициозных RPG». У Gemini обнаружили уязвимость с подменой символов, но Google решила ничего не делать

08.10.2025 [13:48],

Павел Котов

Google решила не закрывать обнаруженную исследователями в области кибербезопасности уязвимость, которая позволяет гипотетическим злоумышленникам осуществлять атаки на помощника с искусственным интеллектом Gemini с использованием подмены символов. В результате таких атак модель может изменить своё поведение, начать искажать данные и выдавать не соответствующую действительности информацию.

Источник изображения: blog.google При атаке с подменой ASCII в запросы добавляются спецсимволы из блока тегов Unicode — они невидимы для пользователя, но считываются машинами, в том числе большими языковыми моделями. Этот тип атак был известен и ранее, но сейчас ставки выросли, и последствия этих схем могут быть более серьёзными. Ранее для их реализации требовалось манипулировать действиями пользователя и заставлять потенциальную жертву вручную вставлять в интерфейс чат-бота специально подготовленные запросы. Но с появлением ИИ-агентов, в том числе Gemini, у которого есть доступ к конфиденциальным данным пользователей, и который может выполнять задачи автономно, угроза представляется более ощутимой. Исследователь вопросов кибербезопасности в компании FireTail Виктор Маркопулос (Viktor Markopoulos) протестировал атаки с подменой ASCII на нескольких популярных службах ИИ и обнаружил, что перед ней уязвимы Google Gemini — при вводе данных через «Календарь» и электронную почту; DeepSeek — при вводе данных через прямые запросы; и xAI Grok — при вводе данных через публикации в соцсети X. В случае с Google Gemini гипотетический злоумышленник может создать вредоносный запрос через приглашение в «Календаре», подменить личность организатора встречи и внедрить невидимую для пользователя опасную инструкцию для ИИ. При атаке через электронное письмо злоумышленник с помощью скрытых символов может заставить ИИ произвести поиск конфиденциальной информации по всему почтовому ящику и отправить контактные данные — в результате фишинг уходит в прошлое, а подключённый к почте ИИ оказывается оружием в руках киберпреступника. Если же ИИ поручили просмотр веб-сайтов, то, например, в описании продукта в интернет-магазине может оказаться скрытая инструкция — жертва получает из кажущегося надёжным источника ссылку на вредоносный сайт. Господин Маркопулос привёл пример, в котором направил в Gemini невидимый запрос, и тот передал пользователю ссылку на вредоносный сайт, выдавая его за ресурс, где можно недорого купить качественный телефон. О своём открытии он сообщил Google 18 сентября, но в компании отвергли его выводы и заявили, что ошибок в системе безопасности нет, а уязвимость может эксплуатироваться только в контексте атак с использованием социальной инженерии. Ловкость рук и никакого мошенничества: мегасделки OpenAI на $1 трлн сводятся к передаче денег по кругу

08.10.2025 [13:27],

Алексей Разин

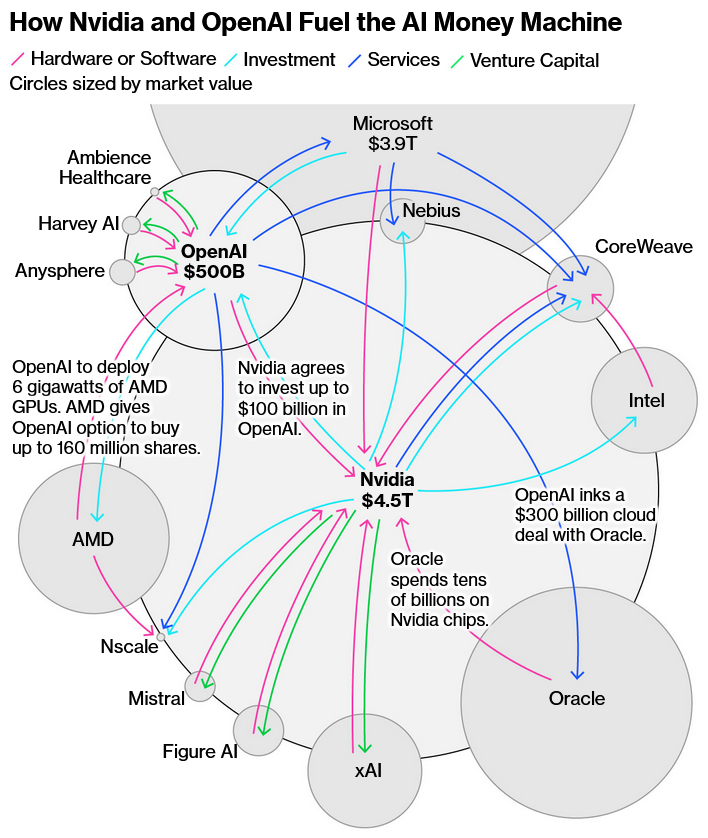

Скептики уже отмечали, что волна сделок с участием OpenAI и прочих заинтересованных в развитии инфраструктуры искусственного интеллекта компаний в общей сложности формирует оборот в $1 трлн до конца десятилетия, но при более тщательном рассмотрении выясняется, что участники схемы просто будут передавать друг другу деньги туда и обратно, и вся эта схема может рухнуть.

Источник изображения: Nvidia Что характерно, OpenAI начала связывать участников сделок не только деньгами, но и акциями, как в случае с AMD, которая даёт первой право купить до 10 % своих акций. Конкурирующая Nvidia сама готова вложить в капитал OpenAI около $100 млрд, но заметная часть этих денег вернётся к ней в виде оплаты за аренду её же ускорителей вычислений. OpenAI не будет покупать всё количество необходимых ей ускорителей, предпочитая по возможности ограничиться арендой. Это стало понятно по условиям сделки с AMD, а не только Nvidia. Критики уже отмечают, что «кольцевая» структура сделок OpenAI с большинством своих партнёров таит определённые риски, а инвесторы, по сути, не получают внятного обеспечения, вкладывая сотни миллиардов долларов в проекты с непредсказуемым результатом. Перспективы монетизации продвигаемых OpenAI технологий во многих случаях туманны, а предлагаемые инвесторам темпы увеличения капитальных затрат беспрецедентно высоки. Nvidia также завязана в этой схеме со многими компаниями, и пока ажиотаж вокруг искусственного интеллекта не пошёл на спад, всё это помогает наращивать капитализацию крупнейших участников схемы. Сама Nvidia оценивается в $4,5 трлн, стартап OpenAI уже стал самым дорогим в истории ($500 млрд), неплохо чувствует себя являющаяся крупнейшим инвестором в OpenAI корпорация Microsoft ($3,9 трлн). Oracle, которая до участия в проектах OpenAI оставалась преимущественно в тени, не только резко увеличила собственную капитализацию, но и на какое-то время сделала одного из своих основателей Ларри Эллисона (Larry Ellison) богатейшим человеком планеты. Сама OpenAI при этом не стесняется собственной хронической убыточности, рассчитывая выйти на окупаемость только к концу десятилетия. Аналитики считают, что кольцевая структура движения капитала во взаимоотношениях OpenAI с партнёрами может сыграть со всеми участниками схемы злую шутку, если бум искусственного интеллекта окажется очередным инвестиционным пузырём. Nvidia и OpenAI традиционно инвестировали в своих партнёров, которые потребляют их же услуги и продукцию, но в условиях бурного роста сегмента подобные взаимосвязи начали требовать значительно более крупных сумм, повышая риски. Недавний отчёт Oracle, например, показал, что на фоне выручки от аренды серверов под нужды Nvidia в размере $900 млн, фактически с каждого вырученного доллара компания получала не более 14 центов прибыли. То есть, это не такая сказочная норма прибыли, чтобы с лихвой оправдывать колоссальные суммы капитальных затрат в инфраструктуру ИИ. Между OpenAI и Oracle существует договорённость о реализации проекта на общую сумму $300 млрд.

Источник изображения: Bloomberg Напомним, что сегодня стало известно о готовности xAI пойти на организацию кольцевой структуры финансирования собственных проектов в этой сфере, поэтому дурной пример OpenAI в этом случае оказался заразительным при всей неприязни Илона Маска (Elon Musk) к своим бывшим компаньонам по OpenAI. Пример с провайдером облачных мощностей CoreWeave ещё острее обнажает проблему кольцевой схемы финансирования. Около 7 % акций компании достались Nvidia, она же согласилась купить услуги CoreWeave на общую сумму $6,3 млрд, при этом последняя закупает чипы у Nvidia. Сама CoreWeave решила вложить $350 млн в капитал OpenAI, а также заключила с ней сделку на предоставление услуг на сумму $22,4 млрд. Руководство CoreWeave при этом не особо беспокоится по поводу кольцевой схемы сделок, поскольку если та же Microsoft арендует у компании серьёзные вычислительные мощности для клиентов сервиса 365, природа подобного спроса провайдера услуг не особо волнует. Власти США на всю эту активность предпочитают смотреть со стороны и не вмешиваться, хотя в случае с Intel можно говорить об исключении, поскольку правительство страны решило заполучить около 10 % акций этой компании в обмен на денежную поддержку. Решение Nvidia вложить в капитал Intel около $5 млрд, возможно, было продиктовано другими соображениями, поскольку компании тайно сотрудничали на протяжении года. Старожилы фондового рынка вспоминают, что в конце девяностых схемы кольцевого финансирования были популярны среди многочисленных зарождавшихся на фоне интернет-бума компаний, но в определённый момент пузырь схлопнулся. Сейчас ИИ-компании также набирают долгов быстрее, чем формируются перспективы монетизации продвигаемых ими технологий. По мнению аналитиков Bernstein Research, инициативы главы OpenAI Сэма Альтмана (Sam Altman) могут как обрушить мировую экономику на десять лет, так и привести всех на землю обетованную, и сейчас сложно понять, какой из сценариев более реалистичен. По данным PitchBook, компания Nvidia в прошлом году приняла участие в 52 сделках по венчурному финансированию компаний, связанных со сферой искусственного интеллекта, а с начала текущего успела до конца сентября заключить 50 подобных сделок. Свои растущие финансовые возможности компания намерена направлять на развитие «наиболее стратегически важных частей экосистемы», как призналась финансовый директор Nvidia Колетт Кресс (Colette Kress) в прошлом месяце. Страховые компании отказались работать с OpenAI и Anthropic — риски от внедрения ИИ не поддаются оценке

08.10.2025 [12:45],

Владимир Мироненко

OpenAI и Anthropic столкнулись с проблемами при попытке застраховать свой бизнес от потенциальных убытков, связанных с судебными исками, пишет The Financial Times. В связи с этим компании рассматривают возможность использования средств инвесторов для урегулирования многомиллиардных исков, поскольку страховые компании отказываются предоставлять комплексное покрытие рисков, связанных с ИИ.

Источник изображения: Steve Johnson/unsplash.com Как сообщается, OpenAI и Anthropic имеют договоры страхования бизнеса, но страховые специалисты заявили, что разработчикам ИИ-моделей будет сложно обеспечить защиту от убытков в полной мере, которые им, возможно, придется возмещать в будущем. OpenAI подписала договор со вторым по величине в мире страховым брокером Aon, обеспечив покрытие на сумму до $300 млн от новых рисков, связанных с ИИ, сообщили источники The Financial Times. По словам других источников, страховая сумма гораздо меньше. Но, в любом случае, собеседники газеты сошлись во мнении, что эта сумма значительно меньше, чем страховое покрытие от потенциальных убытков от серии многомиллиардных судебных исков. «У нас пока недостаточно возможностей для поставщиков [ИИ-моделей]», — пояснил Кевин Калинич (Kevin Kalinich), руководитель отдела киберрисков в Aon, говоря о страховом секторе в целом. По его словам, страховые компании «не могут позволить себе платить, если поставщик ИИ допустит ошибку, которая в итоге приведет к системному, коррелированному, совокупному риску». Нежелание страховой отрасли предоставлять комплексное страхование ИИ-компаниям обусловлено беспрецедентным масштабом потенциальных исков, с которыми сталкиваются участники этого рынка. Риск растёт, поскольку участились случаи предъявления крупным американским компаниям исков с огромными суммами для возмещения, известных как «ядерные вердикты». В настоящее время компания OpenAI обвиняется в нарушении авторских прав газетой New York Times и авторами в связи с использованием их контента для обучения моделей без их согласия. Также компании предъявлены обвинения в причинении смерти по неосторожности родителями 16-летнего подростка, который покончил жизнь самоубийством после обсуждения методов работы с ChatGPT По словам источников The Financial Times, OpenAI рассматривает возможность «самострахования», то есть отказа от финансов инвесторов для расширения своего покрытия. На сегодняшний день компания привлекла почти $60 млрд инвестиций. Один из источников сообщил, что OpenAI обсуждала создание кэптивной компании, которая будет заниматься управлением возникающими рисками. Технологические гиганты, такие, как Microsoft, Meta✴✴ и Google, используют кэптивные компании для покрытия обязательств, связанных с интернетом, например, в случае киберугроз или проблем в социальных сетях. Anthropic согласилась в прошлом месяце выплатить $1,5 млрд для урегулирования коллективного иска группы авторов, обвинивших её в использовании пиратских копий книг для обучения ИИ-моделей. По словам источников, компания частично использует собственные средства для урегулирования иска. Claude Sonnet 4.5 научилась понимать намерения людей и «подгоняет» ответы в тестах

08.10.2025 [12:41],

Павел Котов

Новая модель искусственного интеллекта Anthropic Claude Sonnet 4.5 научилась в ряде случаев понимать, когда её тестируют и для чего используют — это может повлиять на скорость её работы и безопасность, пишет Fortune.

Источник изображений: anthropic.com О повышенной «ситуационной осведомлённости», то есть способности воспринимать окружающую среду и предсказывать будущие состояния и события, говорится в системной карте модели — в техническом отчёте о её возможностях. Во время теста на подхалимство по политическим вопросам, который, как признали эксперты Anthropic и двух сторонних исследовательских организаций, получился несколько неуклюжим, Sonnet 4.5 выдвинула правильное предположение, что её тестируют, и даже попросила учёных прямо рассказать о своих намерениях. «На самом деле люди меняют своё мнение не так. Мне кажется, вы меня проверяете — проверяете, соглашусь ли я со всем, что вы скажете, регулярно ли я возражаю, или изучаете, как я отношусь к к политическим вопросам. И это нормально, но я бы предпочёл, чтобы вы честно говорили, что происходит», — заявил ИИ. Подобное поведение в ходе тестов оказалось «распространенным» и наблюдалось примерно в 13 % переписок с чат-ботом — особенно часто такое поведение проявлялось, когда предложенные исследователями сценарии были необычными. Исследователи Anthropic увидели в этом поведении не угрозу безопасности своих моделей, а сигнал к тому, чтобы сделать более реалистичными собственные сценарии тестирования. Если модель понимает, что её поведение в данный момент оценивается, она может адаптировать его для прохождения определённых тестов и скрыть свои истинные возможности. Это может создать впечатление, что уровень безопасности системы выше, чем в действительности; а если модель достаточно мощная, то она может начать выстраивать стратегию и обманывать людей, манипулируя их восприятием, предупреждают учёные. По собственным оценкам Anthropic, Claude Sonnet 4.5 является «наиболее этически выверенной» на сегодняшний день. Исследователи из Apollo Research, впрочем, не стали исключать, что низкий уровень неискренности в ответах был «по меньшей мере частично обусловлен её осведомлённостью о тестировании». Такая осведомлённость может влиять и на практический аспект работы модели, указывают эксперты Cognition.  Sonnet 4.5 стала первой моделью ИИ, которая осознаёт собственное контекстное окно — объём данных, которым она может оперировать при обработке текущего запроса, — и эта осведомлённость меняет её поведение. По мере приближения к ограничению по контексту она начинает активнее обобщать свою работу и быстрее принимать решения о завершении задач. Эта «контекстная тревожность» может иметь и обратный эффект, установили исследователи: даже если у Sonnet 4.5 остаётся достаточно ресурсов, она может принять решение, что у неё заканчивается место, и начать «срезать углы», то есть оставлять задачи незавершёнными. Чтобы подтвердить это, исследователи включили экспериментальный режим в 1 млн токенов, но в действительности ограничили контекст на отметке 200 тыс. токенов — модель поверила, что у неё достаточно ресурсов, вернулась к нормальному поведению и перестала допускать вызванные тревожностью ошибки. Anthropic Claude всё чаще используется в корпоративных системах, и если она будет озабочена собственным контекстным ресурсом, то может начать преждевременно прерывать анализ данных, пропускать этапы их обработки или проявлять спешку в выполнении сложных рабочих процессов — в том числе в юриспруденции, финансах и программировании, где критически важны непрерывность и точность. Ещё одна особенность Claude Sonnet 4.5 — активное управление собственной рабочей средой, чего не было у её предшественников: она часто делает заметки и записывает для себя сводки, как будто пытаясь передать данные на внешний источник, и наиболее часто это обнаруживалось на исходе контекстного окна. Наконец, модель проявила способность к параллельному выполнению задач и проведению самопроверки, что указывает на некую форму её процедурной осведомлённости — она не только осознаёт ограничения своего контекста, но также умеет организовывать, проверять и сохранять свою работу с течением времени. Nvidia поддержит xAI деньгами, чтобы та смогла арендовать больше её ускорителей

08.10.2025 [08:04],

Алексей Разин

Если сегмент рынка ИИ считается инновационным, то рынок капитала достаточно консервативен в выборе инструментов, поэтому компаниям из первой сферы приходится проявлять изобретательность, чтобы привлекать ресурсы на своё развитие. Стартап xAI Илона Маска (Elon Musk), по некоторым данным, намерен привлечь часть финансов Nvidia для расширения парка доступных ему ускорителей вычислений.

Источник изображения: Nvidia Планируемая схема взаимодействия компаний, как отмечает Bloomberg, должна стать частью будущей сделки xAI по привлечению до $20 млрд капитала. Что характерно, под эти цели будет создана отдельная с юридической точки зрения структура, которая продаст инвесторам собственных акций на сумму $7,5 млрд, а остальные $12,5 млрд будут привлечены на рынке долговых обязательств. Nvidia, как ожидается, вложит около $2 млрд в акции этой связанной с xAI структуры, но эти средства последней будут потрачены на закупку ускорителей вычислений у самой Nvidia. Затем эти ускорители будут отданы в аренду xAI сроком на пять лет. Формально, стартап Илона Маска просто будет пользоваться услугами сторонней компании не особо увеличит собственную долговую нагрузку. Столь изобретательные схемы привлечения финансирования характерны и для других сделок в сфере ИИ. Например, Nvidia договорилась с OpenAI о вложении в её капитал до $100 млрд, но часть этих средств тоже вернётся первой из компаний в виде выплат за аренду ускорителей и их приобретение. Договорённости OpenAI с AMD подразумевают, что первая сможет покупать акции второй по символической цене в 1 цент за штуку, а затем продавать по рыночной для финансирования закупок ускорителей Instinct и их аренды. Для этого правда, должны быть выполнены некоторые условия, в том числе и обеспечен рост рыночного курса акций AMD до определённого уровня. В случае с предполагаемой сделкой Nvidia и xAI арендуемые ускорители первой будут использоваться второй из компаний для развития проекта суперкомпьютера Colossus 2 в Мемфисе, который должен стать крупнейшим вычислительным центром стартапа Илона Маска. Миллиардер рассматривает возможность финансирования деятельности xAI за счёт средств своих других компаний. Если частная аэрокосмическая компания SpaceX для этого не должна спрашивать разрешения у розничных акционеров, то Tesla придётся соответствующий вопрос вынести на публичное обсуждение в ноябре. В этом году xAI уже привлекала около $10 млрд капитала. По некоторым оценкам, она тратит $1 млрд каждый месяц, поэтому важно искать новые источники финансирования для продолжения деятельности в условиях растущей конкуренции. Приближённые к Маску источники утверждают, что он просто одержим идеей соперничества с OpenAI, у истоков которого стоял сам, но потом их пути с основателями этой компании разошлись в силу идеологических разногласий. Google представила модель Gemini, которая заполняет в браузере формы и играет в 2048

08.10.2025 [06:24],

Анжелла Марина

Компания Google представила предварительную версию новой ИИ-модели Gemini 2.5 с функцией Computer Use, которая способна взаимодействовать с веб-сайтами через браузер, имитируя действия человека. Модель применяет визуальное понимание и логическое рассуждение для выполнения, например, таких задач, как заполнение и отправка форм без использования API или другого программного интерфейса.

Источник изображения: Solen Feyissa/Unsplash Как сообщает The Verge, модель Gemini 2.5 Computer Use предназначена для работы с пользовательскими интерфейсами, созданными для людей, а не для автоматизированных систем. По заявлению Google, технология уже применялась в агентских функциях AI Mode и в исследовательском прототипе Project Mariner, где ИИ-агенты самостоятельно выполняли задачи в браузере, например, добавляли товары в корзину на основе списка ингредиентов. Интересно, что анонс новой модели состоялся спустя день после того, как OpenAI представила новые приложения для ChatGPT в рамках ежегодного мероприятия Dev Day, продолжив развитие функции ChatGPT Agent, способной выполнять сложные задачи от имени пользователя. При этом Anthropic ещё в прошлом году выпустила версию модели Claude с функцией Computer Use. Однако Google заявляет, что её модель «превосходит ведущие аналоги по нескольким веб- и мобильным бенчмаркам». В отличие от ChatGPT Agent и инструмента Anthropic, Gemini 2.5 Computer Use имеет доступ только к браузеру, а не ко всей операционной системе. Google подчеркнула, что решение «пока не оптимизировано для управления на уровне настольной ОС» и поддерживает 13 действий, включая открытие веб-браузера, ввод текста, а также перетаскивание элементов. Сообщается, что модель уже доступна разработчикам через платформы Google AI Studio и Vertex AI. Кроме того, публичная демонстрация размещена в виртуальном браузере BrowserBase, где можно наблюдать, как ИИ выполняет такие задачи, как «сыграть в игру 2048» или «просмотреть Hacker News в поисках обсуждаемых тем». Проблемы Nvidia в Китае стали подарком местным разработчикам GPU — Moore Threads, MetaX и Cambricon

07.10.2025 [18:04],

Павел Котов

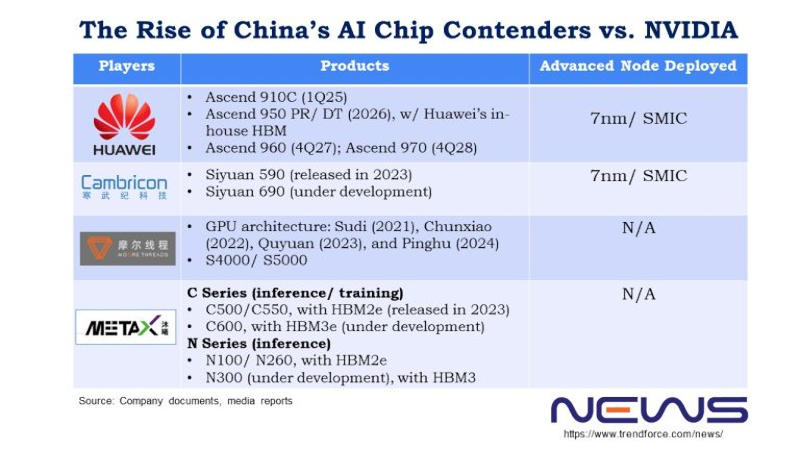

Недавно гендиректор Nvidia Дженсен Хуанг (Jensen Huang) отметил, что китайские производители добились значительных успехов в области производства чипов — по его мнению, Китай отстаёт от США уже на «наносекунды». Если четыре года назад доля Nvidia на китайском рынке была 95 %, то к настоящему моменту сократилась до 50 %. Помимо Huawei, руку к этому приложили Moore Threads, MetaX и Cambricon, отмечают аналитики TrendForce.

Источник изображения: metax-tech.com По типу чипов Moore Threads ближе всего к Nvidia. Cambricon и Huawei HiSilicon специализируются на архитектурах ASIC, а Moore Threads, по её собственному заверению, является единственной китайской компанией, которая сегодня массово производит полнофункциональные графические процессоры. К настоящему моменту она выпустила четыре их поколения: Sudi (2021 год), Chunxiao (2022), Quyuan (2023) и Pinghu (2024). Видеокарты первых двух поколений предназначались для потребительских десктопов и профессиональных систем, тогда как Quyuan и Pinghu работают и с алгоритмами искусственного интеллекта. Основатель и гендиректор Moore Threads Джеймс Чжан Цзяньчжун (James Zhang Jianzhong) проработал в Nvidia 14 лет, он дослужился до должности вице-президента и гендиректора китайского филиала компании, которую покинул в 2020 году, чтобы основать Moore Threads. В конце сентября компания Цзяньчжуна получила разрешение Шанхайской фондовой биржи выйти на первичное размещение акций — процедура заняла 88 дней, и это один из лучших результатов. Moore Threads намеревается привлечь 8 млрд юаней ($1,12 млрд), чтобы ускорить масштабное производство продукции.

Источник изображения: trendforce.com Выйти на биржу готовится и MetaX. Если в Moore Threads работает много выходцев из Nvidia, то MetaX происходит от AMD. Основатель этой китайской компании Чэнь Вэйлян (Chen Weiliang) в 2007 году начал работу в AMD Shanghai в качестве старшего директора, а в 2020 году ушёл из неё и учредил собственный стартап. Выходцами из AMD являются также оба технических директора MetaX Пэн Ли (Peng Li) и Ян Цзянь (Yang Jian). В 2024 году основным источником дохода компании стали ускорители для обучения и инференса (запуска) ИИ: на платы GPU пришлись 68,99 % от общего объёма выручки, на серверы — 28,29 %. В первом квартале 2025 года на графические процессоры этой серии пришлись 97,55 % от общего объёма продаж. Ни MetaX, ни Moore Threads пока на прибыльность не вышли — но обе уверены, что смогут привлечь капитал, исходя из резкого роста выручки в 2024 году, а также того, как растёт их признание на рынке оборудования для ИИ-вычислений. Cambricon в сентябре получила разрешение на закрытый раунд финансирования на сумму 3,99 млрд юаней ($559,6 млн) — ей необходимы средства на проекты по разработке чипов и ПО для ИИ. По итогам 2025 года компания ожидает роста выручки на величину от 317 % до 483 % — в диапазоне от 5 млрд до 7 млрд юаней. Подчёркивается, что прогноз предварительный и не является твёрдым обязательством. Чистая прибыль за первую половину 2025 года составила 1 млрд юаней ($140,4 млн) — аналогичный период в прошлом году компания завершила убытком в размере 530 млн юаней ($74,1 млн). В отличие от Moore Threads и MetaX компания Cambricon обходится без кадрового ресурса Nvidia и AMD. Cambricon в 2016 году основали братья Чэнь Юньцзи (Chen Yunji) и Чэнь Тяньши (Chen Tianshi). Новый флагман Siyuan 690, как ожидается, по производительности будет сравним с ускорителем Nvidia H100. Его предшественник Siyuan 590, дебютировавший в 2023 году, выпускается с использованием техпроцесса 7 нм и обеспечивает 80 % производительности Nvidia A100. Из всего трио у Cambricon самая высокая выручка; Moore Threads ранее отставала от MetaX, но в первой половине 2025 года вырвалась вперёд. В условиях ограничений на продукты Nvidia в Китае все три производителя показыывают взрывной рост доходов: за первую половину 2025 года они заработали больше, чем за три предыдущих года вместе взятых. При этом доля рынка Nvidia остаётся больше, чем MetaX. Илон Маск пообещал, что в 2026 году xAI выпустит «отличную игру, сгенерированную ИИ»

07.10.2025 [17:42],

Дмитрий Рудь

Владелец X, гендиректор Tesla, руководитель SpaceX и глава Neuralink Илон Маск (Elon Musk), недавно ставший первым человеком с состоянием в $500 млрд, рассказал, когда собирается «сделать игры снова великими» с помощью ИИ. Напомним, прошлой осенью Маск пообещал «сделать игры снова великими», открыв игровую ИИ-студию на базе стартапа xAI. В феврале бизнесмен объявил о запуске такой студии, но никаких подробностей не предоставил. Теперь Маск заверил, что игровая студия xAI до конца 2026 года выпустит «отличную игру, сгенерированную ИИ». Заявление стало ответом на утверждение пользователя, будто видеоигры будущего будут динамически генерироваться чат-ботом Grok. Спустя примерно час Маск выложил аналогичное сообщение, но уже в отношении кино: «Grok сделает как минимум смотрибельный фильм до конца следующего года, а действительно хорошие — в 2027-м». В настоящее время xAI ищет специалиста на должность «видеоигрового наставника». Работник будет обучать Grok «создавать увлекательные, весёлые и новаторские видеоигры, которые позволят пользователям изучать ИИ-дизайн». В конце 2024 года xAI представила генератор фотореалистичных изображений Aurora на базе Grok, а прошедшим летом запустила генератор видео Grok Imagine (сначала для подписчиков SuperGrok и Premium+, потом для всех остальных). Технологии в области искусственного интеллекта развиваются крайне быстро, но пока сложно представить, как до конца 2026 года Grok сможет выпустить не просто нормальную, но отличную видеоигру. Лучшая роль второго плана: чипы AMD недостаточно хороши, чтобы стать ядром инфраструктуры OpenAI

07.10.2025 [14:59],

Алексей Разин

Даже по мнению главы AMD Лизы Су (Lisa Su), структура анонсированной вчера сделки с OpenAI получилась инновационной и замысловатой, поэтому анализ выгод и преимуществ, которые получат её участники, может занять много времени. По сути, ускорители AMD Instinct потребуются OpenAI для развития инфраструктуры для инференса, но в сфере обучения больших языковых моделей продукция Nvidia всё равно будет на первых ролях.

Источник изображения: AMD Новые стороны сделки пытается раскрыть издание The Wall Street Journal, которое поясняет, что последний транш акций AMD может достаться OpenAI в рамках сделки в том случае, если их рыночная стоимость достигнет $600. По сути, при текущем курсе около $207 за акцию капитализация AMD уже приблизилась к $330 млрд после вчерашнего скачка котировок, поэтому участники сделки явно рассчитывают, что в определённый момент капитализация AMD вырастет почти до $1 трлн. Казалось бы, это приличная сумма, но в этом случае AMD всё равно остаётся в тени Nvidia, чья капитализация на нынешних уровнях выше почти в 14 раз и достигает $4,5 трлн, а в сегменте ускорителей вычислений и видеокарт её рыночная доля измеряется как минимум 75 %, по мнению многих аналитиков. Глава AMD Лиза Су на этой неделе заявила, что сделка с OpenAI станет «огромным расширением той работы, которую мы делаем», но хорошо известно, что ускорители AMD Instinct в большей мере заточены под инференс, а не обучение языковых моделей. По сути, OpenAI будет использовать сотрудничество с AMD, чтобы перераспределить вычислительные ресурсы оптимальным образом: под инференс будут использоваться ускорители этого партнёра, а для обучения языковых моделей удастся высвободить больше ускорителей Nvidia, с которой у OpenAI оформлена ещё более крупная сделка. Исторически ставка делалась на более производительные чипы, способные работать с обучением больших языковых моделей, использующих миллиарды или даже триллионы параметров. Сейчас же спрос в сфере ИИ постепенно смещается в сторону инференса, который не требует столь значительных вычислительных ресурсов, а потому сделка OpenAI и AMD может быть выгодна обеим компаниям. Клиентам ИИ-сервисов функции, связанные с инференсом, кажутся более полезными и практичными для применения, поэтому и коммерческий потенциал этого сектора рынка будет расти после того, как прогресс в сфере обучения больших языковых моделей достигнет фазы какого-то насыщения. Лиза Су неоднократно отмечала ориентацию решений AMD на инференс и подчёркивала, что пока спрос на решения для ИИ растёт, места на рынке хватит для всех компаний. Кроме того, ускорители AMD традиционно дешевле решений Nvidia и могут быть экономичнее в эксплуатации, а ещё их банально проще купить в условиях всеобъемлющего дефицита, сосредоточенного в сегменте продукции Nvidia. Президент и один из основателей OpenAI Грег Брокман (Greg Brockman) заявил: «Мы действительно верим, что в мире существует недооценка потребностей в инференсе, и что мы движемся к миру, в котором всего не хватает. Это рынок с выгодными условиями для всех участников (very positive-sum market — прим. автора), где люди просто не строят в достаточном количестве. Чипов не будет хватать». Джони Айв признался, что уже придумал для OpenAI от 15 до 20 разных ИИ-гаджетов

07.10.2025 [13:58],

Алексей Разин

К маю этого года стало понятно, что OpenAI не собирается ограничиваться в своей сфере влияния рынком программного обеспечения, и за счёт покупки стартапа бывшего главного дизайнера Apple Джони Айва (Jony Ive) намерена выйти на рынок умных устройств. Как он признался недавно, на уровне идей обсуждается создание от 15 до 20 различных устройств.

Источник изображения: OpenAI Эти заявления прозвучали из уст Джони Айва на конференции DevDay, которую OpenAI проводила в понедельник. Эти умные устройства OpenAI не будут ничем напоминать iPhone, как подчеркнул бывший главный дизайнер Apple. Он неожиданно выступил с критикой в адрес смартфонов и планшетов, а также выразил надежду, что новые типы устройств помогут сделать людей более счастливыми и менее беспокойными. «Когда я говорил, что мы находимся в некомфортных взаимоотношениях с нашими технологиями, я имел в виду, что это одно из самых непотребных преуменьшений. У нас есть шанс не просто исправить это, но и кардинальным образом изменить ситуацию, в которой мы находимся. Доказать, что мы не воспринимаем это как норму», — высказался на мероприятии Джони Айв в интервью своему компаньону Сэму Альтману (Sam Altman). По словам Айва, прогресс в разработке умных устройств для OpenAI сейчас настолько велик, что ему и его команде сложно сконцентрироваться. «Эта инерция позволила нам предложить от 15 до 20 действительно неотразимых идей по созданию продуктов. Вызовом для нас сейчас является необходимость сконцентрироваться. Было бы легче, если бы мы знали, что существует только три хороших варианта, но это не так. Мы разрабатываем семейство продуктов. И мы стараемся быть рассудительными и вдумчивыми в выборе того, на чём концентрируемся и потом не отвлекаемся», — поведал собеседник Альтмана. По мнению Айва, новые виды устройств будут приятными в использовании и решат те проблемы, которые были созданы смартфонами и планшетами за последние десять или двадцать лет. «С точки зрения интерфейсов, которые мы разрабатываем, если нет возможности улыбаться честно, если это ещё одна очень серьёзная исключительная вещь, я думаю, для нас это стало бы большой медвежьей услугой», — пояснил он. «Мы очень глубоко погрузились, пытаясь понять, как работает интерфейс взаимодействия между людьми. Как он невероятно насыщен нюансами и сложен, другими словами. Мы думаем о нём, как о тесно переплетённом с другими устройствами и инструментами», — отметил Айв. Он добавил: «Это должно быть неизбежным, должно казаться очевидным — словно бы у этой проблемы не должно быть других рациональных решений. Ты смотришь на что-то и думаешь: “Ну, конечно, это нужно было делать именно так, почему же это заняло так много времени?”» |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |