|

Опрос

|

реклама

Быстрый переход

Meta✴ нашла ещё одну альтернативу Nvidia, заключив многомиллиардную сделку по аренде ИИ-чипов Google TPU

27.02.2026 [15:34],

Павел Котов

Meta✴✴ заключила многомиллиардную сделку, предметом которой является аренда разработанных в Google ускорителей искусственного интеллекта — гигант соцсетей будет использовать эти ресурсы в разработке ИИ-моделей. Об этом сообщил ресурс The Information со ссылкой на участвовавший в переговорах источник.

Источник изображения: blog.google Сделка носит многолетний характер — сегодня технологические гиганты вкладывают миллиарды долларов в инфраструктуру для удовлетворения спроса на сервисы искусственного интеллекта. Комментариев со стороны Google и Meta✴✴ по данному вопросу не последовало. Ранее AMD сообщила о намерении поставить Meta✴✴ оборудование для ИИ — сумма сделки может превысить $100 млрд. Крупное соглашение гигант соцсетей заключил и с Nvidia, у которой намеревается закупать как существующие, так и перспективные ИИ-ускорители. Google, в свою очередь, намеревается сделать свои тензорные процессоры (TPU) жизнеспособной альтернативой продукции Nvidia, которая пока является лидирующей на рынке. Продажи TPU становятся важнейшим фактором роста доходов Google от облачных сервисов — компания стремится доказать инвесторам, что её вложения в ИИ способны приносить деньги. Сейчас Meta✴✴, по неофициальной информации, также ведёт переговоры с Google на предмет закупки TPU для собственных центров обработки данных в следующем году, но статус этих переговоров установить пока не удалось. Google, стало известно The Information, также подписала соглашение с некой крупной инвестиционной фирмой на предмет финансирования совместного предприятия, которое будет сдавать TPU в аренду другим компаниям. У Google разглядели потенциал для конкуренции с Nvidia в ИИ-чипах, но ей будет нелегко

25.02.2026 [14:11],

Алексей Разин

В сегменте ИИ-ускорителей основными конкурентами Nvidia до сих пор было принято считать AMD и в лучшем случае Intel, но разработавшая собственные процессоры TPU компания Google демонстрирует настолько серьёзные амбиции, что и её нельзя списывать со счетов при анализе конкурентной обстановки на рынке.

Источник изображения: Google Google исторически была одним из главных потребителей ускорителей марки Nvidia. За последние три года глава Google Сундар Пичаи (Sundar Pichai) в 10 из 12 случаев выступления на квартальной отчётной конференции упоминал использование компанией чипов Nvidia в собственной вычислительной инфраструктуре. Выход ИИ-модели Gemini 3 начал менять ландшафт, поскольку представители Google заявили, что обучили её исключительно на своих процессорах TPU. Успех Gemini 3 выступил своего рода рекламой для этих чипов, и теперь Google якобы ведёт переговоры об их поставках для нужд сторонних разработчиков систем ИИ. До сих пор Google использовала TPU только для собственных нужд, но недавно появились слухи, что ими интересуется Meta✴✴ Platforms. Последняя при этом заключила контракт на поставку центральных процессоров Nvidia, что является относительно молодым видом бизнеса для одноимённого разработчика чипов. Недавно стало известно, что Google собирается предоставлять финансовую поддержку тем создателям серверных систем, которые готовы использовать для их строительства чипы TPU. Например, в капитал стартапа Fluidstack компания Google намеревается вложить до $100 млрд. Nvidia подобные схемы сотрудничества с провайдерами облачных услуг уже применяла, вложившись в капитал CoreWeave, Nebius и Lambda. Подвинуть Nvidia на рынке ИИ-чипов не так просто ещё и по причине дефицита контрактных производственных мощностей. Она уже стала крупнейшим клиентом TSMC, являющейся ведущим производителем заказных чипов. В этих условиях даже у Apple возникают проблемы с получением от TSMC достаточно количества чипов, хотя исторически она относилась к числу привилегированных клиентов тайваньского подрядчика. Google просто не сможет выпустить силами TSMC такое количество чипов, которого хватило бы и для собственных нужд, и для продаж клиентам. Google готова помогать деньгами тем облачным провайдерам, которые используют её ускорители

22.02.2026 [08:16],

Алексей Разин

Активная деятельность OpenAI по вовлечению в свои «кольцевые сделки», по всей видимости, не оставила Google равнодушной, и теперь последняя старается использовать свои финансовые ресурсы для привлечения новых клиентов к покупке фирменных ускорителей для систем ИИ. Конкуренты к этой инициативе Google относятся скептически, а ещё реализации мешает дефицит компонентов.

Источник изображения: Google О намерениях Google стимулировать спрос на чипы для ИИ собственной разработки сообщило издание The Wall Street Journal со ссылкой на осведомлённые источники. Крупнейшие облачные провайдеры в большинстве своём ориентируются на ускорители Nvidia, поэтому Google с трудом удаётся продвигать свои нейронные процессоры TPU. Компания решила ориентироваться на новых игроков облачного рынка (neocloud) и стимулировать закупки собственных ускорителей финансовым участием в развитии бизнеса этих компаний. Как отмечает источник, Google ведёт переговоры об инвестициях в размере $100 млн в капитал облачного стартапа Fluidstack в рамках сделки на общую сумму $7,5 млрд. Одним из условий сделки со стороны Google, как предполагается, станет использование Fluidstack в своей вычислительной инфраструктуре аппаратных решений Google. По некоторым данным, Google также готовится поддержать финансами несколько бывших криптомайнинговых проектов, которые переориентируются на создание ЦОД. Кроме того, внутри Google ведутся дискуссии о придании подразделению, занимающемуся разработкой ускорителей TPU, относительной структурной независимости. Она позволила бы, помимо прочего, привлекать сторонний капитал к созданию таких чипов. В Google наличие таких намерений отрицают. С 2018 года Google предлагает клиентам своего облачного бизнеса доступ к вычислительным мощностям на базе TPU. При этом основная часть облачной инфраструктуры Google продолжает зависеть от ускорителей Nvidia. По некоторым данным, Google уже предлагает свои собственные ускорители TPU сторонним заказчикам, которые самостоятельно на их основе создают вычислительные мощности. Руководитель разработки TPU Амин Вахдат (Amin Vahdat) в структуре управления Google недавно был повышен в должности до главного технолога по инфраструктуре ИИ, перейдя в прямое подчинение генеральному директору Сундару Пичаи (Sundar Pichai). Проблемой для экспансии бизнеса TPU остаётся дефицит производственных мощностей TSMC, которая отдаёт приоритет нуждам конкурирующей Nvidia, да и нехватка оперативной памяти тоже не позволяет расширять инфраструктуру на базе TPU желаемыми темпами. При всём этом крупные компании проявляют интерес к данным ускорителям Google, слухи приписывают его Meta✴✴ Platforms и Anthropic. Тем не менее, Amazon (AWS) видит в Google только конкурента, а потому не спешит переходить на использование TPU — тем более, что она разрабатывает собственные процессоры Graviton. Это же можно сказать и о корпорации Microsoft с её облачным сервисом Azure. За пару дней акции MediaTek взлетели на 19 % — благодаря сделке с Google

26.01.2026 [17:57],

Алексей Разин

Разработчики мобильных процессоров не остаются в стороне от бума ИИ. Данные о сотрудничестве Google и MediaTek в сфере разработки тензорных процессоров для систем ИИ первой из компаний способствовали росту курса акций второй до рекордных высот. За пару торговых сессий акции MediaTek выросли в цене на 19 %.

Источник изображения: MediaTek Только по итогам понедельника они подорожали на 8,6 %, как отмечает Bloomberg, а двухдневный прирост на 19 % вообще является рекордом для этой компании. Сейчас ценные бумаги MediaTek находятся на историческом максимуме своей курсовой стоимости. Положительная динамика в целом наблюдается уже на протяжении двух месяцев подряд. MediaTek не единственный партнёр Google по разработке тензорных процессоров для систем ИИ. Ранее в этом качестве выступала Broadcom. Если учесть, что в сегменте смартфонов потенциал роста рынка, с учётом специализации MediaTek на среднем и начальном ценовом диапазоне, в ближайшие годы будет сильно ограничен, то переключение на более прибыльный серверный сегмент станет для компании хорошим выходом из неприятной ситуации. Тайваньский индекс Taiex в понедельник вырос до исторического максимума, поскольку помимо MediaTek, его толкали вверх акции производителя памяти Nanya Technology и контрактного производителя чипов UMC. Характерно, что акции TSMC при этом упали в цене на 0,9 %. Инвесторы могут надеяться на превышение реальными финансовыми результатами MediaTek прогнозных величин, что и способствует росту котировок акций этой компании. Google объединилась с Meta✴, чтобы ударить по доминированию Nvidia в сфере ПО для ИИ

18.12.2025 [20:49],

Сергей Сурабекянц

Google работает над улучшением производительности своих ИИ-чипов при работе с PyTorch. Этот проект с открытым исходным кодом является одним из наиболее широко используемых инструментов для разработчиков моделей ИИ. Для ускорения разработки Google сотрудничает с Meta✴✴, создателем и администратором PyTorch. Партнёрство подразумевает доступ Meta✴✴ к большему количеству ИИ-ускорителей. Этот шаг может пошатнуть многолетнее доминирование Nvidia на рынке ИИ-вычислений.

Источник изображения: unsplash.com Эта инициатива является частью агрессивного плана Google по превращению своих тензорных процессоров (Tensor Processing Unit, TPU) в жизнеспособную альтернативу лидирующим на рынке графическим процессорам Nvidia. Продажи TPU стали важнейшим двигателем роста доходов Google от облачных сервисов. Однако для стимулирования внедрения ИИ-ускорителей Google одного оборудования недостаточно. Новая инициатива компании, известная как TorchTPU, направлена на устранение ключевого барьера, замедляющего внедрение чипов TPU, путём обеспечения их полной совместимости и удобства для разработчиков PyTorch. Google также рассматривает возможность открытия некоторых частей исходного кода своего ПО для ускорения его внедрения. По сравнению с предыдущими попытками поддержки PyTorch на TPU, Google уделяет больше организационного внимания, ресурсов и стратегического значения TorchTPU, поскольку компании, которые хотят использовать эти чипы, рассматривают именно программный стек как узкое место технологии. PyTorch, проект с открытым исходным кодом, активно поддерживаемый Meta✴✴, является одним из наиболее широко используемых инструментов для разработчиков, создающих модели ИИ. В Кремниевой долине очень немногие разработчики пишут каждую строку кода, которую будут фактически выполнять чипы от Nvidia, AMD или Google. Разработчики полагаются на такие инструменты, как PyTorch, представляющий собой набор предварительно написанных библиотек кода и фреймворков. Доминирование Nvidia обеспечивается не только её ускорителями ИИ, но и программной экосистемой CUDA, которая глубоко интегрирована в PyTorch и стала методом по умолчанию для обучения и запуска крупных моделей ИИ. Инженеры Nvidia приложили максимум усилий, чтобы программное обеспечение, разработанное с помощью PyTorch, работало максимально быстро и эффективно на чипах компании. Бо́льшая часть программного обеспечения Google для ИИ построена на основе платформы Jax, что отталкивает клиентов, применяющих для разработки PyTorch. Поэтому сейчас для Google стало особенно важным обеспечить максимальную поддержку PyTorch на своих ускорителях ИИ. В случае успеха TorchTPU может значительно снизить затраты на переход для компаний, желающих найти альтернативу графическим процессорам Nvidia. Чтобы ускорить разработку, Google тесно сотрудничает с Meta✴✴, создателем и администратором PyTorch. Это партнёрство может предоставить Meta✴✴ доступ к большему количеству ИИ-чипов Google. Meta✴✴ прямо заинтересована в разработке TorchTPU — это позволит компании снизить затраты на вывод данных и диверсифицировать инфраструктуру ИИ, отказавшись от использования графических процессоров Nvidia. В качестве первого шага Meta✴✴ предложила использовать управляемые Google сервисы, в рамках которых клиенты, такие как Meta✴✴, получили бы доступ к ИИ-ускорителям Google, а Google обеспечивала их операционную поддержку. В этом году Google уже начала продавать TPU напрямую в центры обработки данных своих клиентов. Компания нуждается в такой инфраструктуре как для запуска собственных продуктов ИИ, включая чат-бот Gemini и поиск на основе ИИ, так и для предоставления доступа клиентам Google Cloud.

Источник изображения: Google «Мы наблюдаем огромный, ускоряющийся спрос как на нашу инфраструктуру TPU, так и на инфраструктуру GPU, — заявил представитель Google. — Наша цель — обеспечить разработчикам гибкость и масштабируемость, необходимые независимо от выбранного ими оборудования». Разработчик «виртуальных» процессоров Tachyum внезапно потребовал от Google не использовать название TPU

09.12.2025 [16:46],

Павел Котов

Разработчик «универсальных процессоров» Tachyum потребовал, чтобы Google и другие компании прекратили пользоваться принадлежащей ей торговой маркой TPU. Поисковый гигант расшифровывает эту аббревиатуру как «тензорный процессор» (Tensor Processing Unit) и употребляет её уже десять лет.

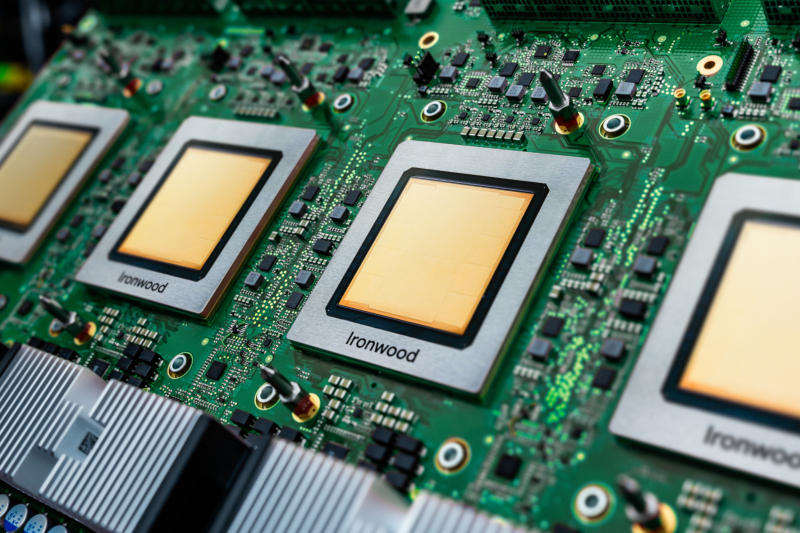

Источник изображения: blog.google В этом году Google выпустила Ironwood — уже седьмое поколение TPU, то есть попытка Tachyum защитить свой товарный знак представляется несколько запоздалой. Заявку на регистрацию торговой марки TPU компания Tachyum подала в 2015 году и получила её в 2020 году. В том же 2015 году Google впервые использовала аббревиатуру TPU, а представила проект в мае 2016 года — в 2016 году была официально зарегистрировала и Tachyum. Tachyum позиционирует себя как разработчика процессоров, но до сих пор не выпустила ни одной модели — компания часто объявляет о передовых проектах и обещает начать их воплощение, но пока эти обещания не выполняет. Google же выпускает свои TPU уже много лет. Спутать продукцию Google с оборудованием Tachyum невозможно — последнего просто не существует. «Мы подали заявку и получили защиту товарного знака TPU в составе нашего портфеля зарегистрированной и защищённой на международном уровне интеллектуальной собственности. Нелицензированное использование Google термина TPU представляет собой нарушение, которое создаёт путаницу и вредит нашим деловым перспективам на рынке искусственного интеллекта. В связи с этим мы снова заявляем о правах на товарный знак TPU как на принадлежащий исключительно нам корпоративный актив и просим Google и других воздержаться от нарушения этих прав при описании собственных аналогичных конкурирующих продуктов и услуг в сфере ИИ. Мы в полной мере рассчитываем на успешную защиту в Бюро по товарным знакам США от избыточного использования этого термина [компанией] Google», — заявил гендиректор Tachyum доктор Радослав Данилак (Radoslav Danilak). Истинные цели Tachyum остаются неясными. Возможно, компания хочет, чтобы Google платила ей лицензионные сборы за использование термина «TPU». Но непонятно, почему Tachyum подняла этот вопрос только сейчас. Учитывая отсутствие реально существующей продукции, её действия более похожи на троллинг. Реакции от Google пока не последовало. Google с помощью TPU сможет отщипнуть десятки миллиардов от ИИ-пирога, который почти единолично «поедает» Nvidia

09.12.2025 [10:17],

Алексей Разин

На фоне недавнего успеха Google Gemini на передний план вышли ускорители TPU собственной разработки, которые она уже много лет использует в собственной вычислительной инфраструктуре. Аналитики Morgan Stanley прогнозируют, что в следующем году для нужд Google компания TSMC выпустит 3,2 млн ускорителей TPU.

Источник изображения: Google В дальнейшем это количество будет расти, по данным источника, до 5 млн штук в 2027 году и 7 млн штук в 2028 году. Аналитики утверждают, что Google могла бы продавать свои TPU сторонним заказчикам с большой выгодой. Каждые 500 000 реализованных по такой схеме TPU могли бы принести Google до $13 млрд дополнительной выручки. В разработке TPU интернет-гиганту помогают Broadcom и MediaTek, а первые эксперименты в этой сфере начались ещё в 2013 году. По слухам, заинтересованность в приобретении TPU у Google уже проявила Meta✴✴ Platforms, хотя последняя от комментариев на эту тему отказалась. Около 1 млн ускорителей TPU будут предоставлены ИИ-стартапу Anthropic, сумма сделки измеряется десятками миллиардов долларов США. Как ожидают эксперты, если Google сможет заключить контракты на поставку TPU с OpenAI, xAI и Safe Superintelligence, это позволит её увеличить свою выручку более чем на $100 млрд в ближайшие годы. Наличие систем так называемого вайб-кодинга позволяет специалистам проще адаптировать свои программные ИИ-платформы под новое аппаратное обеспечение, и в этом контексте привязка большинства отраслевых решений к экосистеме Nvidia уже не имеет прежнего значения. Руководство последней данная тенденция уже насторожила, оно поспешило заявить, что компания находится на целое поколение впереди всей отрасли. Представители Nvidia и Google при этом подтвердили сохранение сотрудничества между компаниями в сфере использования аппаратных компонентов первой. Если ранее Google старалась выпускать новое поколение TPU каждые два года, то теперь компания старается обновлять их ежегодно. Дженсен Хуанг заявил, что чипы Nvidia на поколение опережают всю отрасль, включая ускорители Google

26.11.2025 [08:03],

Алексей Разин

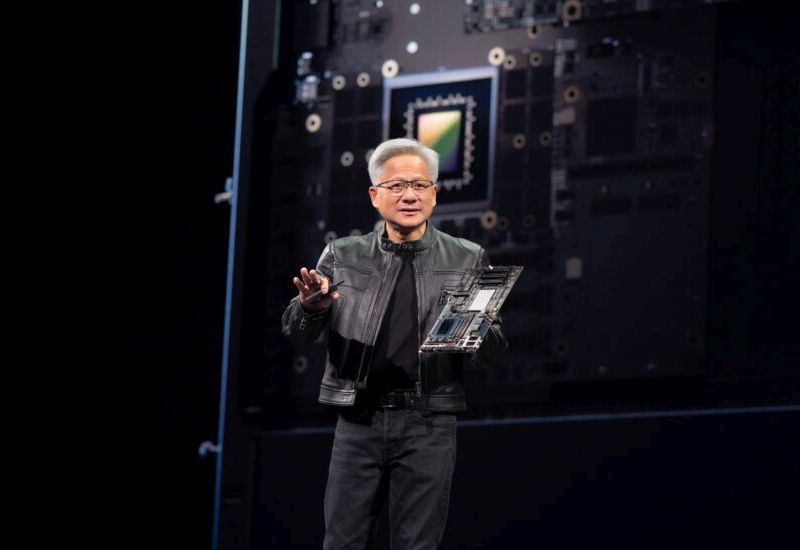

История с готовностью Meta✴✴ Platforms потратить серьёзные суммы на покупку и аренду вычислительных мощностей Google, основанных на чипах TPU собственной разработки, негативно сказалась на динамике курса акций Nvidia, поэтому основатель этой компании Дженсен Хуанг (Jensen Huang) не смог промолчать. Он заявил, что Nvidia опережает отрасль на целое поколение.

Источник изображения: Nvidia «Мы рады успеху Google — они добились большого прогресса в ИИ, но мы продолжаем снабжать Google. Nvidia опережает отрасль на целое поколение — это единственная платформа, которая работает с любой ИИ-моделью и делает это везде, где осуществляются вычисления», — подчеркнул Дженсен Хуанг в своём заявлении на страницах социальной сети X. По мнению руководителя Nvidia, чипы этой марки остаются более производительными и гибкими по сравнению с так называемыми ASIC — решениями, заточенными под выполнение более узких задач. Продукция Nvidia, по словам Дженсена Хуанга, обеспечивает более высокие быстродействие, универсальность и взаимозаменяемость, чем ASIC. К последней категории относятся и TPU компании Google. Как уже отмечали представители Google, компания наблюдает растущий спрос как на собственные чипы, так и на ускорители Nvidia, и будет поддерживать обе платформы, как и делала на протяжении нескольких лет. Глава Nvidia подчеркнул, что поддерживает деловые контакты с генеральным директором Google DeepMind Демисом Хассабисом (Demis Hassabis). В своей переписке они недавно сошлись во мнении, что использование большего количества чипов и данных в сфере ИИ позволяет создавать более производительные языковые модели. Подобный эффект масштабирования позволит сохранить спрос на ускорители и готовые системы, поставляемые Nvidia, по мнению руководства компании. Google выпустила Arm-процессоры Axion и тензорный ускоритель Ironwood для обучения и запуска огромных ИИ-моделей

06.11.2025 [19:52],

Сергей Сурабекянц

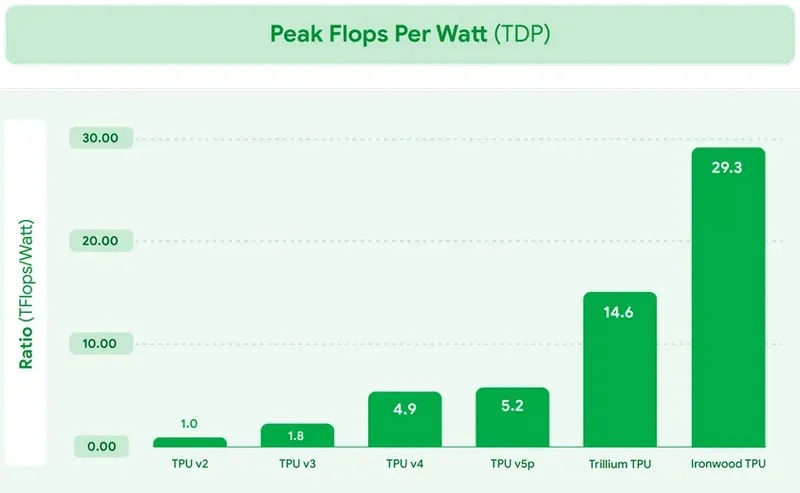

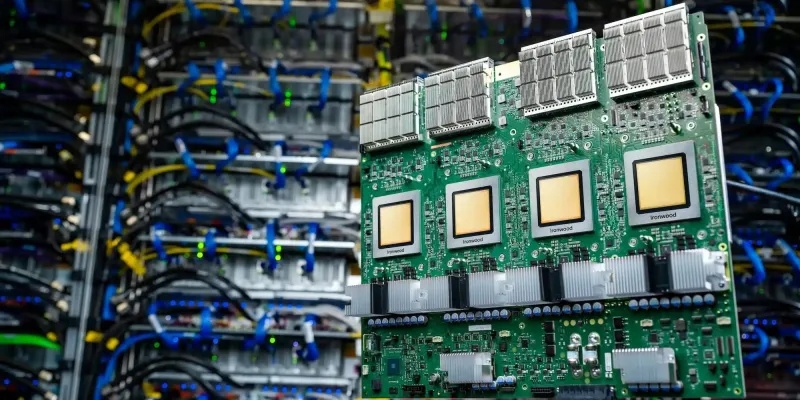

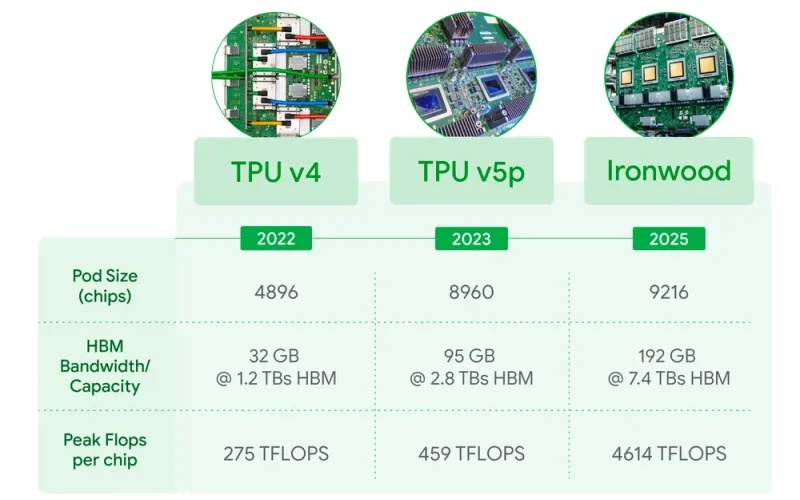

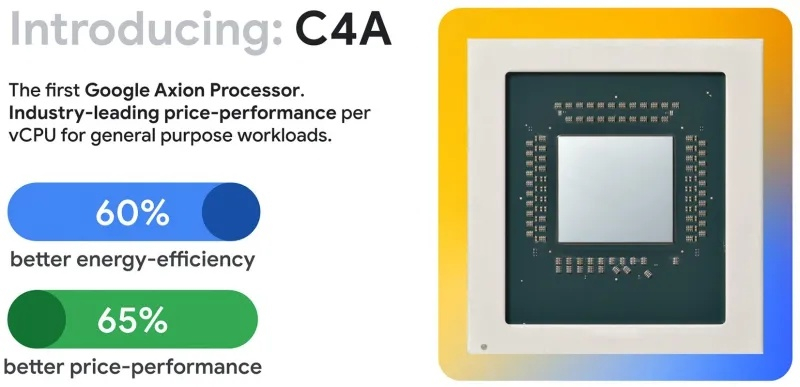

Сегодня Google представила новые процессоры Axion и тензорные ускорители Ironwood — TPU седьмого поколения. По словам компании, чипы Axion на 50 % производительнее и на 60 % энергоэффективнее современных x86-процессоров, а TPU Ironwood — самый производительный и масштабируемый настраиваемый ИИ-ускоритель на сегодняшний день и первый среди чипов Google, разработанный специально для запуска обученных ИИ-моделей (инференса). TPU Ironwood будет поставляться в системах в двух конфигурациях: с 256 или с 9216 чипами. Один ускоритель обладает пиковой вычислительной мощностью 4614 Тфлопс (FP8), а кластер из 9216 чипов при энергопотреблении порядка 10 МВт выдаёт в общей сложности 42,5 Эфлопс. Эти показатели значительно превосходят возможности системы Nvidia GB300 NVL72, которая составляет 0,36 Эфлопс с операциях FP8.  Ironwood оснащён усовершенствованным блоком SparseCore, предназначенным для ускорения работы с ИИ-моделями, которые используются в системах ранжирования и рекомендаций. Расширенная реализация SparseCore в Ironwood позволяет ускорить более широкий спектр рабочих нагрузок, выйдя за рамки традиционной области ИИ в финансовые и научные сферы. Модули объединяются между собой с помощью фирменной сети Inter-Chip Interconnect со скоростью 9,6 Тбит/с и содержат около 1,77 Пбайт памяти HBM3E, что также превосходит возможности конкурирующей платформы Nvidia. Они могут быть объединены в кластеры из сотен тысяч TPU.  Это интегрированная суперкомпьютерная платформа, которую Google называет «ИИ-гиперкомпьютер» объединяет вычисления, хранение данных и сетевые функции под одним уровнем управления. Для повышения надёжности, Google использует реконфигурируемую матрицу Optical Circuit Switching, которая мгновенно обходит любые аппаратные сбои для поддержания непрерывной работы. По данным IDC, этот «гиперкомпьютер ИИ» обеспечивает среднюю окупаемость инвестиций (ROI) в течение трёх лет на уровне 353 %, снижение расходов на ИТ на 28 % и повышение операционной эффективности на 55 %. Несколько компаний уже внедряют эту платформу Google. Anthropic планирует использовать до миллиона TPU для работы и расширения семейства моделей Claude, ссылаясь на значительный выигрыш в соотношении цены и производительности. Lightricks начала развёртывание Ironwood для обучения и обслуживания своей мультимодальной системы LTX-2.  Полные спецификации универсальных процессоров Axion пока не опубликованы, в частности, не раскрыты тактовые частоты и использованный техпроцесс. Сообщается, что процессоры располагают 2 Мбайт кэша второго уровня на ядро, 80 Мбайт кэша третьего уровня, поддерживают память DDR5-5600 МТ/с и технологию Uniform Memory Access (UMA). Известно, что Axion построен на платформе Arm Neoverse v2 и должен обеспечить до 50 % более высокую производительность и до 60 % более высокую энергоэффективность по сравнению с современными процессорами x86. По словам Google, он также на 30 % быстрее, чем «самые быстрые универсальные экземпляры на базе Arm, доступные сегодня в облаке». Процессоры Axion могут использоваться как в серверах искусственного интеллекта, так и в серверах общего назначения для решения различных задач. На данный момент Google предлагает три конфигурации Axion: C4A, N4A и C4A Metal. C4A обеспечивает до 72 виртуальных процессоров, 576 Гбайт памяти DDR5 и сетевое подключение со скоростью 100 Гбит/с в сочетании с локальным хранилищем Titanium SSD объёмом до 6 Тбайт. Экземпляр оптимизирован для стабильно высокой производительности в различных приложениях. Это единственный чип, который доступен уже сегодня.  N4A предназначен для общих рабочих нагрузок, таких как обработка данных, веб-сервисы и среды разработки, но масштабируется до 64 виртуальных ЦП, 512 Гбайт оперативной памяти DDR5 и сетевой пропускной способности 50 Гбит/с. C4A Metal предоставляет клиентам полный аппаратный стек Axion: до 96 виртуальных ЦП, 768 Гбайт памяти DDR5 и сетевую пропускную способность 100 Гбит/с. Экземпляр предназначен для специализированных или ограниченных по лицензии приложений, а также для разработки на базе ARM. Процессор Axion дополняет портфолио специализированных чипов компании, а TPU Ironwood закладывает основу для конкуренции с лучшими ускорителями ИИ на рынке. Серверы на базе Axion и Ironwood оснащены фирменными контроллерами Titanium, которые разгружают процессор от сетевых задач, задач безопасности и обработки ввода-вывода, обеспечивая более эффективное управление и, как следствие, более высокую производительность. ИИ-чипы Google TPU обрели популярность спустя 10 лет после дебюта — Anthropic арендовала 1 млн ускорителей

24.10.2025 [13:27],

Алексей Разин

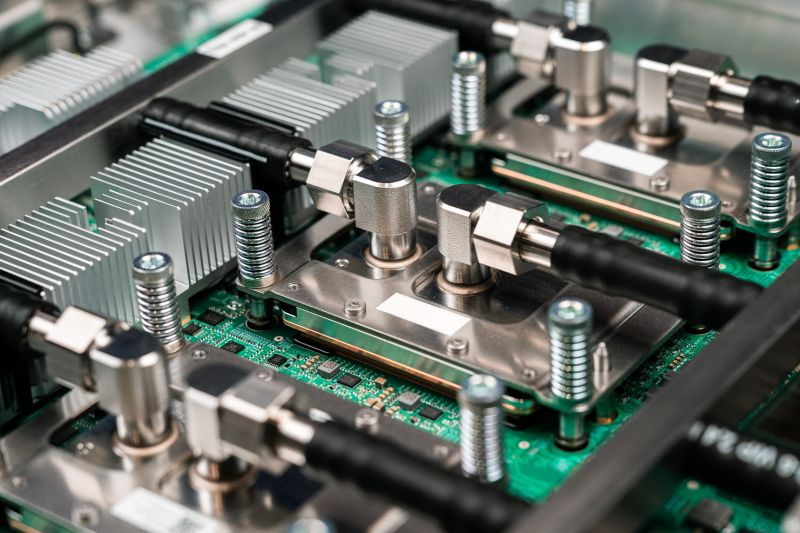

Дефицит вычислительных мощностей, возникающий из-за стремительного развития систем искусственного интеллекта, выставляет в выгодном свете даже те платформы, которые на протяжении многих лет не пользовались популярностью. Процессоры TPU собственной разработки Google, например, оказались в большом количестве задействованы компанией Anthropic PBC при развитии вычислительной инфраструктуры.

Источник изображения: Google Как поясняет Bloomberg, недавно Anthropic PBC заключила контракт с Google на использование более чем 1 ГВт вычислительной мощности, сделка оценивается десятками миллиардов долларов США. По её условиям, Anthropic получит доступ к 1 млн процессоров TPU собственной разработки Google, которые эксплуатируются в облачной инфраструктуре интернет-гиганта. До сих пор основным потребителем таких процессоров оставалась сама Google, хотя первые процессоры этого семейства были разработаны ею более десяти лет назад. Это уже не первый контракт такого рода между Google и Anthropic, но расширение сотрудничества между компаниями указывает на заинтересованность последней в использовании указанных процессоров. Не исключено, что пример Anthropic вдохновит и прочие ИИ-стартапы арендовать у Google вычислительные мощности, основанные на TPU. Разработку этих довольно узко специализированных процессоров Google начала в 2013 году, но первые модели представила только двумя годами позже. Первоначально они применялись для ускорения работы собственного поискового сервиса Google. В облачную инфраструктуру компания начала внедрять TPU в 2018 году, тем самым открыв доступ к данной платформе для сторонних клиентов. Со временем Google начала использовать TPU для работы фирменных ИИ-сервисов. Процессоры дорабатывались с учётом опыта, полученного при развитии соответствующих сервисов Google. В этом процессе были задействованы и специалисты DeepMind, также принадлежащей интернет-гиганту. Чипы Nvidia в этой сфере считаются более универсальными и производительными, но они отличаются и высоким энергопотреблением, а также стоимостью и остаются в дефиците. TPU в процессе своей эволюции тоже неплохо приспособились к вычислительным нагрузкам, характерным для сферы ИИ. При этом они доступнее, потребляют меньше электроэнергии и не требуют столь серьёзного охлаждения. Помимо Anthropic, инфраструктуру Google на базе TPU для своих нужд используют Salesforce, Midjourney и стартап SSI одного из основателей OpenAI Ильи Суцкевера. Скорее всего, процессоры TPU со временем начнут применяться и за пределами облачной инфраструктуры самой Google. При этом Google продолжит оставаться одним из крупнейших клиентов Nvidia, поскольку чипы последней лучше приспособлены к изменениям в характере вычислительных нагрузок. Собственные процессоры Google в этом отношении хуже адаптируются к изменениям без сопутствующих аппаратных преобразований. Новейшее поколение TPU под обозначением Ironwood было представлено в апреле, оно заточено под инференс и рассчитано на использование жидкостного охлаждения. В одном кластере может быть объединено либо 256 таких чипов, либо 9216 штук. Специалисты, которые стояли у истоков TPU, сейчас во многих случаях нашли себе работу в ИИ-стартапах. Они опосредованно поддерживают степень влияния Google в отрасли. OpenAI пока не готова активно использовать ускорители Google в своей инфраструктуре

01.07.2025 [07:01],

Алексей Разин

В минувшую субботу стало известно об экспериментах OpenAI по использованию ускорителей Google серии TPU для вычислений, связанных с формированием логических выводов, тогда как исторически для этого применялись в основном изделия Nvidia. Представители OpenAI поспешили заверить Reuters, что планов по масштабному внедрению TPU у этого стартапа пока нет.

Источник изображения: Google Cloud При этом, как отмечает Reuters, представители OpenAI не отрицают, что начали экспериментировать с ускорителями Google, но тестирование находится на ранней стадии и не подразумевает скорого и активного масштабирования. На этом пути способны возникнуть серьёзные барьеры в виде длительной адаптации программного обеспечения под особенности архитектуры конкретных вычислительных компонентов. Основная часть вычислений и далее будет производиться OpenAI с использованием ускорителей AMD и Nvidia. Более того, ранее сообщалось, что OpenAI занимается разработкой собственных чипов для ускорителей ИИ, и уже в этом году рассчитывает получить готовый к массовому производству цифровой проект. В тоже время, готовность Google предлагать свои ускорители сторонним клиентам говорит о смене вектора в политике компании. К ним уже присоединились Apple, а также стартапы Anthropic и Safe Superintelligence. Два последних были основаны выходцами из OpenAI, поэтому тенденция может считаться достаточно распространённой. Другое дело, что непосредственно OpenAI существенных надежд с применением ускорителей Google пока не связывает. Монополия Nvidia пошатнулась: OpenAI начала использовать чипы Google

28.06.2025 [18:06],

Владимир Мироненко

OpenAI начала использовать ИИ-ускорители TPU компании Google для поддержки работы ИИ-чат-бота ChatGPT и связанных с ним сервисов. Это стало её первым значительным шагом в направлении отказа от исключительного использования чипов Nvidia в рамках стратегии по снижению зависимости от инфраструктуры, управляемой Microsoft, сообщил The Information.

Источник изображения: Mariia Shalabaieva/unsplash.com OpenAI арендует у Google Cloud тензорные процессоры (TPU) с целью сокращения расходов, связанных с вычислениями инференса — процесса использования ИИ-модели для генерации результатов в ответ на запросы после завершения её обучения. Решение OpenAI использовать TPU от Google может означать повышение их статуса в качестве экономически эффективной альтернативы широко используемым GPU компании Nvidia, которая доминирует на рынке ИИ-ускорителей, отметил ресурс investing.com. Ранее OpenAI для обучения и развёртывания своих ИИ-моделей использовала оборудование на базе чипов Nvidia, в основном через партнёрство с Microsoft и Oracle. Новый партнёр, Google, хотя и предоставляет OpenAI некоторые вычислительные мощности на базе TPU, не предлагает ей самые мощные версии своих ускорителей, сообщают источники The Information. Следовательно, самые продвинутые версии TPU Google зарезервировала для внутреннего использования, включая работу над собственными большими языковыми моделями в рамках проекта Gemini. Тем не менее, для OpenAI доступ даже к более ранним версиям TPU представляет собой шаг в направлении диверсификации вычислительной инфраструктуры на фоне растущего спроса на ИИ-чипы в отрасли. На данный момент неясно, будет ли OpenAI использовать TPU Google для обучения моделей или ограничится только применением для инференса. По мере роста конкуренции и углубления ограничений ресурсов гибридная инфраструктура может обеспечить компании больше гибкости в использовании вычислительных мощностей для масштабирования. Google показала системы с собственными TPU, на которых обучаются ИИ-модели Gemini и Apple Intelligence

23.08.2024 [17:45],

Павел Котов

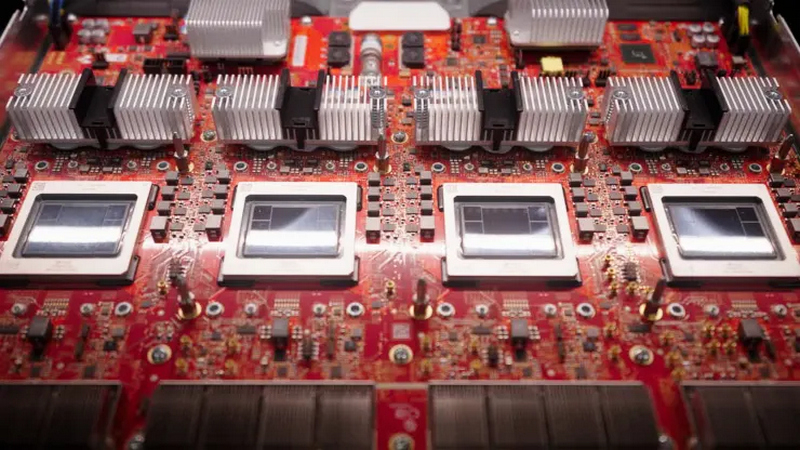

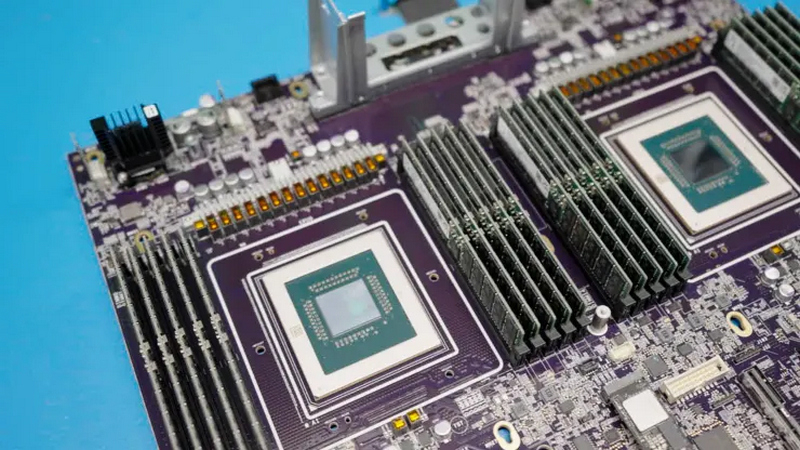

В большой лаборатории в штаб-квартире Google в калифорнийском Маунтин-Вью работают сотни серверных стоек, выполняя задачи, отличные от поисковой системы или рабочих нагрузок Google Cloud. Здесь тестируются тензорные процессоры (Tensor Processing Units —TPU), разработанные самой Google. Журналистам CNBC удалось заглянуть внутрь этой лаборатории.

Источник изображения: alban / unsplash.com TPU от Google появились в 2015 и стали доступны облачным клиентам в 2018 году — они используются, в частности, для обучения моделей Apple Intelligence и Google Gemini. Google была первым поставщиком облачных услуг, который построил собственные чипы для ИИ — Amazon анонсировала свои Inferentia лишь три года спустя, а Microsoft представила Maia лишь в конце 2023 года. Но это первенство не помогло Google стать лидером в гонке генеративного ИИ: Gemini вышла более чем через год после OpenAI ChatGPT. При этом предложения в области ИИ помогли Google Cloud набрать обороты: этот сегмент в компании показал рост на 29 %, а квартальная выручка впервые превысила $10 млрд, гласит последний квартальный отчёт Alphabet. В Google пришли к мысли о создании собственного чипа, когда в 2014 году задумались, какими должны быть ресурсы, чтобы все пользователи сервисов компании смогли пользоваться голосовым интерфейсом хотя бы 30 секунд в день. Как выяснилось, число компьютеров в центрах обработки данных было необходимо удвоить. Google TPU помог поднять эффективность при выполнении некоторых задач в 100 раз. В компании до сих пор используют и традиционные центральные процессоры, и графические процессоры Nvidia. Но Google TPU — это интегральная схема специального назначения (ASIC), предназначенная только для конкретного типа задач. В распоряжении компании есть ещё один такой чип — Video Coding Unit, и используется он для обработки видео.  Собственные чипы Google по примеру Apple стала использовать и в устройствах своей разработки: в смартфонах Pixel 9 это процессор четвёртого поколения Tensor G4, а в наушниках Pixel Buds Pro 2 — Tensor A1. Но важной отличительной чертой Google является серверный TPU — сейчас он занимает 58 % рынка среди облачных ускорителей ИИ собственной разработки. Графические процессоры Nvidia более гибкие, но и более дорогие и дефицитные в сегодняшних условиях, когда бум ИИ взвинтил акции компании до небес, и теперь она соперничает за звание самой дорогой публичной компании в мире с Apple и Microsoft. Настоящее испытание Google TPU ждёт, когда платформа Apple Intelligence в следующем году начнёт в полную силу работать на iPhone и Mac. Разработка альтернативы ускорителям Nvidia — почти подвиг. Процесс настолько сложен и дорог, что даже Google не под силу сделать это в одиночку. С момента появления первого TPU компания заручилась поддержкой чипмейкера Broadcom, который помогает Meta✴✴ в решении той же задачи. Проект полностью разработанного чипа отправляется к полупроводниковому подрядчику — в его роли выступает TSMC, выпускающая 92 % передовой полупроводниковой продукции в мире.

Trillium. Источник изображения: CNBC/Marc Ganley В этом году у Google выйдет шестое поколение TPU Trillium; кроме того, в минувшем апреле компания анонсировала и Axion — свой первый центральный процессор, который появится в конце года. И здесь Google уже не первая: Amazon выпустила свой Graviton в 2018 году, китайская Alibaba последовала её примеру в 2021 году, а Microsoft представила чип Cobalt 100 в ноябре прошлого года. Все они основаны на архитектуре Arm, более гибкой и энергоэффективной, чем x86, которой привержены Intel и AMD.

Axion CPU. Источник изображения: CNBC/Marc Ganley Эффективность является важнейшим аспектом: если верить прогнозам, к 2027 году серверы ИИ будут потреблять столько же энергии в год, сколько Аргентина. Последний экологический отчёт Google показал, что выбросы компании с 2019 по 2023 гг. выросли на 50 % — отчасти из-за роста числа ЦОД для ИИ. Для охлаждения серверов для обучения и работы ИИ требуются огромные объёмы воды, поэтому с третьего поколения Google TPU охлаждение производится непосредственно на чипе — к такой же схеме прибегла и Nvidia с новейшими Blackwell. И, несмотря на сопутствующие трудности, оборудование Google для ИИ продолжает пользоваться большим спросом, и его ослабления в компании пока не отмечают. Google представила мощнейший серверный ИИ-процессор Trillium — почти в пять раз быстрее предшественника

14.05.2024 [22:21],

Николай Хижняк

В рамках конференции Google I/O компания Google представила шестое поколение своего фирменного тензорного процессора (Tensor Processing Unit) с кодовым названием Trillium. Он предназначен для центров обработки данных, ориентированных на работу с искусственным интеллектом. По словам компании, новый чип почти в пять раз производительнее предшественника.

Источник изображения: The Verge «Промышленный спрос на компьютеры для машинного обучения вырос в миллион раз за последние шесть лет и каждый год продолжает увеличиться в десять раз. Я думаю, что Google была создана для этого момента. Мы являемся новаторами в разработке чипов для искусственного интеллекта уже более десяти лет», — заявил генеральный директор Alphabet Сундар Пичаи (Sundar Pichai) в разговоре с журналистами. Разрабатываемые Alphabet, материнской компанией Google, специализированные чипы для центров обработки данных, ориентированных на ИИ, представляют собой одну из немногих жизнеспособных альтернатив решениям компании Nvidia. Вместе с программным обеспечением, оптимизированным для работы с тензорными процессорами Google (TPU), эти решения позволили компании занять значительную долю на рынке. По данным издания Reuters, Nvidia по-прежнему доминирует на рынке чипов для ИИ-дата-центров с долей 80 %. Значительная часть от оставшихся 20 % приходятся на различные версии TPU от Google. В отличие от Nvidia, компания Google не продаёт свои процессоры, а использует их сами и сдаёт в аренду облачные вычислительные платформы, которые на них работают. Для шестого поколения TPU под названием Trillium компания заявляет прибавку вычислительной производительности в 4,7 раза по сравнению с TPU v5e в задачах, связанных с генерацией теста и медиаконтента с помощью больших языковых моделей ИИ (LLM). При этом Trillium на 67 % энергоэффективнее, чем TPU v5e, отмечают в компании. Как пишет портал TechCrunch, значительного увеличения производительности у Trillium компания смогла добиться благодаря увеличения количества используемых матричных умножителей (MXU), а также повышения тактовой частоты чипа. Кроме того, компания удвоила для Trillium пропускную способность памяти. Более конкретных технических деталей Trillium не приводится. Вычислительные мощности нового процессора станут доступны для клиентов облачных сервисов Google к «концу 2024 года», отмечают в компании. Однако от решений Nvidia компания Google не отказывается. В рамках конференции Google I/O также было заявлено, Google станет одним из первых облачных провайдеров, который с начала будущего года будет предлагать облачные услуги на базе специализированных ИИ-ускорителей нового поколения Nvidia Blackwell. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |