|

Опрос

|

реклама

Быстрый переход

Rockstar после «многих лет» тесного сотрудничества купит студию Video Games Deluxe, основанную бывшим режиссёром L.A. Noire

03.03.2025 [17:55],

Дмитрий Рудь

Разработчики из принадлежащей Take-Two Interactive американской Rockstar Games (серии GTA, Red Dead Redemption) в новом пресс-релизе сообщили о приобретении австралийской студии Video Games Deluxe. Напомним, Video Games Deluxe была основана в 2013 году главой разработки и сценаристом детективного экшена L.A. Noire Бренданом Макнамарой (Brendan McNamara) после закрытия его предыдущей студии, Team Bondi, в 2011-м. В 2017 году студия перенесла L.A. Noire на новые платформы и выпустила L.A. Noire: The VR Case Files, впоследствии разработала мобильные версии Grand Theft Auto: The Trilogy — The Definitive Edition и с 2024-го занялась поддержкой сборника. В результате приобретения Video Games Deluxe будет переименована в Rockstar Australia. В Rockstar Games отметили, что решились на покупку студии после «многих лет» тесного сотрудничества. «Работать тесно с Rockstar Games на протяжении последних десяти лет было честью. Мы рады быть частью Rockstar Games и продолжим стремиться создавать лучшие возможные игры», — заявил Макнамара. Чем именно Video Games Deluxe (точнее, Rockstar Australia) займётся теперь, на данный момент не уточняется. В 2020 году сообщалось, что студия разрабатывает для Rockstar Games крупнобюджетную (AAA) VR-игру в открытом мире. Тем временем Rockstar готовит к завтрашнему выпуску крупное обновление для ПК-версии GTA V и продолжает производство GTA VI, которая ожидается ближайшей осенью на PS5, Xbox Series X и S. Технология ИИ-масштабирование видео RTX Video Super Resolution теперь потребляет на 30 % меньше ресурсов GPU

31.01.2025 [19:06],

Сергей Сурабекянц

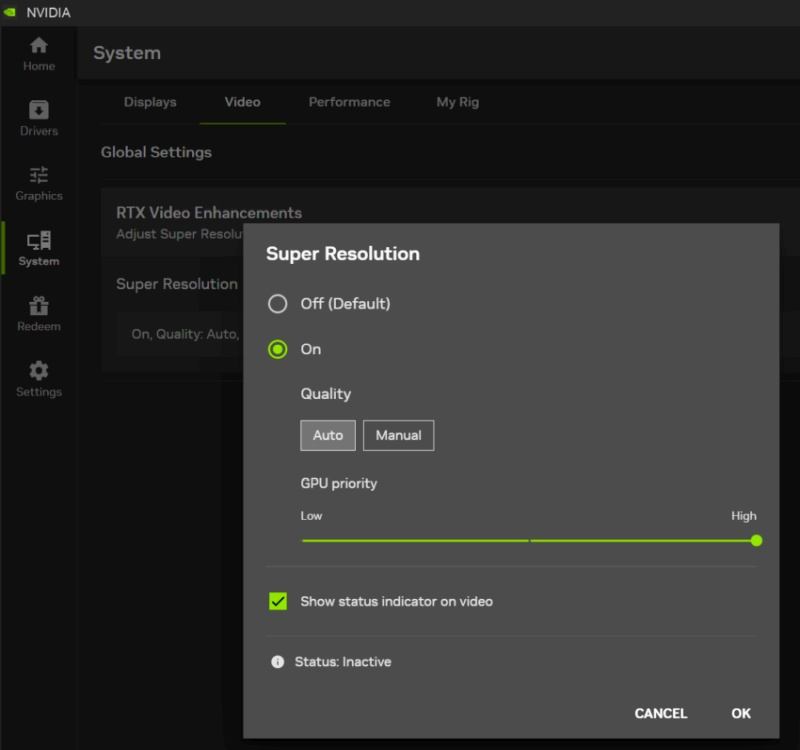

Технология RTX Video Super Resolution (VSR — «суперразрешение видео») позволяет масштабировать видеоконтент, «на лету» повышая разрешение видеопотока. Её основным недостатком является высокий расход электроэнергии — в зависимости от профиля масштабирования видеокарта потребляет от 70 до 240 Вт. Теперь Nvidia представила улучшенную модель ИИ, применяемую для масштабирования видео, которая, как утверждает компания, требует на 30 % меньше энергии. VSR является частью программного обеспечения Nvidia. Включить её можно в разделе «Видео» на вкладке «Система». Там же доступна опция отображения индикатора при использовании этой функции. Nvidia добавила для VSR новую настройку качества — «Авто», которая будет использовать минимально необходимую мощность графического процессора. В то же время настройка «Высокая» будет загружать видеокарту по максимуму для достижения наилучшего качества. Установка использования графического процессора на более низкие уровни позволит зарезервировать больше ресурсов для игр или творческих приложений. В ручном режиме пользователь может задать фиксированный уровень качества, который затем будет использоваться по умолчанию.

Источник изображения: VideoCardz «[Технология] VSR была обновлена до более эффективной модели ИИ, использующей до 30 % меньше ресурсов графического процессора при настройке самого высокого качества, что позволяет большему количеству графических процессоров GeForce RTX включить его», — заявил представитель Nvidia. По его словам, VSR теперь также поддерживает масштабирование HDR-видео. Это означает, что при просмотре в браузере любого HDR-видеоконтента с разрешением ниже разрешения монитора оно автоматически будет повышено до нативного разрешения панели. «Сбер» представил собственный ИИ-генератор видео по текстовому описанию Kandinsky 4.0 Video

12.12.2024 [23:02],

Владимир Фетисов

На проходящей на этой неделе конференции AI Journey «Сбер» представил бета-версию нейросети Kandinsky 4.0 Video, которая позволяет генерировать реалистичные видео на основе текстового описания или стартового кадра. Алгоритм может быть полезен не только обычным пользователям, но также дизайнерам, маркетологам и мультипликаторам, так как с его помощью можно создавать различные видео: от анимированных роликов с поздравлениями для близких до трейлеров и клипов.

Источник изображения: fusionbrain.ai В компании отметили, что с момента релиза первой версии Kandinsky Video в прошлом году разработчики значительно улучшили многие характеристики алгоритма, включая качество создаваемых роликов и скорость генерации. Обновлённая нейросеть способна создавать ролики продолжительностью до 12 секунд с разрешением 1280 × 720 пикселей на основе текстового описания или изображения. Также поддерживается создание роликов с различным соотношением сторон. Улучшилось визуальное качество: повысились контрастность и чёткость кадров, композиция стала более выверенной, а движения объектов в кадре — реалистичными. В дополнение к этому разработчики анонсировали ускоренную версию нейросети — Kandinsky 4.0 Video Flash, которая способна генерировать ролики продолжительностью до 12 секунд с разрешением 720 × 480 пикселей всего за 15 секунд. На начальном этапе доступ к новой версии Kandinsky Video получат представители креативных индустрий, включая художников, дизайнеров и кинематографистов через портал fusionbrain.ai. Для обычных пользователей алгоритм станет доступен в первом квартале следующего года. MiniMax представила бесплатный ИИ-генератор video-1, который превращает текст в видео за 2 минуты

02.09.2024 [19:03],

Владимир Фетисов

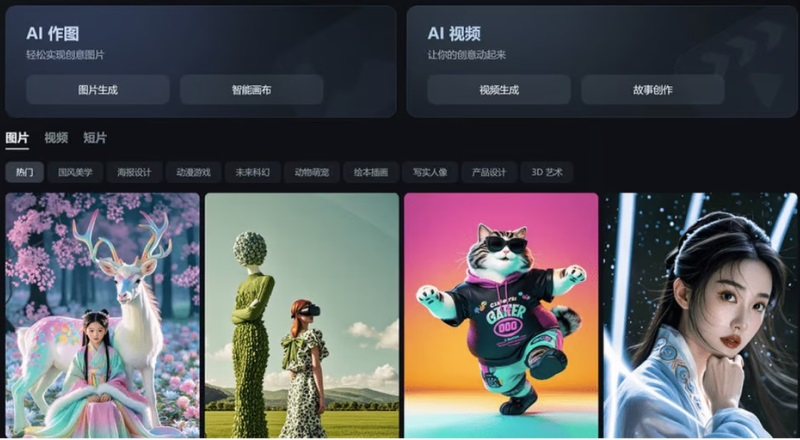

Китайский стартап MiniMax, работающий в сфере искусственного интеллекта, представил алгоритм video-1, который генерирует небольшие видеоклипы на основе текстовых подсказок. Генератор video-1 был представлен широкой публике на прошедшей несколько дней назад в Шанхае первой конференции разработчиков компании, а позднее стал доступен всем желающим на веб-сайте MiniMax.

Источник изображения: scmp.com С помощью video-1 пользователь может на основе текстового описания создавать видеоролики продолжительностью до 6 секунд. Процесс создания такого ролика занимает около 2 минут. Основатель MiniMax Ян Цзюньцзе (Yan Junjie) рассказал на презентации, что video-1 является первой версией алгоритма генерации видео по текстовым подсказкам, отметив, что в будущем нейросеть сможет создавать ролики на основе статических изображений, а также позволит редактировать уже созданные клипы. Появление video-1 отражает стремление китайских технологических компаний продвинуться в зарождающемся сегменте рынка ИИ. Генератор видео был представлен всего через несколько месяцев после анонса нейросети Sora компании OpenAI, которая также позволяет создавать видео по текстовым подсказкам. Что касается MiniMax, то компания была основана в декабре 2021 года и с тех пор она проделала немалую работу. Новый инструмент video-1 предлагается в рамках платформы MiniMax под названием Hailuo AI, которая ориентирована на потребительский рынок и уже предоставляет доступ к функциям генерации текстов и музыки с помощью нейросетей. Помимо MiniMax, разработкой ИИ-алгоритмов для генерации видео из текста занимаются и другие китайские компании. Пекинский стартап Shengshu AI в июле запустил собственный генератор видео из текста на китайском или английском языках под названием Vidu. Стартап Zhipu AI стоимостью более $1 млрд в том же месяце представил свой аналог Sora, который может создавать небольшие видео на основе текстовых подсказок или статических изображений. Владелец TikTok и Douyin, компания ByteDance, в прошлом месяце опубликовала в китайском App Store приложение Jimeng text-to-video для генерации видео из текста, а ещё ранее оно появилось в местных магазинах Android-приложений. Jimeng позволяет создать бесплатно 80 изображений или 26 видео, а для более активного взаимодействия с нейросетью предлагается оформить подписку за 69 юаней (около $10). В прошлом месяце компания Alibaba Group Holding объявила о разработке алгоритма для генерации видео под названием Tora, основанного на модели OpenSora. Отметим, что среди инвесторов MiniMax есть крупные IT-компании, такие как Alibaba, Tencent Holdings и miHoYo (создатель Genshin Impact). Очередной раунд финансирования прошёл весной и после его завершения рыночная стоимость MiniMax оценивалась более чем в $2 млрд. Windows 11 позволит раздельно активировать HDR для игр и потокового видео

19.08.2024 [23:15],

Анжелла Марина

Microsoft добавит в Windows 11 функцию автоматического включения HDR для потокового видео, даже если HDR отключен на уровне системы. Несмотря на то, что Windows официально поддерживает HDR уже несколько лет, работа с ним не всегда была удобной. Новые настройки, обнаруженные в тестовой сборке Windows 11 build 27686, доступной участникам программы Windows Insider, обещают упростить использование HDR.

Источник изображения: Anton Filatov/Unsplash Главным нововведением является опция, которая позволит смотреть HDR-видео в потоковом режиме, не включая HDR-режим для всей системы, сообщает ресурс TechSpot. Раздел настроек дисплея для HDR также был переименован в «HDR video streaming, games, apps, and more» (Потоковая передача HDR-видео, игр и приложений). Изменение названия, наряду с новой опцией, также намекает на более широкую поддержку HDR в различных приложениях и играх. Интересно, что Microsoft изначально не упомянула об этих изменениях в анонсе Build 27686, сосредоточившись на увеличении максимального размера файловой системы FAT32 с 32 Гбайт до 2 Тбайт. Информация о новой настройке HDR появилась позже в обновлённом посте официального блога. Напомним, компания впервые представила официальную поддержку HDR в 2017 году с выходом Windows 10 Creators Update (1703). С тех пор совместимость с HDR-контентом постоянно улучшалась. Сегодня пользователи могут включать режим HDR с помощью сочетания клавиш или конвертировать стандартный контент (SDR) в HDR для отдельных игр. Помимо улучшений в потоковом воспроизведении HDR-видео, в обновление Windows 11 24H2 также будет включена поддержка сжатия изображений HDR-обоев в формате JXR (JPEG XR), являющейся эксклюзивной технологией от Microsoft, целью которой является улучшение широко распространённого стандарта JPEG. Stability AI представила генератор 4D-видео Stable Video 4D

25.07.2024 [01:21],

Владимир Фетисов

На фоне популярности генеративных нейросетей уже доступно множество ИИ-алгоритмов для создания видео, таких как Sora, Haiper и Luma AI. Разработчики из Stability AI представили нечто совершенно новое. Речь идёт о нейросети Stable Video 4D, которая опирается на существующую модель Stable Video Diffusion, позволяющую преобразовывать изображения в видео. Новый инструмент развивает эту концепцию, создавая из получаемых видеоданных несколько роликов с 8 разными перспективами.

Stable Diffusion 3 «Мы считаем, что Stable Video 4D будет использоваться в кинопроизводстве, играх, AR/VR и других сферах, где присутствует необходимость просмотра динамически движущихся 3D-объектов с произвольных ракурсов», — считает глава подразделения по 3D-исследованиям в Stability AI Варун Джампани (Varun Jampani). Это не первый случай, когда Stability AI выходит за пределы генерации двумерного видео. В марте компания анонсировала алгоритм Stable Video 3D, с помощью которого пользователи могут создавать короткие 3D-ролики на основе изображения или текстового описания. С запуском Stable Video 4D компания делает значительный шаг вперёд. Если понятие 3D или три измерения обычно понимается как тип изображения или видео с глубиной, то 4D, не добавляет ещё одно измерение. На самом деле 4D включает в себя ширину (x), высоту (y), глубину (z) и время (t). Это означает, что Stable Video 4D позволяет смотреть на движущиеся 3D-объекты с разных точек обзора и в разные моменты времени. «Ключевые аспекты, которые позволили создать Stable Video 4D, заключаются в том, что мы объединили сильные стороны наших ранее выпущенных моделей Stable Video Diffusion и Stable Video 3D, а также доработали их с помощью тщательно подобранного набора данных динамически движущихся 3D-объектов», — пояснил Джампани. Он также добавил, что Stable Video 4D является первым в своём роде алгоритмом, в котором одна нейросеть выполняет синтез изображения и генерацию видео. В уже существующих аналогах для решения этих задач используются отдельные нейросети. «Stable Video 4D полностью синтезирует восемь новых видео с нуля, используя для этого входное видео в качестве руководства. Нет никакой явной передачи информации о пикселях с входа на выход, вся эта передача информации осуществляется нейросетью неявно», — добавил Джампани. Он добавил, что на данный момент Stable Video 4D может обрабатывать видео с одним объектом длительностью несколько секунд с простым фоном. В дальнейшем разработчики планируют улучшить алгоритм, чтобы он мог использоваться для обработки более сложных видео. «Сбер» открыла для всех ИИ-генератор 6-секундных видео Kandinsky Video 1.1

28.05.2024 [21:12],

Владимир Фетисов

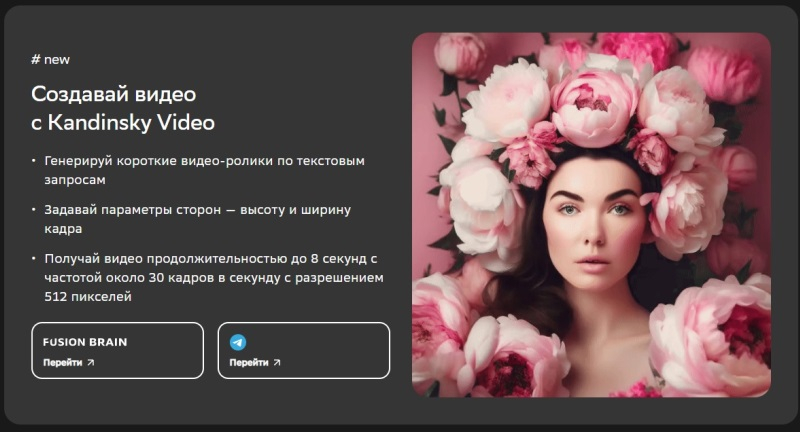

«Сбер» официально объявил о запуске бета-версии нейросети Kandinsky Video 1.1, которая способна создавать полноценные видео продолжительностью 6 секунд на основе текстового описания или статического изображения. Оценить возможности алгоритма можно на платформе fusionbrain.ai и в Telegram-боте Kandinsky.

Источник изображения: fusionbrain.ai Нейросеть генерирует непрерывную сцену с движением объектов и фона продолжительностью до шести секунд на скорости 8 кадров в секунду или 32 кадра в секунду. Поддерживается генерация роликов в форматах 16:9, 9:16 и 1:1. Обновлённый алгоритм способен создавать ролики не только по текстовому описанию, но и на основе статического изображения. За счёт этого пользователи имеют больше возможностей для реализации своих творческих задумок. В дополнение к этому пользователь может контролировать динамику генерируемого видео путём изменения параметра «motion score». «Сегодня мы сделали ещё один шаг в будущее видеотворчества. Теперь каждый пользователь Kandinsky Video может воплотить свои идеи и выразить их в видеоформате. С момента запуска первой версии нейросети прошло менее года, и за это время наша команда значительно улучшила такие показатели, как качество и скорость генерации полноценных видеороликов, открывая тем самым безграничные горизонты для креатива», — прокомментировал запуск нового алгоритма Андрей Белевцев, старший вице-президент, руководитель блока «Техническое развитие» Сбербанка. Браузер Mozilla Firefox получил поддержку ИИ-масштабирования видео Nvidia RTX Video

16.05.2024 [09:42],

Николай Хижняк

Технология масштабирования видео Nvidia RTX Video стала доступна в браузере Mozilla Firefox. Технология задействует мощности видеокарт Nvidia GeForce RTX и специальные ИИ-алгоритмы для повышения качества видеопотока, аналогично тому, как работает технология DLSS в играх.

Источник изображений: Nvidia Очевидную пользу от технологии Nvidia RTX Video могут оценить, например, пользователи платных стриминговых сервисов. Технология масштабирует разрешение изображения видео до более высокого. При этом в данном случае нет необходимости платить за более высокое качество видеопотока. Алгоритмы RTX Video также устраняют артефакты сжатия, улучшают резкость и яркость цвета при использовании режима HDR. Ранее технология Nvidia RTX Video была доступна только для браузеров Google Chrome и Microsoft Edge. Теперь она стала доступна и для Mozilla Firefox. Также следует отметить, что Nvidia RTX Video поддерживается медиапроигрывателем VLC Media Player. А технология RTX Video HDR с помощью ИИ-алгоритма автоматически переводит транслируемый SDR-контент в расширенный динамический диапазон (HDR). Однако для оптимальной функциональности рекомендуется наличие монитора с сертификацией не ниже VESA DisplayHDR 600. Согласно Nvidia, технология RTX Video поддерживается браузером Firefox версии 126 и новее. Для использования RTX Video в браузере Firefox необходимо выполнить следующие шаги:

«Небо и земля»: NVIDIA анонсировала технологию RTX Video HDR, которая с помощью ИИ преображает SDR-контент на лету

10.01.2024 [21:17],

Дмитрий Рудь

Компания NVIDIA в рамках выставки CES 2024 представила ещё одну функцию для видеокарт из линейки GeForce RTX, улучшающую качество передаваемого в потоковой трансляции изображения с помощью ИИ. Львиная доля контента на YouTube транслируется в низком разрешении, с низкой пропускной способностью и в стандартном динамическом диапазоне (то есть SDR), что на современных 4K-мониторах смотрится не лучшим образом. В связи с этим NVIDIA разработала сначала RTX VSR (Video Super Resolution) — аналог DLSS для видеотрансляций, повышающий качество стримов в браузере (см. ролик ниже), — а теперь готовит RTX Video HDR. Как можно догадаться по названию, RTX Video HDR с помощью алгоритма глубинного обучения автоматически переводит транслируемый SDR-контент в расширенный динамический диапазон (HDR). На CES 2024 прошла закрытая демонстрация новой технологии NVIDIA. Сотрудник PC Gamer, присутствовавший на презентации, описал разницу между SDR-стримом и трансляцией RTX Video HDR как «небо и земля». Чтобы оценить RTX Video HDR, понадобится видеокарта GeForce RTX (20-й, 30-й или 40-й серий), имеющий совместимость с форматом HDR10 монитор, а также браузер на основе Chromium вроде Google Chrome и Microsoft Edge. RTX Video HDR появится в драйверах GeForce RTX и NVIDIA RTX до конца января. Как и в случае с RTX VSR, для включения функции будет достаточно активировать её в панели управления NVIDIA. Стартап Stability AI начал поиск покупателя на фоне финансовых трудностей и давления инвесторов

02.12.2023 [07:50],

Дмитрий Федоров

Британский стартап в области ИИ — Stability AI, известный своим генератором изображений Stable Diffusion, ведёт переговоры с потенциальными покупателями бизнеса. Инициатива по продаже возникла на фоне возрастающего давления со стороны инвесторов, в частности Coatue Management, которые выражают обеспокоенность финансовым состоянием компании.

Источник изображения: stability.ai Стартап Stability AI, расположенный в Лондоне и известный своей генеративной ИИ-моделью Stable Diffusion, в последние недели активно ищет покупателя. Это происходит на фоне усиливающегося давления со стороны инвесторов, особенно со стороны Coatue Management, которая требует отставки главы компании, Эмада Мостака (Emad Mostaque). Требование Coatue Management об отставке Мостака последовало спустя год после того, как они помогли привлечь финансирование для Stability AI, оценив стартап в $1 млрд. Stability AI провела предварительные переговоры с несколькими потенциальными покупателями, но источники, близкие к ситуации, предупреждают, что до заключения сделки ещё далеко и процесс может быть остановлен в любой момент. В то же время представитель Stability AI подчеркнул, что компания сосредоточена на разработке новых продуктов в области ИИ, включая модель генерации видео Stable Video Diffusion, и не стремится к продаже. В августе доходы стартапа составили $1,2 млн, тогда как в текущем месяце ожидается их увеличение до $3 млн. Однако ежемесячные расходы компании на оплату счетов и зарплат достигают $8 млн. В октябре прошлого года стартап привлёк инвестиции в размере примерно $50 млн от корпорации Intel, направленные на дальнейшее развитие бизнеса. Отношения между Stability AI и её инвесторами остаются напряжёнными. Генеральный партнёр Coatue Management, Шри Вишванат (Sri Vishwanath), покинул пост директора в результате инвестиций Intel в Stability, так как Coatue Management владеет значительным пакетом акций конкурента Intel — компании AMD. Партнёр из Lightspeed Venture Partners также ушёл с поста наблюдателя в совете директоров стартапа. Intel, в свою очередь, в сентябре назвала Stability AI «якорным клиентом» для своего нового суперкомпьютера, ориентированного на ИИ. Согласно двум источникам, знакомым с условиями сделки, инвестиции Intel были частично обусловлены использованием процессоров Intel в вычислениях Stability AI. «Сбер» представил нейросеть Kandinsky Video — она генерирует 8-секундные видео по текстовому описанию

22.11.2023 [14:06],

Владимир Фетисов

«Сбер» представил нейросеть Kandinsky Video, способную создавать небольшие ролики по текстовому описанию. Алгоритм генерирует видеоряд продолжительностью до 8 секунд с частотой 30 кадров в секунду. Новинка была презентована в рамках конференции AI Journey первым заместителем председателя правления «Сбербанка» Александром Ведяхиным.

Источник изображения: sberbank.com Архитектура Kandinsky Video включает в себя два основных блока. Первый блок отвечает за генерацию ключевых кадров, используемых для создания структуры сюжета видео, а второй — генерирует интерполяционные кадры, за счёт чего достигается плавность движения в финальном ролике. Оба блока построены на базе модели синтеза изображений по текстовым описаниям Kandinsky 3.0. В конечном счёте алгоритм создаёт видео с движением как объекта, так и фона. Это отличает сгенерированные нейросетью видео от анимационных роликов, в которых динамика достигается за счёт моделирования полёта камеры относительно статичной сцены. В настоящее время Kandinsky Video может создавать видео с разрешением 512 × 512 пикселей и разным соотношением сторон. Для обучения алгоритма использовался датасет из более чем 300 тыс. пар «текст-видео». Сам же процесс генерации ролика занимает до 3 минут. Отмечается, что ранее некоторые пользователи нейросети Kandinsky 2.2 в тестовом режиме получили доступ к функции создания анимационных роликов. Всего одного запроса достаточно для генерации видео продолжительностью до 4 секунд с выбранными эффектами анимации, частотой 24 кадра в секунду и разрешением 640 × 640 пикселей. Пользователи новой версии Kandinsky 3.0 также могут генерировать ролики по текстовому описанию в режиме анимации. У генератора кадров в AMD FSR 3 нашли способность повышать FPS не только в играх, но и в видеороликах

09.10.2023 [15:56],

Николай Хижняк

С выходом графической архитектуры RDNA первого поколения компания AMD решила отказаться от одной из функций, на тот момент ещё входившей в состав графического драйвера Adrenalin Software. Она называлась AMD Fluid Motion Video и представляла собой аналог недавно представленного генератора кадров AMD Fluid Motion Frames, но только для видеоконтента. Как выяснилось, Fluid Motion Frames также может использоваться для генерации кадров в видео, но пока неофициально.

Источник изображения: AMD Следует сразу отметить, что AMD Fluid Motion Frames (AFMF) на данный момент не входит в состав официальной стабильной сборки драйвера AMD Software: Adrenalin Edition. Производитель включил функцию в состав специального отдельного превью-драйвера, выпущенного недавно. AMD Fluid Motion Frames представляет собой генератор кадров, аналогичный тому, что применён в пакете технологии масштабирования изображения NVIDIA DLSS3, и служит для повышения FPS. В отличие от DLSS3, который работает только с картами GeForce RTX 40-й серии, решение AMD поддерживается не только последним поколением видеокарт Radeon RX 7000, но также и предыдущим RX 6000. AMD Fluid Motion Video (AFMV) работает по тому же принципу, но только для видео. Она создавала «ненастоящие» кадры, обеспечивая более плавный вывод изображения при воспроизведении видеоконтента. Наиболее полезной AFMV оказалась при использовании со старыми видеоматериалами с кадровой частотой 23–24 FPS. AMD Fluid Motion Video была впервые анонсирована для драйвера AMD Catalyst Omega в 2014 году. При этом тогда для неё заявлялась совместимость только с видеокартами Polaris и некоторыми моделями ускорителей на архитектуре GCN1. Официально функция появилась в составе ПО Radeon с выходом архитектуры GCN 2.0. Впоследствии AMD решила не переносить поддержку AFMV в архитектуру RDNA. Метод использования AMD Fluid Motion Frames (AFMF) в качестве AMD Fluid Motion Video, предложенный пользователем uncycler825 форума Reddit, совместим только с предварительной версией драйвера без поддержки видеокарт Radeon RX 6000 (второе обновление, именуемое Patсh 2), поскольку только в ней AFMF работал с Vulkan API. Для работы функции предлагается использовать проигрыватель MPC-HC с Vulkan через слой трансляции DXVK. После размещения библиотек DXVK в папке MPC-HC нужно добавить проигрыватель в драйвер AMD Software Adrenalin и активировать в профиле приложения AMD Fluid Motion Frames. С подробной инструкцией можно ознакомиться на форуме Reddit. На данный момент неизвестно, собирается ли AMD реализовать функции генерации кадров для видео в официальной версии драйвера Radeon. Однако возможность генерации кадров для видеоконтента может быть востребована, и AMD могла бы расширить область применения AFMF, сделав свои продукты ещё более привлекательными для пользователей. В идеале, для этого компания должна предоставить для разработчиков медиапроигрывателей простой в использовании и открытый API. Как пишет VideoCardz, существуют аналогичные проекты на основе NVIDIA Optical Flow — функции, отвечающей за генерацию кадров на видеокартах NVIDIA. У компании также есть технология RTX Super Video Resolution, которая повышает качество видео в поддерживаемых браузерах в режиме реального времени. Google случайно опубликовала фото неанонсированного Pixel 8 Pro на официальном сайте

30.08.2023 [13:02],

Дмитрий Федоров

Google снова столкнулась с утечкой информации о своём новом флагмане Pixel 8 Pro. На официальном сайте компании появилось изображение смартфона, хотя официального анонса ещё не было. Источник изображения: Google В продолжение долгой традиции утечек информации о устройствах Google Pixel ещё не анонсированный Googl Pixel 8 Pro был замечен на странице Google Store. Пользователь X (в прошлом Twitter) с ником @Android_Setting первым обратил внимание на изображение на странице, рекламирующей подписки и услуги Google. На фотографии изображён мужчина, который разговаривает по Googl Pixel 8 Pro в фарфоровом цвете. Смартфон выглядит так же, как и на уже утёкших рендерах и изображениях, включая предполагаемое видео от самого Google. Более того, в аннотации к изображению говорилось: «Человек разговаривает по телефону Pixel 8 Pro в фарфоровом цвете». На изображении видно, что дизайн смартфона соответствует предыдущим утечкам: задние камеры закрыты стеклянным овалом и традиционно выступают из корпуса, как и у его предшественников. Хотя на основании этой утечки нельзя определить начинку смартфона, ранее уже сообщались сведения о его технических характеристиках, экране, памяти и новых функциях, включая функцию Video Unblur, которая использует нейросеть для повышения чёткости смазанного видео. По имеющейся информации Pixel 8 Pro получит 6,7-дюймовый OLED-экран с разрешением 2992 × 1344 и частотой обновления 120 Гц. Главная камера будет включать в себя 50-Мп датчик от Samsung, 64-Мп датчик от Sony с ультрашироким углом и 48-Мп перископический модуль с 5-кратным оптическим зумом. Фронтальная камера, вероятно, сохранит разрешение 11 Мп. Устройство будет работать на процессоре Google Tensor G3, аккумуляторе емкостью 4 950 мА·ч и будет поддерживать Wi-Fi 7. В браузере Firefox появилась поддержка технологии NVIDIA RTX Video Super Resolution

14.07.2023 [04:29],

Владимир Фетисов

В начале этого года компания NVIDIA представила технологию RTX Video Super Resolution, которая представляет собой аналог ИИ-масштабирования DLSS и позволяет масштабировать потоковое видео с разрешением Full HD до разрешения 4K с улучшением его качества. С тех пор поддержка этой технологии появилась в некоторых браузерах на базе Chromium. Теперь же стало известно, что возможность использования VSR получат пользователи браузера Mozilla Firefox.

Источник изображения: NVIDIA Информация о появлении упомянутой функции появилась от инсайдеров и на данный момент об интеграции VSR официально не объявляли ни Mozilla Foundation, ни NVIDIA. Вероятно, реализация поддержки VSR в Firefox находится на начальной стадии, поэтому потребуется некоторое время, прежде чем эта функция станет доступна пользователям стабильных версий обозревателя. Для активации VSR в Firefox необходимо перейти в настройки приложения и в строке поиска набрать about:config. После этого на вкладке Preferences нужно найти параметр gfx.webrender.super-resolution.nvidia и установить для него значение True. Технология VSR использует ИИ-алгоритмы для повышения качества потокового видео. В процессе обработки осуществляется сглаживание квадратных артефактов на гранях объектов в кадре с последующим масштабированием разрешения видео до более высокого. За счёт этого исходное видео выглядит значительно более качественным на мониторах с высоким разрешением. Например, использование VSR позволяет улучшить качество видео Full HD до 4K. В настоящее время технология VSR поддерживается в нескольких браузерах на базе Chromium, а также в медиапроигрывателе VLC Media Player. Ожидается, что в будущем она получит более широкое распространение. Для доступа к технологии VSR пользователям необходимо обзавестись видеокартой GeForce RTX 3000 или GeForce RTX 4000. |