|

Опрос

|

реклама

Быстрый переход

Американская программа по замене школьных учебников ноутбуками привела к появлению «глупого поколения»

22.02.2026 [15:18],

Владимир Фетисов

Почти четверть века прошло с тех пор, как в США начала реализовываться программа по замене школьных учебников ноутбуками и планшетами. Однако предоставление детям доступа к большому объёму информации привело совершенно не к тем результатам, на которые рассчитывали её авторы.

Источник изображения: StartupStockPhotos / Pixabay В 2002 году штат Мэн первым в США начал реализовывать программу выдачи ноутбуков учащимся некоторых классов общеобразовательных школ. На тот момент губернатором был Ангус Кинг (Angus King), который рассматривал эту программу, как способ предоставить большему количеству детей доступ к интернету, чтобы они могли получать больше информации. Осенью того же года в рамках инициативы штата Мэн по технологиям в обучению (Maine Learning Technology Initiative) было распространено 17 тыс. ноутбуков Apple среди семиклассников в 243 школах. К 2016 году эта цифра выросла до 66 тыс. ноутбуков и планшетов, розданных учащимся школ в штате Мэн. Первоначальные усилия Кинга нашли поддержку по всей стране. В 2024 году США потратили более $30 млрд на обеспечение школ ноутбуками и планшетами. Однако спустя почти четверть века и несколько сменивших друг друга моделей технологий психологи и эксперты видят иной результат, нежели тот, на который рассчитывал Кинг. Вместо того, чтобы дать поколению детей возможность получать доступ к большему объём знаний, технология возымела противоположный эффект. Ранее в этом году нейробиолог Джаред Куни Хорват (Jared Cooney Horvath) в письменных показаниях перед Комитетом Сената США по торговле, науке и транспорту заявил, что поколение Z уступает в плане когнитивных способностей предыдущим поколениям, несмотря на беспрецедентный доступ к технологиям. Он добавил, что поколение Z — это первое поколение в современной истории, показывающее более низкие результаты по стандартизированным тестам, чем предыдущее поколение. Хотя навыки, измеряемые этими тестами, такие как грамотность и счёт, не всегда являются показателями интеллекта, они отражают когнитивные способности, уровень которых, по словам Хорвата, снижается в течение последнего десятилетия. Ссылаясь на данные Программы по международной оценке достижений учащихся (PISA), отражающие результаты 15-летних подростков по сему миру, и другие стандартизированные тесты, Хорват отметил не только снижение результатов в тестах, но и явную корреляцию между набранными баллами и временем, проводимым за компьютером в школе. При этом чем больше ученики проводят времени за компьютером в школе, тем более низкие результаты они показывают в тестах. Нейробиолог уверен, что неограниченный доступ учащихся к технологиям привёл к атрофии, а не к укреплению способностей к обучению. Появление iPhone в 2007 году также не способствовало этому. «Это не дискуссия о том, чтобы отказаться от технологий. Это вопрос о согласовании образовательных инструментов с тем, как на самом деле происходит обучение людей. Данные свидетельствуют о том, что неизбирательное расширение цифровой среды ослабило учебную среду, а не укрепило её», — говорится в письме Хорвата. Возможно, указывающие на эту тенденцию факты появлялись и ранее. В 2017 году американские СМИ писали, что результаты тестов в государственных школах штата Мэн не улучшились за 15 лет с момента внедрения технологической инициативы властей. На тот момент губернатором штата был Пол Лепаж (Paul LePage), который назвал эту программу «масштабным провалом», даже несмотря на то, что штат вложил значительные средства в контракты с Apple. Теперь поколению Z придётся столкнуться с последствиями ослабления способности к обучению. В дополнение к этому поколение сильно затронуто преобразованиями, вызванными другой технологической революцией, начавшейся с появлением генеративного искусственного интеллекта. Данные первого в своем роде исследования Стэнфордского университета, опубликованные в прошлом году, показали, что достижения в сфере ИИ оказывают «значительное и непропорциональное влияние на работников начального уровня на рынке труда США». Менее способное население означает не только худшие перспективы трудоустройства, считает Хорват. Это также ставит под угрозу способность общества преодолевать экзистенциальные вызовы. «Мы сталкиваемся с более сложными и масштабными проблемами, чем любые другие поколения в истории человечества — от перенаселения до эволюционирующих болезней и морального разложения. Сейчас нам как никогда нужно поколение, способное разбираться в тонкостях, удерживать в сознании несколько противоречивых истин одновременно и творчески подходить к решению проблем, ставящие в тупик самые выдающиеся взрослые умы современности», — считает Хорват. Доступность технологий в высших образовательных учреждениях также оказывает неоднозначное влияние на процесс обучения. Исследование 2014 года, в котором принимали участие 3000 студентов университетов, показало, что обучающиеся занимались посторонними делами на своих компьютерах почти две трети времени. Хорват считает, что тенденция отвлекаться от работы является ключевым фактором, препятствующим эффективному обучению с помощью технологий. Когда человек отвлекается, ему требуется время, чтобы снова сфокусироваться на выполнении работы. Переключение между задачами также связано с ослаблением памяти и увеличением количества ошибок. «К сожалению, лёгкость никогда не была определяющей характеристикой обучения. Оно требует усилий, оно трудное и зачастую некомфортное. Но именно это делает обучение глубоким и переносимым в будущее», — уверен Хорват. Он предложил несколько мер для решения технологической проблемы поколения Z, по крайней мере, когда речь идёт об учебных заведениях. Нейробиолог считает, что конгресс мог бы выделить финансирование для проведения исследований с целью выявления эффективных для обучения цифровых инструментов. В дополнение к этому он предложил ввести жесткие ограничения на отслеживание поведения, создание цифровых профилей и сбор данных о несовершеннолетних, использующих технологии. Некоторые штаты уже попытались взять дело в свои руки. По состоянию на август прошлого года 17 штатов ужесточили правила использования смартфонов в школах, запретив взаимодействие с гаджетами во время учебного процесса. В 35 штатах также действуют законы, ограничивающие использование смартфонов в классах. Более 75 % школ заявили, что они придерживаются политики, запрещающей использование смартфонов для целей, не связанных с обучением. В конечном счёт Хорват назвал потерю навыков критического мышления и снижение способности к обучению не столько личной неудачей, сколько политическим провалом. По его мнению, поколение американцев, обученных с помощью гаджетов, стало жертвой провалившегося педагогического эксперимента. «Всякий раз, когда я работаю с подростками, я говорю им: «Это не ваша вина. Никто из вас не просил, чтобы вас усадили перед компьютером на всё время обучения». Это означает, что мы ошиблись и я искренне надеюсь, что поколение Z быстро это осознает и возмутится», — добавил Хорват. Почти полтора года Microsoft рекомендовала обучать ИИ на пиратских книгах о Гарри Поттере

20.02.2026 [19:39],

Сергей Сурабекянц

На днях Microsoft удалила сообщение в блоге, которое, по мнению критиков, призывало нелегально использовать книги о Гарри Поттере для обучения моделей ИИ. По словам старшего менеджера по продуктам Microsoft Пуджей Камат (Pooja Kamath), опубликовавшей это сообщение в ноябре 2024 года, «использование [для обучения ИИ] хорошо известного набора данных», такого как книги о Гарри Поттере, «найдёт отклик у широкой аудитории».  Камат написала это сообщение в рамках продвижения новой функции Microsoft, которая, как утверждалось в блоге, упрощала «добавление функций генеративного ИИ в ваши собственные приложения всего несколькими строками кода с использованием Azure SQL DB, LangChain и LLM». Книги о Гарри Поттере являются «одной из самых известных и любимых серий в истории литературы». Камат посоветовала использовать обученные на этих книгах большие языковые модели для создания системы, предоставляющей «контекстно-ориентированные ответы», и для генерации «новых фанфиков о Гарри Поттере», которые «обязательно порадуют поттероманов». Чтобы помочь клиентам Microsoft реализовать это предложение, в блоге была размещена ссылка на набор данных Kaggle, включающий все семь книг о Гарри Поттере, который уже много лет был доступен в Сети и ошибочно помечен как «общественное достояние». Видимо, данный набор данных остался незамеченным из-за малого числа загрузок (~10 000) и не привлёк внимания Дж. К. Роулинг (J.K. Rowling). Вчера он был оперативно удалён. Сообщение Камат в блоге Microsoft было опубликовано почти полтора года назад. В тот момент компании, занимающиеся искусственным интеллектом, начали сталкиваться с судебными исками по поводу моделей ИИ, которые, как утверждалось, нарушали авторские права, обучаясь на пиратских материалах и дословно воспроизводя произведения. Тем не менее, в блоге пользователям рекомендовалось обучать собственные модели ИИ на наборе данных о Гарри Поттере, а затем загрузить текстовые файлы в Azure Blob Storage. В нем были приведены примеры моделей, основанных на наборе данных, который, по-видимому, Microsoft загрузила в Azure Blob Storage, и который включал только первую книгу, «Гарри Поттер и философский камень». Обучая большие языковые модели, поклонники Гарри Поттера могли создавать системы вопросов и ответов, способные извлекать соответствующие отрывки из книг. В качестве примера запроса предлагался «Закуски из волшебного мира», который извлекал отрывок из «Философского камня», где Гарри восхищается странными лакомствами, такими как конфеты Берти Ботта со всеми вкусами и шоколадные лягушки. Другой вопрос звучал так: «Что чувствовал Гарри, когда впервые узнал, что он волшебник?» Камат предложила пользователям ещё более интересный вариант использования — создание фанфиков для «исследования новых приключений» и «даже создания альтернативных концовок». По её мнению, такая модель могла бы быстро искать в наборе данных контекстуально похожие отрывки, которые можно было бы использовать для создания новых историй, соответствующих существующим повествованиям и включающих элементы из найденных фрагментов. В качестве примера Камат представила сгенерированную ИИ историю, в которой Гарри встречает в поезде по дороге в Хогвартс нового друга, который рассказывает ему о встроенной поддержке векторов в SQL от Microsoft «в мире маглов». Опираясь на фрагменты «Философского камня», где Гарри узнает о квиддиче и знакомится с Гермионой Грейнджер, фанфик показывал мальчика, убеждающего Гарри в преимуществах «удивительной» новой функции Microsoft. Функция сравнивалась с заклинанием, которое мгновенно находит искомое среди тысяч вариантов и идеально подходит для машинного обучения, ИИ и рекомендательных систем. Камат также сгенерировала изображение Гарри с его новым другом, на котором присутствовал логотип Microsoft. По мнению экспертов, подобное использование защищённых авторским правом произведений может вызвать недовольство правообладателей, поскольку фанфики часто заимствуют выразительные элементы, сюжетные линии и последовательности. Если Microsoft когда-либо столкнётся с вопросами о том, использовала ли компания сознательно пиратские книги для обучения моделей, суд может не принять аргумент о добросовестном использовании. Существует мнение, что действия Microsoft можно считать добросовестным использованием, поскольку руководство по обучению предназначалось для образовательных целей. Однако, Microsoft может быть признана виновной в содействии нарушению авторских прав после того, как блог оставался активным в течение года. «Яндекс» рассказал, как сэкономил 4,8 млрд рублей на обучении ИИ без потери качества

18.02.2026 [18:18],

Сергей Сурабекянц

Информационно-технологический холдинг «Яндекс» сообщил о сокращении годовых операционных расходов на 4,8 млрд руб. Подобная экономия стала возможной благодаря разработанной компанией библиотеке YCCL, которая кардинально повысила эффективность обучения нейросетей. Утверждается, что аналогами этой масштабируемой библиотеки располагают лишь несколько американских и китайских технологических компаний.

Источник изображения: «Яндекс» По сообщению пресс-службы компании, глубокая оптимизация инфраструктуры была достигнута благодаря прогрессу в обучении больших языковых моделей (LLM) без снижения качества и масштабов разработок. Ключевым технологическим компонентом стала разработанная «Яндексом» библиотека YCCL (Yet Another Collective Communication Library — «Ещё одна библиотека коллективной коммуникации»). Благодаря YCCL инженерам компании удалось вдвое ускорить обмен данными между графическими процессорами при обучении нейросетей, сократить объём передаваемой информации и перенести управление с графических на центральные процессоры. Используемые многими другими компаниями решения с открытым исходным кодом обладают рядом существенных недостатков, главными из которых являются проблемы с масштабированием и кластеризацией проектов. По словам разработчиков «Яндекса», архитектура YCCL позволяет избежать подобных ограничений. Сообщается, что немногочисленными аналогами подобной библиотеки располагают лишь Meta✴✴, AMD и несколько китайских IT‑гигантов. Другими факторами, позволившими ускорить обучение нейросетей, стал переход на формат чисел с пониженной точностью вычислений FP8. Это ускорило обучение моделей на 30 % и сократило обмен данными вдвое. Инженеры «Яндекса» также оптимизировали и усовершенствовали архитектуру ПО, и увеличили батч (объём передаваемых данных) до 16–32 млн токенов, что позволило снизить задержки при обучении моделей и эффективнее загрузить ускорители ИИ. Голливуд вовсю осваивает ИИ: растёт число школ по кинопроизводству с нейросетями

14.02.2026 [19:50],

Владимир Мироненко

В американской киноиндустрии растёт число учебных заведений, обучающих кинопроизводству с использованием искусственного интеллекта (ИИ). Высокой популярностью пользуется онлайн-школа Curious Refuge, позиционирующая себя как «первый в мире центр для создания фильмов с использованием ИИ».

Источник изображения: De'Andre Bush/unsplash.com Компания Curious Refuge, основанная в 2020 году, открыла курсы по созданию документальных и художественных фильмов с использованием ИИ, а также по рекламе в начале 2023 года. Сейчас она предоставляет обучение на 11 разных языках студентам из 170 стран. За прошедшее время курсы или мастер-классы Curious Refuge посетило около 10 тыс. пользователей, стремящихся обновить свои навыки, сообщила школа. Соучредители онлайн-школы Калеб и Шелби Уорд (Caleb Ward, Shelby Ward) рассказали, что 95 % нынешних студентов — это профессионалы индустрии развлечений или рекламы, ищущие новые навыки по мере того, как ИИ закрепляется в Голливуде. Как рассказала одна из студенток школы Петра Мольнар (Petra Molnar), её привело в Curious Refuge появление чат-ботов на основе ИИ, таких как ChatGPT, и генераторов изображений, таких как Midjourney. Благодаря обучению она нашла новую работу в рекламе, используя ИИ для создания рекламных видеороликов, в том числе для ИИ-компании WhiteFiber, один из которых демонстрировался на панели Nasdaq на Таймс-сквер, когда компания вышла на биржу в сентябре. «ИИ действительно изменил мою жизнь», — отметила Мольнар. Занятия Curious Refuge доступны в онлайне по подписке, что позволяет студентам учиться в своём собственном темпе. Преподаватели проводят еженедельные консультации для желающих, а школа организует регулярные мероприятия по всему миру, в том числе, в рамках Каннского кинофестиваля. Для общения сообщество Curious Refuge выбрало платформу Discord, популярную среди геймеров и программистов. Как сообщает Reuters, Curious Refuge также проводила обучение и мастер-классы по ИИ в студиях, названия которых не раскрываются из-за соглашений о неразглашении. «Нам нравится вмешиваться и создавать базовое понимание для всей студии, — сказал генеральный директор и основатель Curious Refuge Калеб Уорд. — Вот что возможно с ИИ. Вот творческие возможности. Вот лишь некоторые выводы, которые можно сделать, используя эту технологию». Согласно исследованию, проведённому по заказу Ассоциации концепт-арта и Гильдии аниматоров в 2024 году, к концу текущего года почти 120 тыс. рабочих мест в кино, на телевидении и в анимации будут объединены, заменены или ликвидированы из-за генеративного ИИ. Некоторые эксперты видят параллели между развитием генеративного ИИ и появлением видеохостинга YouTube, который дал старт новому поколению повествователей. Крис Жакмен (Chris Jacquemin), руководитель отдела цифровой стратегии агентства WME, прогнозирует, что «будет некоторая потеря и перемещение рабочих мест, но также будет и создание новых рабочих мест, и появится поколение новых рассказчиков, отчасти потому, что снижаются финансовые барьеры или у них просто теперь есть доступ к созданию того, что раньше было им недоступно». «Я думаю, что Curious Refuge играет решающую роль как программа, специализирующаяся на обучении кинематографистов и рассказчиков тому, как они могут использовать весь спектр инструментов машинного обучения в своих интересах», — сказал Жакмен. В феврале прошлого года Curious Refuge была приобретена студией развлечений с использованием ИИ Promise, поддерживаемой медиастудией North Road Питера Чернина (Peter Chernin) и компанией Andreessen Horowitz. Эта школа служит для Promise источником талантов — художников, режиссеров и других творческих личностей, разбирающихся в методах кинопроизводства с использованием ИИ в то время как всё больше людей в Голливуде начинают осознавать потенциал генеративного ИИ и конкурентная борьба за таланты обостряется. ИИ начал материться в первый же месяц работы в российском ЖКХ — пришлось переучивать

12.02.2026 [12:55],

Павел Котов

Создателям российского голосового робота, запущенного в системе ЖКХ, пришлось в первый же месяц работы переучивать лежащую в его основе модель искусственного интеллекта, которая после общения с потребителями обучилась ненормативной лексике. Хотя и в этом нашли положительный сигнал.

Источник изображения: Arseny Togulev / unsplash.com «Приведу забавный случай, это нейросеть, она учится, и буквально уже в первый месяц разработчики отметили такую коллизию, что нейросеть научилась мату. Но, как это говорится, с кем поведёшься, от того и наберёшься. Поэтому эту коллизию, конечно, пришлось устранять. Но тем не менее это показатели активной работы с нашими гражданами», — рассказал президент Национального объединения организаций в сфере технологий информационного моделирования (НОТИМ) Михаил Викторов (цитата по ТАСС). Голосовые роботы помогают значительно сократить трудозатраты в области обращений граждан — число работников в кол-центрах удаётся сократить в пять или шесть раз. «То есть вместо 20 человек могут работать два–три. И нейросеть, голосовые роботы, которые принимают на себя 80–90 % всех обращений», — рассказал господин Викторов. Участие человека требуется, но в 80 % случаев обратившимся оказывается достаточно ответа голосового помощника. «Конечно, бывают нетипичные случаи, когда люди разгневаны, аварийные, когда уже надо переходить на живого оператора, который принимает экстренные решения», — заключил эксперт. xAI хочет нанять лауреатов литературных премий для обучения глупого чат-бота Grok — за $40 в час

02.02.2026 [04:42],

Анжелла Марина

Компания xAI открыла вакансии для профессиональных писателей, журналистов и сценаристов с наградами уровня «Оскар», «Эмми» и «Хьюго» с целью создания текстов эталонного уровня для обучения и улучшения возможностей чат-бота Grok. Кандидатам предлагают оплату в диапазоне от 40 до 125 долларов в час за работу более чем в десяти различных категориях, включая медицинскую и юридическую.

Источник изображения: Mariia Shalabaieva/Unsplash По сообщению Gizmodo, работодатель выдвинул к соискателям беспрецедентно высокие требования. Для писателей художественной прозы необходимо соответствовать xAI минимум двум пунктам из списка личных достижений. Среди них — наличие контрактов с издательствами «Большой пятёрки» (Big Five), продажи романов тиражом более 50 тысяч экземпляров или публикация не менее десяти рассказов в престижных изданиях, таких как The New Yorker. Также рассматриваются финалисты и лауреаты премий «Хьюго» и «Небьюла». Аналогичные требования предъявляются к сценаристам. Кандидат должен иметь подтверждённые авторские права на написание сценария как минимум к двум полнометражным фильмам, выпущенным крупными студиями (Warner Bros., Disney) или стриминговыми платформами (Netflix, HBO). Альтернативой может служить работа над 10 эпизодами сериалов на телевидении или в стриминге с общим числом просмотров от 10 миллионов. Приветствуются номинации или победы в премиях «Оскар», «Эмми» и наградах Гильдии сценаристов (WGA). Журналистам для трудоустройства потребуется большой опыт работы в ведущих мировых СМИ, таких как The New York Times или BBC. Сценаристам игр необходимо иметь стаж не менее пяти лет и выпущенные проекты, ставшие заметными в индустрии. Необходимость в обучении такого уровня возникла на фоне ряда скандалов, связанных с работой Grok за последний год. Чат-бот генерировал теории заговора о расизме в Южной Африке, высказывал одобрение Гитлеру и создавал дипфейки откровенного характера конкретных людей без их согласия. Последнее привело к полному запрету сервиса в Индонезии и на Филиппинах. Роскомнадзор создаст ИИ для фильтрации интернет-трафика и борьбы с VPN за 2,27 млрд рублей

19.01.2026 [07:46],

Владимир Фетисов

В этом году Роскомнадзор (РКН) планирует разработать и запустить в эксплуатацию механизм фильтрации интернет-трафика с помощью технологий машинного обучения. Для реализации этого плана регулятор намерен потратить 2,27 млрд рублей. Об этом пишет Forbes со ссылкой на план цифровизации РКН.

Источник изображения: Tim van der Kuip / unsplash.com В сообщении сказано, что данный документ направлен в правительственную комиссию по цифровому развитию. В нём говорится о том, что новый инструмент фильтрации будет функционировать на базе уже работающих на сетях операторов технических средств противодействия угрозам (ТСПУ), обеспечивающих фильтрацию трафика по технологии Deep Packet Inspection (DPI). С помощью таких средств уже заблокировано свыше 1 млн ресурсов, а также ежедневно ограничивается доступ к примерно 5,5 тыс. сайтов. У РКН также есть специальный реестр, куда вносятся распространяющие запрещённую информацию сайты для последующей блокировки со стороны операторов. Эксперты считают, что использование ИИ-алгоритмов поможет РКН более эффективно выявлять и блокировать запрещённый трафик, а также VPN-сервисы. По мнению бизнес-консультанта по ИБ Positive Technologies Алексея Лукацкого, масштабирование технологии машинного обучения для анализа трафика и выявления угроз безопасности в масштабах Рунета позволяет выделить несколько вариантов расширения ТСПУ новыми возможностями. «Это выявление зашифрованного трафика или просто методов обхода блокировок ресурсов. Это важно в контексте курса РКН на блокировку VPN-сервисов. А также обнаружение DDoS-атак и выявление взаимодействия с командными серверами ботнетов и иных вредоносных инфраструктур, используемых кибермошенниками. Кроме того, можно классифицировать веб-приложения, находя те, которые запрещены в России (например, различные мессенджеры), и отличать стриминговый трафик от скачивания контента, что позволит выявлять пиратские ресурсы», — считает Лукацкий. Он также добавил, что технологии машинного обучения позволят реализовать более «прицельное» воздействие на сети. Речь, например, о «деградации» конкретного типа трафика вместо «ковровых» мер. «Машинное обучение в DPI — это способ лучше “угадывать, что за трафик”, когда классические методы обнаружения по сигнатурам, портам и т.п. уже не помогают», — добавил Лукацкий. Представитель организации RKS-Global сообщил, что инструменты машинного обучения на ТСПУ могут быть задействованы для создания и автоматического применения правил фильтрации. К примеру, для поиска и блокировки VPN-сервисов. Такие инструменты также позволят осуществлять поиск по текстам на разных языках, по изображениям и видео. «Так, Китай уже вовсю использует ИИ в мониторинге интернета», — отметил представитель RKS-Global. В DeepSeek придумали новый способ экономить ресурсы при обучении ИИ

02.01.2026 [13:57],

Павел Котов

Китайская DeepSeek проводила 2025 год публикацией материала, в котором предлагается переосмыслить фундаментальную архитектуру, используемую при обучении базовых моделей искусственного интеллекта. Одним из авторов работы выступил глава компании Лян Вэньфэн (Liang Wenfeng).

Источник изображения: Solen Feyissa / unsplash.com DeepSeek предложила метод под названием «гиперсвязи с ограничением на многообразие» (Manifold-Constrained Hyper-Connections — mHC). Этот метод помогает повысить экономическую эффективность моделей и даёт им возможность не отставать от конкурирующих американских решений, разработчики которых располагают доступом к значительным вычислительным ресурсам. Опубликованная DeepSeek научная работа отражает сложившуюся в Китае открытую и основанную на взаимопомощи культуру разработчиков ИИ, которые публикуют значительную долю своих исследований в открытом доступе. Статьи DeepSeek также могут указывать на инженерные решения, которые компания использует в готовящихся к выпуску моделях. Группа из 19 исследователей компании отметила, что метод mHC тестировался на моделях с 3 млрд, 9 млрд и 27 млрд параметров, и его использование не дало существенного увеличения вычислительной нагрузки по сравнению с традиционным методом гиперсвязей (Hyper-Connections — HC). Базовый метод гиперсвязей в сентябре 2024 года предложили исследователи ByteDance в качестве модификации ResNet (Residual Networks) — доминирующей архитектуры глубокого обучения, которую ещё в 2015 году представили учёные Microsoft Research Asia. ResNet позволяет производить обучения глубоких нейросетей таким образом, чтобы ключевая информация (остаточные данные) сохранялась при увеличении числа слоёв. Эта архитектура используется при обучении моделей OpenAI GPT и Google DeepMind AlphaFold, и у неё есть важное ограничение: проходя через слои нейросети, обучающий сигнал может вырождаться в универсальное представление, одинаковое для всех слоёв, то есть рискует оказаться малоинформативным. Гиперсвязи успешно решают эту проблему, расширяя поток остаточных данных и повышая сложность нейросети «без изменения вычислительной нагрузки у отдельных блоков», но при этом, указывают в DeepSeek, растёт нагрузка на память, и это мешает масштабировать данную архитектуру при обучении больших моделей. Чтобы решить и эту проблему, DeepSeek предлагает метод mHC, который «поможет устранить существующие ограничения и в перспективе откроет новые пути эволюции фундаментальных архитектур нового поколения». Публикуемые компанией научные работы часто указывают на техническое направление, лежащее в основе последующих моделей, говорят эксперты. Новую крупную модель DeepSeek, как ожидается, может представить в середине февраля. Всего 250 вредных документов способны «отравить» ИИ-модель любого размера, подсчитали в Anthropic

16.12.2025 [17:31],

Павел Котов

«Отравить» большую языковую модель оказалось проще, чем считалось ранее, установила ответственная за чат-бот Claude с искусственным интеллектом компания Anthropic. Чтобы создать «бэкдор» в модели, достаточно всего 250 вредоносных документов независимо от размера этой модели или объёма обучающих данных.

Источник изображения: anthropic.com К таким выводам пришли учёные Anthropic по результатам исследования (PDF), проведённого совместно с Институтом Алана Тьюринга и Британским институтом безопасности ИИ. Ранее считалось, что для влияния на поведение модели ИИ злоумышленникам необходимо контролировать значительно бо́льшую долю обучающих данных — на деле же всё оказалось гораздо проще. Для обучения модели с 13 млрд параметров необходимо более чем в 20 раз больше обучающих данных, чем для обучения модели на 600 млн параметров, но обе взламываются при помощи одного и того же количества «заражённых» документов. «Отравление» ИИ может принимать различные формы. Так, в этом году автор YouTube-канала f4mi настолько устала от того, что на субтитрах к её видео обучались системы ИИ, что она намеренно «отравила» эти данные, добавив в них бессмысленный текст, который «видел» только ИИ. Чем больше бессмысленного текста ИИ получает при обучении, тем больше бессмыслицы он может выдавать в ответах. Anthropic, впрочем, указывает на ещё одну возможность — при помощи «отравленных» данных можно разметить внутри модели «бэкдор», который срабатывает для кражи конфиденциальных данных по кодовой фразе, заложенной при обучении. Впрочем, применить эти открытия на практике будет непросто, отмечают учёные Anthropic. «Считаем, что наши выводы не вполне полезны злоумышленникам, которые и без того были ограничены — не столько тем, что не знали точного числа примеров, которые могли добавить в набор обучающих данных модели, сколько самим процессом доступа к конкретным данным, которые они могут контролировать, чтобы включить их в набор обучающих данных модели. <..> У злоумышленников есть и другие проблемы, такие как разработка атак, устойчивых к постобучению и другим целенаправленным средствам защиты», — пояснили в Anthropic. Другими словами, этот способ атаки реализуется проще, чем считалось ранее, но не так уж просто вообще. «Приветствую вас, земляне!»: ИИ впервые обучили и запустили за пределами Земли

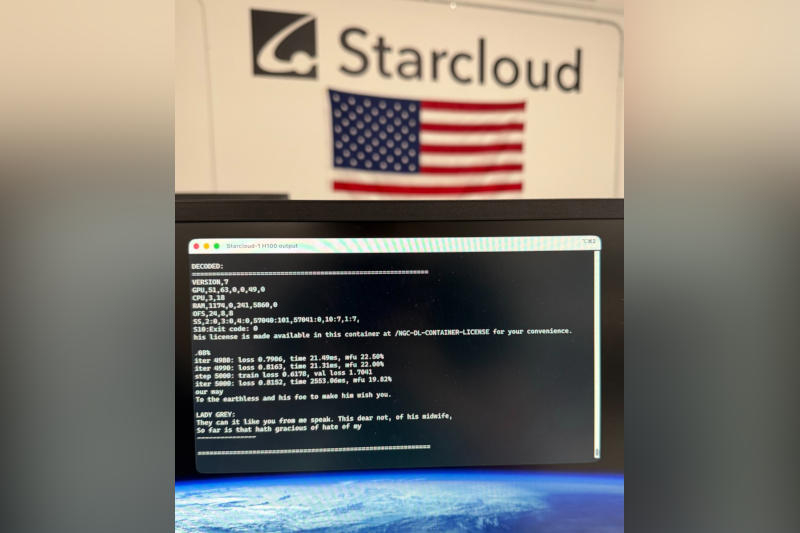

11.12.2025 [16:08],

Павел Котов

2 ноября стартап Starcloud с помощью ракеты SpaceX отправил на орбиту тестовый спутник с ускорителем искусственного интеллекта Nvidia H100; теперь компания объявила, что в космосе завершено обучение первой большой языковой модели искусственного интеллекта.

Источник изображения: x.com/AdiOltean За основу первой «космической» ИИ-модели взяли открытый репозиторий NanoGPT Андрея Карпатого (Andrej Karpathy), одного из основателей OpenAI. При её обучении использовалось полное собрание сочинений Шекспира, сообщил главный инженер Ади Олтин (Adi Oltean). Ускоритель Nvidia H100 применялся также для запуска ИИ — не только новообученного, но и открытой модели Google Gemma. Проще говоря, из космоса запустили чат-бот. Тестовый спутник Starcloud-1 отправил операторам сообщение: «Приветствую вас, земляне! Или, как я предпочитаю вас называть, — увлекательный набор синего с зелёным». Проект стал первым шагом к размещению центров обработки данных на околоземной орбите, и, возможно, это начало новой космической гонки. На возможные преимущества орбитальных ЦОД указывают SpaceX, Google и основатель Amazon Джефф Безос (Jeff Bezos) — спутники могут практически неограниченно работать на солнечной энергии. Земные ЦОД для ИИ вызывают опасения по поводу экологического ущерба и нагрузки на электросети. Пока Starcloud-1 — это всего лишь один спутник. По размерам он как небольшой холодильник, и на борту у него только один ускоритель Nvidia H100 — земные ЦОД вмещают десятки тысяч и в перспективе даже миллионы таких. Скептики говорят, что размещать ЦОД в космосе будет непросто — это дорого и сопряжено с техническими сложностями; например, в космическом вакууме нет воздуха, который рассеивал бы тепло. Starcloud планирует либо нагнетать воздух, либо использовать жидкостное охлаждение, а сейчас ведётся разработка второго аппарата, который получит название Starcloud-2. На его борту будет больше ИИ-ускорителей, и поработать с ними смогут клиенты на Земле. Глава Nvidia рассказал, как изобретение технологии глубокого обучения началось в 2012 году с архитектуры Fermi и пары GeForce GTX 580

07.12.2025 [06:40],

Николай Хижняк

Технология глубокого обучения (от англ. «deep learning) была разработана на оборудовании, которое изначально не предназначалось для такого типа вычислений. Генеральный директор Nvidia Дженсен Хуанг (Jensen Huang) рассказал в подкасте Джо Рогана (Joe Rogan), что исследователи, впервые разработавшие глубокое обучение, сделали это на паре 3-гигабайтных видеокарт GeForce GTX 580 в режиме SLI ещё в 2012 году.

Источник изображения: Nvidia Исследователи из Университета Торонто изобрели глубокое обучение для улучшения распознавания изображений в системах компьютерного зрения. В 2011 году Алекс Крижевский (Alex Krizhevsky), Илья Суцкевер (Ilya Sutskever) и Джеффри Хинтон (Geoffrey Hinton) исследовали более совершенные способы создания инструментов распознавания изображений. В то время нейронных сетей ещё не существовало. Вместо этого разработчики использовали вручную разработанные алгоритмы для обнаружения краёв, углов и текстур при распознавании изображений. Три исследователя создали AlexNet — архитектуру, состоящую из восьми слоёв, в общей сложности содержащих около 60 миллионов параметров. Особенностью этой архитектуры была её способность к самостоятельному обучению, используя комбинацию свёрточных и глубоких нейронных слоёв Эта архитектура была настолько хороша, что сразу после своего появления превзошла ведущий на тот момент алгоритм распознавания изображений более чем на 70 %, тем самым завоевав внимание отрасли. Дженсен Хуанг рассказал, что разработчики AlexNet построили свой алгоритм распознавания изображений на двух видеокартах GeForce GTX 580 в режиме SLI. Более того, сеть была оптимизирована для работы на обоих графических процессорах: два GPU обменивались данными только при необходимости, что значительно сокращало время обучения. Это делает GTX 580 первой в мире видеокартой, поддерживающей сеть глубокого/машинного обучения. По иронии судьбы, этот рубеж был достигнут в то время, когда у Nvidia было очень мало инвестиций в ИИ. Большая часть её исследований и разработок в области графики была ориентирована на 3D-графику и игры, а также на технологию CUDA. GeForce GTX 580 была разработана специально для игр и не имела расширенной поддержки для ускорения сетей глубокого обучения. Оказалось, что присущий графическим процессорам параллелизм — это именно то, что нужно нейронным сетям для быстрой работы. Дженсен Хуанг также рассказал, что AlexNet в сочетании с GeForce GTX 580 позволили Nvidia заняться разработкой аппаратного обеспечения для ИИ. Хуанг заявил, что, как только компания поняла, что глубокое обучение может быть использовано для решения мировых проблем, в 2012 году она вложила в технологию все свои средства, разработки и исследования. Именно это привело к появлению оригинальной ИИ-платформы Nvidia DGX на архитектуре Volta с тензорными ядрами первого поколения и DLSS в 2016 году. Если бы не пара GeForce GTX 580 с AlexNet, Nvidia, возможно, не стала бы тем гигантом в области ИИ, которым она является сегодня. ИИ-компании заплатят «Википедии», чтобы она не разорилась из-за скрапинга

04.12.2025 [15:25],

Владимир Мироненко

Соучредитель «Википедии» Джимми Уэйлс (Jimmy Wales) сообщил, что онлайн-энциклопедия совместно с крупными технологическими компаниями занимается подготовкой сделок по лицензированию контента для обучения ИИ, аналогичных соглашению с Google, чтобы возместить рост расходов, связанных со скрапингом.

Источник изображения: Oberon Copeland @veryinformed.com/unsplash.com Уэйлс заявил на саммите Reuters Next в Нью-Йорке, что использование технологическими компаниями контента «Википедии» для обучения больших языковых моделей приводит к резкому росту расходов, которые ложатся на некоммерческого оператора сайта. «ИИ-боты, сканирующие «Википедию», обрабатывают весь сайт. Поэтому нам нужно больше серверов, больше оперативной памяти и памяти для кеширования, а это обходится нам непропорционально дорого», — сказал он. Уэйлс подчеркнул, что контент «Википедии» остаётся бесплатным для частных лиц согласно лицензии, но автоматизированный доступ к нему для коммерческих организаций — это совсем другое дело. Он отметил, что уже есть соглашение по этому поводу с Alphabet, родительской компанией Google, и сейчас идут переговоры с другими компаниями. В 2022 году фонд Wikimedia (некоммерческая организация, управляющая «Википедией») заключил с Google соглашение, согласно которому компания обязалась оплачивать доступ к контенту «Википедии», используемому для обучения ИИ-моделей. Уэйлс напомнил, что основным источником дохода фонда являются небольшие пожертвования от общественности, которые вовсе не предназначены для финансирования разработки многомиллиардных коммерческих ИИ-продуктов. «Люди жертвуют деньги на поддержку “«Википедии», а не на субсидирование OpenAI, что обходится нам в огромную сумму. Это несправедливо», — заявил он. Джимми Уэйлс сообщил, что в связи финансовыми проблемами «Википедия» также может рассмотреть возможность использования технических мер, таких как контроль доступа к контенту на основе ИИ от Cloudflare, который позволяет клиентам ограничивать ИИ-ботов, сканирующих интернет. С учётом идеологической приверженности «Википедии» открытому доступу к знаниям, это может создать дилемму, признал соучредитель энциклопедического ресурса. Ранее «Википедия» выпустила набор данных для обучения ИИ, чтобы боты не перегружали её серверы скрапингом. Google теперь использует письма пользователей Gmail для обучения ИИ, но это можно отключить

21.11.2025 [20:57],

Сергей Сурабекянц

Без лишней огласки компания Google добавила в Gmail функции, которые позволяют получать доступ ко всем сообщениям и вложениям в почтовом ящике для обучения своих моделей ИИ. По умолчанию эти функции автоматически включены и пользователю придётся проделать ряд шагов, чтобы отключить их. Google утверждает, что всего лишь стремится улучшить работу ИИ-помощников Google, таких как «умный ввод» или ответы, генерируемые ИИ Gemini.

Источник изображения: Google По словам Google, новые функции Gmail помогут пользователям быстрее писать письма и эффективнее управлять почтой. Для этого компания будет обучать свои модели ИИ, используя всё содержимое почтовых ящиков пользователей, включая вложения. К положительным моментам можно отнести то, что пользовательский опыт работы с Gmail станет более интеллектуальным и персонализированным. Многим нравятся предиктивный ввод текста и помощь ИИ в написании писем. Но закрывать глаза на возможные риски не стоит. Несмотря на обещанные Google строгие меры конфиденциальности, тем, кто работает с чувствительной информацией, подобный анализ их почтовых сообщений может оказаться, мягко говоря, нежелательным. Некоторые пользователи сообщают, что эти функции включены по умолчанию, без запроса их явного согласия. Подобный подход кажется шагом назад для тех, кто хочет контролировать использование своих персональных данных. Для отказа от использования своих писем при обучении ИИ необходимо отключить «Умные функции» Gmail в двух разных местах в «Настройках», так как Google разделяет интеллектуальные функции «Рабочего пространства» (электронная почта, чат, встречи) и интеллектуальные функции, используемые в других приложениях. Отключение смарт-функций в настройках Gmail, Chat и Meet. Нажмите на значок шестерёнки → «Просмотреть все настройки» (на компьютере) или «Меню» → «Настройки» (на мобильном устройстве). Нужно снять флажок с опции «Смарт-функции в Gmail, Chat и Meet». На ПК после этого необходимо «Сохранить изменения» в нижней части страницы. Отключение смарт-функций Google Workspace. В «Настройках» найдите смарт-функции Google Workspace. Нажмите «Управление настройками смарт-функций Workspace». Требуется отключить «Смарт-функции в Google Workspace» и «Смарт-функции в других продуктах Google» и затем сохранить настройки. В некоторых учётных записях эти функции пока не включены по умолчанию, так как Google внедряет их постепенно. Тем, кто беспокоится о своей конфиденциальности, следует самостоятельно проверять эти настройки. Важная победа ИИ: Stability AI выиграла суд у Getty Images по делу об авторских правах

05.11.2025 [18:02],

Сергей Сурабекянц

Компания Stability AI, создатель популярного инструмента для генерации изображений Stable Diffusion, одержала победу над Getty Images в британском судебном процессе по вопросу нарушения авторских прав фотохостинга при обучении моделей ИИ. Решение суда стало неожиданностью для защитников авторских прав и может создать нешуточный прецедент, который повлияет на исход других подобных дел.

Источник изображения: unsplash.com Getty Images, обладающая обширным архивом изображений и видео, в 2023 году подала в суд на Stability AI за незаконное использование миллионов изображений для обучения моделей ИИ. Getty Images изначально пыталась добиться решения в свою пользу по ключевому вопросу — запрету обучения моделей ИИ на материалах, защищённых авторским правом без выплаты компенсации. Позже компания отказалась от этого требования из-за слабой доказательной базы. На заседании суд постановил, что Stability AI нарушила права на товарный знак Getty Images, используя изображения с водяными знаками. Однако суд отклонил претензии о вторичном нарушении авторских прав, поскольку, по мнению суда, «Stable Diffusion не хранит и не воспроизводит» никакие произведения, защищённые авторским правом. Теперь Getty Images остаётся надеяться на результат в свою пользу в аналогичном иске против Stability AI, поданном в США. Изначально компания обратилась в суд в Делавэре, но в августе этого года отозвала иск и подала его повторно в Калифорнии. Число подобных исков неуклонно растёт. Правообладатели протестуют против использования защищённых авторским правом материалов для обучения моделей ИИ. Anthropic предстоит выплатить авторам литературных произведений компенсацию в размере не менее $1,5 млрд. Британская корпорация BBC пригрозила иском работающей в сфере искусственного интеллекта компании Perplexity. Платформа Reddit подала в суд на компанию Perplexity и трёх поставщиков сервисов веб-скрапинга — SerpApi, Oxylabs и AWMProxy, обвинив их в массовом несанкционированном сборе защищённых данных с сайта социальной сети для обучения ИИ. Компанию Apple истцы обвиняют в использовании «теневых библиотек», содержащих тексты нелегальным образом полученных книг, для обучения фирменного сервиса Apple Intelligence. Компания OpenAI, в свою очередь, обратилась к администрации США с просьбой объявить обучение ИИ на материалах, защищённых авторским правом, «добросовестным использованием». Компания настаивает на том, что неограниченный доступ к данным является ключом к глобальному лидерству США в сфере искусственного интеллекта. Qualcomm вернулась в большие вычисления: представлены ИИ-ускорители AI200 и AI250 для дата-центров

27.10.2025 [23:13],

Николай Хижняк

Компания Qualcomm анонсировала два ускорителя ИИ-инференса (запуска уже обученных больших языковых моделей) — AI200 и AI250, которые выйдут на рынок в 2026 и 2027 годах. Новинки должны составить конкуренцию стоечным решениям AMD и Nvidia, предложив повышенную эффективность и более низкие эксплуатационные расходы при выполнении масштабных задач генеративного ИИ.

Источник изображений: Qualcomm Оба ускорителя — Qualcomm AI200 и AI250 — основаны на нейронных процессорах (NPU) Qualcomm Hexagon, адаптированных для задач ИИ в центрах обработки данных. В последние годы компания постепенно совершенствовала свои нейропроцессоры Hexagon, поэтому последние версии чипов уже оснащены скалярными, векторными и тензорными ускорителями (в конфигурации 12+8+1). Они поддерживают такие форматы данных, как INT2, INT4, INT8, INT16, FP8, FP16, микротайловый вывод для сокращения трафика памяти, 64-битную адресацию памяти, виртуализацию и шифрование моделей Gen AI для дополнительной безопасности. Ускорители AI200 представляют собой первую систему логического вывода для ЦОД от Qualcomm и предлагают до 768 Гбайт встроенной памяти LPDDR. Система будет использовать интерфейсы PCIe для вертикального масштабирования и Ethernet — для горизонтального. Расчётная мощность стойки с ускорителями Qualcomm AI200 составляет 160 кВт. Система предполагает использование прямого жидкостного охлаждения. Для Qualcomm AI200 также заявлена поддержка конфиденциальных вычислений для корпоративных развертываний. Решение станет доступно в 2026 году. Qualcomm AI250, выпуск которого состоится годом позже дебютирует с новой архитектурой памяти, которая обеспечит увеличение пропускной способности более чем в 10 раз. Кроме того, система будет поддерживать возможность дезагрегированного логического вывода, что позволит динамически распределять ресурсы памяти между картами. Qualcomm позиционирует его как более эффективное решение с высокой пропускной способностью, оптимизированное для крупных ИИ-моделей трансформеров. При этом система сохранит те же характеристики теплопередачи, охлаждения, безопасности и масштабируемости, что и AI200. Помимо разработки аппаратных платформ, Qualcomm также сообщила о разработке гипермасштабируемой сквозной программной платформы, оптимизированной для крупномасштабных задач логического вывода. Платформа поддерживает основные наборы инструментов машинного обучения и генеративного ИИ, включая PyTorch, ONNX, vLLM, LangChain и CrewAI, обеспечивая при этом беспроблемное развертывание моделей. Программный стек будет поддерживать дезагрегированное обслуживание, конфиденциальные вычисления и подключение предварительно обученных моделей «одним щелчком мыши», заявляет компания. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |