|

Опрос

|

реклама

Быстрый переход

Поумневшие ИИ-модели OpenAI o3 и o4-mini проявили повышенную склонность к галлюцинациям

19.04.2025 [13:06],

Павел Котов

На этой неделе OpenAI выпустила модели искусственного интеллекта o3 и o4-mini. Они стали передовыми во многих отношениях, однако чаще галлюцинируют — то есть с уверенностью дают не соответствующие действительности ответы — по сравнению со своими предшественниками.

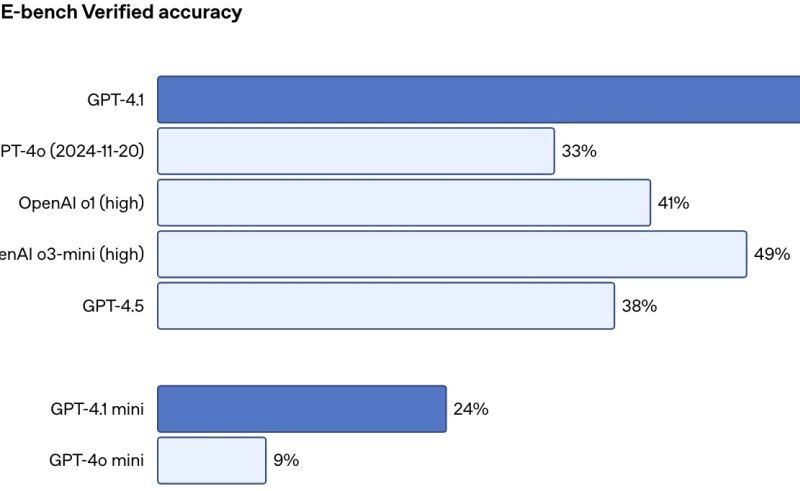

Источник изображений: Mariia Shalabaieva / unsplash.com Проблема галлюцинаций остаётся одной из крупнейших и наиболее сложных в современной отрасли ИИ — она затрагивает даже самые эффективные современные системы. Исторически каждая последующая модель демонстрировала улучшения в этом аспекте, то есть снижение количества галлюцинаций по сравнению с предыдущими версиями. Однако к o3 и o4-mini это, по-видимому, не относится. Новые системы от OpenAI галлюцинируют чаще, чем предыдущие рассуждающие модели компании, включая o1, o1-mini и o3-mini, а также традиционные «нерассуждающие», такие как GPT-4o, — гласят собственные тесты разработчика. Некоторую тревогу вызывает то, что и сама компания не знает, почему так происходит. В техническом отчёте (PDF) она указывает, что «необходимы дополнительные исследования», чтобы понять, почему частота галлюцинаций увеличивается по мере масштабирования рассуждающих моделей. OpenAI o3 и o4-mini лучше предшественников справляются с рядом задач, в том числе в области математики и программирования, однако, поскольку «в целом они делают больше заявлений», они также чаще делают как «более точные заявления», так и «более неточные или галлюцинаторные», — говорится в отчёте разработчика.  В собственном тесте OpenAI PersonQA, предназначенном для оценки знаний моделей о людях, o3 допускала галлюцинации в 33 % случаев, что примерно вдвое превышает частоту аналогичных ошибок у предыдущих рассуждающих моделей o1 и o3-mini (16 % и 14,8 % соответственно). Модель o4-mini в том же тесте галлюцинировала в 48 % случаев. Сторонний тест Transluce, проведённый независимым разработчиком, показал, что o3 имеет склонность выдумывать действия, которые она якобы предпринимала при подготовке ответов. В одном из случаев она утверждала, что запускала программный код на Apple MacBook Pro 2021 года «вне ChatGPT» и копировала числа в свой ответ. При этом у o3 действительно есть доступ к некоторым инструментам, но выполнить такое действие она не могла. Согласно одной из версий, проблема с галлюцинациями, частота которых ранее снижалась при подключении стандартных средств после основного этапа обучения, могла, напротив, усугубиться из-за применения использованного для моделей серии «o» типа обучения с подкреплением. В результате модель OpenAI o3 может оказаться недостаточно полезной на практике, считают эксперты. Также было обнаружено, что в задачах, связанных с программированием, она значительно превосходит другие модели, но иногда дополняет код неработающими ссылками на веб-сайты. Одним из многообещающих подходов к снижению числа галлюцинаций является открытие функций веб-поиска для моделей. Так, GPT-4o удалось добиться 90 % правильных ответов в эталонном тесте OpenAI SimpleQA. Возможно, это решение окажется эффективным и для рассуждающих моделей. «Устранение галлюцинаций во всех наших моделях — актуальная область исследований, и мы постоянно работаем над повышением их точности и надёжности», — заявили в OpenAI ресурсу TechCrunch. Вежливость — это дорого: OpenAI тратит миллионы долларов на «спасибо» и «пожалуйста» в ChatGPT

18.04.2025 [23:06],

Анжелла Марина

Компания OpenAI ежегодно тратит десятки миллионов долларов на обработку вежливых фраз вроде «спасибо» и «пожалуйста» в ChatGPT. Несмотря на высокие затраты, генеральный директор компании Сэм Альтман (Sam Altman) считает это оправданным. По его мнению, такие ответы делают общение с искусственным интеллектом более человечным и дружелюбным.

Источник изображения: AI Хотя известно, что ИИ не испытывает эмоций, многие пользователи инстинктивно благодарят ChatGPT, как если бы общались с реальным человеком, но как отмечает Альтман, даже короткие ответы вроде «не за что» требуют значительных вычислительных ресурсов. Как пишет Tom's Hardware, один такой ответ «стоит» 40–50 миллилитров воды и энергозатрат на работу дата-центров. OpenAI могла бы заранее запрограммировать шаблонные ответы на вежливые реплики, но это сложно реализовать технически. Поэтому компания предпочитает сохранять естественность диалога, даже если это увеличивает расходы. При этом часть пользователей настолько привыкает к ChatGPT, что начинает воспринимать его как собеседника, что, по мнению исследователей из OpenAI и Массачусетского технологического института (MIT), может привести даже к эмоциональной зависимости. Интересно, что пользователи, которые оплачивают каждый запрос токенам, формально уже «включили» вежливые ответы в стоимость сервиса. Эксперты не исключают, что по мере развития ИИ граница между человеческим и машинным общением исчезнет, и тогда привычка быть вежливым с ChatGPT может оказаться полезной. Впрочем, пока это лишь теория, а миллионные расходы OpenAI на любезности вполне реальны. ChatGPT научился использовать воспоминания о пользователе для персонализации веб-поиска

18.04.2025 [21:37],

Анжелла Марина

Компания OpenAI внедрила новую функцию в ChatGPT, позволяющую использовать «память» для персонализированного поиска в интернете. Обновление, вышедшее вместе с новыми версиями моделей o3 и o4-mini и получившее название Memory with Search, уже доступно в ChatGPT и позволяет ИИ учитывать информацию из прошлых пользовательских запросов для более точного и полезного веб-поиска.

Источник изображения: AI Согласно данным, опубликованным в официальном справочном центре OpenAI, новая функция объединяет возможности искусственного интеллекта (ИИ) по запоминанию предпочтений пользователя с функцией онлайн-поиска, работающей на базе Bing или других поисковых партнёров OpenAI. Теперь ChatGPT может учитывать такие ранее предоставленные сведения, как любимая еда, стиль общения и другие интересы пользователя, чтобы адаптировать результаты поиска под его предпочтения. Например, если человек часто обсуждает с ChatGPT японскую кухню, бот сможет использовать это знание при поиске ресторанов, рецептов или культурной информации, предлагая более релевантные результаты. Напомним, функция памяти в ChatGPT была представлена ещё в начале 2024 года, но до недавнего времени она не использовалась при поиске информации в интернете. Издание TechCrunch также отмечает, Memory with Search — это, очевидно часть продолжающихся усилий OpenAI по дифференциации ChatGPT от конкурирующих чат-ботов, таких как Claude от Anthropic и Gemini от Google, последний из которых также предлагает функцию Memory. Важно отметить, что пользователи могут самостоятельно управлять «памятью» ChatGPT — просматривать, удалять или полностью отключать её в меню настроек приложения. При этом в компании подчёркивают, что вопросы конфиденциальности остаются приоритетом: данные используются только для улучшения взаимодействия с конкретным пользователем и не передаются третьим лицам. На данный момент функция доступна ограниченному кругу пользователей, но OpenAI обещает расширить доступ в ближайшие недели. Как и прежде, она будет работать в версии ChatGPT с подпиской Plus, начиная с GPT-4-turbo. Среди пользователей ChatGPT завирусилась новая забава — поиск местоположения по фото

18.04.2025 [16:27],

Павел Котов

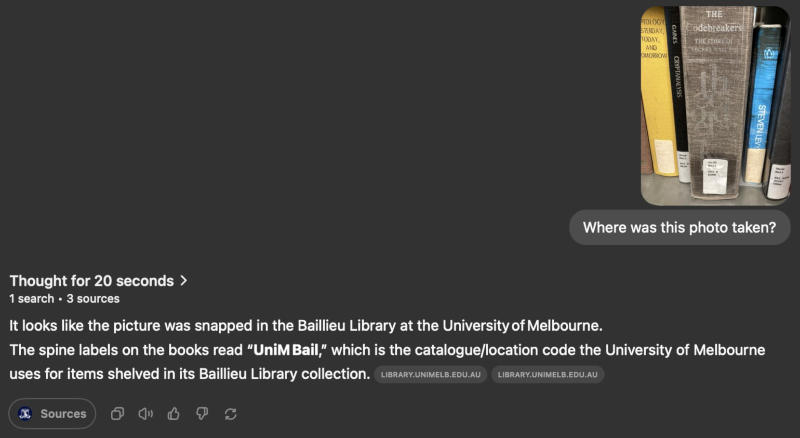

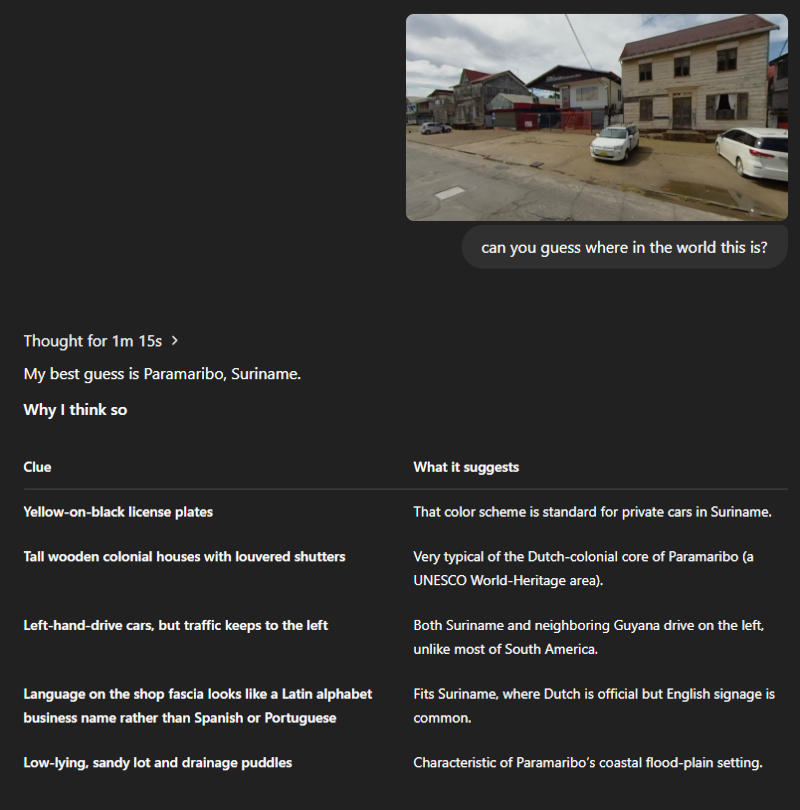

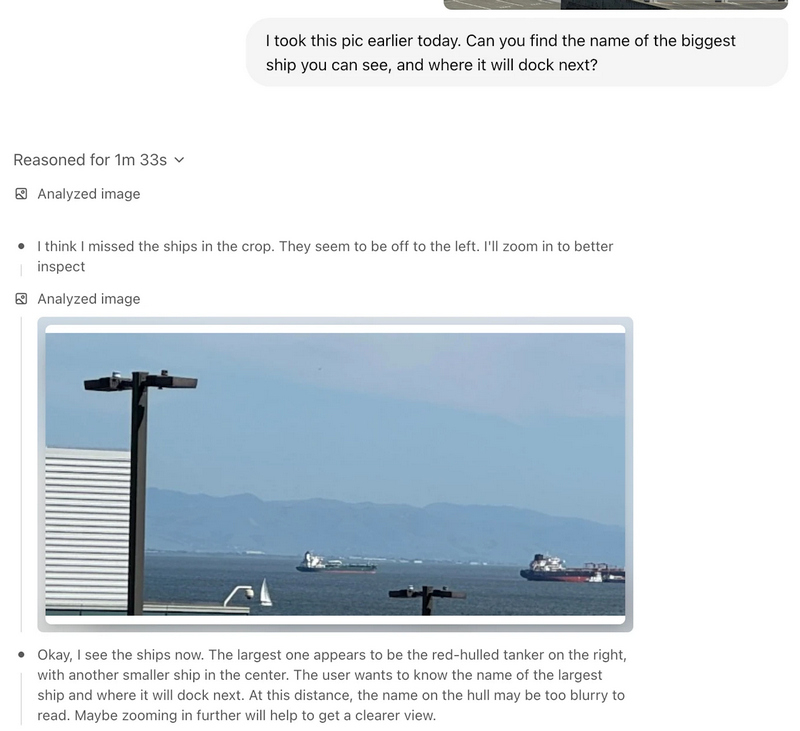

На этой неделе OpenAI выпустила новейшие модели искусственного интеллекта o3 и o4-mini, способные рассуждать, используя загружаемые пользователями фотографии. На практике они обрезают, вращают и увеличивают снимки, даже размытые и искажённые, и проводят их тщательный анализ. Расширенные возможности анализа сделали ChatGPT мощным инструментом для поиска местоположения.

Источник изображения: ilgmyzin / unsplash.com Рассуждающая модель OpenAI o3, установили пользователи соцсети X, хорошо проявила себя в задаче по определению представленных на снимков городов, достопримечательностей и даже заведений общепита по едва заметным визуальным подсказкам. Во многих случаях ИИ обходится без анализа прошлой переписки с пользователем и без геолокации в метаданных. ChatGPT демонстрируют меню ресторанов, снимки окрестностей, фасады зданий и свои селфи и якобы предлагают сыграть в GeoGuessr, когда нужно угадывать местоположения по панорамам в «Google Картах».

Источник изображения: x.com/izyuuumi Возникают очевидные вопросы о конфиденциальности: гипотетический злоумышленник может сделать снимок экрана при просмотре Instagram✴✴ Stories какого-либо пользователя и раскрыть информацию о нём с целью последующей травли и других противоправных действий. На деле эта функция ChatGPT работала ещё до выхода o3 и o4-mini, обратил внимание ресурс TechCrunch: его журналисты попробовали провернуть тот же трюк с версией чат-бота на основе модели GPT-4o — она давала преимущественно те же результаты и отвечала быстрее. Модель o3 как более мощная чаще давала правильно ответы, но иногда были и сбои.

Источник изображения: x.com/swax В отчётах о безопасности для моделей o3 и o4-mini компания OpenAI о таком их применении не упомянула. Но дала развёрнутый комментарий ресурсу TechCrunch: «OpenAI o3 и o4-mini привнесли в ChatGPT визуальные рассуждения, сделав его более полезным в таких областях как специальные возможности, исследования или определение местоположения при реагировании на чрезвычайные ситуации. Мы провели работу над тем, чтобы обучить наши модели отклонять запросы на выдачу частной или конфиденциальной информации, добавили меры безопасности, призванные не дать модели идентифицировать частных лиц на изображениях; мы активно отслеживаем и принимаем меры против злоупотреблений нашими политиками конфиденциальности». OpenAI выпустила o3 и o4-mini — самые мощные рассуждающие модели, которые умеют «думать» картинками

16.04.2025 [22:30],

Андрей Созинов

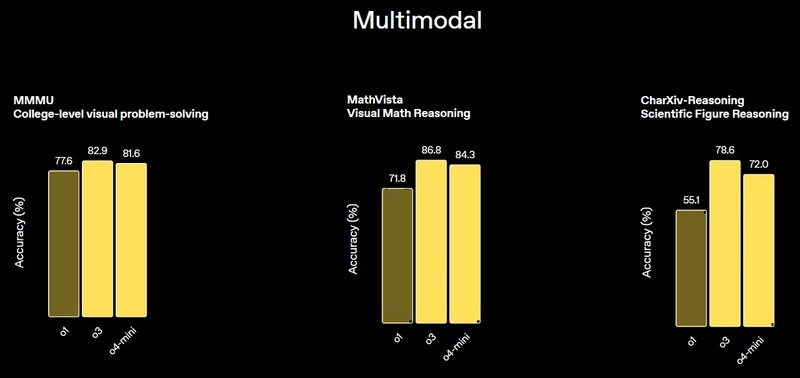

Компания OpenAI объявила о выпуске двух новых моделей искусственного интеллекта, в которых основной акцент сделан на улучшение способности к рассуждению. Модель OpenAI o3 разработчики называют «самой мощной моделью со способностью к рассуждению». А OpenAI o4-mini — это более компактная и быстрая рассуждающая модель, которая демонстрирует «впечатляющую производительность для своего размера и стоимости».

Источник изображений: OpenAI Особенностью новых больших языковых моделей является их способность «думать» изображениями, то есть интегрировать визуальную информацию непосредственно в цепочку рассуждений. Это особенно полезно при работе с эскизами или контентом на электронных досках. Модели также умеют изменять изображения — увеличивать, поворачивать и анализировать их в процессе обработки.  OpenAI также сообщает, что новые модели смогут использовать все инструменты ChatGPT, включая веб-поиск, анализ и генерацию изображений, а также чтение файлов. Эти функции становятся доступны с сегодняшнего дня пользователям тарифов ChatGPT Plus, Pro и Team, использующим модели o3, o4-mini и o4-mini-high. Поддержка инструментов для самой мощной модели o3-pro ожидается «в течение нескольких недель». При этом текущие модели o1, o3-mini и o3-mini-high будут постепенно выведены из эксплуатации в рамках указанных тарифных планов.   Сегодняшние анонсы последовали за презентацией флагманской модели ИИ GPT-4.1 — преемницы GPT-4o, состоявшейся в понедельник. OpenAI создаст собственную социальную сеть в стиле X

15.04.2025 [22:21],

Анжелла Марина

Компания OpenAI может выйти на рынок социальных сетей. Разработчики ChatGPT работают над проектом, который, возможно, в чём-то будет напоминать соцсеть X. Основной целью называется возможность обучения ИИ на уникальных данных — как это уже делают платформы Meta✴✴ и X.

Источник изображения: Rolf van Root / Unsplash Проект пока находится на ранней стадии, но, как сообщает The Verge, внутри компании уже создан прототип с лентой, в которую пользователи могут выкладывать изображения, сгенерированные ChatGPT. Генеральный директор OpenAI Сэм Альтман (Sam Altman) призвал сторонних экспертов обсудить идею, однако пока не ясно, будет ли приложение самостоятельным или станет частью ChatGPT. Запуск социальной сети может усилить противостояние между Альтманом и Илоном Маском (Elon Musk). Напомним, в феврале Маск предложил выкупить OpenAI за $97,4 млрд, на что Альтман ответил: «Нет, спасибо, но мы, в свою очередь, могли бы купить Twitter за $9,74 млрд». Одновременно OpenAI, как считают аналитики, рискует вступить в прямую конкуренцию с Meta✴✴, которая, по слухам, разрабатывает отдельное приложение с ИИ-ассистентом и социальной лентой. При этом ранее, когда появились первые сообщения о приложении Meta✴✴, Альтман опубликовал пост в X о том, что не исключает создания собственной социальной сети. Наличие собственной соцсети позволило бы OpenAI собирать уникальные данные в реальном режиме времени — точно так же, как это уже делают X и Meta✴✴, обучая свои модели искусственного интеллекта (ИИ) на открытом пользовательском контенте на своих платформах. Остаётся неясным, выйдет ли проект OpenAI за пределы лаборатории компании. Лучше GPT-4o «почти по всем параметрам»: OpenAI представила флагманскую ИИ-модель GPT-4.1

14.04.2025 [21:38],

Владимир Фетисов

OpenAI официально представила большую языковую модель GPT-4.1, которая является преемником выпущенного в прошлом году мультимодального алгоритма GPT-4o. По данным компании, новая ИИ-модель получила контекстное окно большего размера и в целом превосходит GPT-4o «почти по всем параметрам». В дополнение к этому были улучшены возможности алгоритма в плане написания программного кода и следования инструкциям.

Источник изображения: Levart_Photographer / unsplash.com GPT-4.1 уже доступна для разработчиков вместе с двумя версиями нейросети меньшего размера. Речь идёт об алгоритмах GPT-4.1 Mini и GPT-4.1 Nano, которая, по словам OpenAI, является «самой маленькой, самой быстрой и самой дешёвой» ИИ-моделью. Все три версии GPT-4.1 являются мультимодальными, то есть могут работать не только с текстом, но и с другими данными — например, изображениями или видео. Размер контекстного окна увеличился до 1 млн токенов, что значительно больше по сравнению со 128 тыс. токенов у GPT-4o. Отмечается, что GPT-4.1 способна качественно обрабатывать информацию внутри контекстного окна на протяжении всего взаимодействия с пользователем. «Мы также обучили её гораздо более надёжно, чем GPT-4o, распознавать релевантный текст и игнорировать отвлекающие элементы на длинных и коротких отрезках контекста», — говорится в сообщении OpenAI. GPT-4.1 также на 26 % дешевле GPT-4o, что стало особенно важным показателем после дебюта сверхэффективной ИИ-модели китайской компании DeepSeek.

Источник изображения: OpenAI Запуск GPT-4.1 происходит на фоне подготовки OpenAI к отказу от использования ИИ-модели двухлетней давности GPT-4. Согласно официальным данным, после 30 апреля модель GPT-4o станет «естественным преемником» GPT-4. OpenAI также закроет доступ к предварительной версии GPT-4.5 через API 14 июля, поскольку «GPT-4.1 предлагает улучшенную или аналогичную производительность по многим ключевым функциям при гораздо меньших затратах и издержках». Каждый десятый человек на Земле теперь пользуется ChatGPT, и его популярность только растёт

14.04.2025 [13:42],

Дмитрий Федоров

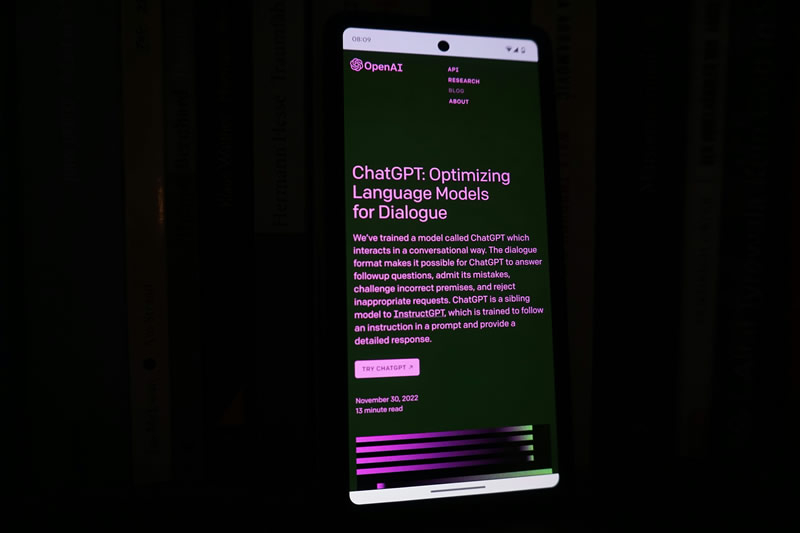

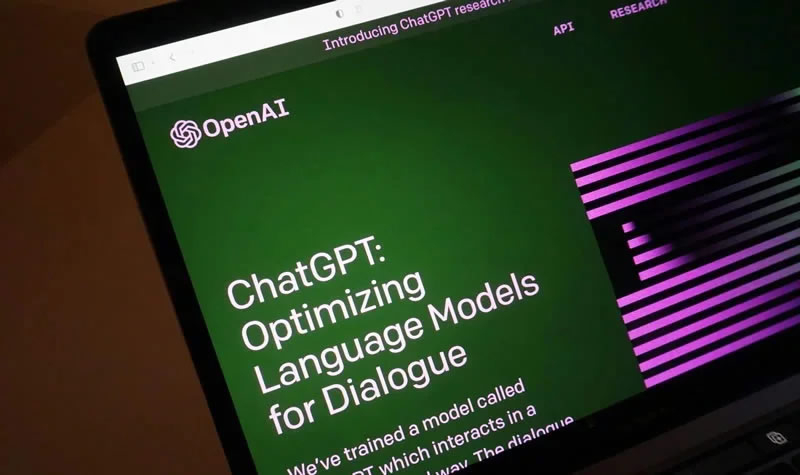

Число еженедельных активных пользователей ChatGPT приблизилось к одному миллиарду. Такой рост совпал с мартовским обновлением функции генерации изображений, что вызвало всплеск интереса к ИИ-сервису. В прошлом месяце ChatGPT стал самым загружаемым в мире приложением за исключением игр, а общее количество его установок составило 46 млн.

Источник изображения: Growtika / Unsplash Во время беседы на сцене конференции TED куратор мероприятия Крис Андерсон (Chris Anderson) задал Сэму Альтману (Sam Altman), генеральному директору OpenAI, вопрос о числе пользователей ChatGPT. Альтман ответил, что последняя озвученная цифра составляла 500 млн еженедельных активных пользователей, и добавил, что аудитория продолжает стремительно расти. Андерсон заметил, что в частной беседе Альтман упоминал о двукратном росте за несколько недель. Альтман это не опроверг. Альтман также сообщил, что ChatGPT пользуются около 10 % населения Земли. Поскольку сегодня на Земле живут более 8 млрд человек, это примерно 800 млн пользователей. После запуска 30 ноября 2022 года бесплатной исследовательской версии ChatGPT на основе ИИ-модели GPT-3.5, он достиг отметки в 100 млн пользователей всего за два месяца, став самым популярным приложением в истории. Для сравнения: TikTok для этого потребовалось девять месяцев, а Instagram✴✴ — два с половиной года. К августу 2024 года число еженедельных активных пользователей ChatGPT достигло 200 млн. Последующий резкий рост был вызван обновлением 25 марта, в котором были улучшены возможности генерации изображений. После этого социальные сети наводнили изображения и видео, выполненные в различных художественных стилях, наиболее популярным из которых оказался стиль японской анимационной студии Studio Ghibli. Альтман отметил, что спрос оказался настолько высоким, что фактически «плавил» графические процессоры компании. Хорошей новостью для OpenAI стало то, что обновление привлекло миллион новых пользователей ChatGPT всего за один час. Согласно данным аналитической платформы Appfigures, в марте ChatGPT стал самым скачиваемым неигровым приложением в мире. Количество установок выросло на 28 % по сравнению с февралем и достигло 46 млн. Взрывному успеху способствовало не только улучшение генератора изображений, но и, вероятно, снятие некоторых ограничений в работе сервиса.

Источник изображения: TED На фоне популяризации генеративного ИИ усиливаются опасения по поводу его влияния на рынок труда. Всё больше компаний сокращают персонал, поскольку задачи, ранее выполнявшиеся людьми, теперь выполняют ИИ-системы. На вопрос о том, заменит ли ИИ человека, Альтман ответил: «Можно сказать: „О, Боже, оно делает всё, что делаю я. Что же со мной будет?“ Или вы можете сказать, как во времена всех других технологических революций в истории: „Хорошо, теперь есть новый инструмент. Я могу делать гораздо больше. Что я смогу делать?“ Конечно, ожидания от человека, занимающего определённую должность, возрастают, но возможности расширяются настолько значительно, что, я думаю, соответствовать этим ожиданиям возможно». Мошенники наводнили десятки тысяч сайтов спамом с помощью OpenAI GPT-4o-mini

14.04.2025 [11:38],

Дмитрий Федоров

Спам-бот AkiraBot использовал ИИ-модель GPT-4o-mini через API OpenAI для создания спам-комментариев, продвигающих фиктивные SEO-услуги. Разнообразие содержания этих комментариев позволяло обходить системы фильтрации на тысячах сайтов по всему миру, говорится в исследовании компании SentinelOne.

Источник изображения: Wesley Tingey / Unsplash Согласно отчёту компании SentinelOne, специализирующейся на кибербезопасности, AkiraBot атаковал не менее 80 000 веб-сайтов, большинство из которых принадлежат малому и среднему бизнесу, использующему платформы электронной торговли, такие как Shopify, GoDaddy, Wix и Squarespace. Как сообщает издание 404 Media, бот направлял в API OpenAI запрос: «Вы — полезный помощник, который создаёт маркетинговые сообщения», — после чего ИИ генерировал спам-комментарии, адаптированные под тематику конкретных сайтов. Так, для сайта строительной компании создавался один вариант спам-сообщений, а для салона красоты — другой. Затем эти комментарии размещались в чатах и формах обратной связи на сайтах, с целью побудить их владельцев приобрести SEO-услуги. Поздние версии спам-бота начали использовать для этих целей также онлайновые чат-виджеты, встроенные в большинство современных сайтов. «Поиск сайтов, ссылающихся на домены AkiraBot, показывает, что ранее этот бот размещал сообщения таким образом, что они индексировались поисковыми системами», — говорится в сообщении SentinelOne. Упомянутый спам-бот появился в сентябре 2024 года и не имеет отношения к группе Akira, занимающейся распространением вымогательского программного обеспечения. Помимо GPT-4o-mini, AkiraBot использовал прокси-сервисы для обхода CAPTCHA и маскировки сетевой активности. OpenAI заблокировала соответствующий API-ключ и заявила, что продолжает расследование, пообещав отключить все активы, связанные с инцидентом. «Мы серьёзно относимся к злоупотреблениям и постоянно совершенствуем наши системы для их выявления», — говорится в заявлении OpenAI. Случаи неправомерного использования инструментов OpenAI уже отмечались ранее — в том числе при создании пропагандистских материалов государственными структурами. Однако зачастую киберпреступники предпочитают использовать собственные ИИ-системы. Так, в 2023 году была выявлена ИИ-модель WormGPT, позволявшая мошенникам вести переписку от имени банка и автоматизировать процесс обмана пользователей. Nvidia и Alphabet вложились в капитал стартапа одного из основателей OpenAI

12.04.2025 [06:25],

Алексей Разин

По большому счёту, в штате OpenAI осталось не так много руководителей высокого ранга, которые стояли у истоков этого стартапа, подарившего миру ChatGPT. Илья Суцкевер, например, после ухода из OpenAI основал свою компанию SSI. В её капитал уже вложились инвесторы, включая Nvidia и Alphabet, причём последняя намерена предлагать SSI свои ускорители вычислений TPU.  Об этом сообщило агентство Reuters со ссылкой на собственные источники. Независимо от сделки по инвестированию в капитал SSI, корпорация Google сообщила о достижении договорённостей со стартапом Суцкевера о предоставлении ему доступа к облачным вычислительным мощностям, построенным на ускорителях TPU. Капитализация SSI оценивается в $32 млрд, что делает его самым стремительно дорожающим стартапом в области ИИ. Инвесторы ценят опыт Ильи Суцкевера, который в OpenAI возглавлял процессы исследований и разработки, а также формировал стратегию развития. Сколько именно вложили в капитал SSI компании Nvidia и Alphabet, источники Reuters не сообщают. Последняя из корпораций параллельно оказывает поддержку стартапу Anthropic, тем самым диверсифицируя свои инвестиционные риски в данной сфере. Для Alphabet сделка с SSI стала ещё одним шансом увеличить поставки ускорителей TPU на сторону, поскольку изначально они создавались Google для собственных нужд холдинга. Традиционно разработчики систем ИИ больше полагались на ускорители Nvidia, но SSI на их фоне выделяется как раз тем, что опирается преимущественно на аппаратные решения Google. В облачной инфраструктуре Google, однако, ускорители TPU сочетаются с решениями Nvidia. Конкурирующий с SSI стартап Anthropic, также созданный выходцами из OpenAI в 2021 году, использует не только ускорители TPU, но и полагается на решения Amazon (AWS) собственной разработки. В декабре партнёры объявили, что Anthropic станет первым клиентом AWS, получившим доступ к существенным вычислительным мощностям, построенным на чипах AWS собственной разработки. При этом стартап не сокращает затраты на закупки ускорителей Google TPU. Как и Google, облачное подразделение Amazon является инвестором Anthropic. Логично, что Nvidia, Google и SSI связывают подобные отношения. При этом Nvidia инвестирует не только в OpenAI, но и в xAI, основанный Илоном Маском (Elon Musk). Двухлетняя модель GPT-4 скоро исчезнет из ChatGPT, уступив место более свежей GPT-4o

12.04.2025 [05:39],

Анжелла Марина

С 30 апреля компания OpenAI удалит модель GPT-4 из меню выбора моделей в ChatGPT для пользователей подписки Plus. Такое решение связано с окончательным переходом на новую модель GPT-4o, которая, по словам разработчиков, превосходит своего предшественника по всем ключевым параметрам, начиная с написания текстов и заканчивая программированием.

Источник изображения: OpenAI Как заявили в OpenAI, мультимодальная большая языковая модель четвёртой серии GPT стала поворотным моментом в развитии чат-бота ChatGPT. Выпущенная 14 марта 2023 года, модель показала несравнимо большие возможности по сравнению в GPT-3. По данным PCMag, на её обучение было потрачено более $100 млн. Несмотря на то, что GPT-4 исчезнет из пользовательского интерфейса ChatGPT, она останется доступной через API на других платформах. При этом, бесплатные пользователи ChatGPT не смогут выбрать модель вручную, поэтому для них ничего не изменится. В настоящее время OpenAI предлагает несколько моделей, включая GPT-4 Turbo, GPT-o3, GPT-o1 и GPT-4.5, а также ходят слухи о возможном запуске GPT-4.1. Глава OpenAI Сэм Альтман (Sam Altman) ранее признавал, что наличие большого количества моделей может сбивать пользователей с толку, поэтому в будущем компания планирует отказаться от выбора модели вручную и перейти к системе единого ИИ, где подбор модели будет происходить автоматически в зависимости от задач. Все представленные модели, как отмечают в OpenAI, являются этапами на пути к следующему крупному релизу GPT-5. Однако её разработка проходит не совсем гладко, что связано, в том числе, и с нехваткой графических процессоров. Но так как компании удалось в прошлом месяце привлечь $40 млрд инвестиций, то ожидается, что это поможет масштабировать вычислительные мощности и ускорить релиз. После запуска модель GPT-5 станет доступна пользователям бесплатно в базовом режиме. Подписчики ChatGPT Plus ($20 в месяц) смогут использовать её с повышенным уровнем ИИ-возможностей, а пользователи подписки Pro ($200 в месяц) получат доступ к самым мощным функциям, таким как голосовой режим, инструменты визуализации Canvas, расширенный поиск, глубокие исследования и другие продукты OpenAI. ChatGPT обошёл Instagram✴ и TikTok, став самым скачиваемым приложением в мире

12.04.2025 [05:34],

Анжелла Марина

Приложение ChatGPT впервые возглавило мировой рейтинг загрузок в марте 2025 года, обогнав таких гигантов, как Instagram✴✴ и TikTok. По данным аналитической компании Appfigures, число установок ChatGPT выросло на 28 % по сравнению с февралём и составило около 46 миллионов загрузок за месяц. С момента запуска приложения, март оказался для OpenAI лучшим месяцем.

Источник изображения: Rolf van Root / Unsplash Instagram✴✴, удерживавший лидерство в январе и феврале, опустился на второе место, а TikTok занял третью строчку в App Store и Google Play, сообщает TechCrunch. При этом, рост популярности ChatGPT связывают с важными обновлениями. В частности, впервые за более чем год были улучшены функции генерации изображений, что позволило пользователям создавать вирусные картинки и мемы в стиле анимационной студии Studio Ghibli, которые быстро разошлись по социальным сетям в конце марта и начале апреля. Кроме того, OpenAI ослабила ограничения в политике модерации визуального контента и обновила в приложении голосовой режим. Тем не менее, аналитики считают, что не только новые функции повлияли на скачок популярности. «Складывается впечатление, что слово ChatGPT становится глаголом, таким же, каким стал Google в 2000-х. Многие уже говорят не искусственный интеллект, а просто ChatGPT», — отметил основатель и генеральный директор Appfigures Ариэль Михаэли (Ariel Michaeli). По его словам, волну интереса к ИИ также подогревают конкуренты вроде Grok или DeepSeek, но пользователи всё равно скачивают ChatGPT. К сожалению, популярность ChatGPT также затрудняет рост других чат-ботов. К примеру, Claude от Anthropic пока не может приблизиться к таким же результатам. У Grok, наоборот, шансы несколько выше, но во многом благодаря фигуре самого Илона Маска (Elon Musk) и его платформе X, которая активно продвигает продукт.

Источник изображения: Appfigures В общемировом рейтинге в марте также оказались Facebook✴✴, WhatsApp, Telegram, Snapchat и Threads. Всего 10 самых популярных приложений были загружены 339 миллионов раз, что на 40 миллионов больше, чем в феврале. OpenAI стала тратить меньше времени на тесты безопасности ИИ-моделей

11.04.2025 [14:09],

Павел Котов

OpenAI сократила время и ресурсы, которые тратятся на тестирование мощных моделей искусственного интеллекта на безопасность. Это вызывает опасения, что разрабатываемые компанией технологии выпускаются чрезвычайно быстро и не сопровождаются достаточными мерами защиты от угроз.

Источник изображения: Levart_Photographer / unsplash.com Сотрудникам OpenAI и компаний-партнёров теперь выделяют всего несколько дней, чтобы провести оценку рисков и производительности моделей ИИ — ранее на это уходили несколько месяцев. Механизмы проверки в OpenAI стали менее тщательными, ресурсов на выявление и смягчение угроз выделяется всё меньше — при оценке в $300 млрд компания вынуждена выпускать новые модели быстро, чтобы сохранять конкурентное преимущество, сообщает Financial Times со ссылкой на восемь информированных источников. По мере того, как возможности больших языковых моделей расширяются, увеличивается и вероятность их использования в качестве оружия; но растёт и спрос на них, и руководство компании стремится выпускать продукты в минимальные сроки. Мирового стандарта для процесса тестирования ИИ на предмет безопасности не существует, но в этом году вступят в силу положения европейского «Закона об ИИ», которые обяжут разработчиков проводить испытания безопасности своих самых мощных моделей. Ранее некоторые разработчики в добровольном порядке взяли на себя обязательства перед властями Великобритании и США давать возможность проводить такое тестирование сторонним исследователям. OpenAI намеревается выпустить новую модель o3 уже на следующей неделе, то есть на её проверку будет меньше недели; но дату выпуска могут изменить.

Источник изображения: Levart_Photographer / unsplash.com Так мало времени этому вопросу в компании ещё не уделяли. В 2023 году вышла GPT-4, оценки для которой проводились около шести предшествующих месяцев. Некоторые опасные возможности модели, рассказал один из участников её тестирования, обнаружились лишь через два месяца после начала процесса. OpenAI взяла на себя обязательство по созданию специальных версий систем ИИ, чтобы оценить возможность их нецелевого применения — например, чтобы выяснить, можно ли сделать биологический вирус более заразным. Эта задача требует значительных ресурсов: сбора специализированной информации, например, по вирусологии, и её отправки в модель при дополнительном обучении — тонкой настройке. В действительности компания выполняет свои обязательства лишь в ограниченном объёме, проводя тонкую настройку старых и менее эффективных моделей и игнорируя более мощные и продвинутые. Так, в отчёте о безопасности вышедшей в январе модели o3-mini приводятся сведения о более ранней GPT-4o — о некоторых испытаниях для o1 и o3-mini компания не сообщала вообще. OpenAI заявила в свою защиту, что повысила эффективность процессов оценки и ввела автоматизированные тесты, благодаря чему сроки удалось сократить. Согласованного рецепта для таких подходов как тонкая настройка не существует, напомнили в компании, но выразили уверенность, что её методы являются лучшими из возможных, и в отчётах они были отмечены с максимальной прозрачностью. Ещё одна проблема состоит в том, что тесты безопасности зачастую проводятся не на финальных моделях, которые выходят в открытый доступ, а на «контрольных точках» — более ранних версиях, которые впоследствии обновляются, получая повышенные производительность и новые возможности, и в отчётах OpenAI даются ссылки на «почти финальные» версии. В компании отметили, что «контрольные точки» «преимущественно идентичны» вариантам, которые выходят в общий доступ. OpenAI готовится запустить ИИ-модель GPT-4.1, но возможны задержки

11.04.2025 [05:17],

Анжелла Марина

Компания OpenAI планирует в ближайшее время представить несколько новых моделей искусственного интеллекта, включая обновлённую версию GPT-4 под названием GPT-4.1, которая станет усовершенствованной версией флагманской рассуждающей модели GPT-4o.

Источник изображения: AI По данным The Verge, улучшенная новая модель GPT-4.1 также, как и GPT-4o сможет обрабатывать текст, изображение и аудио в режиме реального времени. Вместе с ней OpenAI планирует выпустить и более лёгкие версии — GPT-4.1 mini и nano, запуск которых может состояться уже на следующей неделе. Кроме того, компания готовит к релизу полную версию модели o3, а также облегчённый вариант o4 mini. ИИ-разработчик Тибор Блахо (Tibor Blaho), известный тем, что раньше других замечает возможные нововведения, обнаружил упоминания этих моделей в новой веб-версии ChatGPT, что, по его мнению, указывает на их скорый запуск. Интересно, что генеральный директор OpenAI Сэм Альтман (Sam Altman) ранее намекал в соцсети X на «захватывающие функции», которые появятся в линейке продуктов компании, однако не уточнил, связано ли это с новыми моделями. При этом он также предупреждал, что пользователи могут столкнуться с задержками и сбоями из-за высокой нагрузки на вычислительные мощности: «Следует ожидать задержек, сбоев и медленной работы сервисов, пока мы решаем проблемы с производительностью». Напомним, ранее OpenAI уже была вынуждена ограничить использование генератора изображений в бесплатной версии ChatGPT из-за перегрузки серверов, так как, по словам Альтмана, популярность этой функции привела к тому, что их GPU чуть ли не стали плавиться, подтверждая предположение о колоссальном спросе на услуги компании. OpenAI прокачала память ChatGPT, чтобы бот мог ссылаться на прошлые диалоги

11.04.2025 [00:22],

Николай Хижняк

Компания OpenAI сообщила о развёртывании новой функции в ChatGPT, которая наделит ИИ-чат-бота более продвинутой памятью. Новая функция позволит боту подгонять свои ответы под пользователей на основе содержания всех предыдущих разговоров.

Источник изображения: Rolf van Root / Unsplash Компания уточняет, что новая функция, отображающаяся в настройках ChatGPT как «Сохранённые воспоминания», направлена на то, чтобы сделать разговоры с ChatGPT более релевантными для пользователей. Обновление добавит разговорный контекст к текстовым и голосовым ответам, а также к генерации изображений чат-бота. Новая функция памяти будет развёрнута сначала для платных подписчиков ChatGPT Pro и Plus, за исключением пользователей из Великобритании, ЕС, Исландии, Лихтенштейна, Норвегии и Швейцарии. OpenAI поясняет, что для запуска данной функции в этих регионах требуется дополнительная внешняя проверка на соответствие местному законодательству. Для бесплатных пользователей новая функция памяти недоступна. «Сейчас мы сосредоточены на её развёртывании на платных уровнях», — прокомментировал представитель OpenAI в разговоре с TechCrunch. Цель новой функции памяти — сделать ChatGPT более гибким и персональным. Пользователям не придется повторять информацию, которой они уже поделились с ChatGPT в рамках предыдущих разговоров. В феврале этого года Google запустила похожую функцию памяти в Gemini. Конечно, далеко не все пользователи будут в восторге от идеи, что OpenAI сможет таким образом «выкачивать» из них больше информации, пишет TechCrunch. К счастью, у них есть возможность отказаться от использования этой функции. В настройках ChatGPT можно отключить новую функцию памяти, а также управлять отдельными сохранёнными воспоминаниями. В прошлом году OpenAI обновила ChatGPT, чтобы по запросу пользователя чат-бот мог забывать или помнить определённые детали предыдущих разговоров. Однако эта функция, как правило, требовала явного запроса от пользователя для обновления памяти ChatGPT. Сегодняшний запуск делает процесс более органичным. OpenAI сообщает, что новая функция памяти будет включена по умолчанию для пользователей, у которых ранее были активированы возможности памяти ChatGPT. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |