|

Опрос

|

реклама

Быстрый переход

Обзор сервера iRU Rock G2212IG6 на базе Intel Xeon 6

18.02.2026 [00:00],

Илья Коваль

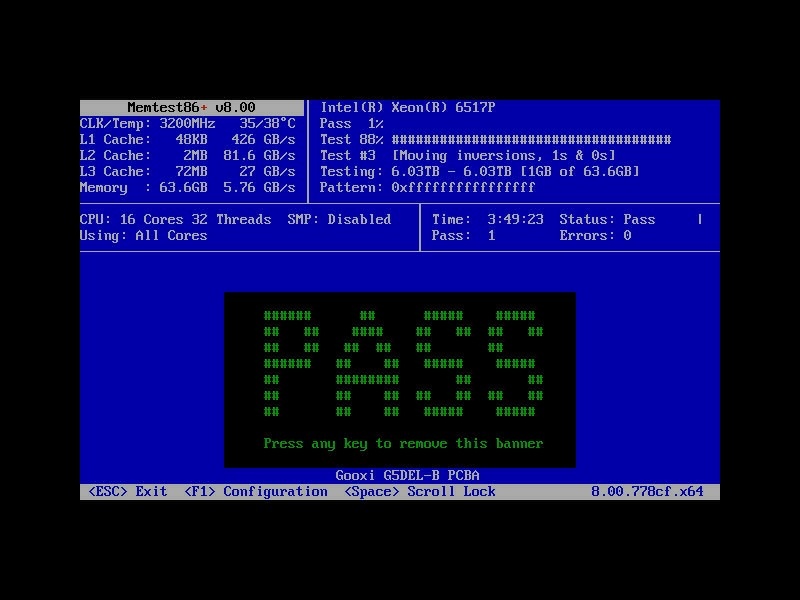

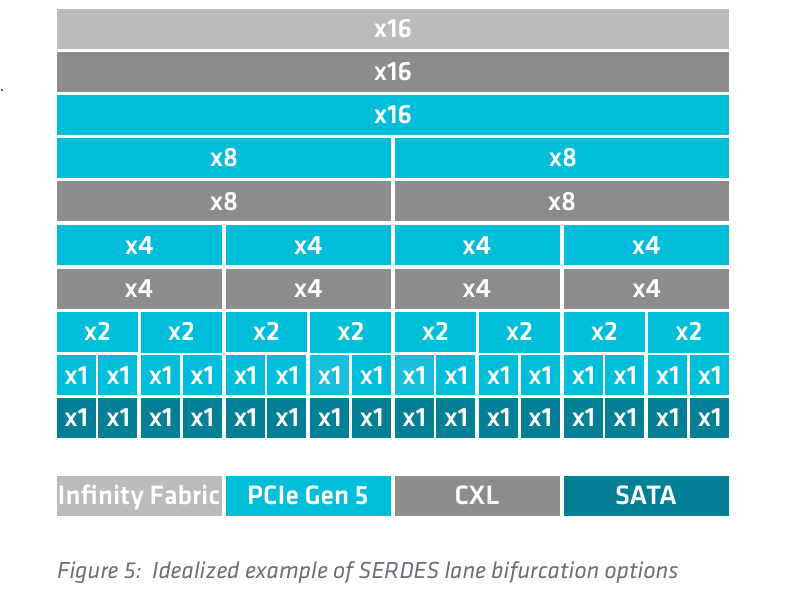

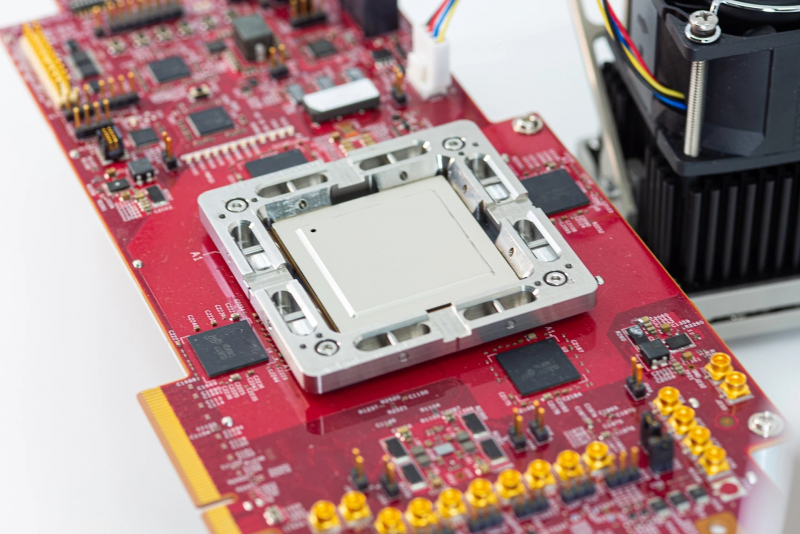

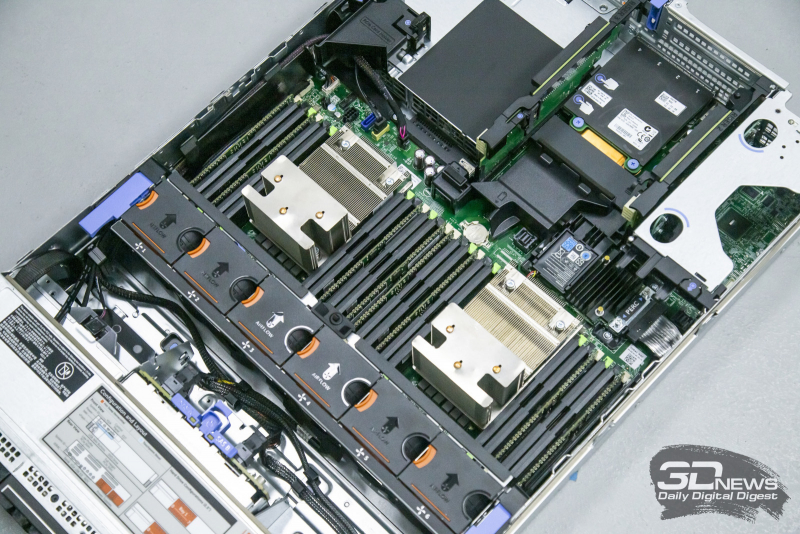

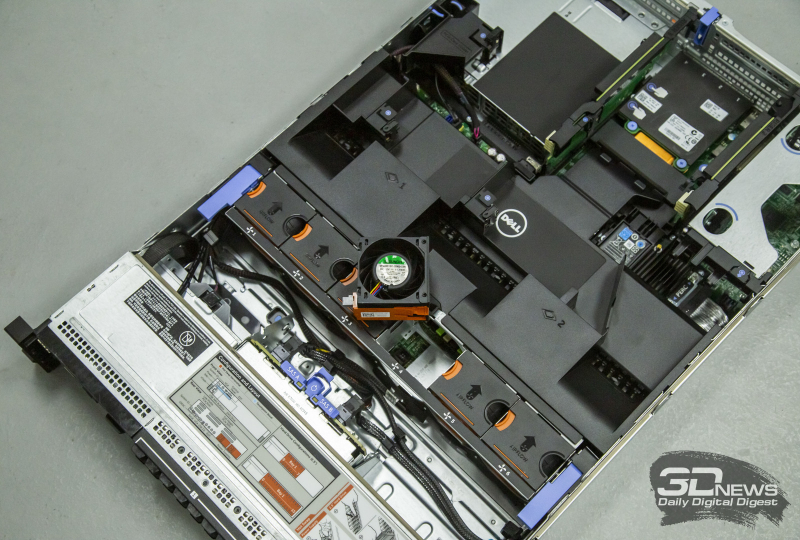

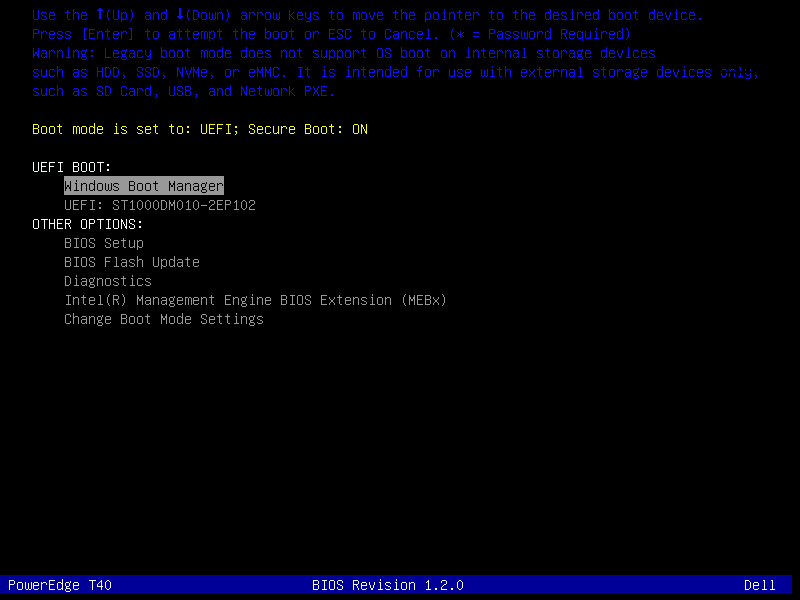

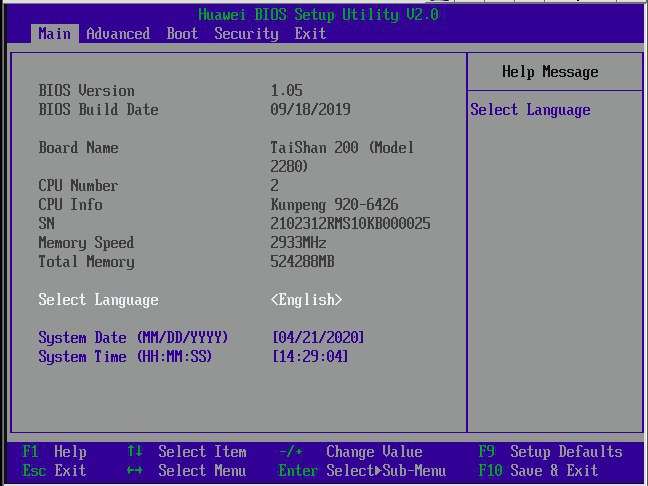

iRU Rock G2212IG6 — это не первая и вряд ли последняя «рабочая лошадка» от российского бренда на базе современных Intel Xeon 6 (Granite Rapids-SP) с TDP до 350 Вт. Чтобы сразу пресечь разговоры об «отечественности», отметим, что это, очевидно, платформа от популярного китайского ODM-вендора, но ничего плохого в этом, собственно говоря, нет. О глубокой локализации речи нет, но поддержка, ремонт и прочее сопровождение от местного игрока нынче дорогого стоит. Кроме того, в этом есть даже плюсы для заказчиков, у которых нет жёстких требований к импортозамещению, — это как минимум более высокая доступность платформы для приобретения, «нормальный» BIOS/UEFI, совместимость с привычными компонентами и т. п. iRU Rock G2212IG6 — машина достаточно универсальная. И процессоры можно поставить помощнее, и под карты расширения слотов PCIe 5.0 хватает, и дисковую корзину при желании можно целиком «набить» NVMe SSD, и слотов под память полный комплект (32 × DDR5-5200/6400, до 8 Тбайт). Вместе с сервером поставляются наборы винтов и стяжек, два кабеля питания, «рельсы» и небольшая бумажная инструкция на русском языке. 2U-шасси имеет габариты 799 × 433 × 87 мм. Верхнюю крышку фиксирует привычный замок-защёлка, но по бокам всё же дополнительно есть пара винтиков. Имеется датчик вскрытия. На правое переднее «ушко» выведены два порта USB 3.0 Type-A и VGA-выход, на левое — кнопки-индикаторы питания и ID, утопленная внутрь кнопка сброса, а также индикаторы, уведомляющие о проблемах с памятью, температурой, сетью и о системной ошибке. Сзади тоже есть пара USB 3.0 и VGA, а также 1GbE-порт RJ45 для BMC ASPEED AST2600 и кнопка UID. Ручки сзади нет, впрочем, компоновка сзади и так довольно плотная. За питание отвечают два (1+1) БП CRPS мощностью до 2600 Вт каждый. Индикаторы работы/состояния у них есть. Над ними есть место для четырёх слотов под низкопрофильные карты, но в данном случае у правого края шасси была установлена корзинка на два SFF-накопителя, причём NVMe (два PCIe 5.0 x4), а райзер для пространства слева от неё не установлен. Два основных x32-райзера имеют либо по три x16-слота PCIe 5.0 (x16 + пара x8), либо по паре x16. Т. е. возможна установка, например, двух двухслотовых ускорителей, благо для них на плате есть два 12VHPWR-разъёма питания. Для сети, конечно, лучше задействовать слоты OCP 3.0. Их тут два: один с подключением PCIe 5.0 x16, второй — x8, но опять-таки через MCIO-коннектор можно получить ещё x8. Вообще на плате есть сразу 14 x8-коннекторов MCIO (суммарно 112 линий), причём восемь из них находятся непосредственно за бэкплейном, и ещё один x4-коннектор для опционального модуля на пару M.2 22110/2280 NVMe SSD. Т. е. вполне можно сделать целиком All-Flash-систему, и на карты расширения ещё останется. С учётом того, что пара 6700P даёт в сумме до 176 линий PCIe 5.0, развернуться есть где, но на все-все хотелки линий может и не хватить. За охлаждение отвечают четыре (N+1) двухроторных вентилятора типоразмера 8056 с поддержкой горячей замены, два «ступенчатых» радиатора CPU с пятью теплотрубками и воздуховод, который как раз отводит часть воздуха на верхние половинки радиаторов. Заявленные условия эксплуатации: t° от +5 до +35 °C с отн. вл. от 20 % до 80 %. В целом внутренняя компоновка и платы, и шасси вообще весьма плотная, но внутренний кабель-менеджмент реализован хорошо. Дополнительно на плате есть порт USB 2.0 Type-A, слот для карты microSD и разъём для VROC-ключа. Основная корзина рассчитана на 12 накопителей LFF. Бэкплейн, помимо NVMe, поддерживает и SAS/SATA-накопители. У лотков имеются индикаторы активности и сбоя. Чисто механически сервер скроен ладно, нет никаких люфтов и прочей неаккуратности. На небольшой тест нам досталась система с парой Xeon 6517P (16C/32T; 3,2/4,2 ГГц; 70 Мбайт L3-кеш; TDP 190 Вт), парой 32-Гбайт регистровых модулей DDR5-5600 Samsung (ну, чем богаты), RAID-контроллером Broadcom MegaRAID 9560-16i 8GB с «батарейкой» CacheVault CVPM05 (а без отдельного RAID/HBA для SAS/SATA-накопителей не обойтись), парой 960-Гбайт SATA-3 SSD Micron 5300 Pro, а также парой БП мощностью 2000 Вт каждый (рейтинг 80 PLUS не указан) и сетевым адаптером LR-Link LREC9222HT (Intel I350). От себя добавили ещё три 1,9-Тбайт SATA SSD Intel D3-S4520 и три 1-Тбайт NVMe SSD Intel DC P4510. Из SATA-накопителей силами контроллера Broadcom были сформированы с настройками по умолчанию массивы RAID1 и RAID5 соответственно. Сформированы непосредственно в BIOS/UEFI — ROM’ы и RAID-контроллера, и сетевых карт загрузились успешно. Из двух NVMe-накопителей посредством VROC был собран RAID0, а ещё один остался сам по себе в задней корзине. BIOS/UEFI тут самый обычный — от AMI — и довольно свежий. Это только в плюс, поскольку теоретически поможет избежать проблем совместимости с оборудованием (давайте признаем, что на рынке массово используются всё-таки зарубежные, а не отечественные компоненты) и повысить стабильность работы сервера в целом. Если бы не одно но: в настройках не нашлось ни следа Secure Boot. Это можно было бы объяснить, например, отсутствием TPM-модуля, но свериться с документацией не выйдет, она в принципе не покрывает все эти настройки. BIOS

В веб-интерфейсе BMC тоже нашёлся кусочек непереведённого с китайского пояснения работы одного из механизмов ограничения энергопотребления. Локализации на русский язык нет, но это дело наживное, да и, пожалуй, не очень-то она и нужна. Функций в BMC очень много, включая, например, 2FA для входа, встроенный брандмауэр, поддержку NVMe-MI, интеграцию с LDAP/AD (а не только с RADIUS), запись видео по триггеру на удалённый раздел NFS/CIFS, монтирование загрузочных образов по NFS/CIFS/HTTPS, лог изменения конфигурации CPU/RAM/БП (когда и что вынули или добавили), поддержка Redfish, возможность управления NIC/RAID (пусть и не всегда полноценную) и т. п. Также присутствует весьма удобный iKVM, опять-таки с возможностью непосредственно в HTML5-версии подмонтировать какой-нибудь мелкий образ, — всё через один порт. Есть и более традиционные Java-клиент, а также поддержка VNC поверх SSH/Stunnel. Из приятных мелочей стоит отметить поддержку тёмной темы оформления веб-интерфейса и удобную навигацию — при открытии очередного подраздела для него создаётся вкладка, чтобы можно было быстро переключаться между ними, а не копаться каждый раз в основном меню. Это всё, конечно, не какие-то эксклюзивные функции, но удобства они добавляют. В целом же для мониторинга, управления и инвентаризации возможностей хватает. Мониторинг BMC

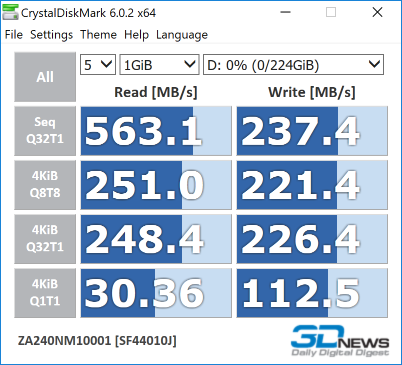

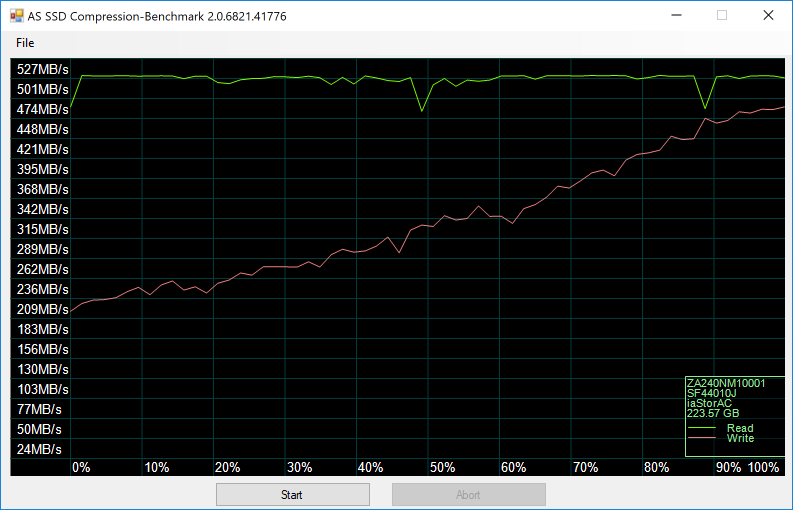

Настройки BMC

ТестированиеДля небольшого теста была установлена Windows Server 2025 (24H2) Standard Edition с десктопным окружением с последующим онлайн-обновлением всего и вся. С драйверами проблем не возникло. Никаких дополнительных настроек сделано не было, кроме двух: профиль высокой производительности в Windows и профиль Max Performance в BIOS. В конце концов, и задачи выжать максимум не стояло, и аппаратная конфигурация не требует каких-то трюков с SNC и т. п.  В SPECworkstation 4.0.0 процессор получил рейтинг 2,00. В Geekbench 6 CPU получил 2041 и 11186 очков в одно- и многопоточных тестах, а в CPU-Z 2.17.0 в бенчмарке 17.01.64 — 668 и 27044 балла соответственно. В PassMark Performance Test 11.1 процессор набрал 70065 очков, а память — 2676. Никаких проблем или отклонений в работе системы во время тестирования замечено не было. В SPECworkstation 4.0.0 SATA-массивы RAID1 и RAD5 получили рейтинг 0,69 и 0,70 соответственно. По результатам CrystalDiskMark хорошо видна работа кеша. Один NVMe SSD получил рейтинг всего лишь 0,35, а пара в RAID0 — и вовсе 0,34. Впрочем, в CrystalDiskMark (набор тестов именно для NVMe, а не по умолчанию) хорошо виден прирост в массиве. Если такой полупрограммный RAID устраивает, то можно докупить ключик для VROC. Выбор именно LFF-корзины можно назвать как компромиссным вариантом, так и универсальным. С одной стороны, вариант 24 × SFF был бы поинтереснее, с другой — 12 × LFF в нынешних условиях, пожалуй, практичнее. ЗаключениеiRU Rock G2212IG6 оказался, пожалуй, типичным представителем своего поколения. Переход к Xeon 6 дал не только повышение производительности собственно CPU-части, но и много линий PCIe 5.0, что позволяет собрать быструю во всех отношениях систему — с производительными CPU, GPU, SSD, RAM и NIC, причём в типовом 2U-формате. И внутри, и снаружи компоновка плотная, но сделанная аккуратно. Функциональность BIOS/UEFI и BMC тоже современная, и, надо полагать, она и далее будет наращиваться. Непосредственно во время тестирования каких-то особенных проблем замечено не было, во всяком случае в аппаратной части, а в ПО пусть есть пара огрехов, но это дело поправимое. Для отечественного заказчика очевидным плюсом является поддержка и сопровождение от отечественного же производителя. iRU осуществляет крупноузловую сборку на территории России из комплектующих мировых производителей, причём возможна кастомизация под конкретные запросы клиентов. На складе поддерживается неснижаемый остаток в несколько десятков серверов, для крупных проектов комплектующие закупаются индивидуально. Склад запчастей для ремонта тоже имеется, а гарантийное обслуживание, включая, например, исправление ошибок в прошивках, осуществляется по всей России. У iRU также есть гарантийные пакеты с выездом к месту эксплуатации для проведения ремонта и реакцией на следующий день (NBD). Не менее очевидным минусом станет дороговизна системы в целом, т.е. сервера в сборе, в чём вины iRU нет. Ситуация на рынке такова, что и оперативная память, и ускорители, и твердотельные накопители, и даже обычные жёсткие диски стремительно дорожают, а доступность их снижается, особенно в России. При этом отдельно платформы не поставляются, поставляются только серверы в сборе. А для тех, кому это важно, компания ведёт тестирование на совместимость с отечественными программными и аппаратными решения, включая, например, модули доверенной загрузки. Соответствующие сертификаты по мере получения будут появляться на официальном сайте. Обзор российской системы инвентаризации «ИТМен»: лучше день потерять, потом за пять минут долететь

05.12.2025 [00:00],

Илья Коваль

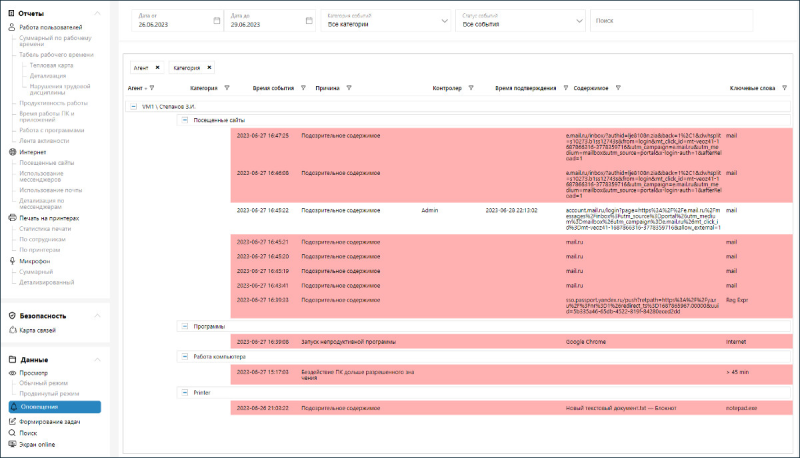

«Инферит ИТМен» (ранее iTman Discovery) — это российская система инвентаризации, учёта и контроля IT-инфраструктуры. Решение агрегирует данные из разных источников, нормализует, идентифицирует, обогащает и типизирует их для создания единого источника достоверных данных обо всех IT‑активах организации с автоматизированным обнаружением новых активов и постоянным контролем изменений. Решение включено в реестр отечественного ПО Минцифры (реестровая запись №12289 от 14.12.2021), соответствует требованиям российских регуляторов и фактически применяется с 2011 г. как в коммерческих, так и в государственных структурах. Разработчики отдельно отмечают, что «ИТМен» не является некой надстройкой над какими-либо open source продуктами, а весь код контролируется исключительно ими. Первое и, наверное, самое главное, что нужно отметить, — это то, что «ИТМен» является в первую очередь поставщиком очищенных и достоверных данных, в том числе по API и через готовые коннекторы, для других систем, например CMDB или ITSM/ITAM/SAM. Да, платформа позволяет быстро составить гибкие отчёты в веб-интерфейсе, чтобы пробежаться по ним глазами и принять какое-то решение (или отложить данные для более глубокого анализа), но не стоит воспринимать её как что-то, что не только заметит аномалии, но и сделает некие выводы и само предпримет упреждающие действия без участия человека. Основная задача платформы — инвентаризация, как можно более гибкая, с возможностью настройки под практически любую инфраструктуру, и масштабируемая до сотен тысяч устройств. По оценкам компании, «ИТМен» позволяет оптимизировать затраты на IT-инфраструктуру до 25 % путём выявления неиспользуемых лицензий, автоматизировать до 70 % ручных операций IT и найти неиспользуемые активы. Конечно, «ИТМен» может уведомить и вышестоящий ИБ-инструментарий о появлении (или исчезновении) в обозреваемых системах ПО или «железа», но сделает она это не мгновенно, а постфактум при выгрузке журналов и отчётов. Более того, в изолированных контурах данные вообще могут переноситься не так уж часто, пересекая «воздушный зазор» на физических носителях, т. е. даже вне прямой области видимости. То же касается и, например, геораспределённых сетей. При этом в любом случае собираемые данные шифруются, в том числе по ГОСТ’у, есть возможность принести собственные сертификаты и, что самое главное, настроить работу с данными в соответствии с внутренними политиками безопасности. Непосредственно сама платформа интегрируется с LDAP, а также позволяет создавать группы и пользователей с различными правами и задавать им парольные политики. В будущих релизах обещана более гранулярная выдача прав. Сбор данныхНепосредственно на устройствах, с которых будут собираться данные, рекомендуется заводить отдельные учётные записи с нужными для работы «ИТМен» правами. Это довольно общая формулировка, и она не случайна. Сбором информации занимаются агенты, которые могут передавать данные сразу в «ИТМен» или же через цепочку агентов-посредников. Цепочки полезны и для соблюдения правил безопасности, и просто для распределения нагрузки — например, нет смысла напрямую «гнать» в центральный офис данные со всех агентов филиала. Агенты работают на Linux и Windows и могут собирать данные как локально на тех машинах, где они запущены, так и по сети, в том числе автоматически выявляя новые устройства (но есть и отдельные облегчённые агенты, где вырезана функция сканирования сети). Это могут быть ПК, серверы, МФУ, коммутаторы, ИБП и т. д. Проще говоря, практически всё что угодно, что имеет хоть какой-то сетевой интерфейс и способ общения с внешним миром. И данные собирать можно тоже практически какие угодно, даже базовый список включает десятки пунктов. Ограничением будет не ваша фантазия, а… политики безопасности! Для дискаверинга и инвентаризации по сети используются протоколы ICMP, ARP, LLDP, SNMP (v1, v2, v3), SSDP, DNS, SSH, WinRM, WMI и IPMI. Для последних четырёх, очевидно, нужно иметь удалённый доступ к хостам. Методы аутентификации поддерживаются самые разнообразные. Агенты «знают» все эти протоколы, а возможность их использования ограничена только поддержкой и доступностью нужного протокола со стороны удалённого хоста. Проще говоря, «ИТМен» изначально поддерживает работу в гибридных окружениях. Первичные данные об устройствах организации можно получить и из Active Directory (а также Samba, FreeIPA и LDAP вообще) или SCCM, а потом регулярно обновлять данные оттуда или же полагаться на сетевой дискаверинг. Но данные можно также собирать посредством SQL-запросов (Microsoft SQL и PostgreSQL) и REST API. Последнее, например, позволяет удобно работать с VMware-хостами. Да-да, «ИТМен» умеет работать и с гипервизорами, и с виртуальными машинами, и с контейнерами. За сбор данных отвечают т.н. сенсоры, исполняемые агентами. Сенсоры — это фактически скрипты: PowerShell, Shell, SQL или внутренний скрипт «ИТМен». В одном сенсоре может содержаться несколько скриптов, например для последовательного сбора (или добора) данных или для выполнения разных скриптов в зависимости от заданных условий (И/ИЛИ). Условиями могут быть, к примеру, (не)успешное (не)выполнение предыдущего скрипта с (не)получением данных от него, тип ОС (Windows/Linux), наличие в собранных данных какого-то конкретного значения поля (атрибута) одного из объектов (активов): устройств, ПО, пользователей. «ИТМен» предлагает динамическую модель данных, так что для собираемой сенсорами информации можно создавать собственные поля различных типов, а не полагаться только на встроенные, которые, впрочем, покрывают самые часто используемые типы собираемых данных. Все найденные и вручную добавленные устройства отображаются в специальном разделе, где их можно сгруппировать вручную или по какому-либо свойству, в том числе «раскидать» их по департаментам или филиалам с формированием вложенных подгрупп. У каждого устройства есть системные и настраиваемые поля, для заполнения некоторых из них нужны справочники. Некоторые поля или атрибуты можно заполнить в процессе обогащения данных, но об этом чуть позже. Для каждого устройства формируется карточка, где приведены все собранные о нём данные. В случае ПК/серверов/ВМ это полная аппаратная конфигурация, логические тома, гостевые ОС, сведения о пользователях и последнем входе, список установленного ПО и т. д. А, например, у принтера это будет «пробег» и объём тонера. Но, как и говорилось выше, собирать можно практически всё, что угодно. Непосредственно процесс инвентаризации заключается в формировании задач с их последующим запуском в соответствии с выставленным приоритетом, вручную или с заданной регулярностью/по расписанию. Для каждой задачи выбираются нужные агенты, у каждого из которых видно наименование устройства, на котором он установлен. Агентам для удобства поиска и выбора можно присвоить теги, в том числе при первичной установке. Затем отбираются сенсоры, которые и предоставят данные. Для этих сведений доступна нормализация по справочнику. Например, Microsoft и Microsoft Corp. будут записаны как просто Microsoft, если в справочнике для этого вендора уже заведены различные варианты написания его имени. Поскольку какие-то получаемые данные могут совпадать у нескольких объектов, например одинаковое имя устройств в разных доменах или в разных сетях, либо, наоборот, одно устройство было обнаружено одновременно, скажем, во время сетевой инвентаризации и при опросе службы каталога, на следующем шаге настраивается идентификация, т. е. такое сочетание нескольких полей, которое будет определять уникальность объекта. Наконец, опционально можно сделать обогащение данных — дополнить информацию об объектах, отфильтровав (больше/меньше/(не)содержит и т. д.) выбранные данные полей с предыдущих этапов, в том числе теги агентов. Таким образом, например, можно назначить тип устройства (ноутбук, десктоп и т. д.), определить его расположение (филиал, департамент и т. д.), доступность (слишком долго было офлайн) и т. п. Но в целом формировать критерии можно какие угодно — добавив поле и настроив обогащение, можно упростить поиск, фильтрацию и составление отчётов. Помимо задач инвентаризации есть особый класс задач отслеживания, которые в течение заданного времени с заданной регулярностью получают данные от выбранных сенсоров. Таким образом, например, можно отслеживать время и частоту использования выбранного ПО, а также тех, кто им пользовался. «ИТМен» ведёт историю задач, так что можно посмотреть, какие и когда были выполнены или засбоили в процессе. Работа с даннымиАктивы — устройства, ПО, пользователи — представлены в одноимённом разделе. Именно сюда после инвентаризации попадают все собранные и обработанные сведения, с которыми можно работать в дальнейшем. Для ПО есть ещё одна крайне полезная функция — нормализация и идентификация данных с помощью каталога ПО, где есть сведения о более чем 315 тыс. приложений и служб. Библиотеку ПО (справочник) можно, конечно, наполнять и вручную, если разнообразие приложений не так велико. Но с готовым каталогом намного удобнее. Вообще работа с ПО в «ИТМен» достаточно продумана. Так, например, установка нескольких языковых версий Microsoft Office засчитывается как одна установка. Также помимо сбора установленного ПО предусмотрена инвентаризация исполняемых файлов на устройствах, позволяющая получать дополнительную информацию (версия, описание и путь к исполняемому файлу). И в целом ведётся учёт количества установок. Отдельно формируется список нераспознанного ПО, о котором нет сведений в библиотеке. Более того, «ИТМен» может отслеживать любое запущенное ПО, так что portable-версии тоже не ускользнут от его ока. Также можно задать списки запрещённого и разрешённого для использования на устройствах ПО. Наконец, для пользователей ведётся учёт, на каких устройствах и когда они входили. Активы можно сгруппировать и отфильтровать по тому или иному параметру. Например, собрать воедино все устройства с Windows или определённого производителя. Для более глубокого и регулярного анализа предназначен раздел «Анализ данных». В нем находится конструктор отчётов, позволяющий создавать необходимые подборки, сохранять их в виде своих отчётов и настраивать регулярную отправку на определённую почту. Раздел «Исторические данные» позволяет отследить изменения в исторических данных в заданные даты. Например, можно составить отчёт об установке/удалении того или иного приложения, а для самих устройств можно отследить изменения того или иного параметра. В специальном отчёте «Использование ПО» можно отслеживать длительность и частоту использования приложений и их уникальных пользователей, что полезно при наличии конкурентных лицензий на ПО (для этого можно даже построить наглядные графики). Отчёты имеют табличный формат с настраиваемым отображением столбцов. Внутри отчётов доступны группировка, фильтрация и сортировка. Для отчётов доступна регулярная отправка на почту. Ещё одна важная функция — журналы проверки для регулярного отслеживания выбранных полей (атрибутов) устройств. Для этого используются наборы правил, где каждое правило проверяет соответствие выбранного поля заданному критерию. Дополнительно задаётся уровень критичности: низкий, средний, высокий. На основе одного или нескольких правил формируются задачи проверки, которые исполняются с заданной регулярностью, а затем отправляют результаты на email. При этом можно настроить их так, что при отсутствии изменений отчёт отправляться лишний раз не будет. Всё отчёты складываются в журналы проверки, где с ними можно ознакомиться и потом. Также есть отдельные задачи оповещения, которые будут отслеживать изменения определённых конфигураций устройств и отправлять уведомления на почту или по REST API. И вот как раз здесь в полную силу проявляется вся гибкость модели данных «ИТМен», потому что можно получать уведомления о практически любых изменениях в активах: появилось нежелательное или неизвестное ПО (например, зловред или запрещённый мессенджер); изменилась конфигурация оборудования (накопитель сломался или был украден); в сети появилось неизвестное ранее устройство (кто-то пронёс личный ноутбук или администратор просто забыл поставить агента на новый ПК) или, наоборот, устройства что-то давно не видно в сети; кто-то слишком долго пользуется каким-либо приложением (хотя в его обязанности это не входит) или зачем-то остановил службу антивируса; на компьютерах в бухгалтерии стало заканчиваться свободное место на накопителях, а на сервере с бэкапами его стало подозрительно много; у МФУ заканчивается тонер, у ИБП низкий заряд, а коммутатора что-то не так с портами и т. д. ЗаключениеЕсли вам на секунду показалось, что «ИТМен» — это довольно сложный продукт, то… нет, вам не показалось. Во всяком случае, на то, чтобы разобраться с ним, придётся потратить время. С другой стороны, освоив хотя бы основные функции, можно донастроить функциональность продукта без обращения к вендору. Базовые коробочные версии для инвентаризации и поставки данных в CMDB обойдутся от 632 руб./год за каждое устройство. В стоимость включены гарантийная техподдержка и обновления в течение года (в среднем пять релизов в год). За возможность модифицировать модель данных придётся доплатить. Каталог ПО, позволяющий не вбивать вручную параметры для выявления и определения ПО и пополняемый вендором не только самостоятельно, но и по запросу от клиентов, распространяется по отдельной подписке. При остановке подписки текущая версия каталога сохранится, но без постоянного обновления смысла в этом немного. Расширенная техподдержка, которая в том числе включает видеоконференцсвязь с экспертом, обучение внутренней команды заказчика, моделирование проблемы на стенде и удалённое подключение к инфраструктуре для отладки проблем стоит от 399 руб./год за каждое устройство. Доработка функциональности возможна по запросу. Для средних и крупных предприятий внедрение будет скорее проектной историей с обращением к интегратору, доработкой под специфические задачи и требования и т. п., а не просто покупкой лицензии, которую при желании можно напрямую приобрести у «Инферит». Впрочем, интегратор может выбрать вариант поставки и лицензий, и сертификата на внедрение. В этом случае внедрением занимается «ИТМен», и это, вероятно, самый лучший вариант для сложных развёртываний, т. к. никто не знает свой продукт лучше, чем сами разработчики. При этом «ИТМен» в целом уже учитывает специфику российского рынка, поддерживая отечественные дистрибутивы Linux, СУБД, готовые коннекторы (SimpleOne, BPMSoft, ITSM box и т. п.) и т. д. Ценность «ИТМен» для IT-служб более чем очевидна, но вот экономический эффект заранее предсказать, скорее всего, будет сложно. Реальная польза будет зависеть не от самого продукта, а от качества его внедрения, корректности использования и поддержки всех сценариев в актуальном состоянии. И это как раз тот случай, когда «лучше день потерять, потом за пять минут долететь». А ещё лучше заказать демонстрацию продукта. Обзор нововведений в ALD Pro 3.0.0: всем каталогам каталог

15.10.2025 [00:00],

Игорь Осколков

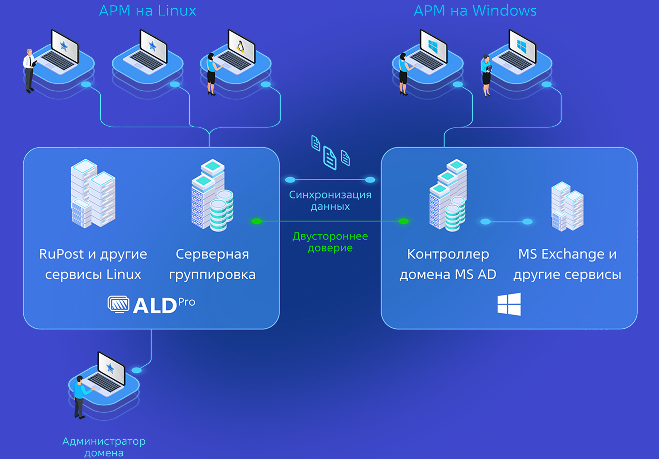

Программный комплекс ALD Pro (Astra Linux Directory Pro), если говорить официальным языком, — это «набор сетевых служб сервера Astra Linux для организации централизованного управления ИТ-инфраструктурой». А если говорить просто, то это отечественный аналог Microsoft Active Directory (MS AD) или Red Hat Identity Management (IdM), в отношении поддержки Linux-систем даже превосходящий их по возможностям. Важным отличием от ряда конкурирующих продуктов является возможность гибридного развёртывания рядом с MS AD, что открывает путь к поэтапной миграции с зарубежных решений — домен ALD Pro может синхронизировать учётные записи пользователей вместе с их паролями и умеет устанавливать доверительные отношения с имеющимся доменом, который в этом случае отвечает за свои собственные службы, а для пользователей обоих доменов обращения к их службам работают совершенно прозрачно. Второе важное отличие от решений конкурентов — это, по словам создателей, принципиально иной подход к выбору компонентов. Если первые чаще всего используют в качестве основы Samba, которая в большей степени ориентирована на управление Windows-компьютерами, то в ALD Pro за основу взята FreeIPA, которая в умелых руках позволяет сформировать полноценный домен для Linux, учитывающий особенности этой системы. Причём с групповыми политиками для настройки окружения пользователей и компьютеров, которые в поставке по умолчанию у FreeIPA отсутствуют. И если раньше разработчиков ALD Pro можно было обвинить в ориентированности только на один конкретный дистрибутив, имя которого прямо указывается в названии продукта, то теперь это не так. С релизом 3.0.0 появилась возможность ввести в домен ПК под управлением ALT Linux 10.4 и 10.2.1 (сертифицированная версия), РЕД ОС 7.3 и 8, а не только защищённой Astra Linux от 1.7.3 до 1.7.7.UU2 или от 1.8.1 до 1.8.1.UU2. Кроме того, ALD Pro совместим с полусотней различных продуктов, включая даже Microsoft Exchange, и этот список постоянно растёт. В основном речь идёт, конечно, об аутентификации с использованием доменных учётных записей посредством Kerberos V5, что само по себе немало. Для контроллеров домена ALD Pro, правда, всё равно требуется Astra Linux 1.7.6.UU2 или 1.7.7.UU2, причём в редакции «Смоленск», т.е. с максимальным уровнем защищённости (для клиентов такого требования нет). А чтобы можно было попробовать базовые возможности, у ALD Pro 3.0.0 впервые появилась бесплатная редакция Free. Её основные ограничения — можно развернуть только один контроллер домена (плюс доверительные отношения с одним доменом MS AD), получить централизованную аутентификацию для 25 пользователей и управлять групповыми политиками для 25 ПК.

Источник изображения: ALD Pro В целом ALD Pro предоставляет централизованное управление учётными записями пользователей и компьютеров, а также управление конфигурациями систем в домене через применение групповых политик. Посредством последних возможна установка и удаление ПО на машинах, а также использование собственных репозиториев. Для пущего удобства реализовано автоматическое развёртывание ОС на машинах в локальной сети с последующим введением в домен и включением функции удалённого доступа даже в редакции Free. Традиционно имеется управление печатью и общим доступом к файлам в сети предприятия. Базовые сетевые службы представлены собственными серверами DNS, DHCP и NTP. Естественно, доступны мониторинг и журналирование, в том числе с выгрузкой данных сторонним системам обеспечения информационной безопасности. Платформа ALD Pro опирается на проверенное open source ПО: FreeIPA, 389 Directory Server, MIT Kerberos, Bind9, ISC DHCP, NTP, SSSD, CUPS, Samba, Zabbix, Syslog-NG, SaltStack, Reprepro, TFTP + PXE. Чисто гипотетически можно было бы попытаться самостоятельно собрать аналог ALD Pro из этих компонентов (что само по себе титанический труд), но полнофункционального решения из этого не выйдет. Во-первых, вендор изрядно доработал и подогнал друг к другу эти компоненты, и то не везде до сих пор всё идеально гладко. Во-вторых, он же создал и проприетарные составляющие, которые просто так уже не скопируешь. В-третьих, ALD Pro предоставляет единый портал управления, а также дополнительные GUI-утилиты: aldpro-join для присоединения компьютеров под Astra Linux к домену с возможностью обновления пароля компьютера и рядом других востребованных функций и aldpro-setfacl для добавления доменных пользователей и групп в списки доступа на файловом сервере. Сам по себе домен ALD Pro использует ролевую модель управления доступом администраторов к тем или иным параметрам или модулями, т.е. областям действия. Для управления каждым типом объектов каталога задаётся отдельный набор привилегий: чтение (Read), создание (Create/Add), изменение (Modify), удаление (Drop/Delete) или же даются полные права Manage. Роли включают набор заданных (из коробки или вручную) привилегий. Таким образом, можно назначать права доступа администраторов с довольно высокой гранулярностью, в том числе на управление объектами конкретных организационных подразделений. Но этим дело не ограничивается. В Astra Linux реализован мандатный контроль доступа с аудитом посредством отдельной службы PARSEC, да ещё и сертифицированный ФСТЭК, ФСБ и Минобороны России, что позволяет добиться максимального уровня защищённости при работе с «чувствительной» информацией. Это касается как самих хостов, где развёрнут ALD Pro, так и клиентских машин и пользователей, для которых необходимые настройки автоматически применяются в рамках групповых политик. Администраторы (и только они, в отличие от традиционного дискреционного доступа, когда права могут раздавать и обычные пользователи — владельцы файлов) задают уровни и категории конфиденциальности (МКЦ/МРД) и назначают допустимые значения конкретным сотрудникам, для которых при входе применяются разрешённые метки. Мандатный контроль распространяется и на зарегистрированные внешние носители, что позволяет предотвратить утечки (а при необходимости и найти виноватых), а отдельный модуль ядра динамически контролирует целостность системных файлов. В ALD Pro теперь есть централизованная регистрация USB-накопителей (а не на каждой машине по отдельности) в службе каталога, чтобы их можно было монтировать на любом хосте в рамках домена. При регистрации можно задать для таких накопителей дискреционные и мандатные права доступа, что позволяет использовать их без риска утечки данных. Или же полностью запретить монтирование неучтённых накопителей. Да, всё это нужно далеко не всем, но для крупных предприятий КИИ будет большим облегчением наличие единых и воспроизводимых политик доступа, ускорение аттестации и аудита, а также упрощение ввода в строй новых пользователей/машин и минимизация шансов появления проблем из-за ошибок конфигурирования. Кроме того, групповыми политиками теперь можно включить и автомонтирование сетевых томов (своего рода аналог DFS-N). Если мандатный контроль доступа работает только с Astra Linux, то для остальных систем есть два более универсальных механизма. Первый — правила для sudo, которые берутся из каталога (а не из локальных файлов конфигурации). ALD Pro позволяет групповыми политиками ограничить список приложений и сервисов, для выполнения которых требуется временное повышение прав, не лишая пользователей нужных им инструментов, но и не позволяя получить все привилегии суперпользователя. Второй механизм — правила HBAC (Host Based Accees Control), разрешающие заданным пользователям использовать определённые службы на конкретных хостах. Службами в данном случае называются любые приложения, которые используют PAM-стек для авторизации пользователей. Это опять-таки позволяет сделать доступ более гранулярным и централизованно управляемым (для групп пользователей и/или хостов) без ущерба повседневной работе. В документации ALD Pro предлагаются типовые шаблоны для обоих механизмов. Разработчики также рекомендуют отключать локальные учётные записи, оставляя доступ только для доменных пользователей. Впрочем, даже для локальных учётных записей предлагаются дополнительные меры безопасности. Так, теперь групповыми политиками можно включить принудительное периодическое обновление паролей локальных администраторов (опционально этот же пароль будет устанавливаться и для GRUB) и ограничить минимально возможные длину и сложность пароля. Этот аналог LAPS позволяет не беспокоиться о том, что уволенные сотрудники сохранят доступ к системам. Кроме того, в новой версии ALD Pro появилась функция проверки новых паролей на отсутствие запрещённых слов (например, наиболее часто используемых и уязвимых сочетаний). В будущем планируется добавить проверку по базам утёкших паролей, хотя это не совсем тривиальная задача с точки зрения производительности, признают разработчики. Но и в текущем релизе создатели поработали над повышением производительности платформы. Были существенно повышены надёжность и скорость модуля синхронизации, незаменимого во время поэтапной миграции пользователей в процессе импортозамещения. Перенос более 10 тыс. учётных записей осуществляется за два часа, при этом у пользователей остаётся непрерывный доступ к системам по логину-паролю вне зависимости от домена, что важно при миграции. Вендор отдельно отмечает, что синхронизация паролей вынесена в отдельный процесс, а журнал событий разделён на три потока: сервисный, операционный и поток синхронизации. По словам производителя, ALD Pro может масштабироваться более чем до 400 контроллеров и 30 млн. объектов. Чтобы работа с действительно крупными доменами была комфортнее, существенно доработан и портал управления, который теперь без задержек справляется с 300+ тыс. пользователей. Наконец, для ALD Pro 3.0.0 был подготовлен модуль «ACM 1.3.0 Инвентаризация», который отвечает за инвентаризацию парка ПК, их оборудования и ПО, лицензий на ОС Astra Linux. Модуль кардинально упрощает управление инфраструктурой, а на крупных предприятиях может быть и вовсе незаменим. Наконец, отдельного внимания заслуживает утилита aldpro-join. Она значительно упрощает ввод нового компьютера под управлением Astra Linux в домен. От администратора требуются только его логин и пароль да имя нужного домена, а всё остальное утилита сделает сама. Не то чтобы без GUI нельзя обойтись, нет, консольная версия не менее прекрасно справляется со своей работой. Однако для новичков в мире Linux, перешедших из экосистемы Microsoft, это полезное подспорье. Компания в целом организовала различные курсы по обучению и переподготовке Windows-специалистов с последующей сертификацией, чтобы людям было проще провести миграцию на отечественный продукт. Кроме того, «Группа Астра» постоянно совершенствует документацию, в том числе справочные материалы, встроенные непосредственно в обновлённый портал управления ALD Pro. Присоединение к домену aldpro-join

Этим список нововведений не ограничивается — разработчики внесли сотни малых и крупных изменений для повышения производительности и масштабируемости, надёжности и устойчивости, безопасности и удобства, совместимости и открытости к интеграции. Всё ли получилось, всё ли идеально? Нет, так не бывает. Но компания опирается на отзывы и опыт работы с продуктом собственных заказчиков, а перед каждым важным релизом формирует небольшие фокус-группы из реальных пользователей, которым даёт предварительный доступ к новой версии. И уже есть понимание, что будет включено в последующие минорные и мажорные обновления. Но уже сейчас ALD Pro решает две важные проблемы — это поэтапная и по возможности максимально безболезненная миграция с Windows и поддержка действительно крупномасштабных проектов развёртываний с соблюдением всех требований к инфраструктурам КИИ. Мало кто таким сейчас может похвастаться. Intel Xeon 6+ Clearwater Forest: большой плюс для маленьких ядер

13.10.2025 [17:00],

Владимир Мироненко

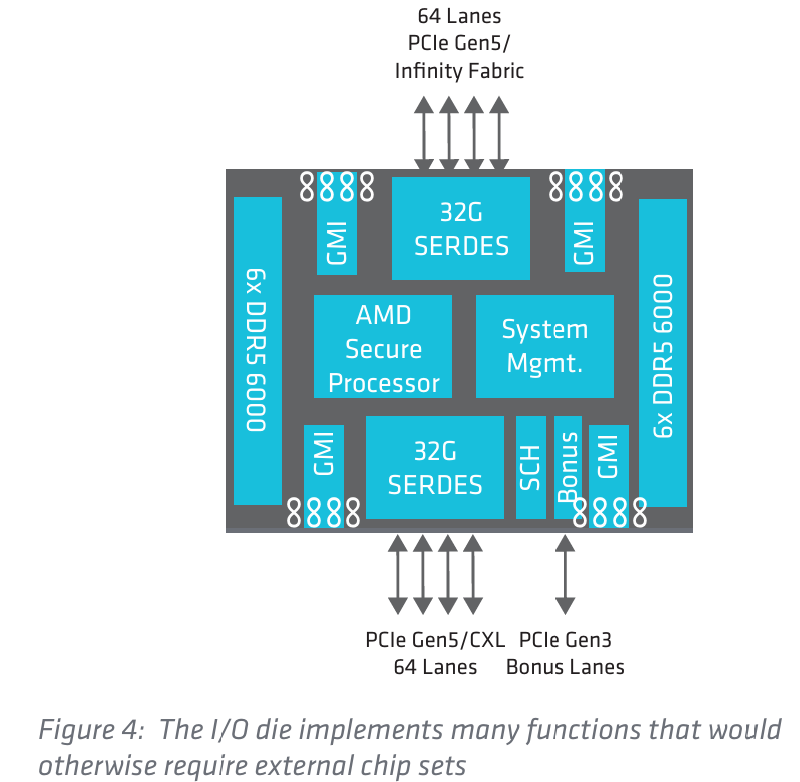

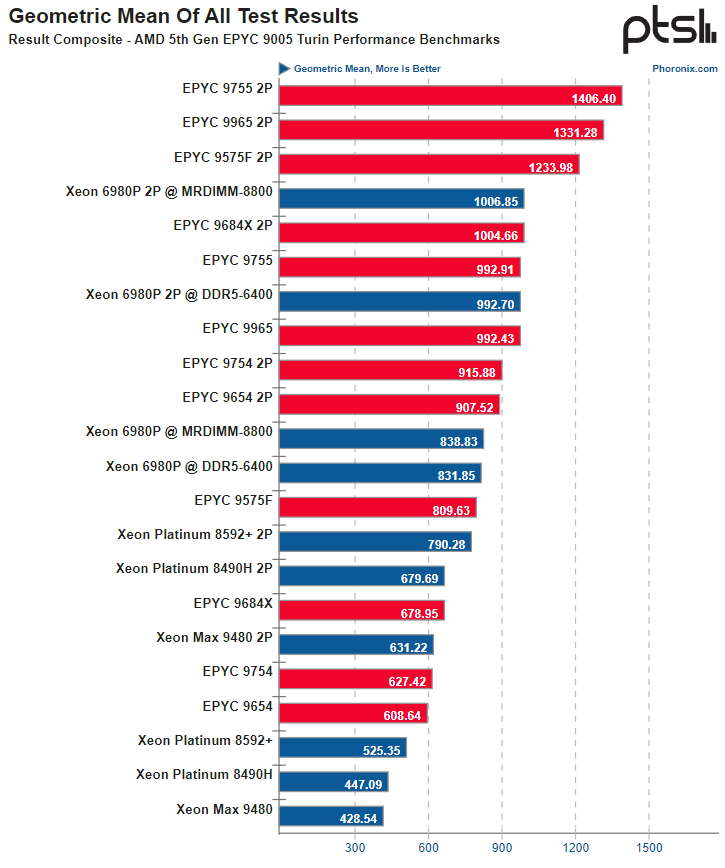

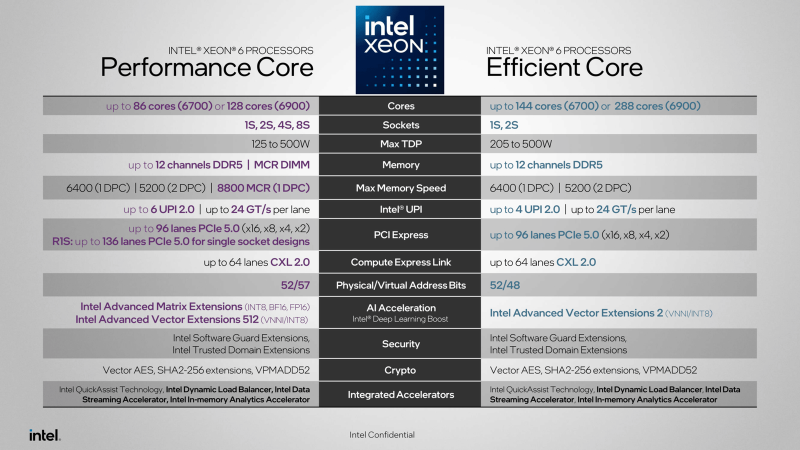

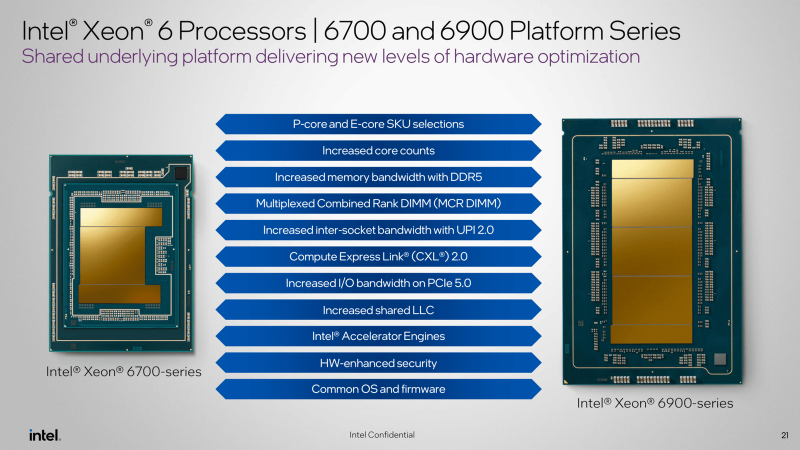

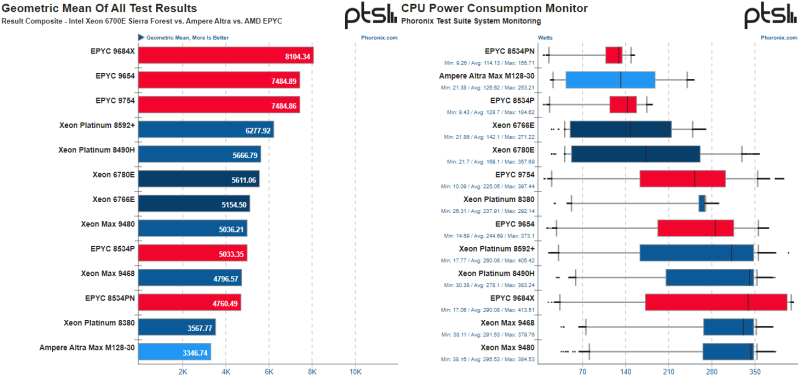

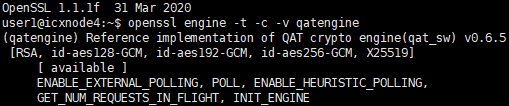

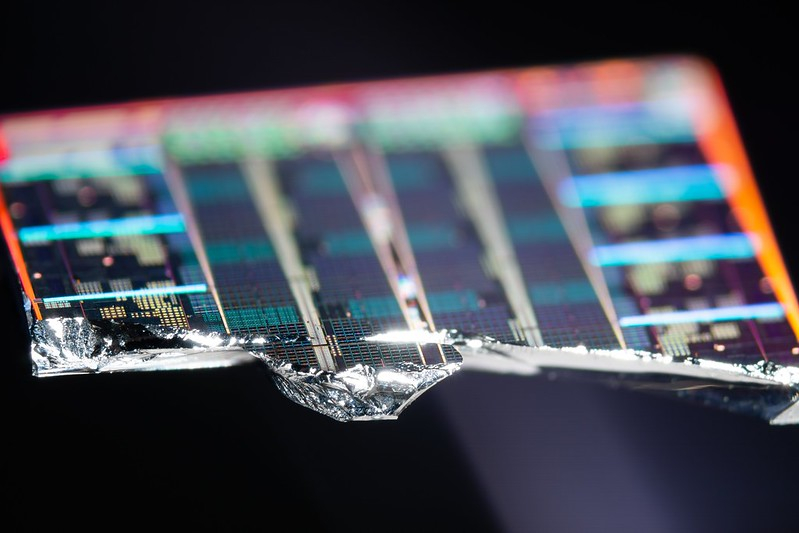

На прошлой неделе Intel представила первые процессоры семейства Xeon 6+, изготовленные по передовому техпроцессу 18A — Clearwater Forest (CWF), выпуск которых был отложен практически на год. Ожидание того стоило, поскольку компания вывела свою тайловую архитектуру и возможности упаковки на новый уровень. Clearwater Forest включает 12 EMIB-чиплетов (2.5D-упаковка), объединяющих 3 базовых тайла (Active Base, Intel 3) с 2 IO-чиплетами I/O (Intel 7) и 12 вычислительными тайламм с E-ядрами Core (Intel 18A с RibbonFET и PowerVia). Это один из первых чипов, который производится по техпроцессу 18A, обеспечивающему, по словам компании, наилучшую энергоэффективность для основной логики благодаря меньшей ёмкости затвора, а также более высокую плотность ячеек, улучшенную маршрутизацию сигналов и шины питания на задней стороне. Технология 18A также снижает потери питания на 4–5 %. При общем повышении производительности компании удалось остаться в рамках прежнего диапазона TDP от 300 до 500 Вт. Ещё одна особенность Clearwater Forest — Intel AET (Application Energy Telemetry) — новая технология телеметрии энергопотребления приложений, нагрузок и ВМ. В отличие от интерфейса Intel Running Average Power Limit (RAPL), обеспечивающего мониторинг энергопотребления CPU, а также в некоторых сценариях DRAM и интегрированных GPU, с отражением расхода энергии в целом, новая функция позволяет контролировать энергопотребления по каждому приложению. Эта функция помогает разработчикам/администраторам профилировать и масштабировать рабочие нагрузки на процессорах с большим количеством ядер. Также реализована поддержка технологии Intel Turbo Rate Limiter. Clearlwater Forest-AP также является первым процессором массового производства, использующим технологию Foveros Direct3D — это передовое решение для корпусирования, которое объединяет вычислительные и IO-тайлы на базовых тайлах. Foveros Direct 3D имеет расстояние между контактами 9 мкм и использует вертикальное соединение Cu–Cu. Технология реализована в виде активного кремниевого интерпозера с высокой плотностью и низким сопротивлением, обеспечивая производительность ~0,05 пДж/бит. Проще говоря, на передачу данных между тайлами расходуется минимум энергии. I/O-тайл позаимствован у Granite Rapids-AP (6900P). Он содержит восемь блоков ускорителей Intel Quick Assist (QAT), Intel Dynamic Load Balancer (DLB), Intel Data Streaming Accelerator (DSA) и Intel In-Memory Analytics Accelerator (IAA) — суммарно до четырёх ускорителей каждого типа на CPU. I/O-тайл также имеет 48 линий PCIe 5.0 (всего 96 на процессор), 32 линии CXL 2.0 (всего 64) и 96 линий UPI 2.0 (всего 192). Всего доступно шесть UPI-подключений (по 24 ГТ/с), который в 2S-конфигурации дают 576 Гбайт/с между CPU. Базовый тайл оснащён четырьмя контроллерами памяти DDR5-8000 (без поддержки MRDIMM), что в сумме обеспечивает 12 каналов памяти на процессор. Тайл также подключён к общему L3-кешу с 48 Мбайт на вычислительный блок или 192 Мбайт на базовый тайл. Суммарно это даёт 576 Мбайт общего L3-кеша на чип. Формально это существенный прогресс в сравнении с Sierra Forest-AP (6900E), но эти чипы массовыми так и не стали. Вычислительный тайл состоит из шести модулей, по четыре E-ядра Darkmont в каждом (по-прежнему без SMT/HT) — 24 ядра на тайл или 288 ядер на 12 тайлов в составе процессора. Один модуль содержит 4 Мбайт общего L2-кеша, т.е. 24 Мбайт L2-кеша на тайл и 288 Мбайт L2-кеша на процессор. Clearwater Forest используют тот же сокет LGA 7529, что и Xeon 6900P (Granite Rapids-AP) и Xeon 6900E (Sierra Forest-AP). Ожидается и появление более компактных 144-ядерных Clearwater Forest-SP. E-ядра Darkmont — это более «широкая» и быстрая версия предыдущей архитектуры Skymont, использовавшейся в десктопных CPU. По сравнению с Crestmont в Sierra Forest она представляет собой значительное обновление. В Darkmont реализовано девятипоточное декодирование — вместо шестипоточного в Crestmont — с помощью трёх трёхпоточных декодеров и возможность аллокации до 8 инструкций за раз. Ёмкость очереди микроопераций выросла с 64 до 96 записей, а буфера переупорядочивания с 256 до 416 записей. Также имеется увеличенный кеш инструкций объёмом 64 Кбайт, и более точный улучшенный механизм предсказаний ветвлений. При этом работа с L2-кешем ускорена вдвое, до 128 байт/такт, а передача данных между L1-кешами теперь происходит быстрее и более предсказуемо (через L2). Кроме того, усовершенствована предвыборка на всех уровнях кеша. В планировщик можно отдавать 8 инструкций за такт (+60 % по сравнению с предыдущим поколением) и завершать исполнение до 16 операций за такт (вдвое больше). Количество портов исполнения увеличено с 17 до 26. Скалярный движок (Scalar Engine) получил 8 целочисленных вычислительных блока (было 4), 3 блока генерации адресов загрузки и 4 блока генерации адресов сохранения (было 2), а также поддержку подсистемой памяти трёх загрузок и двух сохранений за раз. Векторный движок (Vector Engine) получил 4 блока vector/float store, 2 vector/float и 4 стека vector/float — можно работать с четырьмя 128-байт FMA-операциями, а не двумя. Заявлена поддержка AVX2 с VNNI и INT8. В целом, Darkmont E-Core в платформе Clearwater Forest обеспечивают производительность до 90 % выше, чем 144-ядерный процессор Xeon 6780E (Sierra Forest-SP), а также повышение эффективности на 23 % по всем вариантам нагрузок. Сравнение не вполне корректное, учитывая разницу в количестве ядер. По сравнению с Cascade Lake-SP новая архитектура обеспечивает консолидацию серверов до 8:1 с более низкой совокупной стоимостью владения. Функции безопасности будут включать Intel Software Guard Extensions (SGX) и Intel Trust Domain Extensions (TDX). Архитектура NVIDIA Blackwell Ultra: NVFP4 есть, а FP64 — нет

26.08.2025 [09:19],

Владимир Мироненко

NVIDIA поделилась подробностями об ускорителе Blackwell Ultra, обновлённом и улучшенном варианте NVIDIA Blackwell, представленном более года назад. Blackwell Ultra по-прежнему состоит из двух кристаллов с максимальными размерами в пределах фотолитографической маски, соединённых с помощью интерфейса NVIDIA High-Bandwidth Interface (NV-HBI) с пропускной способностью 10 Тбайт/с. Чип имеет 208 млрд транзисторов, изготовленных по кастомному техпроцессу TSMC 4NP — в 2,6 раза больше, чем NVIDIA Hopper — и с точки зрения ПО выглядит как один ускоритель. Чип имеет 160 потоковых мультипроцессоров (SM), включающих 640 тензорных ядер (Tensor Core) пятого поколения общей с производительностью 15 Пфлопс в вычислениях в фирменном 4-бит формате NVFP4 (без разреженности) и общий L2-кеш с полностью когерентным доступом к памяти. SM объединены в восемь кластеров GPC (Graphics Processing Clusters). Каждый SM представляет собой автономный вычислительный блок, содержащий:

Когда NVIDIA впервые представила тензорные ядра в архитектуре Volta, они фундаментально изменили возможности ускорителей для глубокого обучения, расширяя с каждым новым поколением свои возможности, точность и параллелизм, говорит NVIDIA. Blackwell (Ultra) выводят эту технологию на новый уровень благодаря тензорным ядрам пятого поколения и Transformer Engine второго поколения, обеспечивая более высокую пропускную способность и меньшую задержку как для обычных, так и для разреженных ИИ-вычислений. Новые тензорные ядра тесно интегрированы с 256 Кбайт тензорной памяти (TMEM), оптимизированной для хранения данных близко к вычислительным блокам. Они также поддерживают двухпотоковые блочные MMA-операции, где парные SM взаимодействуют в одной операции MMA, деля операнды и сокращая избыточный трафик памяти. Результатом является более высокая стабильная пропускная способность, более высокая эффективность использования памяти, более быстрое обучение и более эффективный инференс с малыми пакетами данных и высокой интерактивностью. Не менее важным для производительности стало внедрение NVIDIA NVFP4, нового 4-бит формата с плавающей запятой, который сочетает микроблочное масштабирование FP8 (E4M3), применяемое к блокам по 16 значений, и масштабирование FP32 на тензорном уровне, что обеспечивает аппаратное ускорение квантования с заметно более низким уровнем ошибок, чем стандартный FP4. При этом точность практически такая же как FP8 (часто с разницей менее ~1 %), но потребление памяти снижается в 1,8 раза (и до ~3,5 раза по сравнению с FP16). При этом от развития FP64 компания практически отказалась. NVFP4 обеспечивает оптимальный баланс точности, эффективности и производительности для ИИ-инференса, заявляет NVIDIA. «Плотные» NVFP4-вычисления в Blackwell Ultra обеспечивают существенный прирост производительности по сравнению с оригинальным ускорителем Blackwell — с 10 Пфлопс до 15 Пфлопс в NVFP4, то есть в 1,5 раза, или в 7,5 раза по сравнению с NVIDIA Hopper. Это ускорение напрямую влияет на масштаб инференса, обеспечивая большее количество параллельных экземпляров моделей, более быстрое время отклика и снижение затрат на каждый сгенерированный токен. В Blackwell Ultra пропускная способность SFU для ключевых инструкций, используемых в слое внимания (attention layer), удвоена, что обеспечивает до двух раз более быстрые вычисления по сравнению с оригинальными Blackwell. Это улучшение ускоряет внимание как на коротких, так и на длинных последовательностях, но особенно эффективно для рассуждающих моделей с большими контекстными окнами, где softmax-этап, когда определяется наиболее вероятный токен для дальнейшего решения задачи, может стать узким местом по задержке. Таким образом, ускорение работы механизма внимания в Blackwell Ultra уменьшает время до выдачи первого токена в интерактивных приложениях, cнижает вычислительные затраты за счёт сокращения общего количества циклов обработки на запрос и повышает энергоэффективность — больше последовательностей на Вт. В сочетании с NVFP4 новые ускорители позволяют добиться повышения качества многоступенчатых рассуждений и многомодального инференса. Blackwell Ultra получили и улучшенную подсистему памяти — 288 Гбайт HBM3e, наполовину больше, чем в Blackwell (192 Гбайт). Всего используются восемь HBM-стеков и 16 × 512-бит контроллеров (общая разрядность 8192 бит). Пропускная способность осталась прежней — 8 Тбайт/с. Столь большой объём быстрой памяти позволяет целиком разместить в ней крупные модели (300+ млрд параметров), реже обращаться к системной памяти или накопителям, увеличить длину контекста и размер KV-кеша. С точки зрения внешних коммуникаций изменений мало. Blackwell Ultra всё так же полагается в первую очередь на интерконнект NVLink 5 с пропускной способностью 1,8 Тбайт/с (по 900 Гбайт/в каждую сторонц) и возможностью объединения в рамках одного домена до 576 GPU в неблокируемой вычислительной фабрике. Хост-интерфейсы представлены PCIe 6.0 x16 (по 128 Гбайт/с в каждом направлении) и NVLink-C2C с когерентностью памяти (900 Гбайт/с). Blackwell Ultra позволяет создавать более крупные модели, чем Blackwell, и повышать пропускную способность без ущерба для эффективности. Ускоренное выполнение softmax дополнительно повышает скорость реального инференса, увеличивая количество токенов в секунду на пользователя (TPS/пользователь) и одновременно улучшая количество токенов в секунду на МВт (TPS/МВт) в ЦОД. Архитектурные инновации улучшают экономичность ИИ-инференса и переосмысливают возможности проектирования ИИ-фабрик, обеспечивая больше экземпляров моделей, более быстрые отклики и более высокую производительность на 1 МВт по сравнению с любой предыдущей платформой NVIDIA, говорит компания. Суперчип NVIDIA Grace Blackwell Ultra объединяет один Arm-процессор Grace с двумя ускорителями Blackwell Ultra через NVLink‑C2C, обеспечивая NVFP4-производительность c разреженностью до 40 Пфлопс (до 30 Пфлопс без разреженности), а также унифицированную память объёмом 1 Тбайт, сочетающую HBM3E и LPDDR5X. Сетевые адаптеры ConnectX-8 SuperNIC обеспечивают высокоскоростное 800G-подключение. Суперчип NVIDIA Grace Blackwell Ultra является базовым вычислительным компонентом стоечной системы GB300 NVL72, которая объединяет посредством NVLink 5 сразу 36 суперчипов Grace Blackwell (1,1 Эфлопс в FP4 без разреженности). Системы GB300 также выводят управление питанием на новый уровень. Они используют конфигурации с несколькими полками питания для обслуживания и сглаживания синхронных изменений нагрузки ускорителей. Как отметила компания, NVIDIA Blackwell Ultra закладывает основу для создания ИИ-фабрик, позволяя обучать и развёртывать интеллектуальные системы с беспрецедентной масштабируемостью и эффективностью. Благодаря революционным инновациям в области интеграции двух кристаллов, ускорению NVFP4, огромному объёму памяти и передовой технологии интерконнекта, Blackwell Ultra позволяет создавать ИИ-приложения, которые ранее было невозможно создать с вычислительной точки зрения. Curator — и пусть DDoS подождёт

21.08.2025 [00:00],

Игорь Осколков

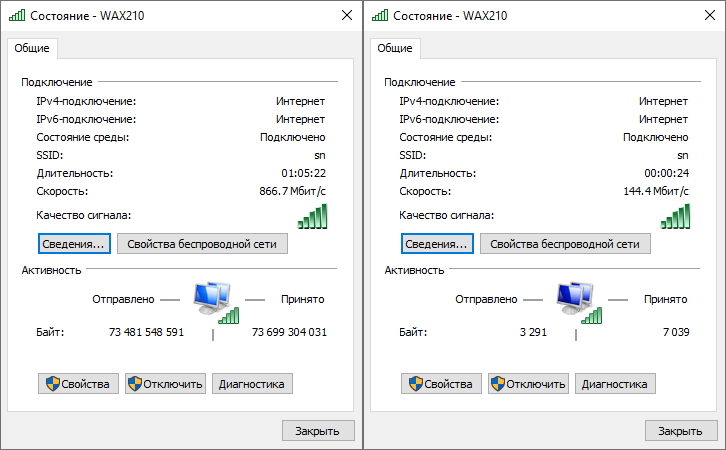

Шумные соседиDDoS-атаки, к сожалению, стали обыденностью и, кажется, теперь касаются компаний из практически любых отраслей. Не то чтобы их раньше не было — конечно, были, но за последние годы изменились и частота, и характер, и смысл, а скорее даже бессмысленность таких атак. Например, на нас формально самая крупная из последних, но отнюдь не самая неприятная атака — флуд на 10 Гбит/с — была совершена в конце 2021 года. Её отфильтровал хостинг-провайдер, опцию базовой защиты от L3/L4-атак предоставляют практически все хостеры. Однако здесь обычно есть несколько проблем. Во-первых, это «шумные соседи» и политика справедливого использования даже для базового безлимитного подключения. Внешний канал, как правило, общий для всех или как минимум для группы клиентов, поэтому атака на одного из них может повлиять на остальных. А в случае действительно серьёзной угрозы такого клиента попросту отключают от сети. Забегая вперёд, скажем, что именно это с нами случилось. Во-вторых, если покупать у хостера защиту отдельно, то ценник может неприятно удивить. Особенно в случае разовых атак, когда приходится платить за очистку трафика потерабайтно. Кроме того, при совсем уж неудачном стечении обстоятельств могут попросить дополнительные деньги и за волну трафика. Масштаб проблем зависит от тарифов хостинга, особенностей атаки и вашей архитектуры. Наконец, в-третьих, базовая защита от хостера обычно не предусматривает никакого особенного контроля и нормального мониторинга, она нередко работает в одностороннем и уведомительном порядке. А уж хоть какую-то защиту от L7 вообще почти никто не предлагает, только в рамках отдельной услуги, которая, скорее всего, является просто перепродажей чьего-то сервиса. Очевидным решением всех этих проблем является уход непосредственно к специализированному поставщику услуг. Одним из наиболее популярных сервисов является CloudFlare, который за скромные деньги предлагает защиту от DDoS, CDN, WAF и кучу других возможностей. Правда, здесь тоже есть нюансы. Во-первых, далеко не все сервисы нужны каждому, некоторые приятно иметь, но обязательными они не являются. Более того, действительно нужные опции могут оказаться платными и вовсе не безлимитными. Во-вторых, CloudFlare печально известен выставлением астрономических счетов, если посчитает, что вы перебрали с использованием услуг. Ну и в-третьих, с постепенным запретом CloudFlare на территории РФ смысл в нём теряется. Хотя, стоит признать, в целом с CloudFlare работать комфортно. Даже первичная настройка путём переноса DNS-зоны очень проста. ПереездНесмотря на то, что наиболее болезненными являются L7-атаки, количество которых с 2022 года существенно возросло, от классического флуда никто не отказывается. Именно с этим нам и пришлось столкнуться. Если ранее хостинг-провайдер достаточно успешно отбивал такие атаки, то этой зимой его сил не хватило. В один не очень прекрасный выходной день на нас началась атака, которая в пике достигла 2996 Мбит/с и 307405 pps. Менее чем через полчаса хостер справедливо решил, что дальше это терпеть не намерен, и отключил нам сеть. К счастью, атака оказалась не слишком изощрённой, так что переезд на другие IP-адреса временно решил проблему. Длительность атаки установить не удалось, но несколько пробных включений в течение нескольких последующих часов показали, что она продолжалась. Продолжилась она и на следующие сутки. Очевидно, что от перехода под защиту специализированного провайдера отказываться уже никак нельзя. Curator (ранее известный как Qrator Labs) — один из старейших поставщиков таких услуг на рынке. И если раньше казалось, что они нужны только каким-то очень крупным или лакомым для злоумышленников заказчикам, то теперь стало понятно, что пострадать может любая компания, даже такая маленькая и скромная, как наша. Собственно процесс переезда не так уж сложен. Curator присылает довольно подробное письмо с простыми пошаговыми инструкциями для первичной настройки. В нашем случае это несколько веб-сайтов, т. е. Curator выступает в качестве реверс-прокси до наших серверов (апстримов), так что всё свелось к замене A-записей для нужных доменов, созданию сертификатов Let’s Encrypt на стороне Curator с автоматическим обновлением их в последующем и добавлению апстримов, т. е. подключений к нашим собственным серверам (в том числе с TLS и по HTTP/2). Тут же можно настроить вид страниц, которые будут отдаваться Curator при ошибках 502/503/504. Также в приветственном письме рекомендуется перенести апстримы на новые IP, желательно из другой подсети, и заблокировать к ним доступ отовсюду, кроме подсетей самого Curator. В особенности когда переезд происходит под атакой. В интерфейсе есть набор утилит для проверки доступности ваших серверов для узлов Curator (и любого другого IP), проходимого им маршрута и корректности настроек доступа. На уровне апстримов можно устроить балансировку посредством Round robin/IP hash с развесовкой запросов и подключить активную проверку доступности апстрима. Ещё одна приятная мелочь — перенаправление с кодом 301/302/307/308 непосредственно на стороне реверс-прокси с возможностью замены имени хоста и пути. При желании можно принести свои сертификаты и самостоятельно отправлять логи, касающиеся HTTP-трафика, чтобы Curator мог в этом случае также защищать и от некоторых L7-атак. Впрочем, можно и самому управлять доступностью своих ресурсов, наполняя по API белые и чёрные списки IP-адресов с указанием времени действия правил (до суток или навсегда) и опираясь на реальные IP-адреса пользователей, которые отдаёт Curator. Также полезно включить уведомление о превышении заданных порогов (в Мбит/с) для входящего, исходящего и пропущенного трафика, а также количества заблокированных IP-адресов. Однако этим возможности не ограничиваются. Curator может работать как обратный TCP/Websocket-прокси или же просто прикрывать «отдельное» TCP-подключение. Для очень крупных заказчиков предлагается защита AS и доступ к Curator посредством туннелей IPIP или GRE. Кроме того, доступны услуги WAF и защищённого DNS-сервера (с передачей зоны). Всё это, естественно, предоставляется с расширенной аналитикой и превентивной защитой от атак. Сеть самого Curator имеет ёмкость 4 Тбит/с, включает 18 центров фильтрации по всему миру и имеет прямое подключение к Tier-1-операторам. Защита от ботовПомимо защиты от DDoS-атак Curator предлагает и фильтрацию запросов пользователей на своей стороне, в первую очередь для защиты от ботов. Никакой скрытой магии тут нет, всё настраивается самим клиентом, поскольку он лучше знает, каких пользователей пускать, а каких нет. Настройки разделены на две логических части: как фильтровать и кого фильтровать. Для ответа на первый вопрос используются простые правила ЕСЛИ–ТО. В ЕСЛИ включён набор из трёх последовательно применяемых условий: хост (или группа хостов, которая задаётся в этом же разделе), метод (GET, POST и т.д.), путь (после хоста) или URI. Можно задать частичное совпадение для каждого из параметров или и вовсе написать регулярное выражение. В ТО входит набор из трёх основных реакций: принять и выдать проверку — при первом обращении отдать 401, снять посредством JS цифровой отпечаток с браузера и поставить cookie, при необходимости выдав CAPTCHA; принять только с cookie, т. е. где-то на более раннем этапе они уже должны быть поставлены; ничего не делать. Есть отдельная опция для работы с внешним CDN, которым нужен беспрепятственный доступ ко всему контенту. Curator «знает» про Ngenix, Akamai и G-Core, а также поддерживает аутентификацию G2O. Настроенные выше правила применяются ко всему приходящему трафику в соответствии с заданным уровнем распределения проверок, за исключением выбранных стран или регионов и заданных IP-адресов или подсетей. Curator рекомендует проверить работу антибота на небольшом проценте пользователей, постепенно перейдя к тотальной проверке всего трафика. Конкретно для тестирования защиты от ботов можно отдельно задать список IP, для которых проверка будет выполняться всегда, и отключить любые проверки для клиентов с предзаданными HTTP-заголовками. Кроме того, конкретно для защиты обращений не от веб-браузеров (или хотя бы WebView с JS) Curator предлагает задействовать не проверку cookie, которые, например, невозможно поставить при прямом обращении к вашему API из приложения, а проверку хеша, который вычисляется на основе HTTP-заголовков и предзаданного секретного ключа. CDNCDN — относительно новая услуга Curator, но весьма полезная, поскольку помогает быстрее доставлять контент до пользователей и экономить на трафике у своего хостинг-провайдера благодаря кешированию на стороне Curator, конвертации изображений в WebP с заданным уровнем сжатия (но если получившаяся на выходе картинка оказалась больше оригинала, то отдаётся оригинал), поддержке HTTP/2 и сжатия gzip/deflate/brotli. Для видео поддерживается работа с потоками HLS и DASH. Ну и конечно, сам CDN тоже находится под защитой от DDoS. Подключение CDN тоже очень простое — Curator выдаёт домен (точнее, поддомен), который посредством CNAME можно привязать к собственному поддомену (или поддоменам) и, как и выше, выписать на него сертификат Let’s Encrypt прямо в интерфейсе Curator или опять-таки принести свой. Это удобно, поскольку позволяет при необходимости переключиться на другого CDN-провайдера. Управлять временем жизни объектов в кеше CDN можно посредством заголовков expires и cache-control, а если их нет, то время жизни по умолчанию составляет 6 часов. Также можно принудительно отправлять клиентам cache-control: no-cache. CDN умеет и кешировать ответы с ошибками, как глобально, так и для конкретного клиента, чтобы лишний раз не дёргать апстрим. Дополнительно можно задать регулярные выражения для запрета обращения к конкретным URL (будет отдаваться код 404), а заодно включить перенаправление с кодом 301/302/307/308 непосредственно на стороне CDN. К слову, отдавать апстриму реальный IP-адрес клиента тоже можно в отдельном заголовке. GET-параметрами можно обрезать, масштабировать или конвертировать изображения на стороне CDN. Сервис поддерживает работу с JPEG, PNG, TIFF, WebP и AVIF, в том числе конвертацию в эти форматы, но если явно операция конвертации не указана, то при любых манипуляциях с изображениями по умолчанию будет отдаваться JPEG или, если эта опция включена, WebP. В тестовом режиме работает возможность выборочно отключать массовую конвертацию в WebP GET-параметром, например когда она даёт слишком плохие результаты (скриншоты, графики и т.п.) или вовсе не нужна (оригиналы фотографий), но при этом отказываться от неё целиком не хочется. ACL и APIСистема прав доступа стандартная, но удобная — есть несколько готовых групп пользователей, однако можно создать и свои, в том числе вложенные, для большего удобства. В рамках каждой группы задаются правила доступа к разделам, подразделам или отдельным функциям. Всего более 30 позиций, причём для некоторых возможна и более гранулярная настройка, например доступ только к определённым сертификатам. Для каждого из правил доступа можно выбрать политики read, update, create, delete (для последних трёх, очевидно, автоматически включается и read). Для повышения защиты рекомендуется у каждого аккаунта включить двойную аутентификацию (TOTP или ключи доступа), а заодно включить уведомления о важных событиях. Для доступа к API используются токены, которые передаются (строго с HTTPS/TLS/SSL) в отдельном HTTP-заголовке. Для каждого токена можно создать набор из нескольких политик, при необходимости задав доступ только к части принадлежащих клиенту ресурсов. Всего доступно несколько десятков различных API, которые покрывают значительную часть функциональности, доступной в консоли Curator. Целиком построить собственную консоль, конечно, не выйдет, поскольку некоторые второстепенные разделы вроде финансовой документации в API не представлены. Кроме того, Curator не даёт прямого доступа к аналитике, но предоставляет возможность самому собрать в консоли графики по основным метрикам: трафик, запросы, задержка, ошибки и т. п. Наконец, Curator предоставляет и сборный помесячный отчёт с более детальной информацией о том, что вообще происходило с вашими ресурсами. ЗаключениеНи одного существенного инцидента с момента подключения к Curator весной этого года не произошло — и это главное. Это, конечно, не значит, что их не будет в будущем, но во всяком случае переход к Curator даёт чувство защищённости в неспокойные для Рунета времена, а это важно, особенно для онлайн-СМИ, которые должны быть доступны читателям всегда. Собственно переход под защиту Curator от DDoS никаких сложностей не вызвал. CDN же помог почти на порядок сократить отдаваемый серверами трафик. Переезд на CDN сам по себе сложностей тоже не вызвал, однако мы, по-видимому, стали одними из первых пользователей данной услуги, так что кое-что пришлось на ходу уточнять и настраивать. Благо техподдержка у Curator адекватная и быстрая, да и в целом приятная в общении, что встречается не так уж часто. Она же, к слову, помогла разобраться с проблемой, которая Curator вовсе не касается, но которая без переезда была бы выявлена нескоро. Единственное, за что можно пожурить сервис, так это за не совсем полную документацию (это только внешняя, есть ещё внутренний FAQ и справка). С одной стороны, понятно, почему так, — сервис постоянно обновляется, где-то по мелочи, где-то заметно. Это видно даже по демоаккаунту, который даёт общее представление об услугах, но всё же отличается от его актуальной версии, более «прилизанной» и удобной. С другой стороны, задавать какие-то элементарные вопросы техподдержке только потому, что буквально одного предложения или ссылки в документации нет, тоже странно. Безопасный выход в интернет для аэропортов как объектов КИИ: как преодолеть дилемму изоляции и безопасности

22.07.2025 [09:00],

Владимир Мироненко

Объекты критической информационной инфраструктуры (КИИ) подлежат особой защите согласно требованиям законодательства, которым предписывается после включения в реестр объектов КИИ перенос критически важных систем в изолированные (закрытые) контуры, отделённые от интернета. Однако без доступа к внешним ресурсам — государственным порталам, системам отчётности, информационным сервисам — работа современного предприятия невозможна. Поэтому требуется найти технологический баланс, обеспечивающий и соответствие требованиям безопасности, и необходимую для работы компании функциональность систем. В решении этой задачи помогут современные отечественные средства виртуализации, позволяющие создать изолированный контур и обеспечить безопасное подключение к нему. Эти средства должны быть сертифицированы ФСТЭК на соответствие актуальным требованиям безопасности. Рассмотрим задачу и способ её решения на примере одного из самых чувствительных типов объектов КИИ — аэропортов, где нарушение работы ИТ-систем грозит особенно серьёзными последствиями. Изоляция vs функциональностьКак и любой другой объект КИИ, аэропорт должен соответствовать строгим требованиям регуляторов по информационной безопасности. Можно просто полностью перенести все системы в закрытый, изолированный, контур, но тогда без доступа к внешним системам не смогут нормально функционировать службы предприятия:

Конечно, можно просто «пробить дыру» в защитном периметре для выхода в Сеть, но это ставит под угрозу всю инфраструктуру. Поэтому для обеспечения необходимой функциональности предприятия требуются специализированные решения, позволяющие обеспечить безопасную связь изолированного контура с внешними системами без нарушения защиты.

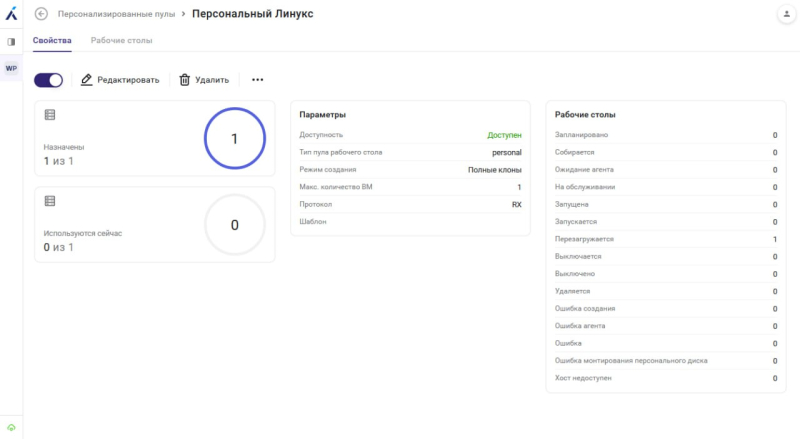

Источник изображений: «Базис» Интерфейс системы управления средой виртуализации Basis Dynamix Standard Виртуальные рабочие столы: мост между изоляцией и функциональностьюСовременные средства виртуализации обеспечивают возможность создать изолированные программные среды, которые могут безопасно взаимодействовать с внешними ресурсами без создания рисков для критической инфраструктуры. Например, решение вендора «Базис», лидера российского рынка виртуализации, предлагает создание виртуальных рабочих столов (VDI) в качестве безопасного «моста» между закрытым контуром и внешним миром Система управления виртуальными рабочими столами Basis WorkplaceОна отвечает за:

Платформа виртуализации Basis Dynamix StandardОна отвечает за создание защищённой изолированной среды и включает:

Как это работает: архитектура безопасностиАрхитектура решения основана на создании демилитаризованной зоны (ДМЗ) между закрытым контуром и интернетом. В ДМЗ размещается диспетчер подключений (брокер), служащий контролируемой точкой доступа к виртуальным рабочим столам, которые находятся в закрытом контуре за пределами ДМЗ, что обеспечивает дополнительный слой безопасности. Из закрытого контура запускается клиентское приложение Basis Workplace, которое устанавливает соединение с диспетчером подключений в ДМЗ, защищённым межсетевыми экранами и обеспечивающим доступ к виртуальным рабочим столам. Благодаря этому виртуальные рабочие столы из закрытого контура имеют контролируемый доступ в интернет через отдельный защищённый канал. Важная особенность архитектуры — применение различных политик безопасности в зависимости от источника подключения. При подключении из защищённого периметра пользователям разрешается использовать буфер обмена, периферийные устройства и USB-накопители. При подключении из внешней сети (например, из домашнего офиса) всё это блокируются для предотвращения утечки данных. Такая многослойная архитектура создает надёжный барьер между критическими системами и внешним миром. Даже если виртуальный рабочий стол будет скомпрометирован, злоумышленники не получат доступа к системам в закрытом контуре, а хранение данных на конечных устройствах пользователей исключено. Что получают пользователи?Виртуальные рабочие столы предоставляют сотрудникам широкие возможности для работы в интернете, но с соблюдением корпоративных политик безопасности. Контроль доступа к веб-ресурсам осуществляется либо на уровне гостевой операционной системы виртуального рабочего стола, либо на уровне шлюзов доступа или прокси-серверов. Это позволяет предоставлять сотрудникам доступ только к необходимым для работы ресурсам и блокировать все потенциально опасные или нежелательные сайты и сервисы. В зависимости от своей роли и должностных обязанностей сотрудники получают только необходимый для работы набор инструментов и доступов, например:

При этом все действия выполняются в изолированной виртуальной среде, физически отделённой от критической инфраструктуры. Скачивание файлов, просмотр веб-страниц, любые потенциально рискованные действия никак не отражаются напрямую на системах в закрытом контуре. Что немаловажно, пользователи, как и раньше, работают с привычными веб-браузерами и другими интернет-приложениями без каких-либо ограничений функциональности. Виртуальный рабочий стол выглядит и функционирует как обычный компьютер с полным набором программ для работы. Работа с электронной подписью и USB-устройствамиПредположим, финансисту необходимо подписать платёжное поручение в интернет-банке с помощью токена электронной подписи. Задача усложняется тем, что компьютер находится в закрытом контуре, а для подписи требуется доступ в интернет. Решение «Базис» устраняет эту проблему с помощью технологии проброса USB-устройств. Сотрудник подключает токен или смарт-карту к устройству доступа (например, ПК) с установленным клиентом Basis Workplace. Устройство доступа может находиться как в защищённом периметре, так и во внешней сети — в зависимости от этого применяются различные политики безопасности. Basis Workplace автоматически делает подключённое устройство доступным на виртуальном рабочем столе, при этом поддерживаются:

Благодаря этому сотрудники могут полноценно работать с системами, требующими строгой аутентификации — будь то государственные порталы, системы отчётности или электронный документооборот — прямо из безопасной среды виртуального рабочего стола. Бесшовный доступ к локальным ресурсамВ случае, если важные документы хранятся на рабочей станции в закрытом контуре, к которой подключены принтеры и другие периферийные устройства, использовать их можно с помощью Basis Workplace, предлагающим два варианта:

КроссплатформенностьРешение «Базис» поддерживает разнообразные операционные системы — как на стороне клиентских устройств (Windows, Альт, Astra Linux, РЕД ОС), так и на виртуальных рабочих столах. Это позволяет внедрить его в любую существующую ИТ-инфраструктуру предприятия без необходимости глобальных изменений. Преимущества для службы информационной безопасностиПредлагаемое «Базисом» решение не только облегчает работу конечных пользователей, но и имеет существенные преимущества для ИБ-специалистов. Прежде всего, архитектура с виртуальными рабочими столами создает эффективный барьер между закрытым контуром и интернетом. Даже если устройство доступа будет скомпрометировано, злоумышленники не получат доступ к критическим системам в закрытом контуре. Это принципиально другой уровень защиты по сравнению с традиционными решениями на основе межсетевых экранов и прокси-серверов. Особое внимание уделяется аудиту и мониторингу. Система ведёт подробные журналы действий пользователей, что позволяет отслеживать, кто, когда и к каким ресурсам получал доступ. Эта информация будет важным подспорьем при расследовании инцидентов и составлении отчётов для регуляторов. При обнаружении подозрительной активности можно будет оперативно отреагировать, вплоть до прекращения сессии пользователя. Также важно то, что Basis Workplace и Basis Dynamix Standard полностью соответствуют требованиям российского законодательства о защите КИИ. Решение «Базиса» обеспечивает надёжную защиту от несанкционированного доступа к значимым объектам, изоляцию сегментов информационной инфраструктуры и контроль действий всех участников. Это значительно упрощает процесс прохождения регуляторных проверок и снижает риски санкций за несоблюдение требований законодательства. Как происходит внедрениеВ «Базисе» разработана прозрачная и эффективная методология внедрения платформы виртуализации, учитывающая специфику объектов КИИ и возможные индивидуальные требования заказчиков. Вначале проводится подробный анализ потребностей, изучается существующая инфраструктура заказчика, проводятся интервью с ключевыми сотрудниками и определяются сценарии использования системы. В итоге формируется список требований к решению, учитывающий как технические аспекты, так и особенности бизнес-процессов предприятия. На этапе проектирования архитектуры интегратор разрабатывает схему решения с учётом всех выявленных особенностей и ограничений инфраструктуры заказчика. Компания также готова рассмотреть и нестандартные требования. Например, можно, в случае необходимости, интегрировать решение с устаревшими, но критически важными системами мониторинга, использующими проприетарные протоколы — такие задачи нередко возникают на промышленных предприятиях. Для этого инженеры разрабатывают специальные «коннекторы», которые позволяют включить эти системы в общий контур безопасности. После утверждения архитектуры вендор разворачивает тестовый стенд — демонстрационную среду, на которой заказчик может оценить работу решения «Базиса» в приближенных к реальным условиях. Это позволяет на ранней стадии выявить возможные проблемы и скорректировать подход к внедрению. Все рутинные операции максимально автоматизированы для ускорения процесса внедрения. От заказчика требуется лишь корректно заполнить «техландшафт» — документ с описанием целевой инфраструктуры. На его основе формируется конфигурация системы, подготавливаются серверы, настраиваются операционные системы и проверяется готовность инфраструктуры. Этап настройки и интеграции включает адаптацию решения к существующей инфраструктуре, настройку компонентов системы и их интеграцию с действующими информационными системами предприятия. Влияние на текущие бизнес-процессы сведено к минимуму — внедрение происходит поэтапно и не нарушает работу критически важных служб. Перед запуском в эксплуатацию проводится комплексное тестирование и аудит безопасности всех компонентов решения. Вендор проверяет функциональность, а интегратор — соответствие требованиям регуляторов. При необходимости выполняется дополнительная настройка средств защиты. После завершения тестирования проводится демонстрация работающего решения. «Базис» собирает обратную связь и при необходимости вносит финальные корректировки. Заключительный этап — запуск решения в промышленную эксплуатацию. В зависимости от требований заказчика вендор может как обеспечить полную передачу компетенций внутренней ИТ-службе, так и взять на себя сопровождение системы в режиме 24/7. Универсальное решение для всех объектов КИИХотя в статье рассмотрено использование платформы виртуализации «Базис» на примере аэропорта, решение может использоваться для любых объектов критической информационной инфраструктуры:

Решение вендора демонстрирует свою эффективность везде, где требуется сочетание высокой безопасности с доступом к внешним ресурсам. Например, банк ВТБ ещё в прошлом году мигрировал с платформы Citrix на Basis Workplace, переведя на новое решение большую часть своих сотрудников. Также успешно реализованы аналогичные проекты по замещению зарубежных VDI-решений и в других крупных российских организациях, в том числе на объектах КИИ. «Базис» — российский лидер в области виртуализацииКомпания «Базис» является ведущим игроком российского рынка виртуализации. Её продукты:

Заключение: безопасность без изоляцииРабота критических систем в закрытом контуре не должна осуществляться в цифровой изоляции. Решение на базе Basis Workplace и Basis Dynamix Standard позволяет выстроить надёжный защищённый мост между закрытым контуром и интернетом, сохраняя высокий уровень безопасности. Вендор понимает специфику работы объектов КИИ и готов помочь найти оптимальный баланс между защищённостью и функциональностью ИТ-инфраструктуры предприятия, поскольку настоящая безопасность — это не изоляция от цифрового мира, а умное управление рисками. Rikor — это база: обзор российской серверной платформы Rikor 7212

27.03.2025 [00:00],

Илья Коваль