|

Опрос

|

реклама

Быстрый переход

Microsoft заявила, что хакеры теперь используют ИИ на всех этапах кибератак

08.03.2026 [00:45],

Владимир Фетисов

Microsoft заявила, что киберпреступники всё чаще задействуют искусственный интеллект в своих операциях для ускорения атак, масштабирования вредоносной деятельности и снижения технических барьеров на всех этапах. В опубликованном недавно отчёте Microsoft Threat Intelligence сказано, что хакеры применяют генеративный ИИ для выполнения широкого круга задач, включая разведку, фишинг, развитие инфраструктуры и создание вредоносного программного обеспечения.

Источник изображений: bleepingcomputer.com Отмечается, что всё чаще злоумышленники используют ИИ-инструменты для составления фишинговых писем, перевода контента, обобщения украденных данных, отладки вредоносного программного обеспечения, а также написания скриптов и настройки инфраструктуры. «<…> большинство случаев злонамеренного применения ИИ связано с использованием языковых моделей для генерации текста, кода или медиа. Злоумышленники задействуют генеративный ИИ для составления фишинговых приманок, перевода контента, обобщения украденных данных, создания и отладки вредоносного ПО, а также написания скриптов и настройки инфраструктуры. В этих сценариях ИИ выступает в качестве усилителя возможностей, который уменьшает технические сложности и ускоряет выполнение, в то время как человек-оператор сохраняет контроль над целями, выбором мишеней и решениями по развёртыванию», — говорится в сообщении Microsoft. Специалисты софтверного гиганта выявили множество случаев, когда разные киберпреступные группировки задействовали ИИ в своих атаках. Речь в том числе о северокорейских группировках Jasper Sleet (Storm-0287) и Coral Sleet (Storm-1877), которые используют ИИ в рамках схем с привлечением находящихся удалённо ИТ-сотрудников. В таких операциях ИИ-инструменты помогают в создании реалистичных личностей, резюме и коммуникациях для трудоустройства в западные компании. «Jasper Sleet использует платформы генеративного ИИ для оптимизации создания поддельных цифровых личностей. Например, члены Jasper Sleet дают команды ИИ-платформам для генерации списков имен, соответствующих культуре, и форматов адресов электронной почты, подходящих под определённые профили личности <…> Jasper Sleet также использует генеративный ИИ для анализа вакансий на должности, связанные с разработкой ПО и IT на профессиональных платформах, давая алгоритмам команды по извлечению и обобщению востребованных навыков. Затем собранные таким образом данные используются для адаптации поддельных личностей под конкретные роли», — сказано в отчёте Microsoft. Там также описывается, как ИИ применяется для разработки вредоносного ПО и создания инфраструктуры. Злоумышленники задействуют языковые модели для написания программного кода, его оптимизации и устранения ошибок, а также переноса отдельных компонентов на разные языки программирования. В некоторых случаях фиксировались признаки использования ИИ для динамической генерации скриптов или изменения поведения в процессе их выполнения. Специалисты Microsoft зафиксировали, как члены группировки Coral Sleet использовали ИИ для быстрого создания поддельных корпоративных сайтов, развёртывания вредоносной инфраструктуры, а также тестирования и устранения неисправностей в работе разных инструментов. Когда ИИ-системы пытаются задействовать механизмы защиты от злонамеренного использования хакеры задействуют особым образом сформированные запросы, позволяющие их обходить. Поскольку многие вредоносные кампании, нацеленные на IT-специалистов, полагаются на злоупотребление легитимным доступом, Microsoft рекомендует организациям рассматривать подобные схемы как инсайдерские риски. Поскольку атаки с использованием ИИ повторяют привычные кибератаки, специалистам по ИБ-безопасности рекомендуется сосредоточиться на выявлении аномального использования учетных данных, усилении защиты систем идентификации от фишинга и обеспечении безопасности самих ИИ-систем, которые могут стать целями в будущих атаках. Китайцы учат роботов «думать» со скоростью света — кремниевая фотоника набирает обороты

06.03.2026 [22:03],

Геннадий Детинич

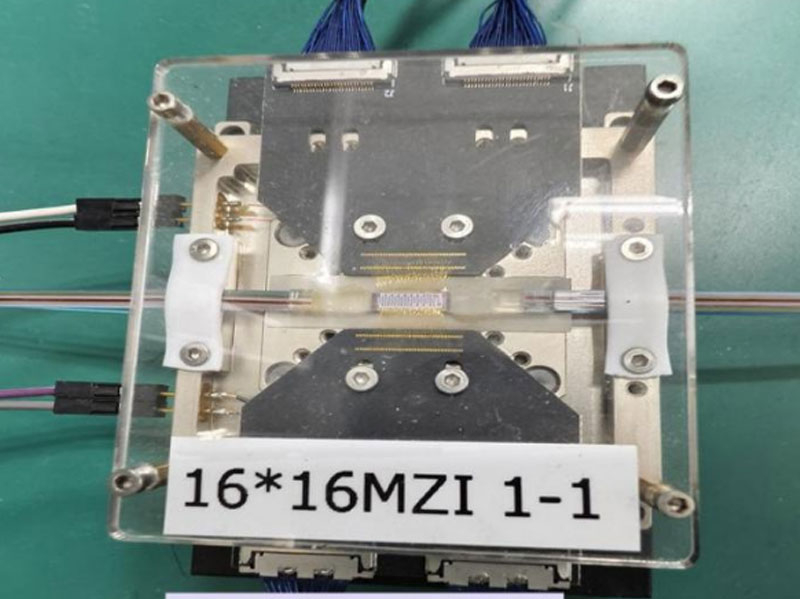

Учёные из Университета Сидянь (Xidian University) разработали фотонную нейроморфную вычислительную систему, которая впервые позволяет выполнять обучение с подкреплением полностью на основе света (фотонов), без перевода сигналов в импульсы тока для выполнения ключевых операций. До этого в массе фотонные спайковые нейронные сети могли совершать только линейные вычисления, но новая разработка ворвалась в сферу нелинейных преобразований и это изменит многое.

Источник изображения: Xidian University Перевод сигналов из состояния фотонов в поток электронов и обратно — это дополнительные потери как энергии, так и времени (задержки). Для функционирования робототехники в режиме реального времени такие потери чреваты быстрым выходом из строя и даже авариями. Поэтому стремление разработчиков создать универсальные фотонные чипы для сложных вычислений и обучения роботов и автопилотов — это один из ключевых путей для безопасного сосуществования робототехники с людьми и среди людей. Созданный учёными двухчиповый оптический прототип решает три основные проблемы: отсутствие ранее крупномасштабных массивов нелинейных фотонных спайковых нейронов с низким порогом срабатывания (теперь такие массивы есть, и порог срабатывания очень низкий, что позволяет создавать намного более плотные массивы нейронов, чем раньше); невозможность создания полностью программируемых чипов спайковых сетей (они были «жёсткими» — запрограммированными аппаратно) и, как итог, отсутствие возможности аппаратной реализации фотонного обучения с подкреплением, что успешно преодолено учёной группой. Первая предложенная исследователями система, о которой они рассказали в свежем выпуске журнала «Оптика» (Optica), состоит из 16-канального фотонного нейроморфного чипа с 272 обучаемыми параметрами (на основе матрицы 16 × 16 интерферометров Маха — Зендера) и чипа с массивом лазеров с обратной связью и насыщаемым поглотителем для низкого порога нелинейной активации спайков. Как положено, также разработан аппаратно-программный фреймворк: модель сначала обучается в программном пакете, затем на чипах, а потом дообучается с учётом особенностей аппаратной реализации. Тестирование проводилось на классических задачах: CartPole (балансировка шеста на тележке) и Pendulum (раскачивание маятника из висячего положения в вертикальное с его последующей стабилизацией в таком положении). Аппаратные результаты показали минимальное падение точности — всего 1,5 % для CartPole и 2 % для Pendulum по сравнению с чисто программной моделью; на CartPole достигнута идеальная производительность, на более сложной задаче Pendulum — хорошая. Производительность впечатляет: энергоэффективность линейных вычислений достигла 1,39 TOPS/Вт при плотности 0,13 TOPS/мм², нелинейных — 987,65 GOPS/Вт и 533,33 GOPS/мм²; задержка вычислений на чипе — всего 320 пикосекунд. Эти показатели выводят оптическую систему в класс GPU по энергоэффективности (1 TOPS/Вт) и плотности вычислений (0,1–0,5 TOPS/мм²), но с преимуществом полной оптической обработки, исключающей потери на конвертацию сигналов. Система демонстрирует быстрое обучение посредством серии проб и ошибок в реальном времени. Разработка открывает перспективы для автономного вождения, встроенного в роботы интеллекта и периферийных вычислений, где требуется сверхнизкая задержка и минимальное энергопотребление. В будущем авторы планируют масштабировать систему до 128-канального чипа для более сложных задач, таких как нейроморфная автономная навигация, и создать компактные гибридно-интегрированные фотонные нейроморфные чипы. Это один из важных шагов к энергоэффективному ИИ, работающему на импульсах света. Google назвала лучшие ИИ-модели для создания Android-приложений — лидером оказалась Gemini

06.03.2026 [18:36],

Владимир Фетисов

Инструменты на базе искусственного интеллекта играют большую роль в написании программного кода и разработке приложений. В пользу этого утверждения говорит то, что Google протестировала несколько ИИ-моделей с целью определить, какие из них лучше подходят для создания Android-приложений. Лидеры тестирования попали в новый рейтинг Android Bench.

Источник изображения: Igor Omilaev/unsplash.com В рамках тестирования специалисты Google изучили, как ИИ-модели работают с Jetpack Compose для создания интерфейсов, Coroutines и Flows для асинхронного программирования, Room для работы с базами данных и библиотекой Hilt для внедрения зависимостей. В дополнение к этому проверялись другие аспекты, такие как обработка критических изменений при обновлении SDK. В процессе Google стремится оценить, как ИИ-модели взаимодействуют с основными и более специфическими частями Android, такими как системный интерфейс, мультимедиа, камеры, адаптация для устройств с гибким дисплеем и др. Google заявила, что цель проекта Android Bench заключается в том, чтобы показать, какие ИИ-модели лучше подходят для разработки Android-приложений, поскольку уже существующие бенчмарки не охватывают весь спектр проблем, с которыми могут сталкиваться разработчики. Как и следовало ожидать, на вершине рейтинга находится модель Google Gemini 3.1 Pro Preview с результатом 72,4 %. Следом за ней идут Anthropic Claude Opus 4.6 и OpenAI ChatGPT 5.2 Codex, набравшие 66,6 % и 62,5 % соответственно. Хуже всего среди участвовавших в тестировании алгоритмов для создания Android-приложений подходит Gemini 2.5 Flash, результат которой 16,1 %. Google заявила, что публикует рейтинг, чтобы «стимулировать улучшение больших языковых моделей для Android-разработки», одновременно помогая разработчикам становиться «более продуктивными». В конечном счёте это должно привести к созданию «приложений более высокого качества во всей экосистеме Android». Roblox задействует ИИ для модерирования чатов в режиме онлайн

06.03.2026 [13:37],

Владимир Фетисов

Платформа Roblox начала использовать алгоритм на базе искусственного интеллекта для корректировки содержания пользовательских сообщений в чатах. Перефразирование сообщений в режиме реального времени выходит за рамки уже действующей на платформе фильтрации запрещённых слов, которые при обнаружении заменяются символами «#».

Источник изображений: Roblox Corporation Теперь же такие слова и фразы будут автоматически трансформироваться в более корректные и уважительные, но с сохранением первоначального смысла, заложенного отправителем. Например, если пользователь напишет в чат «Hurry TF up!» («Давай быстрее, черт возьми!»), алгоритм изменит сообщение на «Hurry up!» («Поторопись!») Каждый раз, когда происходит подобная замена, «все участники чата уведомляются о том, что текст был перефразирован для сохранения вежливого обращения». Функция автоматического перефразирования сообщений в режиме онлайн на платформе Roblox в настоящее время доступна во внутриигровых чатах между игроками, которые прошли возрастную проверку и находятся в схожих возрастных группах. В прошлом месяце в Roblox появилась функция прохождения возрастной проверки для использования чатов на платформе. После подтверждения возраста пользователь может общаться с другими игроками из близких возрастных категорий. Например, пользователи возрастной группы 9-12 лет могут общаться с представителями группы 13-15 лет. ИИ внезапно разогнал спрос на центральные процессоры — AMD и Intel не ожидали такого роста заказов

06.03.2026 [01:30],

Николай Хижняк

На конференции Morgan Stanley Technology, Media & Telecom Conference 2026 компании AMD и Intel заявили о росте спроса на центральные процессоры на фоне продолжающегося развития технологий искусственного интеллекта. Об этом сообщает Tom's Hardware.  Финансовый директор Intel Дэвид Зинснер (David Zinsner) отметил, что «в этом году процессоры снова стали востребованными». Одним из основных драйверов роста топ-менеджер Intel назвал развитие агентных ИИ, которым необходимы процессоры для координации ресурсоёмких вычислительных задач, выполняемых графическими процессорами (GPU) и нейронными процессорами (NPU). Компания даже начала заключать с клиентами долгосрочные соглашения, гарантирующие бесперебойную поставку чипов, необходимых для масштабирования их деятельности. Генеральный директор AMD Лиза Су (Lisa Su), в свою очередь, заявила на той же конференции, что компания наблюдает значительный рост спроса на процессоры на фоне увеличения числа задач инференции. Она также добавила, что спрос на процессоры значительно превзошёл её ожидания. Бум искусственного интеллекта, начавшийся с выпуска чат-бота ChatGPT на базе ИИ в 2022 году, привёл к дефициту различных компьютерных компонентов. Сначала был затронут рынок графических процессоров (GPU). Центры обработки данных и крупные облачные компании массово закупали эти компоненты для создания мощных серверов с сотнями тысяч GPU. По мере нормализации поставок GPU примерно в середине 2025 года эксперты и аналитики начали предупреждать о дефиците оперативной памяти и микросхем для накопителей постоянной памяти из-за огромного спроса на высокоскоростную память и корпоративные хранилища со стороны операторов центров обработки данных, ориентированных на ИИ. Всю силу этого кризиса рынок ощутил в четвёртом квартале прошлого года, когда цены на модули оперативной памяти и SSD выросли до рекордных значений. Этот рост продолжается. Как ожидает TrendForce, в текущем квартале контрактные цены на DRAM последовательно вырастут почти вдвое, а NAND подорожает минимум в полтора раза. Кризис на рынке памяти ощущается сильнее, чем дефицит GPU, поскольку он имеет более широкое влияние. Если графические ускорители в основном используются в домашних ПК и ноутбуках с дискретными видеокартами, то чипы памяти используются практически в каждом современном цифровом устройстве — от потребительских устройств, таких как смарт-телевизоры и смартфоны, до автомобилей и промышленного оборудования. Для выпуска чипов памяти для потребительских продуктов в цепочке производства используются те же кремниевые пластины, которые применяются для выпуска микросхем памяти для систем корпоративного класса, которые обеспечивают производителям более высокую маржу. По мере развития ИИ — от больших языковых моделей и чат-ботов к агентным системам, способным наблюдать, рассуждать, планировать, действовать и учиться независимо, — со стороны центров обработки данных растёт спрос на вычислительную мощность многопроцессорных систем, поскольку для поддержки работы агентных ИИ используются комбинации CPU, GPU и NPU. На этом фоне в Китае уже наблюдается всплеск спроса на процессоры Intel и AMD, при этом некоторые компании в регионе сообщают о нехватке серверных процессоров. По информации Tom’s Hardware, рост популярности агентных ИИ вроде Clawdbot, Moltbot и OpenClaw с открытым исходным кодом для локального использования (то есть дома, а не через облако) приводит к всплеску спроса и на высокопроизводительные системы Mac Studio и Mac mini от Apple. AMD и Intel, говоря о росте спроса на свои процессоры, вероятно, имеют в виду в первую очередь именно серверные чипы, спрос на которые в основном формируется со стороны центров обработки данных. Потребительские системы в общей массе пока не готовы к масштабному локальному развёртыванию агентных ИИ и связанным с этим потребностям в наличии огромного объёма доступной памяти. В течение последних нескольких поколений AMD и Intel двигались в сторону унификации, что позволило им максимизировать прибыль за счёт использования одной и той же микроархитектуры как для клиентских, так и для корпоративных решений. В отличие от Nvidia, которая наблюдала экспоненциальный рост выручки за счёт постоянно растущего спроса на высокопроизводительную память и GPU со стороны сегмента ЦОД, компании AMD и Intel по-прежнему получают около половины своей общей выручки каждый квартал от потребительского рынка. Это по-прежнему важный для них сегмент. И хотя спрос со стороны центров обработки данных на высокопроизводительные серверные процессоры может увеличиться, это не должно произойти за счёт потребительского рынка, по крайней мере в той степени, как это случилось с рынком памяти. Будем надеяться, что и Intel, и AMD смогут удовлетворить спрос на процессоры, чтобы не усугубить и без того ухудшающуюся ситуацию на рынке ПК в целом. В противном случае некоторые уже предсказывают конец эпохи ПК начального уровня к 2028 году, если ситуация будет развиваться в том же направлении. Foxconn похвалилась ростом выручки на 22 % в этом году благодаря ИИ и Nvidia

05.03.2026 [18:50],

Сергей Сурабекянц

Выручка Hon Hai Precision Industry, также известной как Foxconn, за первые два месяца 2026 года выросла на 21,6 %, что отражает неснижающийся спрос на серверы Nvidia, имеющие ключевое значение для глобального развития ИИ. В текущем квартале поставки стоек и серверов для искусственного интеллекта продолжают свой рост. Компания прогнозирует, что результаты первого квартала будут соответствовать ожиданиям рынка.

Источник изображения: Foxconn Благодаря сборке серверов на базе ИИ-ускорителей Nvidia компания Foxconn зарекомендовала себя как ключевой игрок на рынке аппаратного обеспечения для искусственного интеллекта. Спрос на это оборудование стремительно растёт, поскольку технологические гиганты, такие как Alphabet, Amazon, Meta✴✴ и Microsoft, планируют инвестировать в этом году более $650 млрд, несмотря на предупреждения о переизбытке мощностей и сохраняющуюся неопределённость в отношении перспектив монетизации технологии искусственного интеллекта. Объём продаж Foxconn за январь–февраль 2026 года достиг рекордных 1,33 трлн тайваньских долларов ($41,9 млрд). В первом квартале текущего года аналитики прогнозируют рост на 28 %. В месячном исчислении выручка в феврале выросла всего на 8 %, но эксперты объясняют это тем, что в этом году праздничные дни Лунного Нового года пришлись на февраль, в отличие от января 2025 года. Ни в интернет выйти, ни Doom запустить: созданная ИИ операционная система Vib-OS оказалась жалкой пародией на ОС

05.03.2026 [18:36],

Сергей Сурабекянц

Пользователь YouTube с ником Tirimid провёл девятиступенчатую проверку качества ОС Vib-OS v2.2.1, созданной с помощью ИИ. В аннотации на GitHub сказано, что эта Unix-подобная ОС имеет собственное ядро, современный графический интерфейс, полный сетевой стек TCP/IP и виртуальную файловую систему. По результатам тестов ОС оказалась сложной в настройке, содержала множество серьёзных ошибок, не подключалась к интернету и не смогла запустить Doom.

Источник изображения: Tirimid Из описания ОС, по всей видимости также созданного нейросетью, следует, что система нативно поддерживает большинство архитектур, таких как Raspberry Pi 4/5, x86_64 и Apple Silicon, а также может запускаться в эмуляторах, таких как QEMU. Учитывая номер версии 2.2.X можно было ожидать, что проект достиг достаточного уровня стабильности и работоспособности. Тестирование системы проводилось с использованием эмулятора QEMU на Linux x86. Уже на этапе установки были выявлены проблемы, на решение которых у Tirimid ушло несколько часов. Vib-OS v2.2.1 запустилась с привычным рабочим столом, отображающим файловый менеджер, терминал, центральную панель приложений внизу экрана и несколько значков состояния, показывающих, например, состояние сетевого подключения и время. Однако ОС не смогла справиться с несколькими основными задачами:

В описании системы приводились скриншоты игры Doom с пометкой «Классический Doom работает нативно с полной поддержкой графики, ввода и звука». Аннотация уверяла, что в комплект ОС входит «Полный порт Doom с графикой, вводом и звуком». Тем не менее, на попытки запустить игру нажатием на значок Doom система на реагировала. Tirimid смог запустить предустановленную в ОС версию игры Snake («Змейка»), но она имела серьёзные проблемы с обновлениями экрана и темпом игры. Всё же эта плохо реализованная игра позволила Vib-OS повысить оценку системы, поскольку формально она запускалась и работала. Meta✴ заплатит News Corp за доступ ИИ-бота компании к новостном контенту

04.03.2026 [07:31],

Владимир Фетисов

Компания Meta✴✴ Platforms заключила лицензионное соглашение в сфере искусственного интеллекта с News Corp. В рамках достигнутых договорённостей Meta✴✴ сможет использовать контент The Wall Street Journal и других изданий в ответах на пользовательские запросы в своём чат-боте Meta✴✴ AI, а также для обучения нейросетей.

Источник изображения: Copilot News Corp подтвердила заключение соглашения с Meta✴✴, но условия сделки раскрыты не были. По данным источника, гигант соцсетей будет выплачивать издателям «до $50 млн в год» в рамках трёхлетнего соглашения, которое охватывает контент The Wall Street Journal, а также других изданий медиагиганта в США и Великобритании. Ранее News Corp заключила аналогичное соглашение сроком на пять лет с OpenAI, оцениваемое примерно в $250 млн. Во время недавнего выступления на конференции Morgan Stanley по технологиям, медиа и телекоммуникациям гендиректор News Corp Роберт Томсон (Robert Thomson) намекнул, что компания находится на «продвинутой стадии других переговоров». Представитель Meta✴✴ подтвердил, что компании достигли договорённостей. В Meta✴✴ продолжается реорганизация ИИ-подразделений и подготовка к запуску новых языковых моделей. На этом фоне гигант соцсетей заключил несколько лицензионных соглашений на использование контента, в том числе с USA Today, People, CNN, Fox News и др. В компании ранее заявляли, что интегрируя больше разных типов новостных источников, разработчики стремятся улучшить способность Meta✴✴ AI предоставлять пользователям актуальный и релевантный контент с широким разнообразием точек зрения. Сотрудники Google и OpenAI призывают к ужесточению ограничений на использование ИИ в военных целях

03.03.2026 [23:44],

Сергей Сурабекянц

Сотрудники Google и OpenAI опубликовали открытое письмо «Мы не будем разделены», собравшее почти 900 подписей, с призывом к более строгим ограничениям на использование искусственного интеллекта военными. Напряжённость в технологической индустрии возросла в последние несколько дней после того, как Министерство обороны США внесло технологии Anthropic в чёрный список.  Свои подписи под письмом поставили около ста работников OpenAI и около восьмисот сотрудников Google. В письме критикуются действия Министерства обороны США против компании Anthropic, которая отказалась разрешить использование своих технологий для массового наблюдения или создания полностью автономного оружия. «Они пытаются разделить каждую компанию, надеясь, что другая уступит, — говорится в письме. — Эта стратегия работает только в том случае, если никто из нас не знает, какова позиция другой стороны. Это письмо призвано создать взаимопонимание и солидарность перед лицом этого давления со стороны Министерства обороны». Напряжённость в технологической отрасли нарастает уже несколько месяцев. Работники отрасли требуют большей прозрачности в отношении работы, которую их работодатели выполняют с правительством, особенно в отношении контрактов на облачные технологии и искусственный интеллект. Для Google последняя волна критики связана с тем, что компания, как сообщается, ведёт переговоры с Пентагоном о внедрении своей модели ИИ Gemini в секретную военную систему.

Источник изображения: unsplash.com В пятницу группа No Tech For Apartheid, которая давно критикует сделки по облачным технологиям между правительством США и технологическими гигантами, опубликовала совместное заявление под названием «Amazon, Google, Microsoft должны отклонить требования Пентагона». Эти компании, по мнению правозащитников, должны отказаться от условий Министерства обороны, которые позволят осуществлять массовое наблюдение или иное неправомерное использование ИИ. Группа прямо указала на Google, сославшись на потенциальную сделку с Пентагоном, которая может быть аналогична соглашению, позволяющему Министерству обороны развёртывать Grok от xAI «в секретных средах — насколько нам известно, без каких-либо ограничений». В то время как Anthropic и OpenAI сделали публичные заявления относительно своих переговоров с Министерством обороны, Alphabet, материнская компания Google, хранит молчание. Сотни сотрудников технологических компаний подписали открытое письмо в поддержку Anthropic, призывающее Министерство обороны отменить присвоение компании статуса «риска для цепочки поставок». В список подписантов вошли десятки сотрудников OpenAI, а также работники таких компаний, как Salesforce, Databricks, IBM и Cursor. В письме содержится призыв к Конгрессу «изучить вопрос о целесообразности использования этих чрезвычайных полномочий против американской технологической компании». Аналогичные опасения высказывались внутри Google на прошлой неделе, когда более 100 сотрудников, работающих над технологиями искусственного интеллекта, обратились к руководству, выразив опасения по поводу сотрудничества компании с Министерством обороны. Сообщается, что они попросили провести те же «красные линии», что ранее сделала Anthropic.

Источник изображения: Axios Главный научный сотрудник Google Джефф Дин (Jeff Dean) считает, что «массовое наблюдение нарушает Четвёртую поправку и оказывает сдерживающее воздействие на свободу выражения мнений», а системы слежки «склонны к злоупотреблениям в политических или дискриминационных целях». Похоже, что далеко не все менеджеры Google согласны с ним. В 2018 году компания пережила настоящий бунт тысяч сотрудников из-за проекта Maven, программы Пентагона, которая использовала ИИ для анализа видеозаписей с дронов. Позже компания разработала свои «Принципы ИИ», определяющие порядок использования этих технологий. Тем не менее, ситуация продолжает вызывать беспокойство. В 2024 году Google уволила более 50 сотрудников после протестов по поводу проекта Nimbus, совместного контракта с Amazon на сумму $1,2 млрд на работу с правительством Израиля. Хотя руководители утверждали, что контракт не нарушает ни один из «Принципов ИИ», документы и отчёты показывают, что это соглашение позволяло предоставлять Израилю инструменты ИИ, включая категоризацию изображений, отслеживание объектов и положения для государственных производителей оружия. Сообщается, что в начале прошлого года Google пересмотрела свои принципы в области искусственного интеллекта и удалила формулировки, которые прямо запрещали «создание оружия» или «технологий слежки». Двуличность OpenAI возмутила пользователей — число удалений приложения ChatGPT выросло вчетверо

03.03.2026 [13:10],

Владимир Фетисов

Количество удалений мобильного приложения ChatGPT в США подскочило на 295 % всего за один день. Это произошло после того, как OpenAI объявила о подписании соглашения с Министерством обороны США. Об этом говорится в отчёте платформы Sensor Tower, где также отмечается, что типичный показатель удалений приложения ChatGPT день ото дня за последний месяц составлял 9 %.

Источник изображения: unsplash.com На этом фоне количество загрузок приложения Anthropic Claude в США выросло на 37 % через день после объявления OpenAI, и на 51 % ещё через день после того, как Anthropic объявила, что не будет сотрудничать с Пентагоном. Компания сообщила, что условия сделки не удалось согласовать из-за опасений по поводу того, что созданные ею алгоритмы будут использоваться для создания инструментов слежки за американцами или полностью автономного оружия. Данные Sensor Tower указывают на то, что часть потребителей поддерживает позицию Anthropic. Новость о партнёрстве OpenAI с военными повлияла и на количество загрузок приложения ChatGPT. Через день после объявления о сделке количество скачиваний снизилось на 13 %, а ещё через день — на 5 %. За день до объявления о партнёрстве с военными количество загрузок ChatGPT выросло на 14 % по сравнению с предыдущим днём. Это также отразилось на положении приложения Claude в американском App Store. В минувшую субботу приложение заняло первую строчку рейтинга бесплатных приложений и продолжало оставаться на этой позиции по состоянию на понедельник. Всего за неделю приложение Claude сделало скачок в рейтинге более чем на 20 позиций. Потребители также делятся своим мнением о сделке OpenAI с Министерством обороны США в социальных сетях. В минувшую субботу количество отзывов с одной звездой для ChatGPT подскочило на 775 %, а затем выросло ещё на 100 % в воскресенье. Количество пятизвёздочных отзывов за тот же период уменьшилось на 50 %. Lenovo представила настольный «шар с глазками» — концепт робота-помощника AI Workmate с проектором и ИИ

02.03.2026 [02:01],

Николай Хижняк

Lenovo представила Lenovo AI Workmate Concept — концепт цифрового помощника на базе искусственного интеллекта, воплощённого в физической форме. Решение переосмысливает взаимодействие пользователей с интеллектуальными системами в их повседневной работе.

Источник изображений: Lenovo Устройство напоминает настольную лампу на эргономичной подставке. Однако на самом деле это настольный робот, оснащённый экраном и поддержкой различных функций, предназначенных для повышения продуктивности в повседневных рабочих процессах. Он поддерживает текстовое, голосовое, жестовое и пространственное взаимодействие, при этом ввод обрабатывается локально встроенным ИИ. Помимо традиционных функций помощи — например, поиска информации, предоставления подсказок или планирования встреч, — Lenovo AI Workmate предназначен для поддержки практических бизнес-задач, таких как сканирование и обобщение документов, организация заметок, а также помощь в создании презентаций и другого рабочего контента. В рамках концепта устройство также оснащено проектором, с помощью которого можно демонстрировать презентации более широкой аудитории. Контент может проецироваться на близлежащие поверхности, такие как стол или стена. Microsoft представила Copilot Tasks — ИИ-агента для выполнения задач в фоне

27.02.2026 [12:26],

Владимир Фетисов

Microsoft анонсировала бета-версию новой ИИ-системы под названием Copilot Tasks, которая, по словам компании, предназначена для выполнения повседневных задач пользователя в фоновом режиме. Copilot Tasks использует облачную инфраструктуру и браузер, снимая нагрузку с локального устройства, для обработки разных задач — от планирования встреч и поездок до создания учебных планов и др.

Источник изображения: blogs.windows.com В описании нового инструмента сказано, что пользователь может естественным языком описать задачу и поручить Copilot Tasks выполнять её на регулярной основе, по определённому расписанию или же однократно. После завершения работы ИИ-система предоставит пользователю отчёт о том, что было сделано. К примеру, пользователь может попросить Copilot Tasks организовать свои подписки и отменить неиспользуемые или превратить электронные письма с вложениями в презентацию. Другие варианты использования включают возможность выделять срочные письма, генерировать наброски отчётов, планировать дни рождения от выбора места для празднования до рассылки приглашений, отслеживать новые объявления на интересующую тематику и др. По всей видимости, Copilot Tasks является ответом Microsoft на другие аналогичные агентские ИИ-системы, которые были запущены за последние несколько месяцев. Речь об инструментах Claude Cowork, ChatGPT Agent Mode, Perplexity Computer и функции «автоматического просмотра» на базе Gemini в браузере Chrome. Microsoft отметила, что Copilot Tasks будет запрашивать разрешение пользователя на выполнение «значимых действий» от его имени, включая осуществление платежей и отправку сообщений. На данном этапе Copilot Tasks доступен лишь небольшой группе тестировщиков. Новая статья: Биочипы и органоидный интеллект

27.02.2026 [00:03],

3DNews Team

Данные берутся из публикации Биочипы и органоидный интеллект Metacritic удалил обзор Resident Evil Requiem от уважаемого игрового сайта — новая администрация заменила авторов на ИИ

26.02.2026 [23:27],

Дмитрий Рудь

Администрация агрегатора рецензий Metacritic удалила со страницы экшен-хоррора Resident Evil Requiem обзор от уважаемого британского сайта Videogamer, потому что материал был не написан человеком, а сгенерирован ИИ. Обозреватель Videogamer Брайан Мерриголд (Brian Merrygold) оценил Resident Evil Requiem на 9 из 10 баллов. Рецензия попала в рейтинг на Metacritic, однако читатели быстро заметили, что с публикацией что-то не так. По мнению пользователей, текст Мерриголда «отдаёт ИИ», а сам автор, «опытный аналитик в сфере iGaming (азартные игры онлайн — прим.) и спортивных ставок», похоже, является вымышленным персонажем с ИИ-аватаром. Сооснователь Metacritic Марк Дойл (Marc Doyle) в разговоре с Kotaku подтвердил, что обзор Resident Evil Requiem и ещё несколько рецензий от Videogamer за 2026 год были удалены с агрегатора после проверки на ИИ-материалы. Стоит отметить, что владельцем Videogamer с недавних пор является рекламное агентство Clickout, охватывающее, в том числе, сферу азартных игр. Под его началом портал начал рассказывать не только о видеоиграх, но и о казино. По данным Kotaku, в азартном разделе Videogamer сгенерированные ИИ материалы начали появляться ещё осенью 2025 года, а в видеоигровой проникли с увольнением последних настоящих журналистов на прошлой неделе. С тех пор Videogamer начал выпускать созданные «ИИ-авторами» с помощью ИИ игровые новости, специальные материалы и обзоры. Тем временем профили старых авторов были заменены поддельными ИИ-аккаунтами. Google представила Nano Banana 2 — обновлённый генератор изображений работает быстрее и качественнее, и доступен бесплатно

26.02.2026 [20:49],

Николай Хижняк

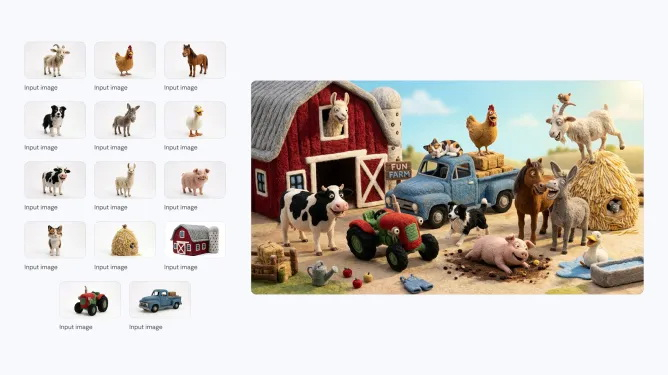

Компания Google анонсировала последнюю версию своей популярной ИИ-модели для генерации изображений — Nano Banana 2. Новая модель, которая технически является аналогом Gemini 3.1 Flash Image, способна создавать более реалистичные изображения по сравнению с предшественницей. Nano Banana 2 станет моделью по умолчанию в приложении Gemini для режимов Fast, Thinking и Pro, то есть новинка будет доступна и бесплатным пользователям.

Источник изображений: Google Компания впервые выпустила Nano Banana в августе 2025 года. Она быстро завоевала популярность среди пользователей Gemini, особенно в таких странах, как Индия. В ноябре Google представила Nano Banana Pro, позволяющую создавать более детализированные и высококачественные изображения. Новая Nano Banana 2 сохраняет ряд характеристик высокой детализации версии Pro, но генерирует изображения быстрее. С её помощью можно создавать изображения с разрешением от 512 пикселей до 4K и с различными соотношениями сторон.  Nano Banana 2 поддерживает единообразие персонажей (до пяти) и точную проработку до 14 объектов в одном рабочем процессе, что улучшает возможности повествования. По словам Google, пользователи могут отправлять сложные запросы с подробными нюансами для генерации изображений. Кроме того, модель позволяет создавать медиаконтент с более ярким освещением, насыщенными текстурами и чёткими деталями.  С запуском Nano Banana 2 станет моделью по умолчанию для генерации изображений во всех приложениях Gemini. Компания также сделает её моделью по умолчанию для генерации изображений в своём инструменте для редактирования видео Flow. В 141 стране Nano Banana 2 станет моделью по умолчанию в Google Lens и в режиме поиска с ИИ в мобильной и веб-версии Google Search. Пользователи тарифных планов Google AI Pro и Ultra смогут продолжать использовать Nano Banana Pro для специализированных задач, выбрав соответствующую настройку через меню с тремя точками. Для разработчиков Nano Banana 2 будет доступна в режиме предварительного просмотра через API Gemini, Gemini CLI и Vertex API. Она также появится в AI Studio и инструменте разработки Antigravity, выпущенном в ноябре прошлого года.  Google заявляет, что все изображения, созданные с помощью новой модели, будут иметь водяной знак SynthID — фирменный маркер для обозначения изображений, сгенерированных искусственным интеллектом. Изображения также совместимы с системой C2PA Content Credentials, которая подтверждает происхождение контента и фиксирует, подвергался ли он изменениям. Систему поддерживают Adobe, Microsoft, Google, OpenAI и Meta✴✴. Google сообщила, что с момента запуска проверки SynthID в приложении Gemini в ноябре ей воспользовались более 20 млн раз. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |