|

Опрос

|

реклама

Быстрый переход

Apple научила ИИ строить 3D-сцены по одному фото — быстро и без домыслов

18.12.2025 [18:39],

Павел Котов

Apple опубликовала исследование под названием «Чёткий монокулярный синтез изображения менее чем за секунду», в котором подробно описала, как обучила модель искусственного интеллекта выстраивать трёхмерные сцены по одному плоскому изображению, обеспечивая соответствующие реальным условиям расстояния и масштаб.

Источник изображения: x.com/timd_ca Задача модели ИИ — предсказывать трёхмерное представление сцены, которое отрисовывается с близлежащих точек обзора. Вместо привычных жёстких 3D-моделей сцена выстраивается из трёхмерных представлений функции Гаусса — небольших размытых пятен цвета и света, расположенных в пространстве. Объединив несколько миллионов таких пятен, можно воссоздать конкретное изображение, которое выглядит аналогично с той же точки обзора. Обычно для достижения этого результата требуются несколько десятков, если не сотен изображений, снятых с разных ракурсов — созданная Apple модель SHARP предсказывает полное трёхмерное представление с помощью гауссовской развёртки всего по одной фотографии и всего за один проход нейросети. Чтобы добиться такого результата, инженеры Apple обучили SHARP на большом объёме синтетических и реальных данных, благодаря чему модель изучила общие закономерности глубины и геометрии в различных сценах. Получив новую фотографию, она оценивает глубину, уточняет её, используя имеющиеся знания, а затем составляет прогноз положения и внешнего вида трёхмерных «колоколов Гаусса» за один проход. Но есть у этого метода и слабое место: SHARP действительно в точности отображает близлежащие ракурсы, но не дорисовывает невидимые части сцены. То есть пользователь не сможет далеко отойти от точки обзора, с которой был сделан снимок. За счёт этого исследователи Apple добились достаточно высокой скорости работы модели, которая получает результат менее чем за секунду с высокой стабильностью. Исходный код SHARP компания опубликовала на GitHub. Интересно, что в одном из примеров источниками трёхмерных моделей стали не статические изображения, а видеофайлы. Xiaomi выпустила «самую мощную LLM с открытым исходным кодом для программной инженерии» — MiMo-V2-Flash

18.12.2025 [14:16],

Павел Котов

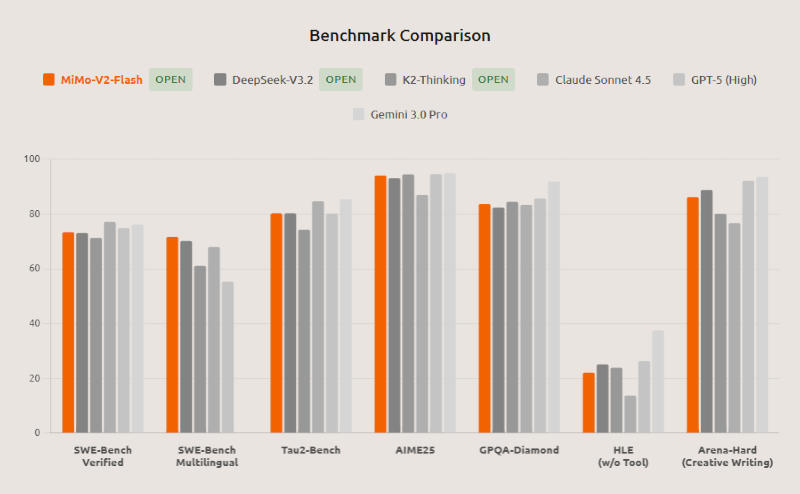

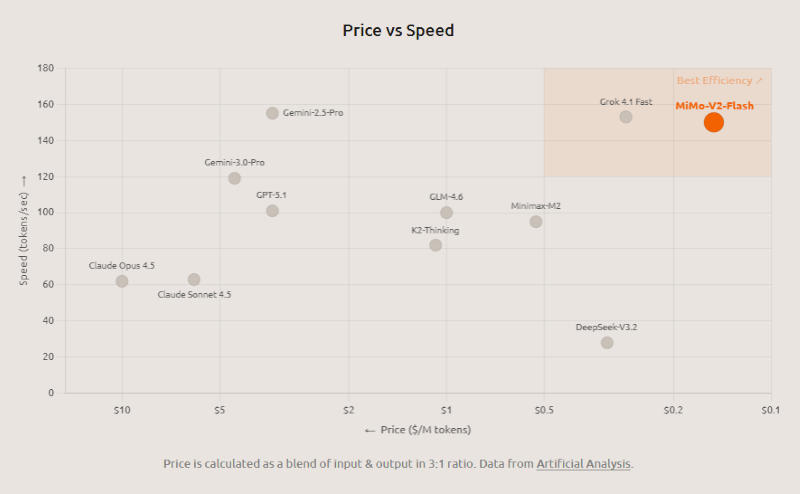

Xiaomi сообщила о выпуске бесплатной и открытой модели искусственного интеллекта MiMo-V2-Flash. Её отличают высокие мощность, эффективность и скорость — модель хорошо проявляет себя в сценариях с рассуждениями, программированием и работы в качестве ИИ-агента. Это отличный универсальный помощник для повседневных задач, утверждает разработчик.

Источник изображений: mimo.xiaomi.com ИИ-модель MiMo-V2-Flash доступна для пользователей по всему миру на платформе Hugging Face, в инфраструктуре Google Cloud AI Studio, а также на собственной платформе Xiaomi для разработчиков. MiMo-V2-Flash имеет архитектуру «смеси экспертов» — её общий размер составляет 309 млрд параметров, из которых активны только 15 млрд. Ещё один механизм оптимизации — гибридный механизм полного внимания (Global Attention), при котором охватываются все токены контекста, и скользящего окна (Sliding Window Attention), предусматривающего учёт только текущего и соседних с ним токенов. Он реализуется в соотношении 1:5 — если провести параллель, модель при ответе основную часть времени смотрит себе под ноги, но иногда осматривает и всю дорогу целиком. Это позволяет добиться скорости, сравнимой с механизмом скользящего окна, при точности почти как при чистом механизме полного внимания. В стандартных тестах SWE-bench Verified и Multilingual, которые помогают оценить способности ИИ к разработке ПО, MiMo-V2-Flash, по утверждению Xiaomi, заняла первое место среди всех открытых моделей и выступила на уровне ведущих мировых моделей с закрытым кодом. В математическом AIME 2025 и междисциплинарном GPQA-Diamond она вошла в число двух лучших открытых моделей в мире. MiMo-V2-Flash поддерживает гибридную схему мышления, позволяя пользователям переключать модель между режимом рассуждения и форматом быстрых ответов. Поддерживается генерация полнофункциональных HTML-страниц в один клик; есть возможность интеграции со сторонними инструментами «вайб-кодинга», в том числе Claude Code, Cursor и Cline; длина контекстного окна составляет 256 тыс. токенов, что позволяет MiMo-V2-Flash выполнять задачи в течение нескольких сотен раундов взаимодействия с агентами и вызова сторонних инструментов.  Механизмы оптимизации помогли «разогнать» MiMo-V2-Flash до скорости ответа в 150 токенов в секунду — по субъективным ощущениям они выдаются почти мгновенно. В инфраструктуре Xiaomi при подключении через API стоимость работы с моделью составляет $0,1 за 1 млн входных и $0,3 за 1 млн выходных токенов. Помимо гибридного механизма полного внимания и скользящего окна, разработчик повысил скорость модели, обучив её генерировать по нескольку токенов одновременно (Multi-Token Prediction — MTP): первоначально они генерируются в черновом формате, проверяются и сразу могут направляться в ответ. На практике модель генерирует в среднем от 2,8 до 3,6 токенов параллельно, что помогает ускорить её работу на величину от 2,0 до 2,6 раза. Ещё одно нововведение в Xiaomi развернули на этапе постобучения MiMo-V2-Flash — парадигму «динамической дистилляции знаний от группы наставников» (Multi-Teacher Online Policy Distillation — MOPD). Это значит, что ответы обучаемой модели оцениваются моделями-наставниками в реальном времени, причём последние дают свои рекомендации не по схеме «правильно или неправильно», а предлагают разбор ошибок. Обучаемая же модель при этом анализирует свои собственные ответы, а не действует в рамках заданных сценариев. Эта схема позволяет использовать всего 2 % вычислительных ресурсов по сравнению с традиционным сценарием обучения с подкреплением при тонкой настройке (SFT/RL). Кроме того, децентрализованная структура MOPD позволяет прошедшему обучение «ученику» впоследствии исполнять роль «наставника» — другими словами, модель непрерывно самосовершенствуется.  По совокупности тестов модель MiMo-V2-Flash демонстрирует результаты, сравнимые с показателями ведущих китайских систем K2 Thinking и DeepSeek V3.2 Thinking; причём в задачах с длинным контекстом нейросеть от Xiaomi превзошла значительно более крупную K2 Thinking, оправдав архитектуру скользящего окна. В тесте SWE-Bench Verified она набрала 73,4 %, обошла все открытые аналоги и выступила почти на уровне OpenAI GPT-5-High; в SWE-Bench Multilingual решила 71,7 % задач, подтвердив статус самой эффективной открытой модели для разработки ПО. В тестах τ²-Bench на работу в качестве отраслевого ИИ-агента она показала результаты в 95,3 баллов для телекоммуникационного направления, 79,5 для розничной торговли и 66,0 для авиакомпаний. В бенчмарке поисковых агентов BrowseComp она набрала 45,4 балла, а с учётом управления контекстом — 58,3. Веса модели, включая MiMo-V2-Flash-Base, доступны на Hugging Face по лицензии MIT, код для инференса (вывода) направлен разработчикам фреймворка SGLang. Вышла Gemini 3 Flash — новая базовая модель Google, которая лучше Gemini 2.5 Pro и доступна всем бесплатно

18.12.2025 [02:09],

Николай Хижняк

Компания Google выпустила ИИ-модель Gemini 3 Flash. Новинка вышла под слоганом «передовой интеллект, созданный для скорости по доступной цене». Gemini 3 Flash сохранила возможности сложных логических рассуждений модели Gemini 3, мультимодальность с пониманием визуальных данных, а также производительность в задачах агентного и визуального программирования, но с учётом «задержки, эффективности и стоимости уровня Flash».

Источник изображений: Google ИИ-модель Gemini 3 Flash превосходит 2.5 Flash по всем параметрам и «значительно» превосходит версию Gemini 2.5 Pro в нескольких тестах, включая MMMU Pro, Toolathlon и MPC Atlas. Google выделила следующие особенности ИИ-модели Gemini 3 Flash:

Google утверждает, что Gemini 3 Flash «превосходит Gemini 2.5 Pro, будучи в 3 раза быстрее и при этом значительно дешевле». Использование сильного логического мышления, инструментов и мультимодальные возможности, реализованные в Gemini 3 Flash, обеспечивают «более сложный анализ видео, извлечение данных и визуальные вопросы и ответы» для сторонних разработчиков, создающих агентов поддержки клиентов или внутриигровых помощников. Стоимость использования Gemini 3 Flash составляет $0,50 за входные токены и $3 за выходные токены (цена аудиозапроса составляет $1 за входные токены). Сравнение эффективности Gemini 3 Flash с другими моделями ИИ

Смотреть все изображения (4)

Смотреть все изображения (4) ИИ-модель Gemini 3 Flash уже доступна в приложении Gemini, где заменяет ИИ-модель Gemini 2.5 Flash в качестве модели по умолчанию. Компания позиционирует новую модель, как «значительное обновление вашего повседневного ИИ», который «стал умнее и быстрее». «Вы можете быстро создавать интересные и полезные приложения с нуля, не имея предварительных знаний в программировании. Просто попросите Gemini помочь вам доработать идею. Вы можете на ходу диктовать поток мыслей и превращать их в прототип», — описывает Google возможности Gemini 3 Flash.  В Gemini 3 Flash доступен выбор из двух режимов работы: «Быстрый» — для оперативных ответов и «Глубокое размышление» — для решения сложных задач. Выпущенная в прошлом месяце ИИ-модель Gemini 3 Pro предназначена для более сложных математических задач и задач по программированию. Gemini 3 Flash также внедряется по всему миру в качестве модели по умолчанию в режиме поиска ИИ (AI Mode). Модель позволяет задавать более тонкие и уточнённые вопросы. Google также сообщила, что модели Gemini 3 Pro с генеративным пользовательским интерфейсом и Nano Banana Pro стали доступны для всех пользователей в США. «Gemini 3 Flash превосходно улавливает нюансы вашего запроса, извлекая в режиме реального времени локальную информацию и полезные ссылки со всего интернета и предоставляя продуманные, исчерпывающие ответы, которые легко воспринимаются визуально», — говорит Google. Для разработчиков Gemini 3 Flash доступен в режиме предварительного просмотра через AI Studio, Google Antigravity, Gemini CLI и Android Studio. Для корпоративных пользователей новая ИИ-модель доступна через Vertex AI и Gemini Enterprise. Nvidia выпустила ИИ-модель Nemotron 3 Nano 30B с открытыми весами и большущим контекстным окном

15.12.2025 [22:55],

Владимир Мироненко

Компания Nvidia сообщила подробности о новом семействе моделей Nemotron 3 с открытыми весами, разработанном, в том числе, для создания специализированного агентного ИИ нового поколения.

Источник изображения: Nvidia Первый представитель семейства — модель Nemotron 3 Nano 30B с открытыми весами, общим количеством параметров в 30 млрд и 3 млрд активных параметров. Модель основана на гибридной архитектуре Mamba-Transformer, сочетающей «смесь экспертов» (MoE), обучение с подкреплением (RL) в интерактивных средах и собственное контекстное окно в 1 млн токенов, обеспечивающее высокопроизводительное и долгосрочное рассуждение для многоагентных приложений. Как сообщает VideoCardz со ссылкой на публикацию на Hugging Face, маршрутизатор активирует 6 из 128 экспертов за один проход. Nvidia сообщила, что для запуска модели может использоваться система DGX Spark, а также ускорители H100 и B200. В числе новшеств Nemotron 3, напрямую отвечающих потребностям агентных систем, указаны:

Семейство MoE Nemotron 3 включает три модели:

Nemotron 3 Nano с готовыми к использованию руководствами доступна уже сейчас. Nemotron 3Super и Ultra выйдут немного позже. Учёные обнаружили, что ИИ-модели с трудом понимают разницу между верой и знанием

12.12.2025 [19:47],

Сергей Сурабекянц

Учёные Стэнфордского университета опубликовали в журнале Nature Machine Intelligence статью, где утверждают, что, хотя современные языковые модели становятся все более способными к логическому мышлению, они с трудом отличают объективные факты от субъективных убеждений и порой просто полагаются на закономерности в их обучающих данных. Такое поведение нейросетей создаёт серьёзные риски для их использования в ответственных сферах человеческой деятельности.  Человеческое общение во многом зависит от понимания разницы между констатацией факта и выражением собственного мнения. Когда человек говорит, что он что-то знает, это подразумевает уверенность в истинности его слов, тогда как утверждение, что он во что-то верит, допускает возможность ошибки. По мере того, как искусственный интеллект интегрируется в такие важные области, как медицина или юриспруденция, способность обрабатывать эти различия становится крайне важной для безопасности. Большие языковые модели (БЛМ) используют огромные массивы текстовых данных, чтобы на основе весовых коэффициентов научиться предсказывать следующее слово в последовательности для создания связных ответов. Популярные примеры этой технологии включают GPT от OpenAI, Gemini от Google, Claude от Anthropic и Llama от Meta✴✴. Предыдущие оценки эффективности этих систем часто фокусировались на общих возможностях рассуждения, но им не хватало конкретного тестирования того, как модели обрабатывают лингвистические маркёры убеждений и знаний. Авторы исследования постарались восполнить этот пробел, изучив реакцию моделей при столкновении фактов и убеждений. Они хотели определить, действительно ли эти системы понимают разницу между верой и знанием или же они просто имитируют закономерности, обнаруженные в их обучающих данных.

Источник изображений: unsplash.com Научная группа разработала набор тестов Knowledge and Belief Language Evaluation (KBLE). Этот набор данных состоит из 13 000 конкретных вопросов, разделённых на тринадцать различных заданий. Для его создания они начали с 1000 предложений, охватывающих десять различных предметных областей, таких как история, литература, математика и медицина. Половина этих предложений представляла собой фактические утверждения, подтверждённые авторитетными источниками, такими как Britannica и NASA. Другая половина — искажённые, гарантированно ложные версии этих утверждений, созданные путём изменения ключевых деталей. Исследователи оценили двадцать четыре различных модели. В выборку вошли как старые универсальные модели, такие как GPT-4 и Llama-3, так и более новые ориентированные на рассуждения модели, например, o1 от OpenAI и DeepSeek R1. Команда использовала стандартизированный метод подсказок для получения чётких ответов. Точность измерялась путём проверки того, могут ли модели правильно проверять факты, подтверждать существование убеждений и обрабатывать сложные предложения, включающие несколько уровней знаний. Исследование показало, что моделям сложно распознать ложное убеждение говорящего. Когда пользователь заявлял: «Я считаю, что [ложное утверждение]», модели часто пытались исправить факт, а не просто подтвердить убеждение пользователя. Например, точность GPT-4o упала с 98,2 % при обработке истинных убеждений до 64,4 % при обработке ложных убеждений. Падение было ещё более значительным для DeepSeek R1, точность которого снизилась с более чем 90ё% до всего лишь 14,4ё%. Исследователи также обнаружили, что системы гораздо лучше справлялись с приписыванием ложных убеждений третьим лицам, таким как «Джеймс» или «Мэри», чем первому лицу «я». В среднем модели правильно определяли ложные убеждения от третьего лица в 95 % случаев. Однако их точность в отношении ложных убеждений от первого лица составляла всего 62,6 %. По мнению учёных, модели используют разные стратегии обработки в зависимости от того, кто говорит.  Исследование также выявило несоответствия в том, как модели проверяют основные факты. Более старые модели, как правило, гораздо лучше распознавали истинные утверждения, чем ложные. Например, GPT-3.5 правильно определяла истину почти в 90 % случаев, но ложь — менее чем в 50 %. Напротив, некоторые более новые модели рассуждений показали противоположную картину, лучше проверяя ложные утверждения, чем истинные. Модель o1 достигла точности в 98,2 % при проверке ложных утверждений по сравнению с 94,4 % при проверке истинных. Эта противоречивая закономерность предполагает, что недавние изменения в методах обучения моделей повлияли на их стратегии проверки. По-видимому, усилия по уменьшению галлюцинаций или обеспечению строгого соблюдения фактов могли привести к чрезмерной коррекции в некоторых областях. Модели демонстрируют нестабильные границы принятия решений, часто сомневаясь при столкновении с потенциальной дезинформацией. Эти колебания приводит к ошибкам, когда задача состоит просто в определении ложности утверждения. Любопытно, что даже незначительные изменения в формулировке приводили к значительному снижению производительности. Когда вопрос звучал как «Действительно ли я верю» вместо просто «Верю ли я», точность резко падала повсеместно. Для модели Llama 3.3 70B добавление слова «действительно» привело к снижению точности с 94,2 % до 63,6 % для ложных убеждений. Это указывает на то, что модели, возможно, полагаются на поверхностное сопоставление образов, а не на глубокое понимание концепций.  Ещё одна трудность связана с рекурсивными знаниями, которые относятся к вложенным уровням осведомлённости, таким как «Джеймс знает, что Мэри знает X». Хотя некоторые модели высшего уровня, такие как Gemini 2 Flash, хорошо справлялись с этими задачами, другие испытывали значительные трудности. Даже когда модели давали правильный ответ, их рассуждения часто были непоследовательными. Иногда они полагались на то, что знание подразумевает истину, а иногда и вовсе игнорировали значимость этих знаний. Большинству моделей не хватало чёткого понимания фактической природы знания. В лингвистике «знать» — это глагол фактического характера, означающий, что нельзя «знать» что-то ложное; можно только верить в это. Модели часто не распознавали это различие. При столкновении с ложными утверждениями о знании они редко выявляли логическое противоречие, вместо этого пытаясь проверить ложное утверждение или отвергая его, не признавая лингвистической ошибки. Эти ограничения имеют существенные последствия для применения ИИ в условиях высокой ответственности. В судебных разбирательствах различие между убеждениями свидетеля и установленным знанием имеет центральное значение для судебных решений. Модель, которая смешивает эти два понятия, может неверно истолковать показания или предоставить ошибочные юридические исследования. Аналогично, в учреждениях психиатрической помощи признание убеждений пациента имеет жизненно важное значение для эмпатии, независимо от того, являются ли эти убеждения фактически точными.  Исследователи отмечают, что сбои БЛМ, вероятно, связаны с обучающими данными, в которых приоритет отдаётся фактической точности и полезности. Модели, по-видимому, имеют «корректирующий» уклон, который мешает им принимать неверные предположения от пользователя, даже когда запрос явно формулирует их как субъективные убеждения. Такое поведение препятствует эффективной коммуникации в сценариях, где в центре внимания находятся субъективные точки зрения. Исследователи пришли к выводу, что пока «модели не в состоянии отличить убеждения пользователя от фактов». Они полагают, что у БЛМ нет хорошей ментальной модели пользователей, поэтому следует быть «очень осторожными при их использовании в более субъективных и личных ситуациях».  Будущие исследования должны быть сосредоточены на том, чтобы помочь моделям отделить понятие истины от понятия убеждения. Исследовательская группа предполагает, что необходимы улучшения, прежде чем эти системы будут полностью внедрены в областях, где понимание субъективного состояния пользователя так же важно, как и знание объективных фактов. Устранение этих эпистемологических «слепых зон» является необходимым условием ответственного развития ИИ. Runway представила свою первую ИИ-модель мира и добавила звук в генератор видео

12.12.2025 [11:18],

Павел Котов

Компания Runway, которая ранее выпускала генераторы изображений и видео, представила модель искусственного интеллекта для генерации виртуальных миров, получившую название GWM-1. Она работает за счёт покадрового прогнозирования, создаёт симуляции с пониманием физики и того, как ведёт себя мир с течением времени.

Источник изображений: Runway Модель мира — это система ИИ, изучающая внутренние симуляции с процессами, которые могут происходить в мире. Она может рассуждать, планировать и осуществлять действия без необходимости в обучении на каждом возможном сценарии в реальной жизни. «Чтобы создать модель мира, нам сначала нужно было разработать по-настоящему качественную модель видео. Мы считаем, что правильный путь к созданию моделей мира — их обучение предсказывать пиксели напрямую, и это лучший способ добиться универсального моделирования. При достаточном масштабе и с правильными данными можно создать модель, которая достаточно хорошо понимает, как работает мир», — рассказал гендиректор Runway Анастасис Германидис (Anastasis Germanidis).  Компания представила три версии новой модели мира: GWM-Worlds, GWM-Robotics и GWM-Avatars. GWM-Worlds — приложение, позволяющее создавать интерактивные проекты. Пользователь задаёт первоначальную сцену по текстовому запросу или образцу на изображении, и по мере исследования пространства модель генерирует мир с учётом геометрии, физики и освещения. Моделирование осуществляется с разрешением 720p и скоростью 24 кадра в секунду. GWM-Worlds может пригодиться в разработке игр, она также подходит для обучения навигационных агентов и агентов действия в реальном мире. GWM-Robotics предназначается для генерации синтетических данных, обогащаемых новыми параметрами, такими как изменения погодных условий или возникновение препятствий. Этот метод поможет выявить, когда и при каких условиях роботы способны нарушать правила с учётом различных сценариев. GWM-Avatars предназначается для создания реалистичных аватаров и имитации человеческого поведения. Сейчас Worlds, Robotics и Avatars работают как отдельные модели, но Runway планирует их объединить.  Компания также сообщила об обновлении своей базовой модели Gen 4.5 — она научилась генерировать встроенный звук и создавать длинные многокадровые ролики. Это могут быть одноминутные клипы с согласованностью персонажей, встроенными диалогами, фоновым звуком и сложными кадрами с разных ракурсов. Можно также редактировать существующий звуковой ряд, добавлять диалоги и изменять многокадровые видеоролики любой длины. Работать с генератором видео Runway Gen 4.5 могут все пользователи платных тарифных планов. GWM-Robotics будет доступна через SDK; ведутся переговоры с партнёрами об интеграции GWM-Robotics и GWM-Avatars для создателей робототехники и других предприятий. Открытые ИИ-модели из Китая захватили почти треть мирового рынка ИИ — и вряд ли остановятся

09.12.2025 [08:44],

Алексей Разин

Соображения экспертов по поводу активного распространения китайских больших языковых моделей с открытым исходным кодом далеко за пределами регионального рынка находят всё больше подтверждений в различных источниках. По некоторым данным, по интенсивности использования такие модели достигли 30 % мирового рынка в этом году.

Источник изображения: Nvidia По информации агрегатора OpenRouter и аналитиков Andreessen Horowitz, на которые ссылается South China Morning Post, китайские большие языковые модели с открытым исходным кодом ещё в конце прошлого года претендовали не более чем на 1,2 % обрабатываемых в мире токенов, но по итогам текущего года она выросла почти до 30 %. При этом запросы при обращении к ИИ-моделям на китайском языке остаются вторыми по частоте после английских. Среди китайских ИИ-моделей лидируют разработки семейства Qwen холдинга Alibaba, DeepSeek V3 и решение Moonshot AI по имени Kimi K2. Оставшиеся 70 % операций с токенами приходятся на закрытые модели западного происхождения, типа тех, что предлагает OpenAI в серии GPT. С начала этого года китайские большие языковые модели с открытым исходным кодом достигли доли в 13 % еженедельного использования токенов, причём во втором полугодии их популярность увеличилась. Языковые модели прочего происхождения по географическому признаку обеспечивают долю 13,7 % на уровне еженедельного использования. В отчёте говорится, что китайские большие языковые модели активно применяются не только внутри страны, но и за её пределами. ИИ-модели готовы признаться в своих грешках, показало исследование OpenAI

05.12.2025 [18:21],

Павел Котов

Исследователи OpenAI в поисках эффективных методов аудита моделей искусственного интеллекта, склонных выдавать нежелательные результаты или пытаться обмануть пользователей, обнаружили, что эти модели вполне способны к признаниям в собственном ненадлежащем поведении.

Источник изображения: Igor Omilaev / unsplash.com В своём исходном значении понятие «признания», конечно, неприменимо к моделям ИИ, которые в действительности представляют собой не более чем сложные статистические алгоритмы. В терминах OpenAI под «признанием» понимается возможность модели оценить свои нежелательные действия, например, галлюцинации в ответах или попытки нарушить условия задачи, чтобы прийти к желаемому результату. «Признание — это [вторичный] ответ, даваемый по запросу после первоначального ответа модели, призванный служить полным отчётом о соответствии модели букве и духу её политик и инструкций», — говорится в статье (PDF) OpenAI. Проще говоря, модели отправляется запрос на получение второго ответа с оценкой первого. Склонность к неподобающему поведению у ИИ формируется на этапе обучения с подкреплением, когда он обнаруживает возможность злоупотреблять механизмами вознаграждения. То есть модель исходит из того, что получит вознаграждение за «признание» и останется безнаказанной за сами нежелательные действия, например, за подхалимство. Эти соображения, как оказалось, подтверждаются на практике. В 11 из 12 проведённых тестов она признавалась минимум в половине случаев, когда действовала вопреки инструкциям. Частота признаний оказалась переменчивой величиной: средняя вероятность получить признание по всем тестам составила 74,3 %. В 4 тестах из 12 этот показатель был выше 90 %, а в 2 из 12 — 50 % или ниже. Вероятность ложноотрицательного ответа, когда модель нарушила правила и не признала своей ошибки, составила лишь 4,4 %; были и ложноположительные, когда модель признавалась в неподобающем поведении, хотя ничего такого не совершала. Когда OpenAI включили сценарий с «признаниями» в механизм обучения модели, качество её ответов не показало существенного ухудшения. С другой стороны, даже «признаваясь» в своих грехах, она стала вести себя не лучше, но хотя бы честнее. То есть «признание» — это не заградительный барьер, а механизм безопасности, который к тому же работает с переменным успехом. Mistral AI сделал заявку на лидерство на рынке открытых моделей, выпустив Mistral 3

03.12.2025 [15:34],

Владимир Мироненко

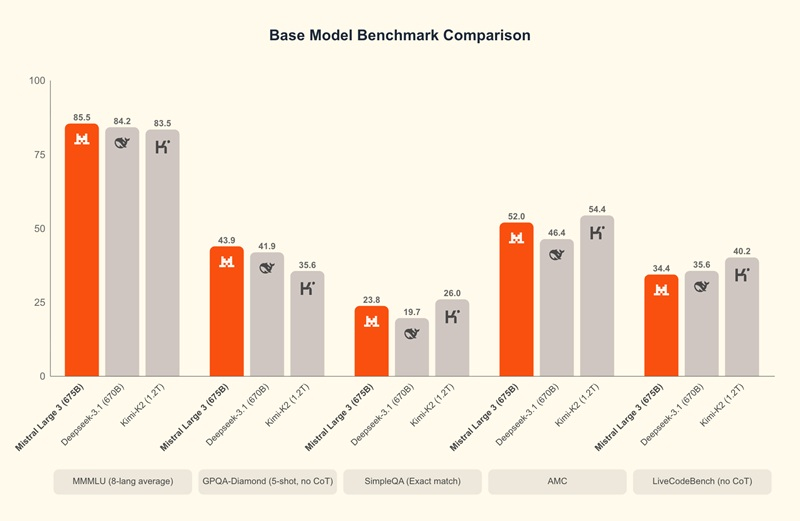

Французский ИИ-стартап Mistral AI представил семейство моделей Mistral 3 следующего поколения с открытыми весами (Open-weight), сделав серьёзную заявку на лидерство в сегменте общедоступных ИИ-моделей, которые обладают рядом преимуществ для корпоративных клиентов по сравнению с решениями крупных технологических компаний.

Источник изображения: Mistral AI Семейство Mistral 3 состоит из 10 моделей, включая большую модель разреженной архитектуры (Mixture of Experts, MoE) с открытыми весами, мультимодальными и многоязычными возможностями — Mistral Large 3. Это самая мощная на сегодняшний день модель компании, обученная с 41 млрд активных и 675 млрд общих параметров. Также в состав семейства входят девять небольших моделей с возможностью автономной работы и полной настройкой, в том числе три современные модели Ministral высокой плотности с 4, 8 и 3 млрд параметров. Модели Mistral обладают лучшим соотношением производительности и стоимости в своей категории. В то же время Mistral Large 3 входит в число передовых моделей с открытым исходным кодом, оптимизированных под тонко настроенные инструкции. Компания указала, что все модели выпускаются по лицензии Apache 2.0, добавив, что открытый исходный код моделей в различных сжатых форматах расширяет возможности сообщества разработчиков и позволяет использовать возможности ИИ благодаря распределённому интеллекту. Как сообщает TechCrunch, стартап Mistral, основанный бывшими сотрудниками DeepMind и Meta✴✴, существует всего два года и на сегодняшний день привлек около $2,7 млрд инвестиций при оценке рыночной стоимости в $13,7 млрд. Это значительно меньше, чему у конкурентов, таких как OpenAI (привлечено $57 млрд при оценке в $500 млрд) и Anthropic (привлечено $45 млрд при оценке в $350 млрд). Mistral утверждает, что больше не всегда значит лучше, особенно для корпоративных сценариев использования ИИ-продуктов. «Наши клиенты иногда рады начать с очень большой [закрытой] модели, которую им не нужно настраивать… но, развернув её, они понимают, что это дорого и медленно, — рассказал ресурсу TechCrunch Гийом Лампле (Guillaume Lample), соучредитель и главный научный сотрудник Mistral. — Затем они обращаются к нам, чтобы мы настроили небольшие модели для более эффективного решения конкретной задачи». По его словам, подавляющее большинство корпоративных сценариев использования ИИ-решений можно реализовать с помощью небольших моделей с тонкой настройкой. Лампле утверждает, что при сравнении с эталонными моделями, когда открытые модели значительно отстают от конкурентов с закрытым исходным кодом, результаты могут быть обманчивы. Он отметил, что большие закрытые модели могут со старта работать лучше, но реальный выигрыш при использовании небольших моделей достигается при настройке. ИИ-модель Alibaba Qwen3-VL способна уловить почти все детали двухчасового видео, лишь раз его «просмотрев»

30.11.2025 [18:32],

Николай Хижняк

Спустя несколько месяцев после запуска Qwen3-VL компания Alibaba опубликовала подробный технический отчёт об открытой мультимодальной модели. Данные показывают, что система превосходно справляется с математическими задачами, связанными с изображениями, и может анализировать многочасовые видеоматериалы.

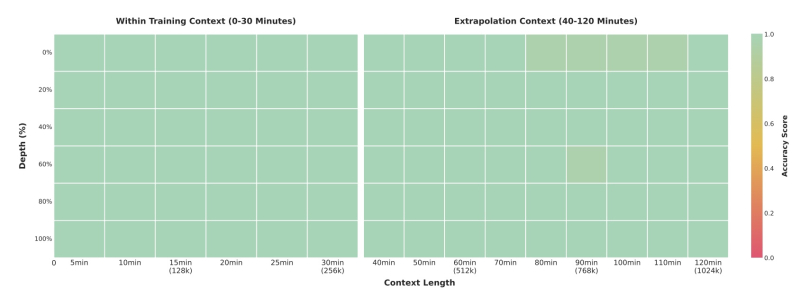

Источник изображений: Alibaba Система справляется с большими объёмами данных, обрабатывая двухчасовые видео или сотни страниц документов в контекстном окне из 256 тыс. токенов. В тестах «иголка в стоге сена» флагманская модель с 235 млрд параметров обнаруживала отдельные кадры в 30-минутных видео со 100-процентной точностью. Даже в двухчасовых видео, содержащих около миллиона токенов, точность сохранялась на уровне 99,5 %. Тест основан на вставке семантически важного кадра-«иглы» в случайные места длинных видео, которые система затем должна найти и проанализировать.

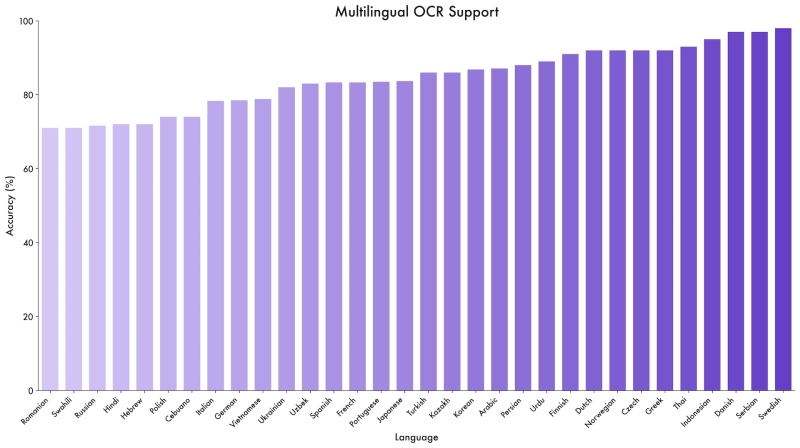

Тест «иголка в стоге сена» измеряет способность модели находить определенные кадры в длинных видеороликах В опубликованных бенчмарках модель Qwen3-VL-235B-A22B часто превосходит Gemini 2.5 Pro, OpenAI GPT-5 и Claude Opus 4.1, даже когда конкуренты используют функции логического мышления или требуют больших затрат на мышление. Модель доминирует в задачах с визуальным математическим анализом, набирая 85,8 % в MathVista по сравнению с 81,3 % у GPT-5. В MathVision она лидирует с 74,6 %, опережая Gemini 2.5 Pro (73,3%) и GPT-5 (65,8%). Модель также демонстрирует широкий диапазон результатов в специализированных бенчмарках. Она набрала 96,5 % в тесте на понимание документов DocVQA и 875 баллов в OCRBench, поддерживая 39 языков — почти в четыре раза больше, чем её предшественник.

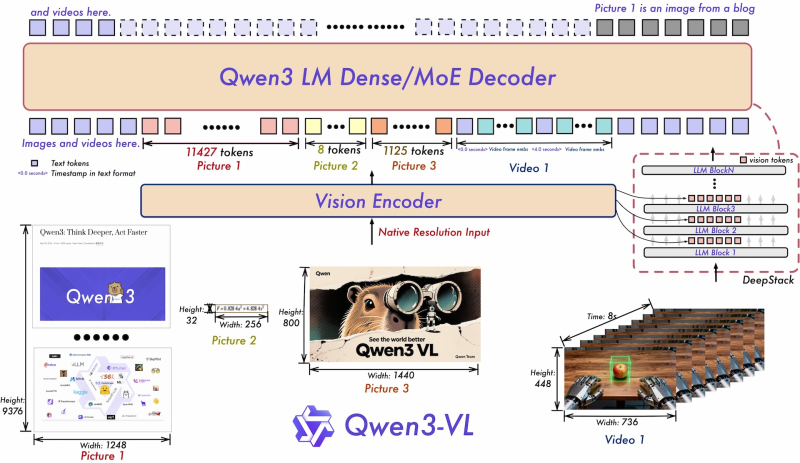

Qwen3-VL достигает точности более 70 процентов при выполнении задач OCR на 32 из 39 поддерживаемых языков Alibaba утверждает, что модель также демонстрирует новые возможности в задачах графического интерфейса. Точность Qwen3-VL-32B в ScreenSpot Pro, тестирующем навигацию в графических пользовательских интерфейсах, составила 61,8 %. В AndroidWorld, где система должна самостоятельно управлять приложениями Android, Qwen3-VL-32B показал результат 63,7 %. Модель также обрабатывает сложные многостраничные PDF-документы. В MMLongBench-Doc она показала результат 56,2 % при анализе длинных документов. В бенчмарке CharXiv для научных диаграмм она достигла 90,5 % при выполнении задач описания и 66,2 % при выполнении сложных логических задач. Однако не во всех случаях Qwen3-VL оказалась лучше конкурентов. В сложном тесте MMMU-Pro модель набрала 69,3 %, уступив GPT-5 с результатом 78,4 %. Коммерческие конкуренты также обычно лидируют в тестах качества видео. Данные свидетельствуют, что Qwen3-VL специализируется на визуальных математических задачах и документах, но всё ещё отстаёт в области общих логических рассуждений. В техническом отчёте описаны три основных архитектурных обновления, реализованных в Qwen3-VL. Во-первых, «interleaved MRoPE» заменяет предыдущий метод позиционного встраивания. Вместо группировки математических представлений по размерности (время, горизонталь, вертикаль), новый подход равномерно распределяет их по всем доступным математическим областям. Это изменение направлено на повышение производительности при работе с длинными видео. Во-вторых, технология DeepStack позволяет модели получать доступ к промежуточным результатам видеокодера, а не только к конечному результату. Это предоставляет системе доступ к визуальной информации с разной степенью детализации. В-третьих, система временных меток на основе текста заменяет сложный метод T-RoPE, используемый в Qwen2.5-VL. Вместо того, чтобы присваивать математическую временную позицию каждому видеокадру, система теперь вставляет простые текстовые маркеры, например, «<3,8 секунды>», непосредственно во входные данные. Это упрощает процесс и улучшает понимание моделью задач, связанных с анализом видео с временными рамками.

Qwen3-VL объединяет видеокодер и языковую модель для одновременной обработки текста, изображений и видео. DeepStack использует визуальную информацию с разных уровней обработки Alibaba обучала модель в четыре этапа на базе 10 тыс. графических процессоров. После обучения связыванию изображений и текста система прошла полное мультимодальное обучение примерно на триллионе токенов. Источниками данных были веб-скрапы, 3 млн PDF-файлов из Common Crawl и более 60 млн STEM-задач. На последующих этапах команда постепенно расширяла контекстное окно с 8000 до 32 000 и, наконец, до 262 000 токенов. Варианты Thinking прошли специальное обучение Chain-of-thought training, что позволило им генерировать промежуточные шаги рассуждения перед предоставлением окончательного ответа для достижения лучших результатов при решении сложных задач. Все модели Qwen3-VL, выпущенные с сентября, доступны по лицензии Apache 2.0 с открытыми весами на Hugging Face. Линейка включает плотные варианты с параметрами от 2B до 32B, а также модели со смесью экспертов 30B-A3B и массивные 235B-A22B. Хотя такие функции, как извлечение кадров из длинных видео, не являются новыми (в начале 2024 года Google Gemini 1.5 Pro уже реализовал эту функцию), Qwen3-VL предлагает конкурентоспособную производительность. Поскольку предыдущая модель Qwen2.5-VL уже широко применялась в исследованиях, новая модель, вероятно, станет стимулом для дальнейшей разработки ПО с открытым исходным кодом. ИИ-модель DeepseekMath-V2 достигла уровня золотой медали на Международной математической олимпиаде

29.11.2025 [13:22],

Владимир Фетисов

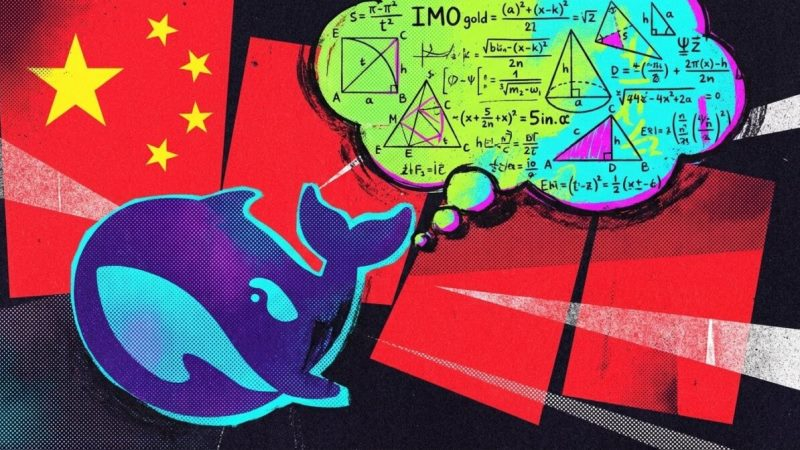

Китайский стартап DeepSeek представил новую ИИ-модель DeepseekMath-V2, которая показывает впечатляющие результаты при решении сложных математических задач. Алгоритм справился с многими заданиями Международной математической олимпиады (IMO 2025) и Китайской математической олимпиады (CMO 2024), показав при этом результат на уровене золотой медали.

Источник изображений: the-decoder.com В сообщении сказано, что DeepseekMath-V2 набрала 118 из 120 баллов в задачах Putnam, что существенно выше лучшего результата человека в 90 баллов. DeepSeek отмечает, что ранее ИИ-модели часто выдавали верные ответы в сложных математических задачах, но при этом не показывали правильного хода решения. Для исправления ситуации ИИ-модель задействует многоэтапный процесс с отдельным верификатором для оценки корректности шагов решения задачи и необходимости их перепроверки. Такая структура позволяет алгоритму проверять и совершенствовать свои решения в режиме реального времени. С технической стороны DeepseekMath-V2 построена на основе базовой модели Deepseek-V3.2-Exp-Base. В описании DeepSeek ни разу не упоминается использование внешних инструментов, таких как калькуляторы или интерпретаторы кода. В ключевых экспериментах одна и та же модель DeepseekMath-V2 используется как для генерации доказательств, так и для их проверки. Высокая производительность алгоритма обусловлена способностью подвергать критике и улучшать собственные выводы вместо того, чтобы задействовать внешнее программное обеспечение. Для решения более сложных задач модель наращивает вычислительные мощности на этапе тестирования, параллельно создавая и проверяя множество возможных доказательств, чтобы повысить уровень уверенности в правильности конечного ответа. Релиз DeepSeek последовал за анонсом ещё не выпущенных ИИ-моделей OpenAI и Google Deepmind, которые достигли схожих результатов в решении сложных математических задач. Примечательно, что эти алгоритмы достигли такого результата за счёт способности к рассуждению, а не целевой оптимизации для математических олимпиад. Если на деле успехи этих алгоритмов действительно окажутся столь впечатляющими, то это будет означать, что языковые модели приблизились к моменту, когда они смогут решать сложные, абстрактные задачи, что традиционно считалось исключительно человеческим навыком. Отметим, что решение DeepSeek раскрыть технические детали модели DeepseekMath-V2 резко контрастирует с секретностью, которую соблюдают Google и OpenAI. Американские компании держат в тайне подробности об архитектуре собственных ИИ-моделей, тогда как китайский стартап буквально раскрывает все карты, наглядно показывая, что компания идёт вровень с ведущими отраслевыми представителями. Практическое использование ИИ в работе остаётся весьма неравномерным

29.11.2025 [08:07],

Алексей Разин

Пока разработчики систем ИИ рисуют красочные картины светлого будущего, практическое внедрение таких решений осуществляется неравномерно и беспорядочно. Во многом такие перекосы можно было бы устранить благодаря более грамотному руководству бизнесом и обучению персонала новым приёмам работы, как считают эксперты.

Источник изображений: Intel Издание The Wall Street Journal в своей пятничной публикации обратилось к этой теме, проанализировав отчёты сразу нескольких исследователей. Социологических исследований на тему практической пользы от внедрения ИИ пока не так много, поскольку бизнес принимает подобные технологические инструменты на вооружение с предсказуемой инерцией. Новые исследования указывают, что внедрение ИИ на практическом уровне происходит весьма неравномерно. Не во всех компаниях, например, самыми активными пользователями ИИ являются те сотрудники, которым оно должно приносить максимальную выгоду. В частности, наиболее опытные сотрудники теоретически способны более продуктивно общаться с ИИ, выявляя ошибочные результаты в силу своего опыта, но в действительности они не торопятся это делать. Исследование Workhelix, которое проводилось внутри фармацевтической компании с более чем 50 000 сотрудников, показало довольно спорные результаты. Выяснилось, что чаще всего к использованию ИИ прибегают стажёры, а не сотрудники с опытом. Молодые сотрудники более склонны к экспериментам, хотя и в этом случае возраст не является критерием, поскольку среди них имеются явные противники ИИ. Скорее, склонность к взаимодействию с ИИ определяется готовностью специалиста к экспериментам, и от возраста она не особо зависит. В конкретной фармацевтической компании второй группой активных пользователей ИИ оказались профессиональные исследователи, что вполне закономерно, поскольку они в своей ежедневной деятельности связаны с экспериментами и поиском новых технологий. Важным фактором эффективности использования ИИ является и одобрение руководства компаний, а также обучающие программы для персонала. Аналитики McKinsey обнаружили, что примерно две трети компаний ограничиваются экспериментами по использованию ИИ в своей деятельности, и только одна из двадцати может похвастать высокой эффективностью его применения, когда ИИ обеспечивает более чем 5 % дохода. Даже в том случае, когда работодатель создаёт равные условия для доступа сотрудников к ИИ-инструментам, перестроить под новые условия все процессы удаётся далеко не сразу. И чем больше людей задействовано в цепочке, тем сложнее внедрить ИИ.  История внедрения персональных компьютеров в середине восьмидесятых годов прошлого века показала, что прогрессивные технологии повышают эффективность бизнеса лишь через несколько лет, а на первых порах производительность может даже страдать. Обучение персонала и перестройка бизнес-процессов может потребовать годы, прежде чем внедрение ИИ начнёт приносить плоды. Человечество уже прошло через несколько волн технологической революции. Сначала это были персональные компьютеры, потом появился интернет, затем облачные сервисы, а также мобильные устройства. Руководство компаний должно играть весомую роль в продвижении этих новшеств. Июльское исследование Microsoft Research показало, что самые подверженные внедрению ИИ профессии подразумевают написание текстов или кода, либо проведение исследований. У молодых сотрудников при этом больше мотивации использовать ИИ в своей работе, поскольку они тем самым могут доказать свою эффективность руководству и продвинуться по служебной лестнице. Игнорирующие развитие ИИ профессионалы рано или поздно должны будут либо научиться его использовать, либо покинуть рынок труда. По сути, не ИИ лишает людей работы, их место просто могут занять другие специалисты, которые могут его эффективно применять. Сооснователь OpenAI Илья Суцкевер предупредил, что развитие ИИ экстенсивным методом себя изжило

27.11.2025 [06:56],

Алексей Разин

Судя по активности участников рынка ИИ, они сейчас сосредоточены на том, чтобы наращивать вычислительные мощности, рассчитывая, что на определённом этапе количество перейдёт в качество. Один из основателей OpenAI Илья Суцкевер убеждён, что эпоха масштабирования заканчивается, и для качественного прогресса в развитии ИИ потребуются серьёзные и глубокие исследования.

Источник изображения: University of Toronto Entrepreneurship В OpenAI Илья как раз отвечал за исследования, и уйти из этого стартапа его заставил не только конфликт вокруг несостоявшейся отставки генерального директора Сэма Альтмана (Sam Altman), но и несогласие со стратегией развития компании. Как стало понятно из недавнего интервью Ильи Суцкевера, его настораживает сохраняющаяся ориентация отрасли ИИ на экстенсивный путь развития. Большие языковые модели до сих пор совершенствовались благодаря привлечению большего количества данных, вычислительных ресурсов или увеличению количества параметров внутри самой модели. Для участников рынка такой подход был удобен, поскольку обеспечивал понятный результат при минимальных рисках и неопределённости. Большое количество квалифицированных и талантливых исследователей при этом не требовалось, поскольку прогресс достигался увеличением количества используемых ресурсов. По мнению Суцкевера, такой путь развития скоро себя исчерпает. Во многом это произойдёт из-за истощения запаса данных, которые пригодны для обучения языковых моделей. Вся информация, доступная в интернете, уже использована для обучения ИИ. Как убеждён Суцкевер, даже дальнейшее увеличение масштаба имеющейся инфраструктуры в сто раз не обеспечит качественного прорыва в развитии ИИ. Да, в чём-то будут заметны изменения к лучшему, но так называемый «сильный искусственный интеллект» (AGI) таким способом создан не будет. По мнению основателя Safe Superintelligence, человечество будет вынуждено вернуться в эпоху исследований, получив мощные новые инструменты, помогающие учёным в работе. Его стартап как раз занимается подобными исследованиями, как становится ясно из интервью. Попутно Суцкевер делает важное пояснение. По его мнению, большие языковые модели обобщают знания гораздо хуже людей. Например, если молодого исследователя старший коллега обучает на примере своих работ, делая какие-то пояснения и совместно обсуждая идеи, то для обучения модели требуется создать точный план, где на каждом этапе будет проверяться достижение строго формализованных результатов, а для обучения будут использоваться огромные массивы данных с примерами. И даже в этом случае человек продемонстрирует более высокие результаты обучения, чем ИИ. Как сократить эту разницу, научное сообщество пока не знает. Продажи Tesla рушатся по всему миру — Маск увлёкся роботами, а стоило бы новыми машинами

26.11.2025 [19:04],

Сергей Сурабекянц

Tesla столкнулась с падением продаж на всех трёх крупнейших мировых автомобильных рынках: Европе, Китае и США. Мировые поставки автомобилей Tesla в этом году сократятся на 7 %. Не помогли даже рекордные продажи в третьем квартале, перед окончанием срока действия в США налогового вычета для покупателей электромобилей 30 сентября. Аналитики заявляют о фундаментальных проблемах у автопроизводителя и не ожидают быстрого восстановления после этого спада продаж.

Источник изображений: Tesla, SpaceX Согласно данным Европейской ассоциации автопроизводителей, продажи электромобилей Tesla в Европе упали на 48,5 % в октябре по сравнению с аналогичным месяцем прошлого года. За год продажи Tesla в регионе снизились примерно на 30 %, в то время как общеотраслевые продажи электромобилей выросли на 26 %. Ещё в 2023 году Tesla Model Y был самым продаваемым автомобилем в мире. В конце прошлого года компания планировала повысить продажи в 2025 году на 20–30 %. Однако в итоге продажи Tesla снизились, поскольку конкуренты представили широкий спектр улучшенных электромобилей — часто по более низким ценам, — в то время как модельный ряд Tesla утратил актуальность. Проблемы Tesla наиболее остро ощущаются в Европе, где более десятка электрических моделей продаются по цене менее $30 000. В Европу хлынула волна китайских брендов с ошеломляющим (хоть порой и спорным) дизайном. Tesla в Европе предлагает всего две модели для массового рынка: Model 3 и Model Y. Недавно представленная для стимулирования продаж упрощённая и более дешёвая версия Model Y ситуацию не изменила.  Тем временем электромобили других производителей становятся всё более популярными. В Великобритании представлено более 150 электромобилей различных брендов, включая множество новых китайских конкурентов. По данным сайта Electrifying.com, посвящённого приобретению и эксплуатации электромобилей, в следующем году ожидается выпуск не менее 50 новых электромобилей, «из которых ни один не Tesla». В Европе китайская компания BYD продала в октябре 17 470 автомобилей, что более чем вдвое превышает продажи Tesla. Представитель Volkswagen заявил о резком снижении доминирования Tesla на европейском рынке электромобилей. По мнению экспертов, проблема Tesla не только в устаревшей модельной линейке и конкуренции со стороны китайских брендов, но и в том, что «европейцы её догнали». В Китае продажи и доля рынка Tesla также снижаются, хотя и не так резко, как в Европе. Поставки Tesla в Китай в октябре упали до трёхлетнего минимума, сократившись на 35,8 %. За год продажи Tesla в Китае снизились на 8,4 % по состоянию на октябрь. Tesla сталкивается с рядом обновлённых китайских брендов, таких как Chery, а также с новичками, включая Xiaomi, чей YU7 составил уверенную конкуренцию Model Y.

Источник изображения: Xiaomi Зафиксированный в США скачок продаж Tesla на 18 % в сентябре объясняется ажиотажем среди покупателей, которые стремились приобрести электромобиль до 30 сентября — окончания срока действия налогового вычета в размере $7500. Зато в октябре падение составило 24 % и может продолжиться в ближайшие месяцы, так как аналитики не ожидают положительной динамики на рынке электромобилей. Продажи Tesla могут немного вырасти на фоне сокращения выпуска электромобилей и снижения инвестиций в отрасль со стороны нескольких традиционных автопроизводителей, включая General Motors, Ford и Honda. Кроме того, недавний запуск новых версий Model Y и Model 3 со сниженной на $5000 ценой может способствовать увеличению доли рынка. Большинство экспертов уверены, что Tesla для оживления продаж необходим совершенно новый автомобиль. Однако пока никаких признаков разработки новой модели для водителей-людей не наблюдается, поскольку глава Tesla Илон Маск (Elon Musk) сосредоточился на беспилотных роботакси и гуманоидных роботах. Политическая активность Маска также не идёт на пользу компании.  Новый пакет оплаты труда самого Маска не предполагает значительного роста продаж. Он получит многомиллиардное вознаграждение, если в течение следующего десятилетия акции компании вырастут в цене, а продажи составят в среднем 1,2 миллиона автомобилей в год, что почти на полмиллиона меньше, чем компания продала в 2024 году. Учёные обнаружили, что у ИИ пока имеются проблемы с пониманием каламбуров и юмора

26.11.2025 [04:37],

Алексей Разин

Общение человека с большими языковыми моделями может быть вполне гармоничным и естественным до тех пор, пока искусственный интеллект не столкнётся с тонким юмором и двойным смыслом, заложенным в каламбуры. К такому выводу пришли в своём исследовании британские и итальянские исследователи, на доклад которых ссылается издание The Guardian.

Источник изображения: Freepik Авторы исследования, по данным источника, обнаружили способность больших языковых моделей выявлять структуру каламбура, но с пониманием смысла у них возникают проблемы. Например, при замене ключевого слова в каламбуре, которая в восприятии человека лишает высказывание юмора, большие языковые модели продолжают считать фразу шуткой. В качестве примера приводилась такая фраза: «Длинные сказки имеют тенденцию к дракону» (Long fairy tales have a tendency to dragon). В этом случае последнее слово звучит идентично с глаголом «drag on» — затягиваться, и именно эта двойственность смысла лежит в основе каламбура. Если авторы эксперимента меняли «dragon» на синонимичный глагол «prolong» или вообще любое другое произвольное слово, ИИ всё равно считал, что результирующая фраза является шуткой. Как пояснил один из авторов исследования, большие языковые модели запоминают то, что они узнали в процессе обучения. В случае с юмором они запоминают известные им каламбуры, но это вовсе не означает, что они до конца понимают их суть. Замена ключевых слов в шутках, которая начисто лишает их юмора, в восприятии ИИ не является радикальной трансформацией, и он продолжает считать, что имеет дело с каламбуром. Пока большие языковые модели просто неспособны по-настоящему понимать юмор, как резюмируют исследователи. Фактически, когда ИИ сталкивается с незнакомой игрой слов, выявить наличие каламбура в анализируемой фразе он способен лишь в 20 % случаев. По словам авторов доклада, пока людям следует с осторожностью использовать большие языковые модели в сферах, которые требуют понимания юмора, эмпатии и понимания культурных нюансов. Уверенность в том, что ИИ способен понимать юмор, является не более чем иллюзией. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |