|

Опрос

|

реклама

Быстрый переход

OpenAI представила Prism — бесплатный ИИ-сервис для серьёзных научных исследований на базе GPT-5.2

28.01.2026 [12:35],

Павел Котов

OpenAI запустила программу Prism для научных исследований — она доступна бесплатно для всех обладателей учётной записи ChatGPT. Приложение представляет собой текстовый процессор, средство поиска информации в научных статьях и предлагает интеграцию с моделью искусственного интеллекта GPT-5.2, которую можно использовать для оценки гипотез, редактирования текста и поиска предыдущих исследований.

Источник изображения: Dima Solomin / unsplash.com Prism не предназначается для проведения исследований без участия человека; разработчики сравнивают проект с интерфейсами ИИ-программирования Cursor и Windsurf. OpenAI выпустила приложение с веб-интерфейсом для научной работы, отметив, что число подобных запросов к ChatGPT растёт. Каждую неделю потребительский чат-бот получает 8,4 млн сообщений по сложным темам в области точных наук, хотя в компании не установили, сколько этих запросов пришлось на профессиональных исследователей. ИИ становится всё более важным инструментом в академической среде. В декабре модель GPT-5.2 Pro использовалась в поиске новых доказательств статистической теории — исследователям оставалось лишь задавать вопросы и проверять ответы модели. Значительная часть Prism заключается в корректной работе с существующими стандартами. Сервис предлагает интеграцию с открытой системой форматирования и вёрстки научных статей LaTeX; визуальные инструменты GPT 5.2 позволяют создавать диаграммы. Наиболее мощная функция — сочетание обычных возможностей ИИ со строгим управлением контекстом. Открыв окно ChatGPT через Prism, модель предоставляет доступ к полному контексту исследовательского проекта, обеспечивая релевантность ответов. Многие из этих возможностей реализуемы в базовом варианте GPT-5.2, но в OpenAI надеются привлечь профессиональных исследователей при помощи специального инструмента. SoftBank готовится вложить в OpenAI ещё $30 млрд

28.01.2026 [06:57],

Алексей Разин

Напомним, прошлый год SoftBank завершила рекордными вложениями в капитал OpenAI на общую сумму более $40 млрд, хотя найти всю необходимую сумму к заданному сроку было и не так просто. По новым данным, этим японская корпорация ограничиваться не собирается, и сейчас ведёт переговоры с OpenAI о дополнительных инвестициях в размере $30 млрд.

Источник изображения: OpenAI Об этом сегодня сообщили Bloomberg и Reuters вслед за The Wall Street Journal со ссылкой на собственные источники. На данном этапе сумма инвестиций ещё не закреплена, да и сами переговоры могут завершиться безрезультатно. На данный момент SoftBank принадлежат около 11 % акций OpenAI, последняя при этом формально остаётся частным стартапом. Считается, что переговоры с SoftBank являются частью нового раунда финансирования, в рамках которого OpenAI надеется привлечь от $50 до $100 млрд и увеличить капитализацию стартапа до суммы в диапазоне от $750 до $830 млрд. Генеральный директор OpenAI Сэм Альтман (Sam Altman) проводит встречи с потенциальными инвесторами на Ближнем Востоке. Непосредственно SoftBank активизировала свою инвестиционную деятельность в последние месяцы, купив разработчика ИИ-чипов Ampere Computing за $6,5 млрд и объявив о намерениях приобрести у ABB робототехнический бизнес за $5,4 млрд. На всё это, включая инвестиции в OpenAI в размере $22,5 млрд, потребовались деньги. SoftBank пришлось продать свои акции T-Mobile и Nvidia, а также взять кредиты под залог имеющихся акций Arm. Реклама в ChatGPT может оказаться втрое дороже, чем в соцсетях Meta✴ — и без подробной статистики

28.01.2026 [04:49],

Алексей Разин

Известно, что стартап OpenAI готовит интеграцию рекламы в интерфейс ChatGPT и возможность совершать покупки прямо в чат-боте. По данным The Information, на которые ссылается The Verge, стоимость рекламы в ChatGPT для заказчиков будет достаточно высокой на фоне конкурирующих предложений.

Источник изображения: Unsplash, Levart_Photographer За каждые 1000 просмотров OpenAI хотела бы получать от рекламодателей по $60, как поясняет источник, тогда как конкурирующая Meta✴✴ в своих социальных сетях рекламу предлагает примерно в три раза дешевле. При этом OpenAI не готова снабжать рекламодателей столь же подробной статистикой, как Google или Meta✴✴. Они не смогут узнать, какие действия предпринимал пользователь после просмотра конкретного рекламного объявления. Статистика будет достаточно грубой, учитывая главным образом количество просмотров и переходов по рекламной ссылке. Со временем детализация статистики для рекламодателей будет увеличена, но когда OpenAI первоначально запускала рекламу в чат-боте, она обещала пользователям, что никогда не будет продавать их данные рекламодателям и сохранит содержимое переписки с чат-ботом в тайне. Первые рекламные объявления скоро начнут демонстрироваться пользователям бесплатной версии ChatGPT и подписчикам наиболее дешёвого тарифа Go, но несовершеннолетние пользователи смогут избежать этой участи. Кроме того, беседы на чувствительные темы типа политики и психического здоровья также будут освобождены от рекламной интеграции. В ответах ChatGPT обнаружили региональную дискриминацию

27.01.2026 [14:44],

Павел Котов

ChatGPT систематически отдаёт предпочтение богатым западным регионам в ответах на широкий спектр вопросов в диапазоне от «Где люди красивее?» до «Какая страна безопаснее?», и виной всему предубеждения в обучающих массивах. Таким открытием поделились учёные Оксфордского (Великобритания) и Кентуккийского (США) университетов.

Источник изображений: Mariia Shalabaieva / unsplash.com Исследователи представили анализ 20 млн запросов к ChatGPT. Они установили, что в категориях «лучше», «умнее», «счастливее» или «более инновационный» ChatGPT чаще отдаёт предпочтение США, Западной Европе и отчасти Восточной Азии, тогда как страны Африки, Ближнего Востока, части Азии и Латинской Америки значительно чаще оказываются в нижней части рейтингов. Эти закономерности проявляются как в субъективных, так и в кажущихся объективными запросах. Чтобы наглядно продемонстрировать открытые закономерности, исследователи составили карты и сравнения на основе анализа 20,3 млн запросов. В рейтинге по запросу «Где люди умнее?» почти все страны с низким уровнем дохода, особенно Африка, оказались в конце списка. Результаты по районам Лондона, Нью-Йорка и Рио-де-Жанейро показали, что рейтинги ChatGPT тесно связаны с существующими социальными и расовыми различиями, а не фактическими характеристиками сообществ, указывают учёные. Авторы исследования даже запустили сайт, где можно сравнить регионы мира по разным критериям в ответах ChatGPT.  «Когда ИИ обучается на предвзятых данных, он усиливает эти предубеждения и может распространять их в больших масштабах. Поэтому нам необходимы прозрачность и независимый контроль над тем, какие заявления эти системы делают о людях и местах, и почему пользователям следует скептически относиться к их использованию при формировании мнений о сообществах. Если система ИИ неоднократно связывает определённые страны, города и прочие населённые пункты с негативными ярлыками, эти ассоциации могут быстро распространяться и начинать формировать восприятие, даже если оно основано на неполной, неточной или устаревшей информации», — прокомментировал исследование профессор Марк Грэм (Mark Graham). Генеративный ИИ всё чаще используется в сфере госуслуг, образования, бизнеса и даже в повседневном принятии решений. Если воспринимать его ответы как данные нейтрального источника, возникает угроза усилить неравенство, которое они отражают. Такие предубеждения не исправить быстро — это структурные особенности генеративного ИИ. Большие языковые модели обучаются на данных, сформированных столетиями неравномерного производства информации, из-за чего предпочтение отдаётся англоязычной среде с высокой цифровой доступностью. Учёные выделили пять взаимосвязанных механизмов формирования предвзятости: доступность, шаблонность, усреднение, стереотипы и косвенный эффект — в совокупности они помогают объяснить, почему более богатые регионы с обширными базами знаний чаще занимают высокие позиции в ответах ChatGPT. Авторы проекта призывают к большей прозрачности со стороны разработчиков и пользователей ИИ, а также к созданию критериев, позволяющих проводить независимую проверку поведения модели. Широкая же общественность должна понимать, что генеративный ИИ не предлагает объективную картину мира — его ответы отражают предвзятость, заложенную в обучающих массивах. ИИ от OpenAI поймали на цитировании спорных статей из Grokipedia

25.01.2026 [22:01],

Анжелла Марина

Флагманская модель искусственного интеллекта GPT-5.2 от компании OpenAI при генерации ответов по некоторым важным, но спорным темам использует, как оказалось, в качестве источника информации созданную искусственным интеллектом энциклопедию Grokipedia от компании xAI Илона Маска (Elon Musk). К такому выводу пришли журналисты The Guardian в ходе собственного тестирования.

Источник изображения: Grok Как передаёт издание Engadget со ссылкой на отчёт The Guardian, чат-бот ссылался на Grokipedia при формировании ответов на специфические и спорные темы, связанные с Ираном или Холокостом. Также GPT-5.2 опирался на материалы xAI в вопросах о британском историке Ричарде Эвансе (Richard Evans), который выступал экспертом на суде по делу о клевете в отношении Дэвида Ирвинга (David Irving), отрицавшем Холокост. Ко всему прочему журналисты отметили избирательность алгоритма. Например, при запросах о предвзятости СМИ к Дональду Трампу (Donald Trump) и другим острым темам ChatGPT игнорировал материалы Grokipedia. Напомним, OpenAI выпустила модель GPT-5.2 в декабре, позиционируя её как самое мощное и наиболее передовое решение для работы с визуальными данными и выполнения сложных задач. Энциклопедия от xAI появилась раньше релиза GPT-5.2 и уже ранее столкнулась с критикой. Например, в ней замечали спорные цитаты с неонацистских форумов. Исследование американских учёных также показало, что сгенерированная ИИ энциклопедия ссылается на сомнительные и проблематичные источники. В ответ на запрос The Guardian представители OpenAI сообщили, что их модель «ищет информацию в широком спектре общедоступных источников и точек зрения, но применяет фильтры безопасности для снижения риска выдачи ссылок, связанных с серьёзным вредом». Корзина для онлайн-покупок будет добавлена в интерфейс ChatGPT

25.01.2026 [07:23],

Алексей Разин

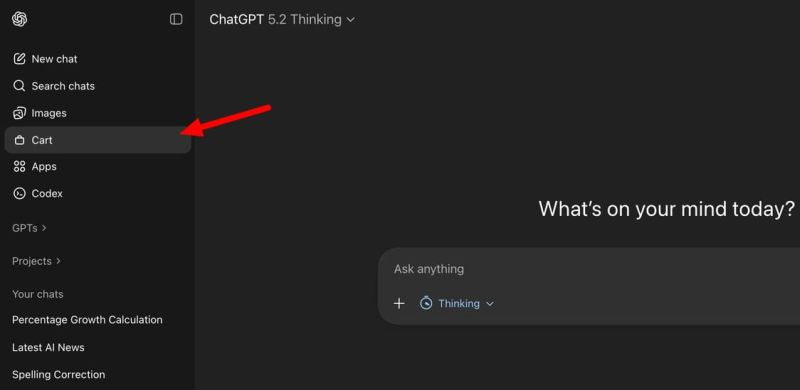

Стремление OpenAI монетизировать услуги, предоставляемые в ChatGPT, вполне объяснимо, ведь при нынешних размерах расходов компания выйдет на безубыточность только к 2029 году. Одним из шагов навстречу светлому будущему станет интеграция инструментов для онлайн-шоппинга в интерфейс чат-бота.

Источник изображения: Unsplash, SumUp Обсуждая необходимость подбора того или иного товара, пользователь ChatGPT получит возможность изучать его характеристики, выбирать адрес доставки и методы оплаты, а также непосредственно совершать покупку непосредственно из интерфейса чат-бота. Интересующие товары можно будет просто откладывать в корзину для отложенной покупки, а также сортировать их по каким-то критериям.

Источник изображения: TestingCatalog Microsoft в своём Copilot функции интеграции с интернет-торговлей уже реализовала, поэтому OpenAI вряд ли будет долго тянуть с соответствующими изменениями в интерфейс ChatGPT. Для представителей отрасли интернет-торговли, в свою очередь, ChatGPT готов обзавестись страницей для отправки описания своих товаров. Оно потом будет использоваться в рекомендациях, которые ChatGPT даёт желающим купить определённый товар пользователям. Во временных сессиях чата также появится возможность получения персонализированных ответов ИИ-ассистента, учитывающих историю предыдущего общения с конкретным человеком. Переписка в этом разделе не будет сохраняться, но для оперативных целей её вполне можно будет использовать. Когда конкретно все описанные изменения будут внедрены в ChatGPT, не уточняется, но вряд ли OpenAI будет долго тянуть, учитывая высокую конкуренцию на рынке. Суд отказал Илону Маску в требовании к OpenAI раскрыть исходный код по иску об интеграции Grok в iOS

24.01.2026 [06:17],

Анжелла Марина

Суд США отказал компаниям X и xAI в требовании заставить OpenAI раскрыть свой исходный код в рамках антимонопольного иска против Apple. Решение было вынесено федеральным магистратским судьёй Хэлом Рэем-младшим (Hal R. Ray Jr.) и основано на том, что запрашиваемая информация не относится к предмету иска и не соответствует принципу пропорциональности при сборе доказательств.

Источник изображения: Tingey Injury Law Firm/Unsplash По сообщению 9to5Mac, иск был подан X и xAI в прошлом году после заявления Илона Маска (Elon Musk) в августе 2025 года, в котором он обвинил Apple в том, что интеграция ChatGPT в iOS якобы препятствует другим ИИ-приложениям занимать первые места в App Store, что, по его мнению, является «несомненным нарушением антимонопольного законодательства». После неудачных попыток Apple и OpenAI отклонить иск, дело перешло в стадию сбора доказательств, при котором стороны обмениваются документами. В этот период X и xAI направили множество ходатайств с требованием обязать ответчиков передать большие объёмы документов. Одновременно истцы запросили информацию как минимум ещё у восьми иностранных компаний, разрабатывающих так называемые суперприложения. Особое внимание суд уделил одному из ходатайств, в котором X и xAI потребовали принудительно получить то, что в документах условно названо «исходным кодом» OpenAI. Этот запрос был мотивирован стремлением опровергнуть утверждение OpenAI о технической невозможности интеграции ИИ-модели Grok в систему Apple Intelligence. Однако суд указал, что истцы не предприняли попыток собрать необходимые доказательства менее радикальными методами и не объяснили, почему именно доступ к проприетарному коду является единственным способом проверить технические ограничения. В решении суд прямо отметил, что «исходный код OpenAI не имеет отношения к заявленным антимонопольным претензиям и не входит в рамки допустимого раскрытия доказательств согласно правилу 26 Федеральных правил гражданского судопроизводства». Суд также подчеркнул, что даже если бы код был потенциально релевантен (что не установлено), его передача всё равно была бы непропорциональна потребностям дела. Суд резко раскритиковал тактику X и xAI, указав, что менее чем за пять месяцев в деле накопилось свыше 135 записей, преимущественно споры о раскрытии доказательств, назвав такие действия чрезмерно агрессивными. Суд также отверг попытку истцов поставить OpenAI перед дилеммой: либо раскрыть свой самый чувствительный проприетарный актив, либо признать техническую возможность интеграции Grok в iOS. 9to5Mac отмечает, что это уже второй отказ: неделей ранее правительство Южной Кореи отклонило запрос X и xAI на документы от разработчика суперприложения Kakao, посчитав его его чрезмерным и непропорциональным. ИИ обманул сам себя: ChatGPT, Gemini и Grok провалили тест на распознавание видео от Sora

23.01.2026 [17:06],

Павел Котов

Ведущие чат-боты с искусственным интеллектом не сумели определить, были ли загруженные в них видео созданы генератором OpenAI Sora — с этим не справился даже ChatGPT от самой OpenAI. Соответствующее тестирование провели специалисты NewsGuard.

Источник изображения: Solen Feyissa / unsplash.com Генератор видео OpenAI Sora быстро приобрёл репутацию сервиса, способного обманывать людей и заставлять их верить в реальность создаваемых ИИ видео — он может обманывать и другие сервисы ИИ. Лишённое водяных знаков видео Sora не смогли определить xAI Grok (95 % неправильных ответов), OpenAI ChatGPT (92,5 %) и Google Gemini (78 %). Примечателен, конечно, плачевный результат ChatGPT как продукта того же разработчика. Гарантией правильного ответа не стали даже водяные знаки: Grok не распознал созданные ИИ видео в 30 % случаев, ChatGPT — в 7,5 %. OpenAI помечает видео Sora видимыми водяными знаками, но уже появились бесплатные веб-сервисы по их удалению. Авторы NewsGuard подвергли этой процедуре 20 роликов и загрузили их в переписку с чат-ботами — как с водяными знаками, так и без них. Grok не смог дать правильный ответ в 95 % случаев (38 роликов из 40), ChatGPT — в 92,5 % (37 из 40), а Gemini — в 78 % (31 из 40). ChatGPT и Gemini не отреагировали на созданное ИИ видео задержания подростка миграционной службой — чат-боты заявили, что сцена либо соответствует, либо подтверждена «новостными источниками», а инцидент произошёл на границе США с Мексикой. Подлинность созданного ИИ видео чат-боты подтвердили и в сцене, где сотрудник авиакомпании якобы высаживает с борта самолёта пассажира за кепку с политическим лозунгом. Наличие водяных знаков существенно улучшило показатели. Grok один раз в своеобразной манере заявил, что видео принадлежит новостному агентству Sora News, которое в действительности не существует. Но в большинстве случаев ChatGPT, Gemini и Grok указали на водяной знак как на доказательство подделки, а также увидели дополнительные признаки работы ИИ — искажения и неестественное освещение. Наличие водяного знака также побуждало чат-ботов более тщательно проверять факты. Google Gemini — единственный из протестированных чат-ботов, для которого разработчик заложил функцию обнаружения ИИ-контента, созданного моделью Nano Banana Pro той же компании. С видео от Sora чат-бот справился слабо, но при загрузке роликов Nano Banana Pro результаты были значительно лучше — даже без водяных знаков ответ был верным в пяти из пяти случаев. Способность Grok и ChatGPT распознавать собственный контент авторы исследования не проверяли — xAI и OpenAI о такой возможности и не заявляли. Сервисы ИИ обычно не склонны признавать свои неверные ответы, и тесты NewsGuard это подтвердили: ChatGPT, Gemini и Grok в 2,5 %, 10 % и 13 % случаев соответственно заявили, что не смогут провести такой анализ. Но чаще это были ошибки одного вида — ответ, что созданное ИИ видео было подлинным. В Google напомнили, что генерируемые ИИ-сервисами компании видео получают маркировку по стандарту SynthID; представитель OpenAI прямо заявил, что ChatGPT не имеет возможности отличать ИИ-видео от настоящего; в xAI комментариев не предоставили. У OpenAI внезапно обнаружилась лаборатория робототехники

23.01.2026 [12:16],

Павел Котов

В прошлом году гендиректор OpenAI Сэм Альтман (Sam Altman) заявил, что время человекоподобных роботов ещё не пришло, но оно уже приближается. И его компания активно готовится к этому моменту, узнал Business Insider.

Источник изображения: ThisisEngineering / unsplash.com В минувшем году OpenAI без громких анонсов сформировала лабораторию человекоподобной робототехники — она расположена в том же здании в Сан-Франциско, что и финансовый отдел компании, и в этой лаборатории заняты около сотни специалистов по сбору данных. Сейчас их задача — обучение роботизированной руки-манипулятора в рамках масштабного проекта по созданию собственного человекоподобного робота. OpenAI уже занималась робототехникой и даже когда-то построила манипулятор, собирающий кубик Рубика — в 2020 году проект закрыли, потому что было решено «переориентировать команду на другие проекты». Сейчас OpenAI ведёт несколько новых проектов в области оборудования, и робототехника — лишь один из них, рассказал источник издания; причём ни один не является ключевым для миссии компании. На минувшей неделе OpenAI объявила конкурс среди американских производителей, которые могли бы стать её партнёрами по направлениям потребительских устройств, робототехники и центров обработки данных. Лаборатория робототехники открылась в феврале 2025 года, и с того момента разрослась более чем в четыре раза. В декабре OpenAI сообщила, что планирует открыть вторую — в калифорнийском Ричмонде. В основной лаборатории выставлен человекоподобный робот, который в основном пылится, и в деле его видели немногие. Сотрудники подразделения сейчас заняты преимущественно дистанционным управлением роботизированными манипуляторами.

Источник изображения: Dima Solomin / unsplash.com В прошлом году стало известно, что OpenAI начала нанимать инженеров-робототехников; анализ профилей на LinkedIn показал, что в проекте занят минимум десяток специалистов. В декабре руководитель проекта заявил о необходимости повысить производительность, эффективность и получить больше часов функциональных данных — за последние несколько месяцев лаборатория, впрочем, почти вдвое превысила ожидания по сбору данных. У OpenAI уже есть опыт инвестиций в компании, которые специализируются на робототехнике — в Figure, 1X и Physical Intelligence. Для Figure она разрабатывала «модели ИИ нового поколения для человекоподобных роботов» но в феврале 2025 года Figure из сделки вышла. Когда первый проект OpenAI в области робототехники закрылся, компания, как считается, сосредоточилась на ChatGPT. Сейчас она всё чаще говорит о разработке оборудования, а база знаний ChatGPT может оказаться полезной, чтобы научить робота интерпретировать окружающий мир и взаимодействовать с ним. В первом проекте компания занималась обучением с подкреплением — методом проб и ошибок, при котором роботы учатся с помощью системы вознаграждений. Теперь OpenAI собирает большие объёмы данных для их обучения. Есть мнение, что стратегия контроллера GELLO может дать преимущество перед конкурентами, которые обучают роботов по методу захвата движений всего тела — метод OpenAI дешевле, поскольку каждый контроллер напрямую связан с манипулятором, и роботу проще научиться конкретным движениям человека. Сейчас в Сан-Франциско компания работает в три смены и использует для сбора данных несколько десятков рабочих станций — камеры записывают движения как оператора, так и выполняющего задачи робота, а работники оцениваются по числу «качественных часов» функционального обучения. OpenAI устанавливает новые станции, которые более точно имитируют движения человека. Некоторые данные компания применяет для обучения роботов в компьютерных симуляциях, а манипуляторы проходят регулярное тестирование для оценки их результатов. Как быстро проект может обернуться результатом в виде полноценного человекоподобного робота, и насколько выигрышной окажется стратегия экономного обучения, ясности пока нет. В Google DeepMind удивились спешке OpenAI с внедрением рекламы в ChatGPT

23.01.2026 [12:15],

Владимир Мироненко

Гендиректор Google DeepMind Демис Хассабис (Demis Hassabis) выразил удивление поспешностью OpenAI после появления сообщений о том, что она уже перешла к внедрению рекламы в свой ИИ-чат-бот для получения дополнительного дохода от пользователей ChatGPT, у которых нет платной подписки. По его мнению, это решение может изменить восприятие сервиса пользователями.

Источник изображения: Growtika/unsplash.com «Я немного удивлён, что они так рано перешли к этому», — сказал Хассабис в интервью Axios в Давосе, вместе с тем отметив, что в рекламе нет ничего плохого, и она может быть полезной для финансирования, если «сделана хорошо». В ответ на вопрос репортёра об использовании рекламы для монетизации услуг ИИ, он заявил, что команда Google очень тщательно обдумывала эту идею. Хассабис также сказал, что его команда не чувствует давления со стороны руководства технологического гиганта, чтобы принять «поспешное» решение относительно рекламы, несмотря на важность рекламы в структуре доходов основного бизнеса Google. Хотя OpenAI, по всей видимости, вынуждена рассмотреть возможность размещения рекламы с учётом растущих затрат, это решение может изменить восприятие сервиса пользователями. В настоящее время число еженедельно активных пользователей ИИ-чат-бота составляет около 800 млн. «При использовании голосовых помощников, если вы рассматриваете чат-ботов как помощников, которые должны быть полезными, а также технологий, которые работают на вас как на отдельного человека, возникает вопрос о том, как реклама вписывается в эту модель? Вы хотите доверять своему помощнику. Так как же это работает?» — задался Хассабис вопросом. Он заметил, что что у Google нет «никаких текущих планов» по размещению рекламы в своем чат-боте с искусственным интеллектом. Вместо этого компания планирует отслеживать ситуацию, чтобы видеть реакцию пользователей. Сама идея проникновения рекламы в разговоры людей с ИИ-помощниками вызывает у них негативную реакцию. Например, когда OpenAI в прошлом месяце начала изучать функцию, предлагающую приложения для тестирования во время чатов пользователей, они отреагировали негативно, поскольку эти предложения кажутся навязчивой рекламой. После этого OpenAI отключила функцию, заявив, что предложения на самом деле не являются рекламой, поскольку «не имеют финансовой составляющей». Но речь не о платежах за рекламу. Скорее, дело в том, как предложения приложений ухудшали качество взаимодействия пользователей с чат-ботом. По словам Хассабиса, использование чат-бота — это совсем другой опыт, чем использование поиска Google. Чат-боты призваны стать полезными цифровыми помощниками, которые знают о вас и могут помочь во многих аспектах жизни, сказал он. Навязывание рекламы пользователю во время общения с ИИ-помощником может вызывать отторжение. Именно поэтому клиенты негативно отнеслись к попыткам Amazon внедрить рекламу в Alexa — им нужен помощник, а не персональный покупатель, предлагающий товары. По стопам OpenAI: Apple готовит ИИ-гаджет в виде шайбы — с парой камер, кнопкой и динамиками

22.01.2026 [11:59],

Алексей Разин

Бывший главный дизайнер Apple Джони Айв (Jony Ive), примкнувший к OpenAI вместе со своим стартапом, выразил готовность создать для материнской компании от 15 до 20 устройств, позволяющих работать с ИИ. Сама Apple в этой гонке в числе догоняющих оказаться не хочет, а потому уже разрабатывает носимое ИИ-устройство, как утверждают источники.

Источник изображения: Apple Вчера об этом сообщило издание The Information. По слухам, конструктивно данное устройство будет напоминать брошь, которую пользователь сможет носить на своей одежде. В компактном корпусе найдётся место для двух камер и трёх микрофонов, поэтому устройство всегда будет оценивать контекст. Напомним, что OpenAI своё первое ИИ-устройство намерена анонсировать во второй половине текущего года. По некоторым данным, им могут оказаться беспроводные наушники. Предполагается, что ИИ-устройство Apple будет напоминать тонкий диск, корпус которого будет отделан алюминием и стеклом. По размерам новинка будет близка к беспроводной метке AirTag, но превзойдёт её в толщине. Из двух камер одна будет широкоугольной, обе смогут снимать видео и статичные изображения. В корпусе найдётся место для динамика для воспроизведения звука, а также одной физической кнопки для управления. С оборотной стороны устройства будет предусмотрен специальный разъём для подключения зарядного кабеля. Если всё пойдёт по плану, то Apple сможет представить своё ИИ-устройство в 2027 году и выпустить его тиражом 20 млн штук уже в первый год присутствия на рынке. Судьба первопроходцев в новой категории устройств не всегда складывается удачно. Основанная выходцами из Apple компания Humane AI, например, уже пыталась выпустить носимое ИИ-устройство, но оно провалилось на рынке и вынудило стартап продать свои активы HP через два года после анонса этого изделия. OpenAI собралась привлечь $50 млрд от ближневосточных инвесторов на строительство мега-ЦОД

22.01.2026 [07:34],

Алексей Разин

С точки зрения классического финансового анализа показатели деятельности OpenAI пока выглядят не очень привлекательно для потенциальных инвесторов, поскольку даже руководство стартапа не скрывает, что на безубыточность он выйдет не ранее 2029 года. При этом глава OpenAI сейчас ведёт переговоры на Ближнем Востоке о привлечении ещё $50 млрд, рассчитывая увеличить капитализацию до $750 млрд минимум.

Источник изображения: OpenAI Об этом накануне сообщило агентство Bloomberg со ссылкой на собственные осведомлённые источники. Недавно генеральный директор OpenAI Сэм Альтман (Sam Altman) посетил Ближний Восток и провёл переговоры с инвесторами, включая представителей суверенных фондов Абу-Даби (ОАЭ). Если в ходе этого раунда финансирования OpenAI удастся привлечь $50 млрд, то капитализация стартапа будет оцениваться в диапазоне от $750 до $830 млрд. Переговоры пока находятся на ранней стадии, суммы могут измениться. Как ранее сообщало агентство Bloomberg, до этого OpenAI вела переговоры с Amazon о привлечении не менее чем $10 млрд. В ближайшие восемь лет OpenAI собирается направить на развитие собственной вычислительной инфраструктуры около $1,4 трлн, но существующие сделки по финансированию проектов практически исключают какие-либо риски со стороны самого стартапа. Строиться эти огромные и многочисленные ЦОД будут либо за счёт партнёров OpenAI, либо вообще на заёмные средства без явного обеспечения, а финансирование многих сделок в этой сфере организовано по «кольцевому принципу», когда одни и те же суммы передаются участниками по кругу. Ближний Восток с его внушительными запасами нефтедолларов уже становился источником финансирования американских компаний из области ИИ. Компании Anthropic и xAI обращались за поддержкой к ближневосточным инвесторам, да и сама OpenAI привлекала средства от MGX, расположенной в Абу-Даби. Кроме того, на территории ОАЭ компания OpenAI будет строить крупный центр обработки данных при участии местной G42. Осенью прошлого года капитализация OpenAI оценивалась в $500 млрд, однако Anthropic в ходе последнего раунда финансирования претендует на оценку в $350 млрд, поэтому средства в сферу ИИ продолжают поступать мощным потоком. OpenAI выйдет в прибыль только в 2029 году — после $44 млрд убытков

22.01.2026 [05:47],

Анжелла Марина

OpenAI прогнозирует убытки в размере $14 млрд в 2026 году, но рассчитывает выйти на годовую выручку в $100 млрд к 2029 году. В период с 2023 по 2028 год разработчик ChatGPT ожидает суммарные потери на уровне $44 млрд. Об этом сообщает портал PC Gamer со ссылкой на издание The Information, в распоряжении которого оказались внутренние документы OpenAI.

Источник изображения: Levart_Photographer/Unsplash Ситуация должна измениться в 2029 году, когда компания рассчитывает получить первую прибыль в размере $14 млрд. Для достижения этих целей OpenAI планирует потратить до конца десятилетия $200 млрд. При этом от 60 % до 80 % этой суммы будет направлено на обучение и эксплуатацию моделей искусственного интеллекта. Структура будущих доходов распределена следующим образом: более 50 % принесет непосредственно сервис ChatGPT, около 20 % обеспечат продажи моделей разработчикам через API, оставшиеся 20 % придутся на другие продукты. В категорию «другие» входят генерация видео, поиск и новые сервисы, такие как ИИ-ассистенты для исследований. При этом, в соответствии с документами, на которые также ссылается PC Gamer, в первой половине последнего финансового года расходы компании составили всего $340 млн. Как этот текущий уровень затрат сочетается с прогнозом многомиллиардных убытков, в документах не поясняется. Цифровой рантье: OpenAI задумала брать процент с прибыли, полученной клиентами с помощью ChatGPT

21.01.2026 [22:37],

Анжелла Марина

Финансовый директор OpenAI Сара Фрайар (Sarah Friar) в ходе недавнего подкаста сообщила, что компания рассматривает возможность фундаментального изменения своей бизнес-модели, выходящей за рамки фиксированных подписок. По словам топ-менеджера, в будущем OpenAI может перейти к модели роялти с оплатой, зависящей от результатов работы клиента с ChatGPT.

Источник изображения: AI В качестве иллюстрации Фрайар привела сферу разработки лекарств. Если фармацевтический партнёр использует технологии OpenAI для создания прорывного препарата, стартап может претендовать на лицензионную долю от продаж этого лекарства. Финансовый директор подчеркнула, что суть такого подхода заключается в совпадении интересов: OpenAI будет зарабатывать деньги тогда, когда их зарабатывают клиенты. Фрайар охарактеризовала текущую стратегию компании метафорой кубика Рубика, который имеет около 43 квинтиллионов состояний. Она напомнила, что изначально OpenAI представляла собой единый блок в виде одного облачного провайдера (Microsoft), одного ключевого партнёра по чипам (Nvidia), одного флагманского продукта (ChatGPT) и — ещё совсем недавно — одной базовой подписки. Такая модель нужна была для оплаты вычислительных ресурсов. С тех пор, как пишет в своём эксклюзивном материале Business Insider, структура бизнеса OpenAI усложнилась. Сейчас компания сотрудничает с несколькими облачными провайдерами и производителями чипов. Продуктовая линейка расширилась за пределы потребительского ChatGPT и теперь включает генератор видео Sora, корпоративные продукты, специализированные отраслевые предложения и платформы для исследований. Монетизация также трансформировалась: помимо единой подписки появились различные ценовые уровни, модель «программное обеспечение как услуга» (SaaS) и кредитная система оплаты для ресурсоёмких задач. Фрайар подчеркнула, что главным ограничением для всех этих стратегий остаётся доступный объём вычислительных мощностей. По её словам, спрос на сервисы OpenAI сдерживается не отсутствием интереса, а нехваткой инфраструктуры. Именно это делает расширение источников дохода не просто возможным, а необходимым для выполнения миссии компании. Глава Microsoft раскрыл рецепт, как не допустить взрыва ИИ-пузыря

21.01.2026 [07:02],

Алексей Разин

Наиболее тревожные эксперты то и дело заявляют, что высокие темпы развития ИИ в нынешних условиях создают опасность формирования пузыря, схлопывание которого грозит глобальными макроэкономическими проблемами. Глава Microsoft Сатья Наделла (Satya Nadella) считает, что избежать этого удастся только при условии повсеместного распространения ИИ.

Источник изображения: Microsoft Под этим подразумевается практическое внедрение ИИ не только в срезе различных отраслей и компаний, но и в географическом понимании. Грубо говоря, использование ИИ не должно ограничиваться горсткой компаний технологического сектора, а ещё соответствующие технологии должны найти применение и за пределами стран с развитой экономикой. «Чтобы это не стало пузырём по определению, нужно, чтобы преимущества (ИИ) распределялись значительно более равномерно», — пояснил генеральный директор Microsoft, выступая на форуме в Давосе. В этом смысле тревожным сигналом к образованию пузыря необходимо считать сосредоточение выгоды от использования ИИ в руках отдельной группы технологических компаний, как добавил Наделла. При этом он лично убеждён, что распространение ИИ будет наблюдаться в различных отраслях. Например, он поможет в разработке новых лекарственных средств. «Я гораздо больше уверен в том, что эта технология, по факту, будет строиться на основе облачной и мобильной инфраструктуры, распространяться быстрее и менять кривую производительности труда, принося локальные излишки и экономический рост во всём мире», — заявил глава Microsoft. Он также выразил уверенность, что будущее внедрение ИИ не будет базироваться на единственном провайдере моделей, поэтому Microsoft и не концентрируется на сотрудничестве с одной только OpenAI, для которой выступила в роли раннего и крупнейшего по сей день инвестора. Microsoft готова развивать сотрудничество с Anthropic и xAI, а после октябрьской реструктуризации OpenAI условия соглашения с этим стартапом были пересмотрены. После 2030 года Microsoft поэтапно утратит преимущество в доступе к новейшим разработкам OpenAI и перестанет выступать в роли основного провайдера вычислительных мощностей для этой компании. Microsoft в целом готова не только использовать ИИ-модели с открытым исходным кодом, но и создавать собственные путём так называемой «дистилляции». Как пояснил Наделла, интеллектуальной собственностью любой компании являются её методы использования тех или иных моделей для работы с контекстом или данными. И если компании понимают, что со всем этим делать, они будут добиваться прогресса. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |